一、文本情感分类

文本分类是自然语言处理的一个常见任务,它把一段不定长的文本序列变换为文本的类别。本节关注它的一个子问题:使用文本情感分类来分析文本作者的情绪。这个问题也叫情感分析,并有着广泛的应用。

同搜索近义词和类比词一样,文本分类也属于词嵌入的下游应用。在本节中,我们将应用预训练的词向量和含多个隐藏层的双向循环神经网络与卷积神经网络,来判断一段不定长的文本序列中包含的是正面还是负面的情绪。后续内容将从以下几个方面展开:

- 文本情感分类数据集

- 使用循环神经网络进行情感分类

- 使用卷积神经网络进行情感分类

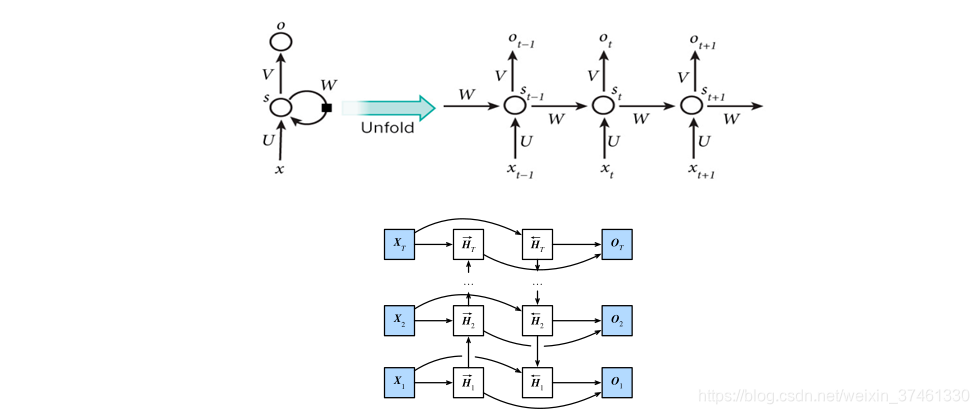

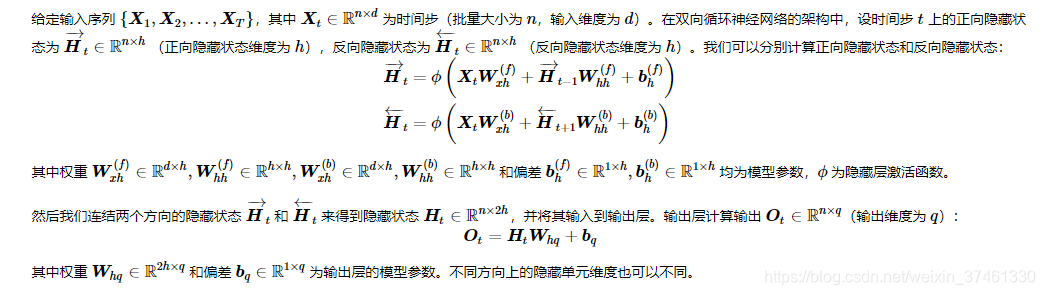

双向循环神经网络

使用卷积神经网络¶

一维卷积层

在介绍模型前我们先来解释一维卷积层的工作原理。与二维卷积层一样,一维卷积层使用一维的互相关运算。在一维互相关运算中,卷积窗口从输入数组的最左方开始,按从左往右的顺序,依次在输入数组上滑动。当卷积窗口滑动到某一位置时,窗口中的输入子数组与核数组按元

本文介绍了文本情感分类,包括使用双向循环神经网络和卷积神经网络;探讨了数据增强技术,如图像增广、翻转、裁剪和颜色变化;并讨论了模型微调在小数据集上的应用,以提高模型的泛化能力。

本文介绍了文本情感分类,包括使用双向循环神经网络和卷积神经网络;探讨了数据增强技术,如图像增广、翻转、裁剪和颜色变化;并讨论了模型微调在小数据集上的应用,以提高模型的泛化能力。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

512

512

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?