1.用Hive对爬虫大作业产生的文本文件(或者英文词频统计下载的英文长篇小说)进行词频统计。

在网上下载英文小说,下载到本地home/hadoop/wc

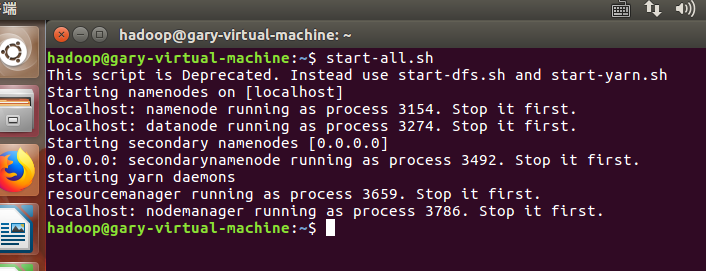

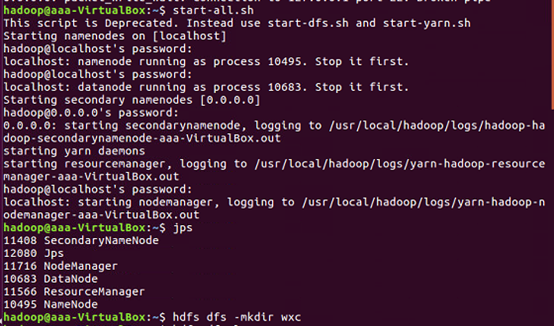

首先要启动dfs:

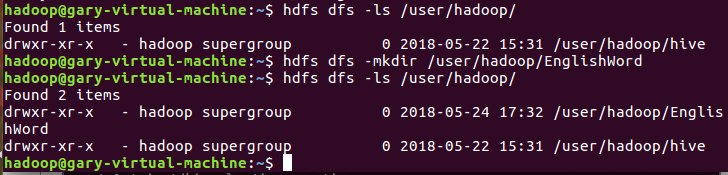

2.在user/hadoop/上创建文件夹EnglishWord:

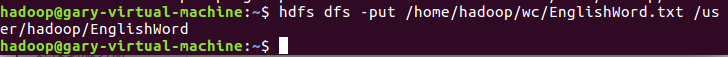

3.上传下载文档到user/hadoop/EnglishWord文件中:

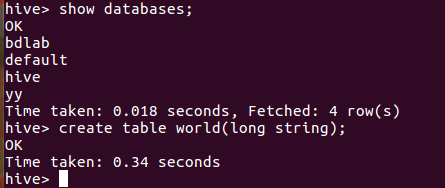

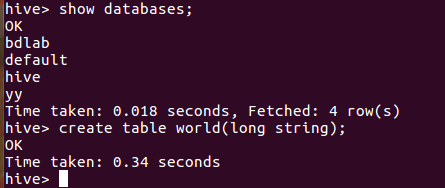

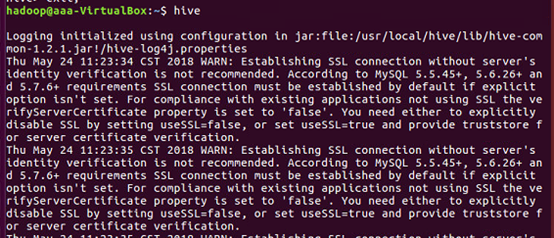

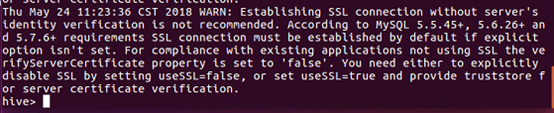

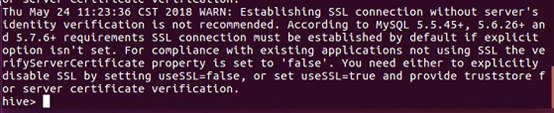

4.在hive数据库创建表 world:

导入文本world.txt并查看

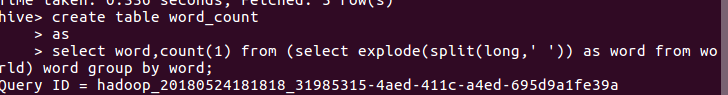

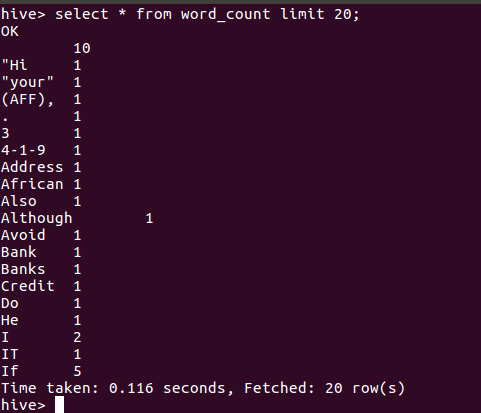

用HQL进行词频统计并保持到表 word_count:

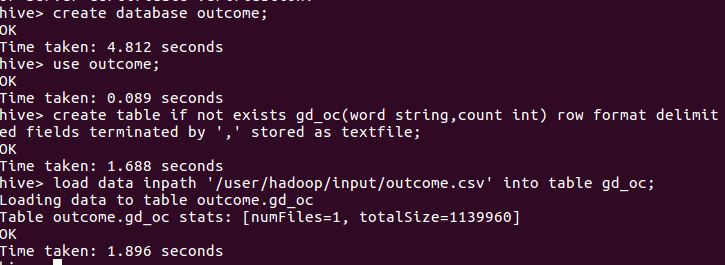

2.用Hive对爬虫大作业产生的csv文件进行数据分析,写一篇博客描述你的分析过程和分析结果。

本文介绍如何使用Hive对爬虫产生的文本文件及CSV文件进行词频统计与数据分析。首先通过Hive对下载的英文小说进行词频统计,并将结果保存到表中;其次对爬虫产生的CSV文件进行数据分析,分享详细的分析过程与结果。

本文介绍如何使用Hive对爬虫产生的文本文件及CSV文件进行词频统计与数据分析。首先通过Hive对下载的英文小说进行词频统计,并将结果保存到表中;其次对爬虫产生的CSV文件进行数据分析,分享详细的分析过程与结果。

2657

2657

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?