参考:深度揭秘爆火MoE!GPT-4关键架构,成开源模型逆袭杀手锏 (baidu.com)

MoE是一种神经网络架构设计,在Transformer模块中集成了专家/模型层。

当数据流经MoE层时,每个输入token都会动态路由到专家子模型进行处理。当每个专家专门从事特定任务时,这种方法可以实现更高效的计算并获得更好的结果。

MoE最关键的组件:

- 专家(Expert):MoE层由许多专家、小型MLP或复杂的LLM(如 Mistral 7B)组成。

- 路由器(Router):路由器确定将哪些输入token分配给哪些专家。

路由策略有两种:token选择路由器或路由器选择token。

路由器使用softmax门控函数通过专家或token对概率分布进行建模,并选择前k个。

MoE能够带来的好处:

- 每个专家都可以专门处理不同的任务或数据的不同部分。

- MoE构架能向LLM添加可学习参数,而不增加推理成本。

- 可以利用稀疏矩阵的高效计算

- 并行计算所有专家层,以有效利用GPU的并行能力

- 帮助有效地扩展模型并减少训练时间。以更低的计算成本获得更好的结果!

MoE:建立高效大模型的关键技术

大型语言模型(LLM)席卷了机器学习领域,而随着现代数据集的复杂性和规模的增加,每个数据集都包含不同的模式,特征和标注之间的关系截然不同。

——这时,就需要MoE出手了。

专家混合(MoE)就像神经网络世界中的一种团队合作技术。

想象一下,将一项大任务分解成更小的部分,并让不同的专家处理每个部分。然后,有一个聪明的法官会根据情况,决定遵循哪位专家的建议,所有这些建议都混合在一起。

——就像你利用不同的口味,组合成一道好吃的菜。

对于复杂的数据集,可以划分为局部子集(local subsets),同样,将需要预测的问题划分为子任务(采用领域知识或者无监督聚类算法)。

然后,针对每个数据子集训练专家模型(Expert Models),专家模型可以是任何模型,比如支持向量机 (SVM) 或者神经网络,每个专家模型接收相同的输入模式并进行预测。

MoE还包含门控模型(Gating Model),用于解释每个专家做出的预测,并根据输入选择信任哪个专家。

最后,MoE需要一种聚合机制(Pooling Method),根据门控模型和专家的输出进行预测。

混合专家模型(Mixture of Experts):在机器学习中,MoE是一种模型架构,它将多个专家模型的输出结合在一起,以提高预测的准确性和鲁棒性。

混合专家模型(Mixture of Experts,简称MoE)是一种机器学习框架,它通过组合多个独立的模型(专家)的预测来改善整体的预测能力。这种架构特别适用于处理大型数据集和高维特征空间的情况,因为它可以利用并行计算的优势,并且能够有效地分配计算资源。

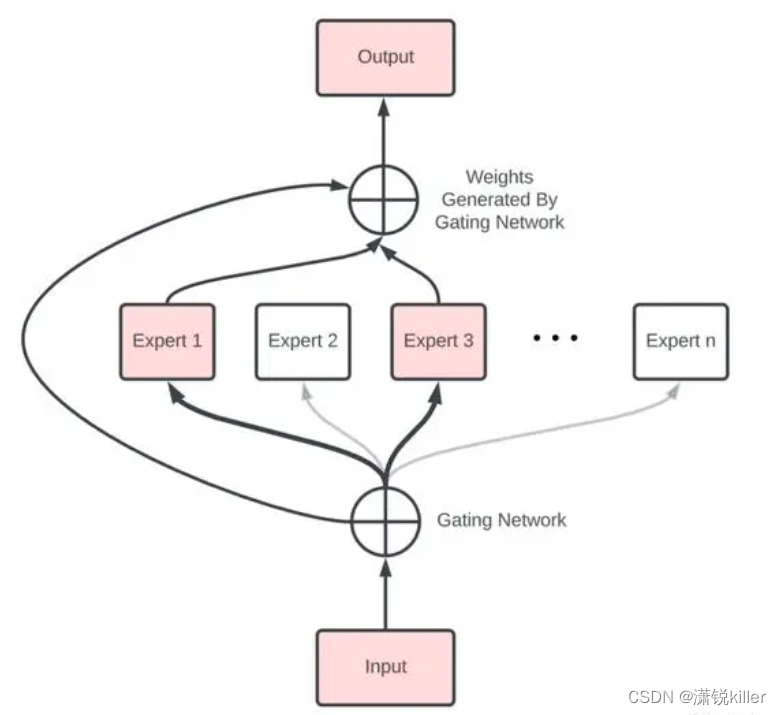

MoE的基本结构

MoE模型通常包括以下几个关键组件:

-

专家模型(Experts): 这些是专门针对不同数据子集或任务的独立模型。每个专家模型都专注于处理特定类型的数据或解决特定类型的子问题,从而可以更高效地学习相关的特征表示。

-

门控网络(Gating Network): 这是一个特殊的模型,用于决定哪些专家应该对给定输入做出响应。门控网络通常通过一个软最大值(Softmax)函数来分配权重,这些权重反映了每个专家被选中的概率。

-

混合层(Mixture Layer): 这一层将所有专家模型的输出按照门控网络分配的权重进行加权平均,生成最终的预测结果。

工作流程

当一个新的输入到达时,门控网络首先评估该输入并确定哪些专家最适合处理它。接着,门控网络会根据其评估结果为每个专家分配一个权重。然后,每个被选中的专家模型都会处理输入并产生自己的预测。最后,混合层将这些预测结合成一个最终输出,每个预测的贡献度由其对应的权重决定。

优点

- 可扩展性:MoE架构允许模型随着计算资源的增加而线性扩展,因为更多的专家可以被添加到模型中。

- 效率:在大规模模型训练中,MoE可以显著降低计算成本,因为不是所有的专家都需要在每个训练步骤中被激活。

- 灵活性:专家模型可以被定制以适应不同的任务或数据类型,这使得MoE在面对复杂和多样化的问题时具有更高的灵活性。

应用场景

MoE在自然语言处理(NLP)、计算机视觉、推荐系统等多个领域都有广泛的应用。例如,在NLP中,MoE可以用来处理不同语言风格或主题的文本;在计算机视觉中,它可以用于识别不同类型的对象或场景。

发展趋势

近年来,随着计算硬件的进步和大规模预训练模型的发展,MoE架构变得越来越流行。特别是在处理超大规模数据集和模型时,MoE提供了一种有效的方法来平衡模型性能和计算效率之间的关系。例如,谷歌的研究人员就使用了MoE架构来创建大规模的神经网络模型,这些模型在多项任务上达到了先进的性能,同时保持了较低的计算成本。

1549

1549

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?