本人项目地址大全:Victor94-king/NLP__ManVictor: 优快云 of ManVictor

写在前面: 笔者更新不易,希望走过路过点个关注和赞,笔芯!!!

写在前面: 笔者更新不易,希望走过路过点个关注和赞,笔芯!!!

写在前面: 笔者更新不易,希望走过路过点个关注和赞,笔芯!!!

检索增强生成(RAG)是一种将LLM(大型语言模型)集成到商业用例中的突出技术,它允许将专有知识注入LLM中。本文假设您已经了解RAG的相关知识,并希望提高您的RAG准确率。

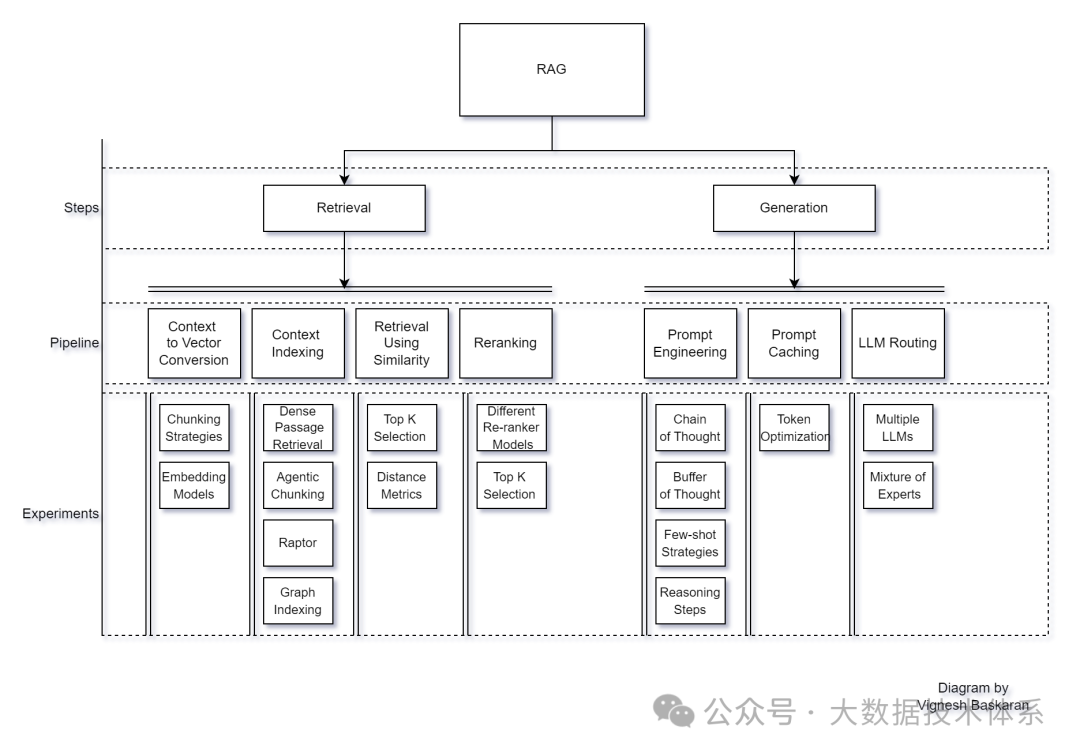

让我们简要回顾一下这个过程。RAG模型包括两个主要步骤:检索和生成。在检索步骤中,涉及多个子步骤,包括将上下文文本转换为向量、索引上下文向量、检索用户查询的上下文向量以及重新排序上下文向量。一旦检索到查询的上下文,我们就进入生成阶段。在生成阶段,上下文与提示结合,然后发送给LLM以生成响应。在发送给LLM之前,可能需要进行缓存和路由步骤以优化效率。

对于每个管道步骤,我们将进行多次实验,以共同提高RAG的准确率。您可以参考以下图片,其中列出了在每个步骤中进行的实验(但不限于)。

开发者面临的一个主要问题是,在生产环境中部署应用程序时,准确性会有很大的下降。

“RAG在POC(原型)中表现最佳,在生产中最差。”这种挫败感在构建GenAI(通用人工智能)应用程序的开发者中很常见。

生成阶段已经通过一些提示工程得到了解决,但主要挑战是检索与用户查询相关且完整的上下文。这通过一个称为上下文召回率的指标来衡量,它考虑了为给定查询检索的相关上下文数量。检索阶段的实验目标是提高上下文召回率。

嵌入模型适配

在检索阶段进行的实验中,通过适配嵌入模型,可以显著地将您的上下文召回率提高+95%。

在适配嵌入模型之前,让我们了解其背后的概念。这个想法始于词向量,我们将训练模型理解单词的周围上下文(了解更多关于CBOW和Skipgram的信息)。在词向量之后,嵌入模型是专门设计来捕捉文本之间关系的神经网络。它们超越了单词级别的理解,以掌握句子级别的语义。嵌入模型使用掩码语言模型目标进行训练,其中输入文本的一定比例将被屏蔽以训练嵌入模型,以预测屏蔽的单词。这种方法使模型能够在使用数十亿个标记进行训练时理解更深层的语言结构和细微差别,结果生成的嵌入模型能够产生具有上下文感知的表示。这些训练好的嵌入模型旨在为相似的句子产生相似的向量,然后可以使用距离度量(如余弦相似度)来测量,基于此检索上下文将被优先考虑。

现在我们知道了这些模型是用来做什么的。它们将为以下句子生成相似的嵌入:

句子1:玫瑰是红色的

句子2:紫罗兰是蓝色的

它们非常相似因为这两句都在谈论颜色。

对于RAG,查询和上下文之间的相似度分数应该更高,这样就能检索到相关的上下文。让我们看看以下查询和来自PubmedQA数据集的上下文。

查询:肿瘤浸润性免疫细胞特征及其在术前新辅助化疗后的变化能否预测乳腺癌的反应和预后?

上下文:肿瘤微环境免疫与乳腺癌预后相关。高淋巴细胞浸润与对新辅助化疗的反应相关,但免疫细胞亚群特征在术前和术后残余肿瘤中的贡献仍不清楚。我们通过对121例接受新辅助化疗的乳腺癌患者进行免疫组化分析,分析了术前和术后肿瘤浸润性免疫细胞(CD3、CD4、CD8、CD20、CD68、Foxp3)。分析了免疫细胞特征并与反应和生存相关。我们确定了三种肿瘤浸润性免疫细胞特征,它们能够预测对新辅助化疗的病理完全缓解(pCR)(B簇:58%,与A簇和C簇:7%相比)。CD4淋巴细胞的高浸润是pCR发生的主要因素,这一关联在六个公共基因组数据集中得到了验证。化疗对淋巴细胞浸润的影响,包括CD4/CD8比率的逆转,与pCR和更好的预后相关。对化疗后残余肿瘤中免疫浸润的分析确定了一个特征(Y簇),其主要特征是CD3和CD68浸润高,与较差的无病生存率相关。

查询和上下文看起来相似吗?我们是否在使用嵌入模型的方式中使用了它们的设计意图?显然,不是!

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1399

1399

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?