一切皆是映射:DQN算法的收敛性分析与稳定性探讨

作者:禅与计算机程序设计艺术 / Zen and the Art of Computer Programming

1. 背景介绍

1.1 问题的由来

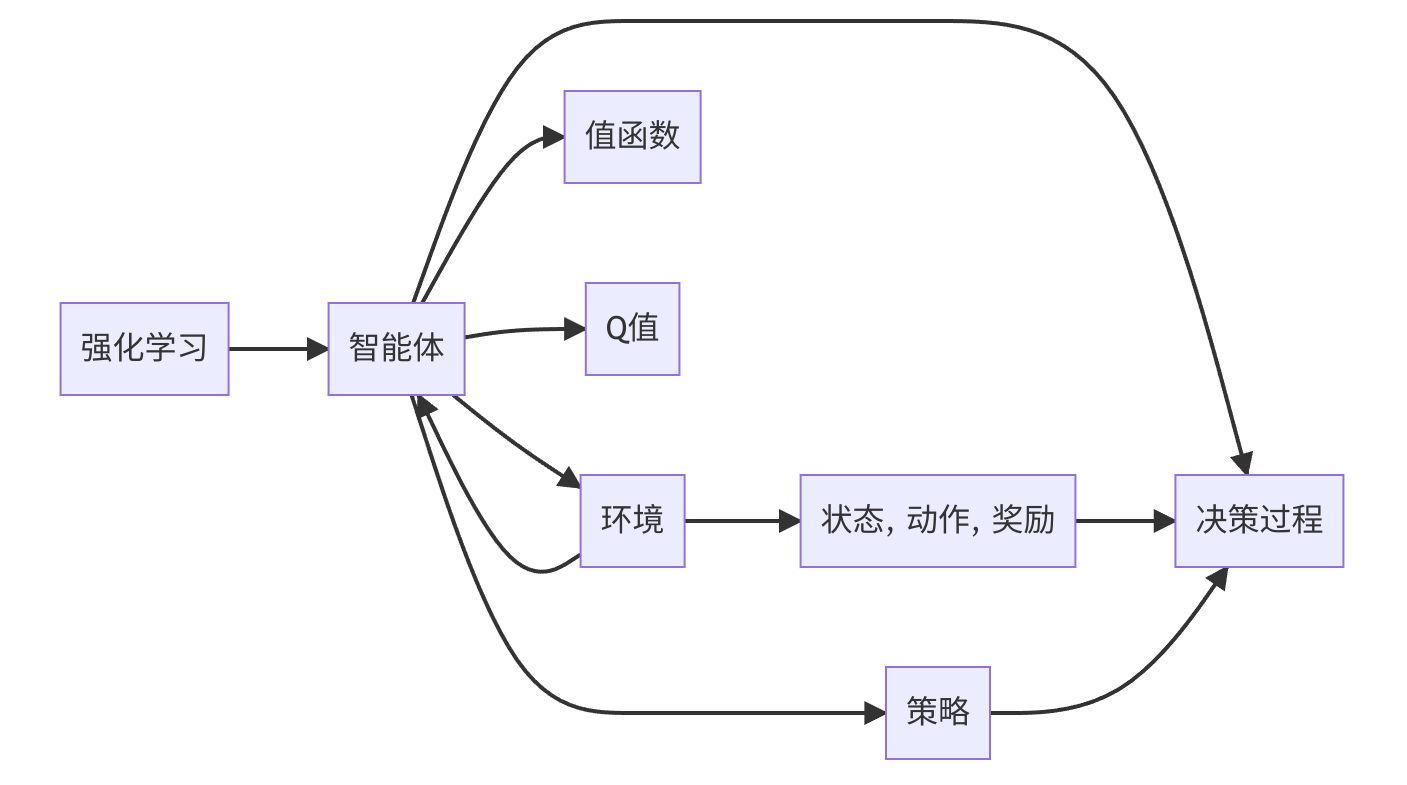

深度Q网络(Deep Q-Network,DQN)作为一种基于深度学习的强化学习算法,自2013年由DeepMind提出以来,就以其强大的学习和泛化能力在智能决策领域崭露头角。DQN的核心思想是通过神经网络来逼近值函数,从而实现智能体的自主学习和决策。

然而,在实际应用中,DQN算法的收敛性分析和稳定性探讨一直是研究者们关注的焦点。收敛性影响着算法的最终性能,而稳定性则决定了算法的鲁棒性和泛化能力。本文将从这两个方面对DQN算法进行深入探讨,旨在为研究者们提供有益的参考。

1.2 研究现状

近年来,针对DQN算法的收敛性分析和稳定性探讨已经取得了许多成果。主要的研究方向包括:

- 收敛性分析:通过分析DQN算法的动态行为,证明算法在特定条件下收敛到最优策略。

- 稳定性分析:研究DQN算法在训练过程中的稳定性,以及如何提高算法的鲁棒性和泛化能力。

- 改进方

订阅专栏 解锁全文

订阅专栏 解锁全文

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?