大模型API调用压力测试

现状

当前各种各样的模型提供商,让人眼花缭乱啊,比如阿里云百炼上的各种大模型、百度的千帆、字节的火山引擎,还有国外的openai、azure、openroute等等。

最近我在测试基于企业知识库的问答系统时,发现延迟比较高,经过分析,发现是大模型调用消耗了很多时间,那么要如何检验大模型调用的效果如何呢?比如并发访问延迟?

有很多工具,我选择了一款容易上手的,名为locust,是用python编写的开源软件,支持webUI,能生成html报告。

完整文档

可以关注“AI发烧友”,然后发送“locust”即可免费获取详细的教程,以下部分内容:

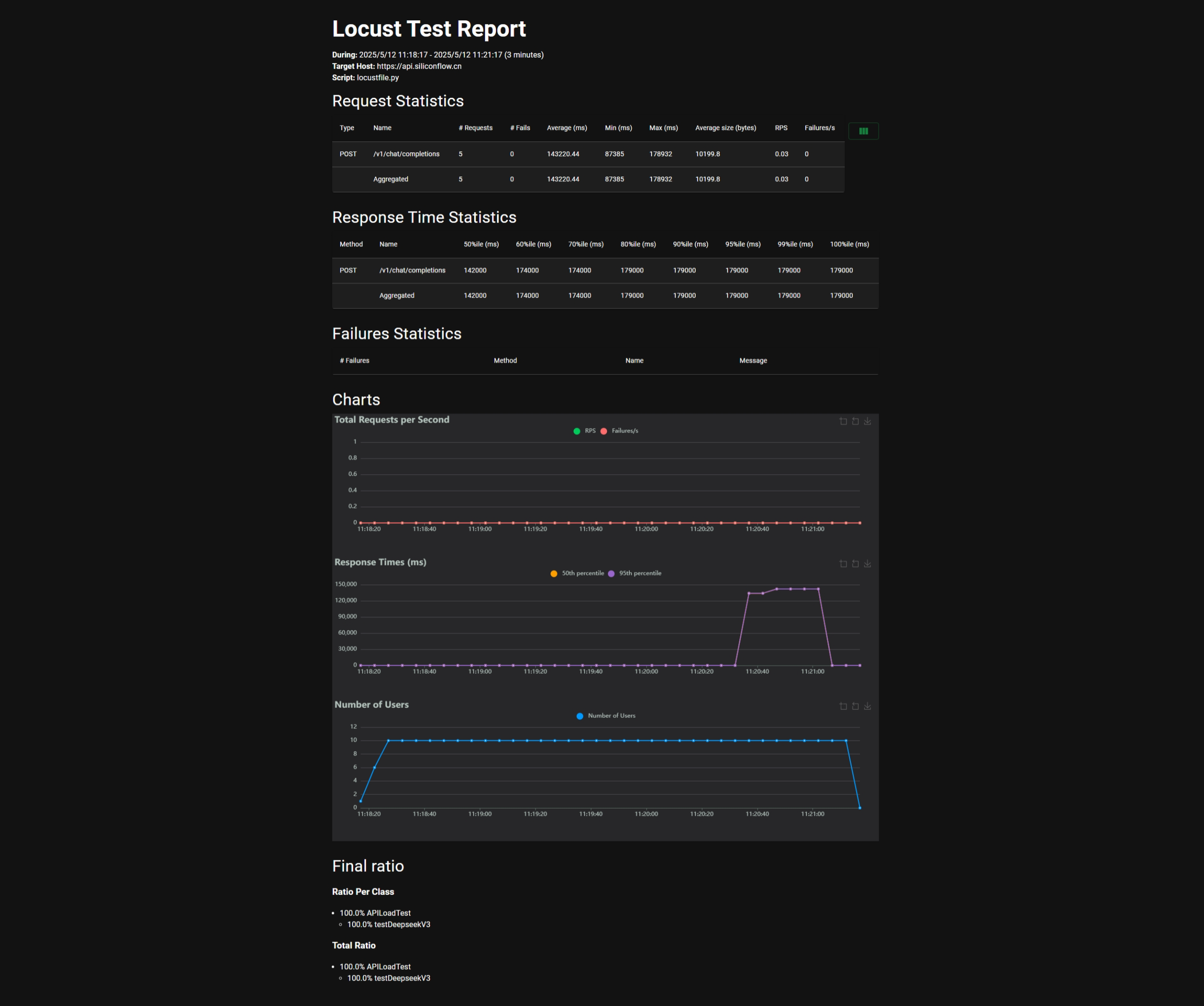

下图是我用locust生成的报告。

8万+

8万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?