近年来,生成式AI模型参数规模快速增长,研究人员和开发者普遍面临一个现实问题:如何在本地进行大模型的高效推理、微调与原型开发? 依赖云计算资源虽然强大,但成本高昂、数据传输延迟以及隐私考虑使得本地化部署成为不少团队的实际需求。

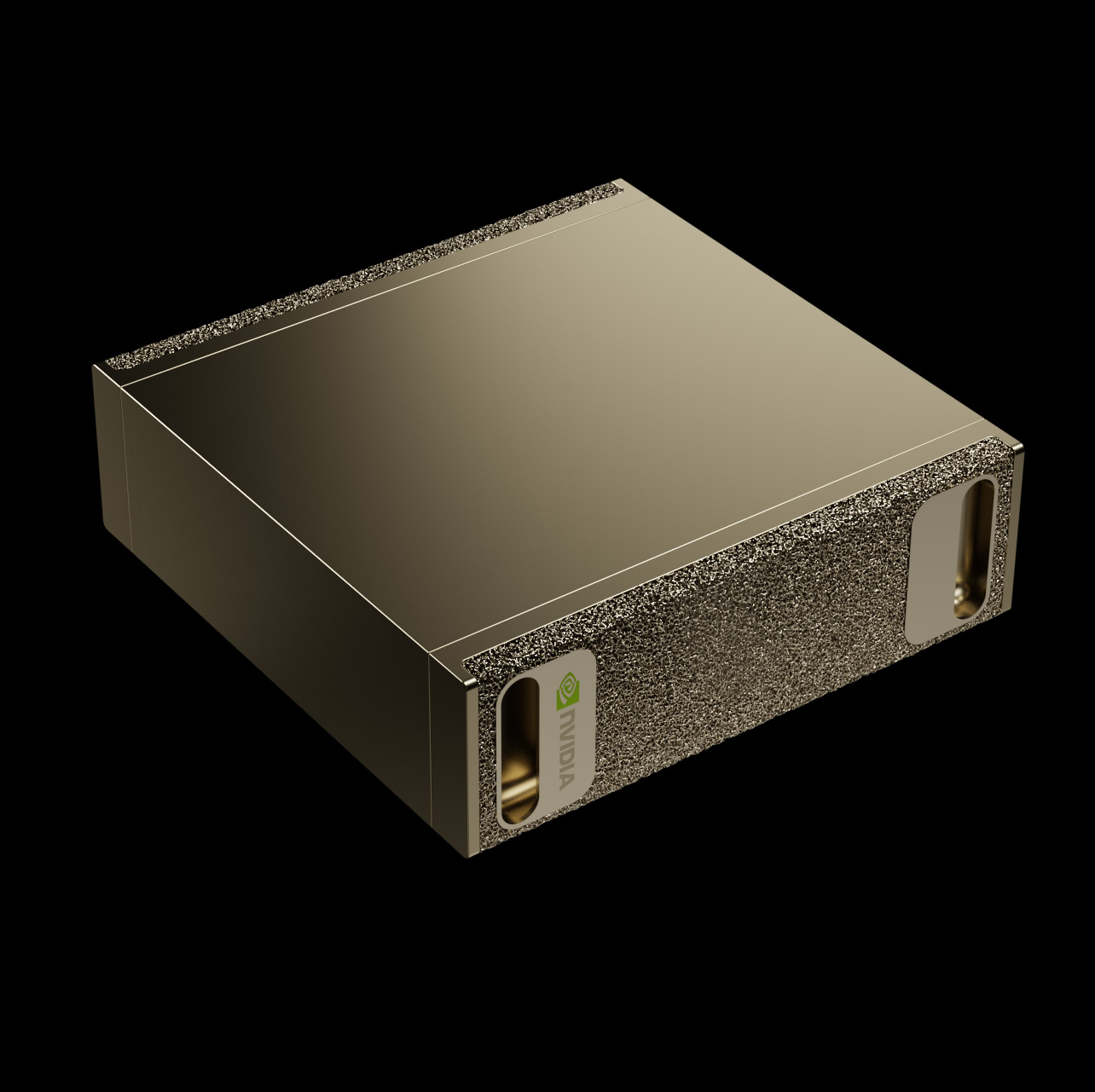

NVIDIA 近期推出的 DGX Spark,正是一款面向该场景的一体化 AI 计算系统。它不同于传统的服务器或工作站,而是在紧凑的桌面形态中,集成了 Grace Blackwell 超级芯片、128GB 统一内存与全栈AI软件栈,试图在本地开发与大模型推理之间找到平衡点。

一、DGX Spark 的架构特点与技术突破

1. GB10 超级芯片:CPU-GPU 一致性内存架构

DGX Spark 搭载的 GB10 超级芯片,采用 Grace Blackwell 架构,最大亮点在于实现了 CPU 和 GPU 之间的统一内存寻址。其借助 NVLink-C2C 互联技术,使得 GPU 和 CPU 能够共享 128GB LPDDR5x 内存,带宽高达 273GB/s。这意味着数据不必在 CPU 和 GPU 之间反复复制,极大减少了预处理和数据交换的开销。

2. 支持FP4稀疏计算与第五代Tensor Core

该设备支持 FP4 精度下的稀疏计算,官方标称 AI 算力可达 1000 TOPS。稀疏计算对于大规模模型推理尤其重要,可显著降低计算和存储压力。结合第五代 Tensor Core,Transformer 类模型推理效率有明显提升。

3. 双机互联扩展模型规模

通过 Connec

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1296

1296

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?