在摄影与图像处理领域,人物写真背景图像融合一直是技术难点。传统方法往往难以实现自然且富有艺术感的融合效果。然而,随着深度学习技术的发展,蒙版重绘与CN局部重绘技术为我们提供了全新的思路。本文将带你深入剖析这两种技术的实战应用,探索如何将人物与背景完美融合,实现令人惊叹的艺术效果。

今天实战介绍SD人物换背景 。在实际写真场景中,涉及切换人物背景图并融合。我们这里使用图生图-蒙版重绘 与 ControlNet局部重绘 实现背景图的融合。

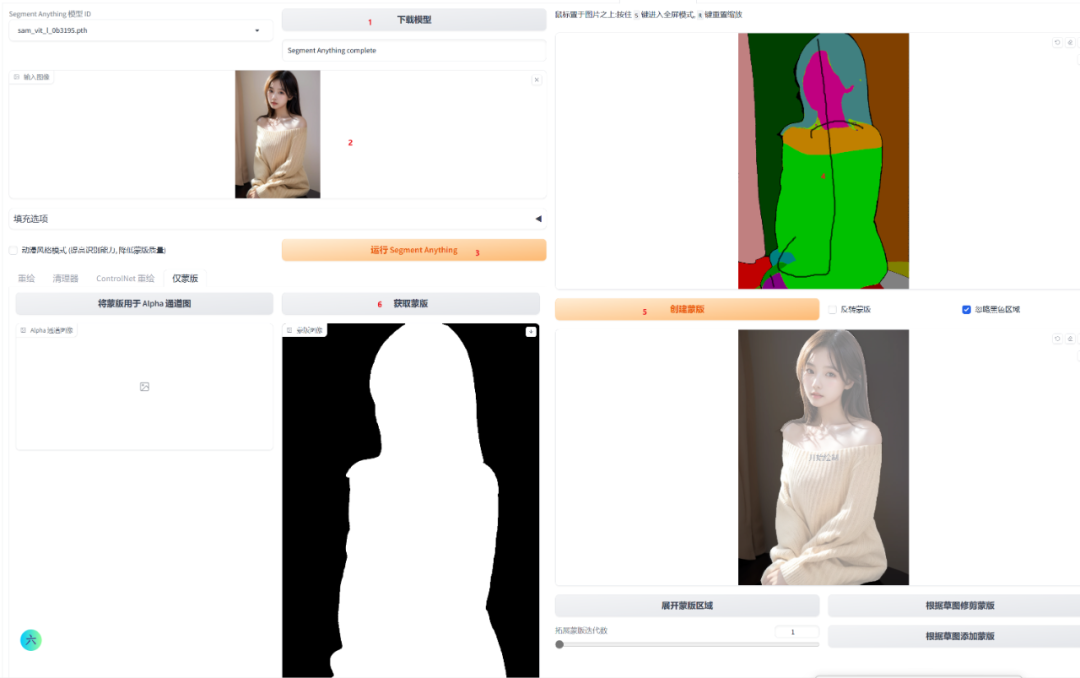

人物蒙版制作

在这里需要首先安装SD插件:sd-webui-inpaint-anything 插件操作提取蒙版。

插件的安装地址为:(需要的同学可以自行扫描获取)

然后利用sd-webui-inpaint-anything插件制作并提取人物蒙版,可以根据页面提示操作和精修,然后我们就可以获得精修后的人物蒙版遮挡图像。

人物案例图像

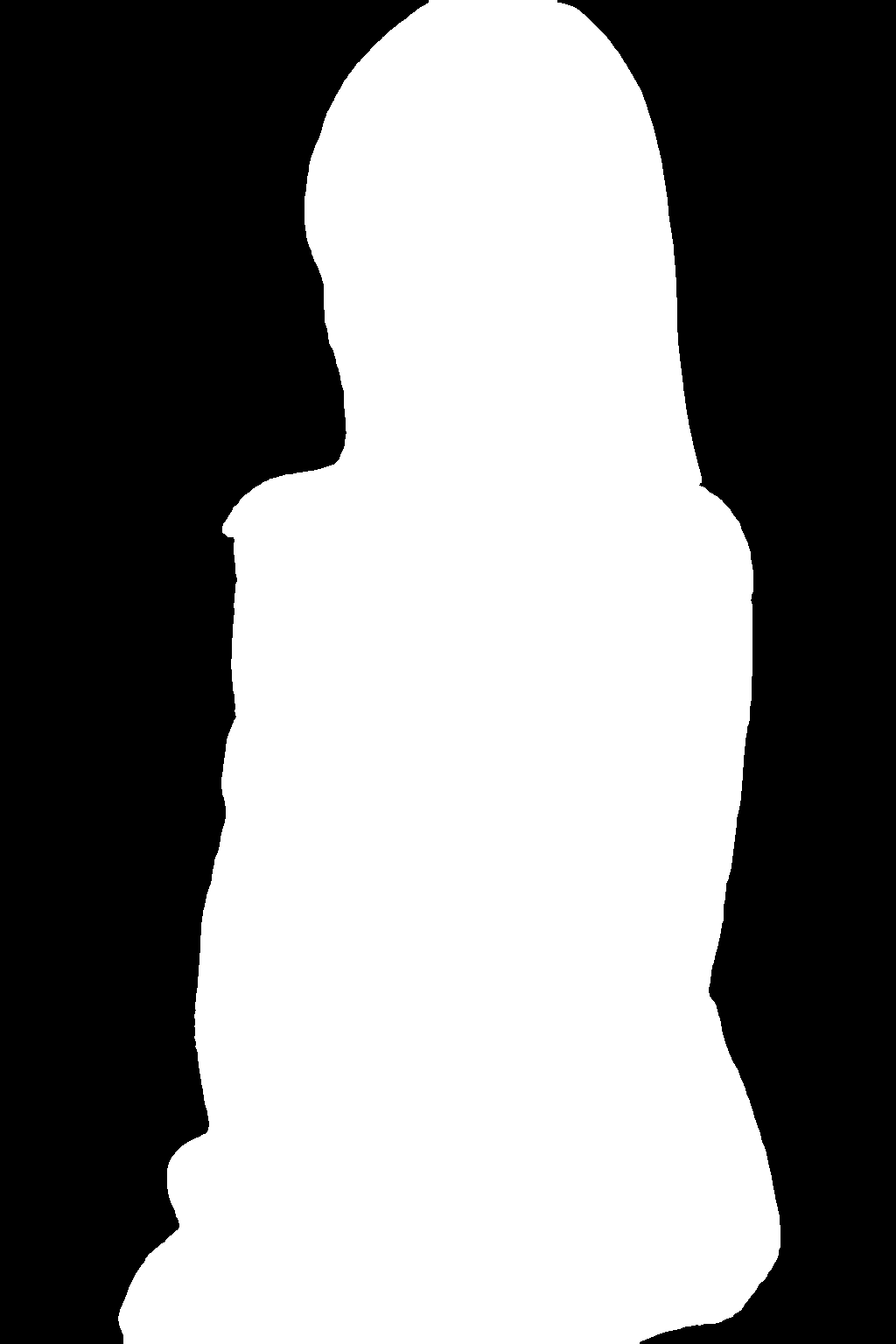

获取人物蒙版

人物写真换背景

上传重绘蒙版

到这一步,我们就可以进入SD图生图 界面,在上传重绘蒙版

标签页,分别上传被切换原始人物写真图像和上一步提取的人物蒙版遮罩。相关配置如下所示:

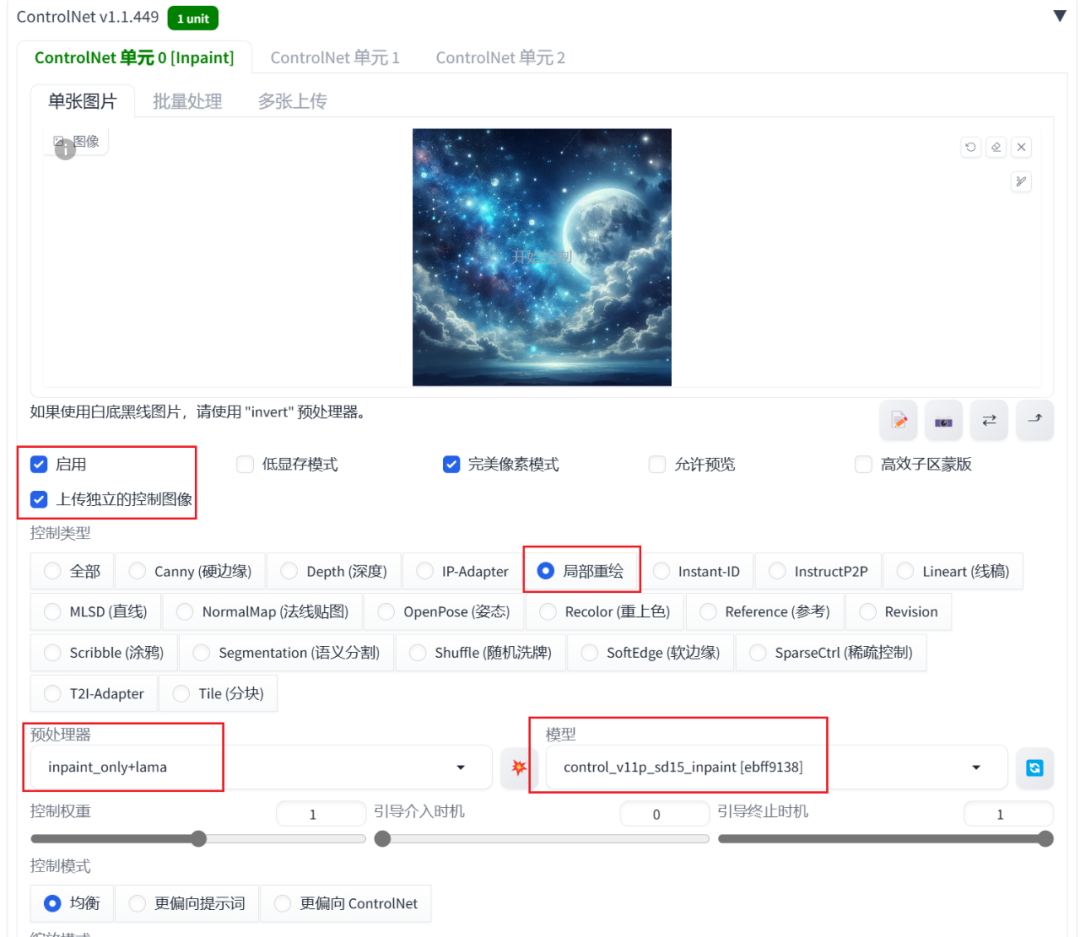

ControlNet局部重绘

同时,还需要配置ControlNet局部重绘 ,上传背景图像实现人物的融合。这里需要选择局部重绘

,inpaint_only+lama 预处理器和control_v11p_sd15_inpaint

ControlNet处理器。配置如下所示:

融合效果

点击生成 按钮,就可以得到相应的融合背景图像:

更多背景融合案例

本文绘图配置如下所示:

• 绘图模型:AWPortrait_v1.4

• 采样方法:DPM++ 2M Karras

• 迭代步数:30步

• 分辨率:512* 768

• 提示词引导系数 (CFG Scale):7

• 放大算法:4x-UltraSharp 2X放大

• 启用ADetailer 修复脸部和手部细节。

本文涉及模型下载地址:(需要的小伙伴可以文末自行扫描获取)

• AWPortrait

• AgainStyle3_Lotus_荷花荷叶效果 LoRA模型

01

lora:AgainStyle3_Lotus:1,AgainStyle3 Lotus,no

humans,outdoors,scenery,day,white flower,sky,blue sky,sunlight,lotus,still

life,green flower,plant,water,bud,realistic,leaf,lily pad,cloud,

背景图想

融合图像

02

lora:AgainStyle3_Lotus:1,AgainStyle3 Lotus,no

humans,flower,sky,outdoors,day,blue sky,blurry,cloud,scenery,depth of

field,red flower,still life,blurry background,orange

flower,sunlight,water,realistic,lens flare,

背景图想

融合图像

生成图后,如果存在边缘融合不充分的,可以采用图生图0.3~0.5低幅度重绘,并结合tiled diffusion和tiledVAE插件和ControlNet tile模型进行细节的修复和增强。

资料软件免费放送

次日同一发放请耐心等待

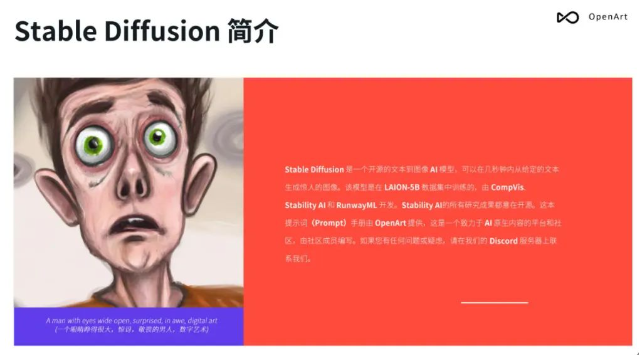

Stable Diffusion 最强提示词手册

- Stable Diffusion介绍

- OpenArt介绍

- 提示词(Prompt) 工程介绍

- …

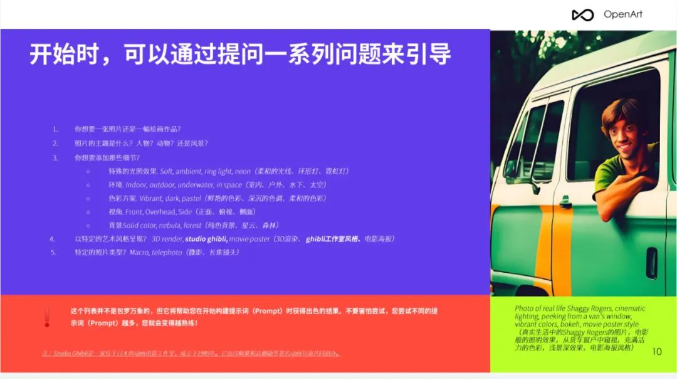

第一章、提示词格式

- 提问引导

- 示例

- 单词的顺序

- …

有需要的朋友,可以点击下方卡片免费领取!

第二章、修饰词(Modifiers)

- Photography/摄影

- Art Mediums/艺术媒介

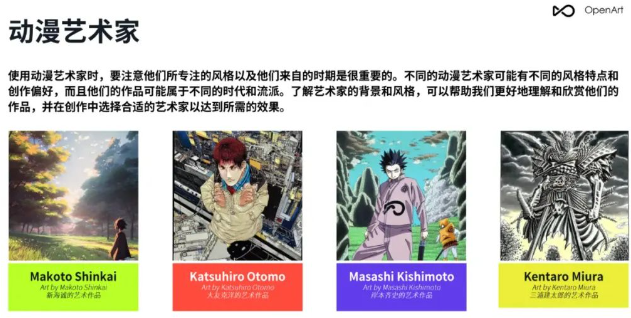

- Artists/艺术家

- Illustration/插图

- Emotions/情感

- Aesthetics/美学

- …

第三章、 Magic words(咒语)

- Highly detailed/高细节

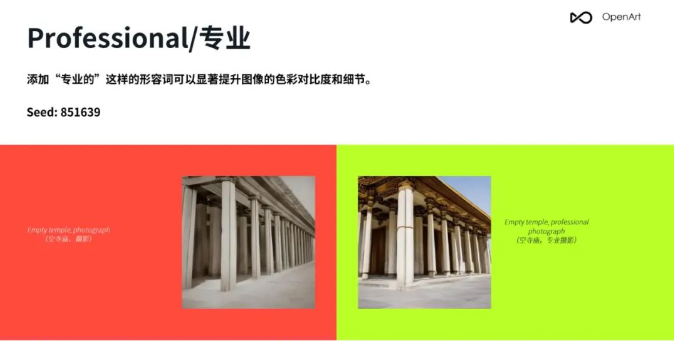

- Professional/专业

- Vivid Colors/鲜艳的颜色

- Bokeh/背景虚化

- Sketch vs Painting/素描 vs 绘画

- …

第四章、Stable Diffusion参数

- Resolution/分辨率

- CFC/提词相关性

- Step count/步数

- Seed/种子

- Sampler/采样

- 反向提示词(Prompt)

第5章 img2img(图生图),in/outpainting(扩展/重绘)

- 将草图转化为专业艺术作品

- 风格转换

- lmg2lmg 变体

- Img2lmg+多个AI问题

- lmg2lmg 低强度变体

- 重绘

- 扩展/裁剪

- …

第6章 重要提示

- 词语的顺序和词语本身一样重要

- 不要忘记常规工具

- 反向提示词(Prompt)

- …

第7章 OpenArt展示

- 提示词 (Prompt)

- 案例展示

- …

篇幅有限,这里就不一一展示了,有需要的朋友可以点击下方的卡片进行领取!

722

722

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?