SD出图不尽人意,与预期相差甚远?

别急,今天就来教大家一招【局部重绘】

让您的作品瞬间焕发新生!

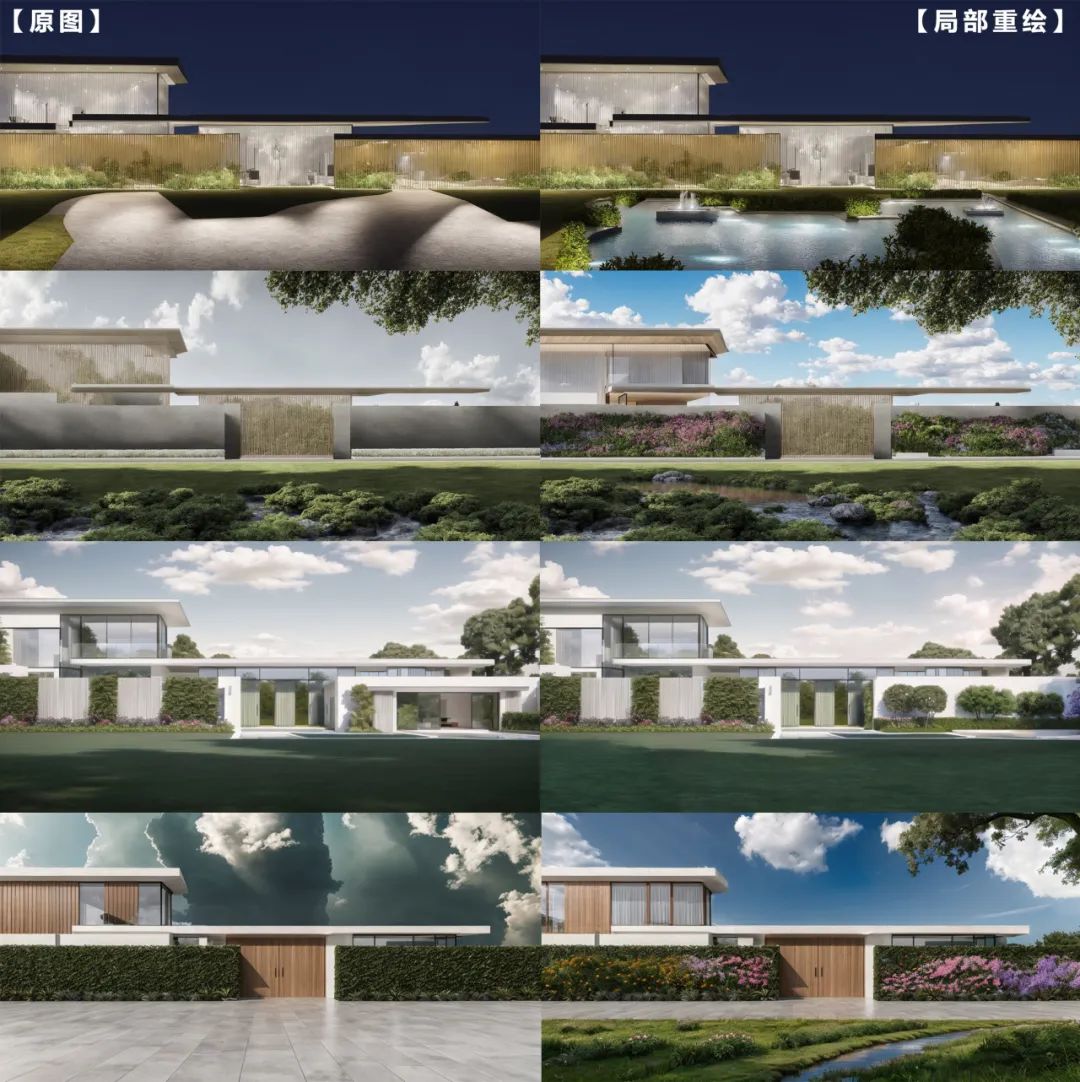

⬇ 让我们先来看看对比图 ⬇

心动了木有!UU们火速上车!!!

上回通过【文生图】,我们用一个朴素的模型,生成了不同的效果~

有这样“美美哒”的~

也有这样“达咩达咩”的 /(ㄒoㄒ)/~~

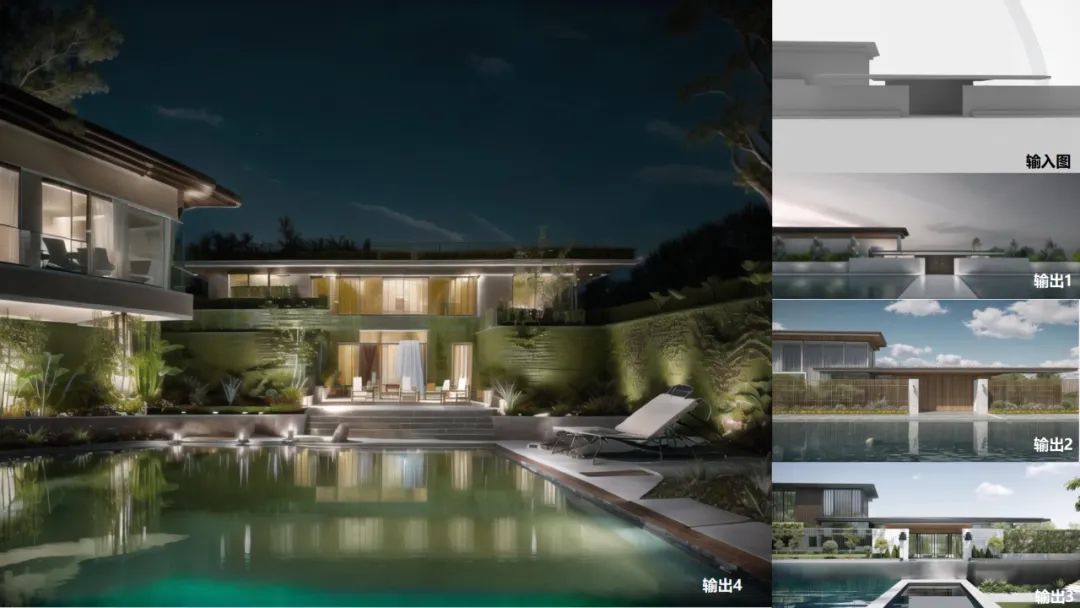

您可以直接保存这张图

跟着我们后面的教程一起操作哦~

不要慌,看我的!!!

巧妙应用【局部重绘】与【蒙版】

让您“美美哒”的图片更加完美,

将“达咩达咩”的图片化腐朽为神奇!

【小新课堂:什么是蒙版?】

*蒙版:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1351

1351

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?