FastGPT 是一个基于 LLM 大语言模型的知识库问答系统,提供开箱即用的数据处理、模型调用等能力,它背后依赖OneApi开源项目来访问各种大语言模型提供的能力。各大语言模型提供的访问接口规范不尽相同,为此OneApi项目提供了统一的API接口去对接各种大语言模型。FastGPT的部署架构如图所示:

本文章将介绍如何部署OneApi和FastGPT,以及两种在线大语言模型(AzureOpenAI 和讯飞星火3.5 )的配置方法。

我将在Windows系统的WSL子系统上进行部署,WSL子系统安装的是Ubuntu22 Linux系统,WSL的部署方式完全适用于真实的Linux系统。

一、部署OneApi

OneApi项目开源地址:https://github.com/songquanpeng/one-api

1.在/opt目录下创建oneapi目录

cd opt

mkdir oneapi

cd oneapi

2.编辑docker-compose.yml文件

在/opt/oneapi目录下创建docker-compose.yml文件,将下面的内容复制进去并保存

version: '3.8'

services:

oneapi:

container_name: oneapi

image: justsong/one-api:latest

restart: unless-stopped

ports:

- 3001:3000

networks:

- llm_net

volumes:

- ./data:/data

environment:

- TZ=Asia/Shanghai

networks:

llm_net:

name: llm_net

external: true

3.创建llm_net docker网络

docker network create llm_net

4.运行oneapi

docker compose up -d

5.配置AzureOpenAI渠道

登录http://localhost:3001,用户名:root,密码:123456。

如果你没有申请AzureOpenAI,可以直接查看讯飞星火的配置方式。其实申请AzureOpenAI并不难,网上教程很多,只要真实填写相关信息,一般24小时内就可以通过。

接下来我们添加AzureOpenAI渠道,按照图中的方式填写就好了。这里有一个需要注意的地方就是名称那一项填的是Azure上面的部署名称,而这个部署名称必须要和模型名称一致(很奇怪的做法,GitHub上已经有人提了issue,正在解决)

6.测试

渠道添加成功后,可以在渠道列表页面点击“测试”按钮,如果没有问题,会返回测试成功。

7.创建令牌

令牌的名称随便填,由于是测试,可以把额度设置为无限额度。

提交后,可以在令牌列表页面复制刚刚创建的令牌,这个令牌将在部署FastGPT时用到。

二、部署fastgpt

1.在/opt目录下创建fastgpt目录

cd opt

mkdir fastgpt

cd fastgpt

2.编辑docker-compose.yml文件

请先阅读FastGPT官方部署文档:https://doc.fastgpt.in/docs/development/docker/

下载docker-compose.yml文件和config.json文件

curl -O https://raw.githubusercontent.com/labring/FastGPT/main/files/deploy/fastgpt/docker-compose.yml

curl -O https://raw.githubusercontent.com/labring/FastGPT/main/projects/app/data/config.json

编辑docker-compose.yml文件,主要是更改了容器网络,数据库用户名密码之类的

version: '3.8'

services:

pg:

image: ankane/pgvector:v0.5.0 # git

# image: registry.cn-hangzhou.aliyuncs.com/fastgpt/pgvector:v0.5.0 # 阿里云

container_name: pg

restart: always

ports:

- 5432:5432

networks:

- llm_net

environment:

- POSTGRES_USER=fastgpt

- POSTGRES_PASSWORD=123456

- POSTGRES_DB=fastgpt

volumes:

- ./pg/data:/var/lib/postgresql/data

mongo:

image: mongo:5.0.18

# image: registry.cn-hangzhou.aliyuncs.com/fastgpt/mongo:5.0.18 # 阿里云

container_name: mongo

ports:

- 27017:27017

networks:

- llm_net

command: mongod --keyFile /data/mongodb.key --replSet rs0

environment:

- MONGO_INITDB_ROOT_USERNAME=fastgpt

- MONGO_INITDB_ROOT_PASSWORD=123456

volumes:

- ./mongo/data:/data/db

- ./mongodb.key:/data/mongodb.key

fastgpt:

container_name: fastgpt

image: ghcr.io/labring/fastgpt:latest # git

# image: registry.cn-hangzhou.aliyuncs.com/fastgpt/fastgpt:latest # 阿里云

ports:

- 3002:3000

networks:

- llm_net

depends_on:

- mongo

- pg

restart: always

environment:

- DEFAULT_ROOT_PSW=123456

- OPENAI_BASE_URL=http://192.168.2.117:3001/v1

- CHAT_API_KEY=sk-XXXXX # 在OneApi中创建的令牌

- DB_MAX_LINK=5 # database max link

- TOKEN_KEY=any

- ROOT_KEY=root_key

- FILE_TOKEN_KEY=filetoken

# mongo 配置,不需要改. 用户名myname,密码mypassword。

- MONGODB_URI=mongodb://fastgpt:123456@mongo:27017/fastgpt?authSource=admin

# pg配置. 不需要改

- PG_URL=postgresql://fastgpt:123456@pg:5432/fastgpt

volumes:

- ./config.json:/app/data/config.json

networks:

llm_net:

name: llm_net

external: true

这里要注意的 OPENAI_BASE_URL=http://192.168.2.117:3001/v1,我本来想设置成http://oneapi:3000/v1,因为fastgpt与oneapi在同一个docker网络,但fastgpt访问不了这个地址,可能是哪里没有设置对,只好先用本机ip来访问。

3.编辑config.json文件

改动如下,name改成在oneapi配置中的一样

4.运行fastgpt

docker compose up -d

运行成功之后,不要忘了对MongoDb进行配置,直接按官网的步骤进行操作:

# 查看 mongo 容器是否正常运行

docker ps

# 进入容器

docker exec -it mongo bash

# 连接数据库

mongo -u myname -p mypassword --authenticationDatabase admin

# 初始化副本集。如果需要外网访问,mongo:27017 可以改成 ip:27017。但是需要同时修改 FastGPT 连接的参数(MONGODB_URI=mongodb://myname:mypassword@mongo:27017/fastgpt?authSource=admin => MONGODB_URI=mongodb://myname:mypassword@ip:27017/fastgpt?authSource=admin)

rs.initiate({

_id: "rs0",

members: [

{ _id: 0, host: "mongo:27017" }

]

})

# 检查状态。如果提示 rs0 状态,则代表运行成功

rs.status()

5.测试

官网说OPENAI_BASE_URL地址后面要加v1,当我加了的时候,测试结果如下,报404:

于是去oneapi容器查看日志,可以看到fastgpt请求已经转到了oneapi,oneapi又去请求AzureOpenAI, AzureOpenAI返回404。于是去Azure上测试部署后的聊天功能,按F12查看网络请求,发现路由里面没有v1

于是更改docker-compose.yml文件,把OPENAI_BASE_URL值中的v1去掉了,重新执行docker-compose up -d ,重启之后继续测试,这次的报错就不一样了,如下图所示:

查看oneapi日志,请求结果是200,但没有响应内容,找了很久的原因,无法得知是OneApi还是Azure OpenAI的问题,于是转而去测试讯飞星火大模型。

三、配置讯飞星火认知大模型

1.创建讯飞模型应用

先去官方领取讯飞星火认知大模型的个人免费试用套餐,然后去到讯飞开放平台去创建基于v3.5版本的应用,得到APPID、APISecret、APIKey三个值(在OneApi中需要用到)

2.在oneapi页面添加星火模型渠道

3.编辑fastgpt的config.json文件

增加星火模型的配置

4.重启fastgpt容器

注意:如果你之前的操作把OPENAI_BASE_URL的v1去掉了,请把它补上,然后执行命令:docker-compose up -d

5.测试

AI模型选择上面配置的spark3.5,测试成功

AI大模型应用怎么学?

这年头AI技术跑得比高铁还快,“早学会AI的碾压同行,晚入门的还能喝口汤,完全不懂的等着被卷成渣”!技术代差带来的生存压力从未如此真实。

兄弟们如果想入门AI大模型应用,没必要到处扒拉零碎教程,我整了套干货大礼包:从入门到精通的思维导图、超详细的实战手册,还有模块化的视频教程!现在无偿分享。

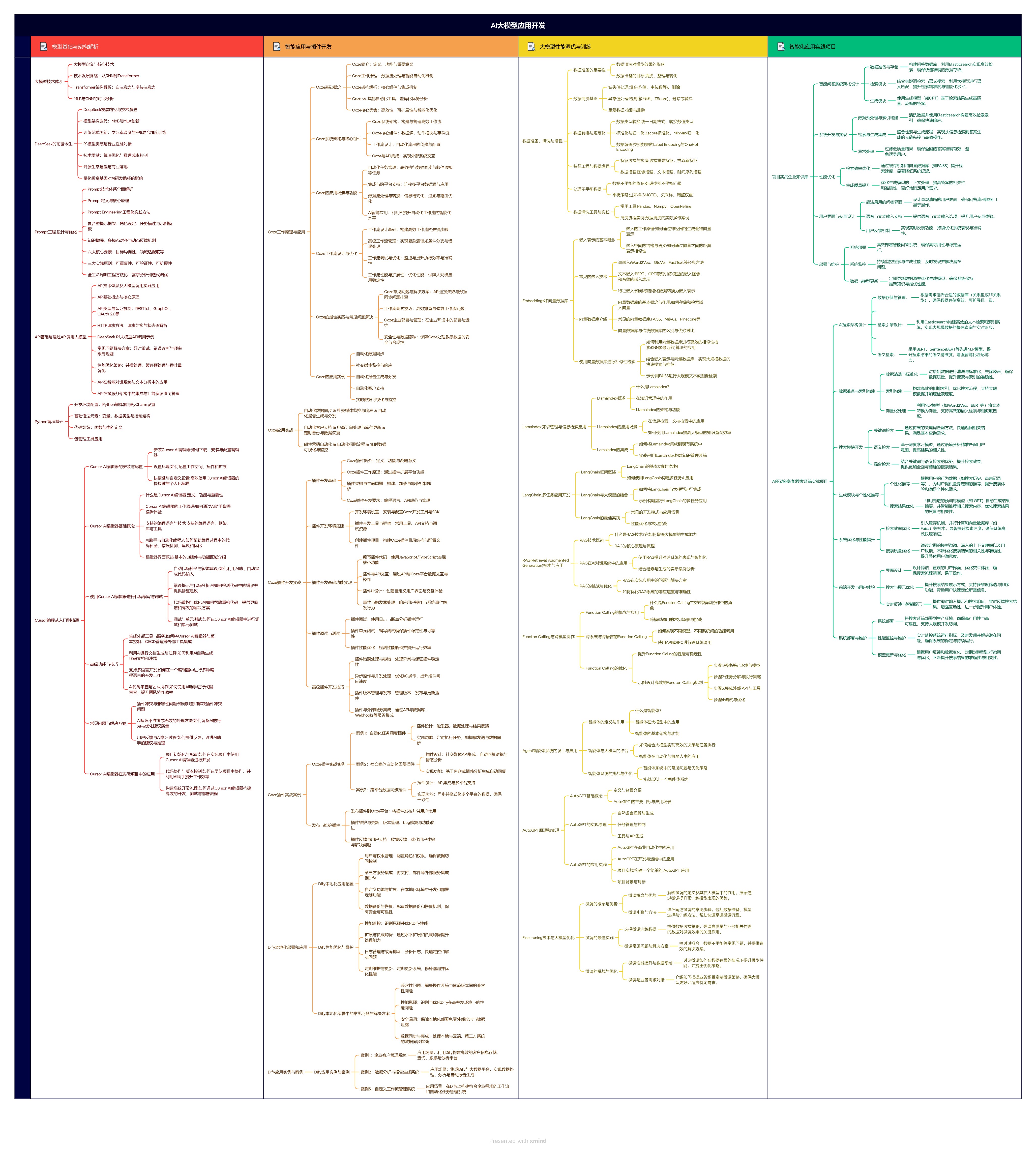

1.学习思维导图

AI大模型应用所有方向的技术点做的整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照下面的知识点去找对应的学习资源,保证自己学得较为全面。

2.从入门到精通全套视频教程

网上虽然也有很多的学习资源,但基本上都残缺不全的,这是我自己整理的大模型视频教程,上面路线图的每一个知识点,我都有配套的视频讲解。

3.技术文档和电子书

整理了行业内PDF书籍、行业报告、文档,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

朋友们如果有需要全套资料包,可以点下面卡片获取,无偿分享!

7665

7665

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?