卷积层

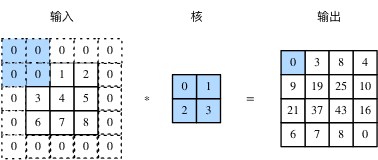

- 填充:

如果原输入的高和宽是nh和nw,卷积核的高和宽是kh和kw,在高的两侧一共填充ph行,在宽的两侧一共填充pw列,则输出形状为:

(nh+ph−kh+1)×(nw+pw−kw+1)

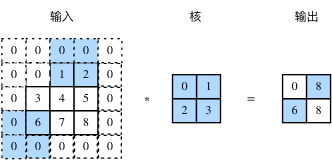

2.步幅:

一般来说,当高上步幅为sh,宽上步幅为sw时,输出形状为:

⌊(nh+ph−kh+sh)/sh⌋×⌊(nw+pw−kw+sw)/sw⌋

如果ph=kh−1,pw=kw−1,那么输出形状将简化为⌊(nh+sh−1)/sh⌋×⌊(nw+sw−1)/sw⌋。更进一步,如果输入的高和宽能分别被高和宽上的步幅整除,那么输出形状将是(nh/sh)×(nw/sw)。

当ph=pw=p时,我们称填充为p;当sh=sw=s时,我们称步幅为s。

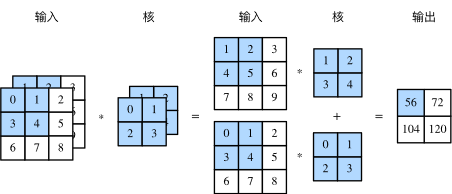

3.多输入通道:

常见卷积神经网络

池化层

池化层主要用于缓解卷积层对位置的过度敏感性。

池化层直接计算池化窗口内元素的最大值或者平均值,该运算也分别叫做最大池化或平均池化。

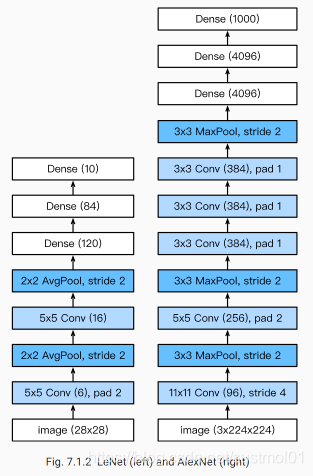

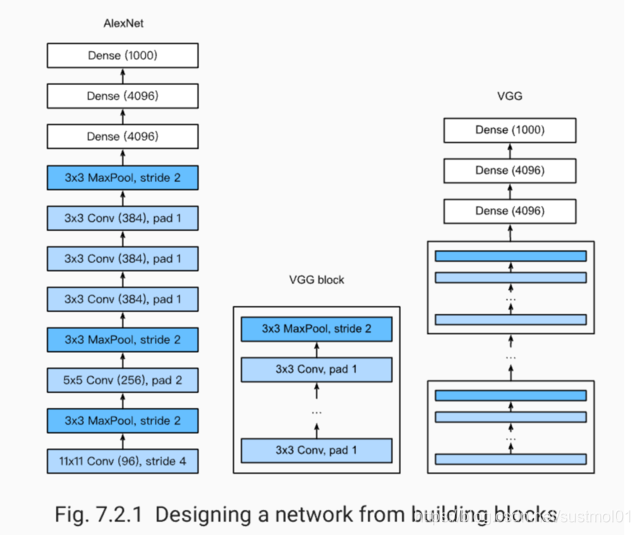

AlexNet

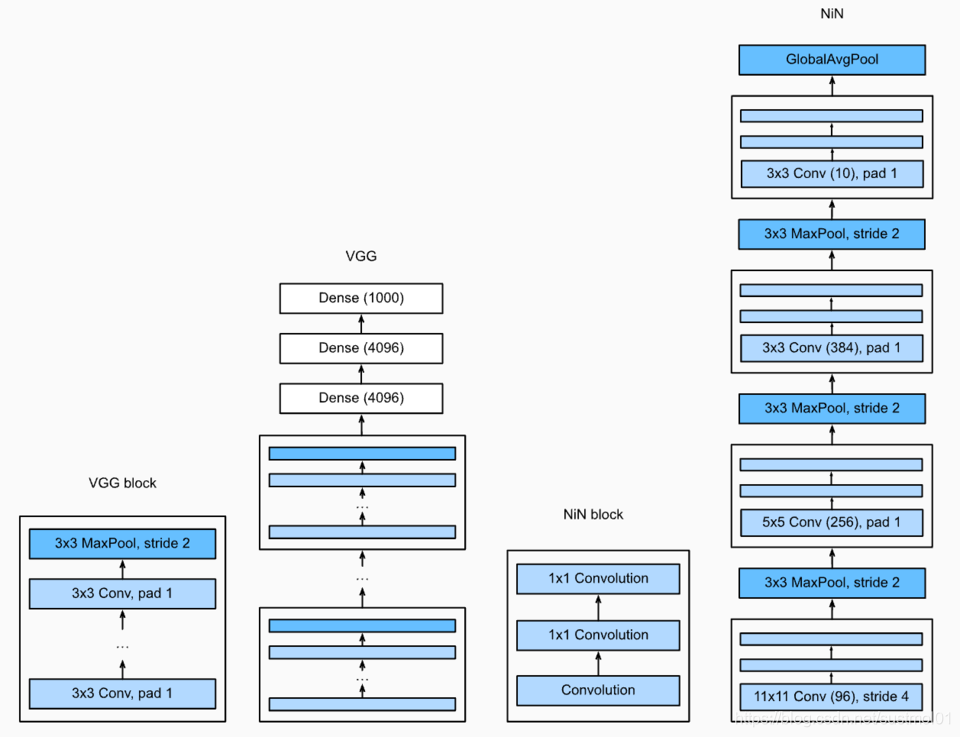

使用重复元素的网络(VGG)

⽹络中的⽹络(NiN)

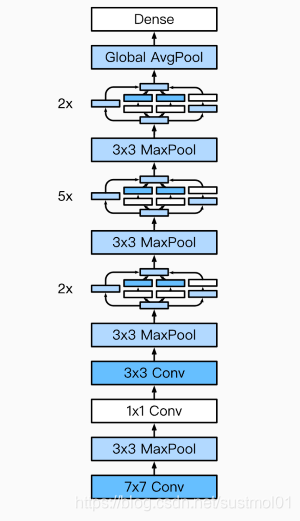

GoogLeNet

本文深入探讨卷积神经网络的三大核心概念:卷积层的填充与步幅,及其如何影响输出形状;多输入通道的处理方式;以及池化层的作用于减少位置敏感性。此外,还介绍了经典网络结构如AlexNet、VGG、NiN和GoogLeNet的设计理念。

本文深入探讨卷积神经网络的三大核心概念:卷积层的填充与步幅,及其如何影响输出形状;多输入通道的处理方式;以及池化层的作用于减少位置敏感性。此外,还介绍了经典网络结构如AlexNet、VGG、NiN和GoogLeNet的设计理念。

1103

1103

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?