作者:夕阳

- SuperMap iObjects配置

从超图软件官网获取SuperMap iObjects for Java Linxu版组件包 与SuperMap iObjects for Spark组件包 。

(1)在/opt下新建一个用于放置SuperMap iObjects for Java相关类库的文件夹。

mkdir /opt/iObjectsJava

(2)将SuperMap iObjects for Java包,放到/opt/iObjectsJava下进行解压。

tar -zxvf [解压文件]

(3)在/opt下新建一个用于放置SuperMap iObjects for Spark相关类库的文件夹。

mkdir /opt/iObjectsSpark

将SuperMap iObjects for Spark包中lib文件夹中的jar包,放到/opt/iObjectsSpark中。 - Apache Spark 安装

(1)将spark-2.1.0-bin-hadoop2.7.tgz 包,放到/opt下解压。

(2)将Spark环境变量配置到/etc/profile中。

export SPARK_HOME=/opt/spark-2.1.0-bin-hadoop2.7

export PATH=$ JAVA_HOME/bin:$ SPARK_HOME/bin:$ PATH - Apache Spark 配置

(1)配置 spark-env.sh

进入spark-2.1.0-bin-hadoop2.7/conf目录,复制 spark-env.sh.template 并重命名为 spark-env.sh。

cp spark-env.sh.template spark-env.sh

编辑spark-env.sh文件,添加以下内容。

export JAVA_HOME=/opt/jdk

export SPARK_MASTER_IP=192.168.29.161

export SPARK_WORKER_MEMORY=4g

export SPARK_WORKER_CORES=4

export SPARK_EXECUTOR_MEMORY=4g

export SUPERMAP_OBJ=/opt/iObjectsJava/Bin

export LD_LIBRARY_PATH=$ LD_LIBRARY_PATH:$ SUPERMAP_OBJ:/opt/jdk/jre/lib/amd64

export SPARK_CLASSPATH=$SPARK_CLASSPATH:/opt/iObjectsSpark

(2)配置slaves。复制slaves.template并重命名为slaves:

cp slaves.template slaves

修改slaves文件,将localhost改为master。 - Apache Spark 启动

(1)进入spark-2.1.0-bin-hadoop2.7/sbin目录下执行如下命令,启动spark。

./start-all.sh

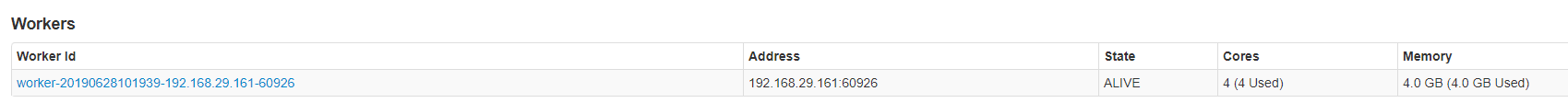

(2)浏览器访问ip:8080看到下图页面则表示spark已经搭建成功。

- 使用SuperMap iServer接入外部spark

(1)启动iServer后,浏览器访问ip:8090/iserver/manager,登陆SuperMap iServer管理页面,点击选项卡【集群】-> 【配置集群】 -> 【配置Spark集群】,选择“启用其他Spark集群服务”-> 在“集群地址”栏中填写Spark集群服务IP:端口(默认7077)。

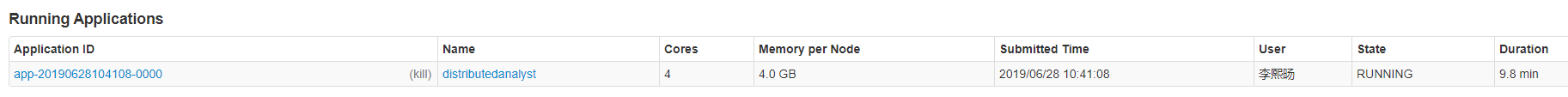

(2)点击选项卡【集群】-> 【分布式分析服务】,在配置分布式分析服务中勾选启用后,打开ip:8080看到Running Applications有进程则启动成功。

本文介绍了SuperMap iObjects的配置,包括获取Java和Spark组件包并解压。还详细说明了Apache Spark的安装、配置与启动步骤,如解压包、配置环境变量、编辑配置文件等。最后讲解了使用SuperMap iServer接入外部Spark的方法,通过管理页面进行集群配置和分布式分析服务启用。

本文介绍了SuperMap iObjects的配置,包括获取Java和Spark组件包并解压。还详细说明了Apache Spark的安装、配置与启动步骤,如解压包、配置环境变量、编辑配置文件等。最后讲解了使用SuperMap iServer接入外部Spark的方法,通过管理页面进行集群配置和分布式分析服务启用。

4072

4072

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?