一、总结

1. 简介

发表时间:2023年12月3日

论文:

[2307.01197] Segment Anything Meets Point Tracking (arxiv.org)![]() https://arxiv.org/abs/2307.01197代码:

https://arxiv.org/abs/2307.01197代码:

2. 摘要

现有的关于视频注释的方法大多数侧重于掩码注释和传播,这大大降低了标注的效率和模型的泛化性。本文提出的SAM-PT是:通过结合SAM的图像分割功能和PT的点跟踪功能,引入了一种以点为中心的交互式视频分割方法。它使用稀疏点传播实现了对用户查询点的有效跟踪。与传统的以对象为中心的掩码传播策略相比,本文使用点传播以利用与对象语义无关的局部结构信息。实验结果表明,基于点的分割跟踪器能够实现更好的零样本性能和高效的交互,SAM-PT在视频分割任务中取得了很强的性能,包括半监督、开放世界和全交互式视频分割。虽然我们的方法存在一些局限性,如难以处理遮挡、小物体、运动模糊和掩码预测不一致,但它为视频对象分割研究提供了一个新的视角。

3. 前言

视频图像分割是自动驾驶、机器人和视频编辑等多个领域应用的核心支柱。近年来,深度学习技术在这些领域都取得了很大进展,但仍存在许多挑战。一是为了实现高精度的分割,这些模型仍需要大量的训练数据、标注数据和昂贵的标签,并且现有的交互式视频分割方法假定视频第一帧给定了某个对象的掩码,但获取准确的掩码耗时耗力;二是目前的主流方法,例如半监督视频对象分割(VOS)和视频实例分割(VIS)在处理未见过的数据时性能会降低。

由于SAM模型具有强大的零样本泛化能力,同时点跟踪方法(PT)可以将点跨越视频帧进行传播,于是本文将两者结合,提出了SAM-PT方法。SAM-PT只需要在第一帧稀疏地标记点以表示目标对象,同时使用最先进的点跟踪器(如Co-Tracker)预测稀疏点轨迹来作为提示符提示SAM。这样做不仅显著降低了标注成本,同时保证了SAM固有的灵活性,使其能够在视频分割方面以及在零样本设置下取得比以前更好的性能。

4. 贡献

(1)本文是首个将稀疏点跟踪(PT)和SAM结合用于视频分割的方法,为交互式视频分割同时实现了领域泛化能力和标记效率。

(2)为了细化输出掩码,提出了多种掩码解码过程。

(3)设计了一种点二重初始化策略,模型可以随着时间推移提高跟踪精度。

(4)使用了多种设置对SAM-PT进行评估,结果显示SAM-PT在DAVIS上比现有零样本方法高出5.0%以上,在YouTube-VOS上高出2.0%,在BDD100K 上高出7.3%,同时在UVO上也超越了完全监督的VIS方法。这证明了SAM-PT完全减少了注释工作量,接近完全监督方法的性能。

二、模型架构

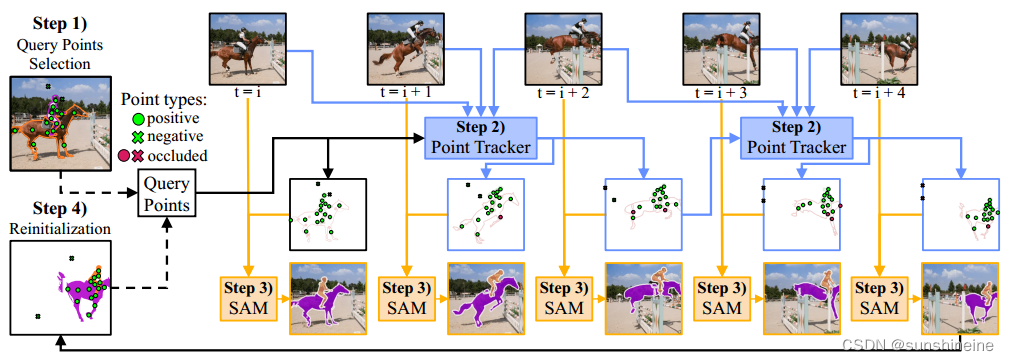

SAM-PT模型的点传播策略与传统面向对象跟踪的方法相比有以下几个具体优势。第一,点传播能够利用局部结构的上下文,且上下文对全局对象语义是未知的,这不仅增强了该模型的零样本泛化能力,更与SAM固有泛化能力结合,以允许在各种环境中跟踪各种对象。第二,SAM-PT允许稀疏点进行更紧凑的物体表示,以捕获足够信息有效表示对象部分。第三,SAM通过训练,可以有效处理稀疏点提示,能够与PT良好集成。具体流程如下图所示:

Step1:查询点选择

这个过程首先定义视频第一帧的查询点。查询点要么是表示目标物体的正点,要么表示非目标物体或背景的负点。用户可以手动交互式地提交查询点,也可以使用点采样技术从ground truth掩码派生出来。本文的消融实验证明K-Medoids采样效果最佳,基本可以完整覆盖对象的各个部分。

Step2:点跟踪

从查询点开始使用点跟踪器将点传播到视频所有帧中,并获得点轨迹和遮挡分数。点跟踪器采用PIPS和最先进的CoTracker进行点传播,有效处理遮挡和长期跟踪问题。实验证明长期点跟踪器比链式光流传播或第一帧对应关系等方法更有效。

Step3:分割

本步骤两次调用SAM来结合正点和负点。第一次调用使用正点提示SAM目标物体的初始位置。第二次调用将正点和负点还有之前的掩码预测一起提示 SAM。最后重复第二次调用来执行可变数量的掩码细化迭代。

Step4:点跟踪二重初始化

为了提高跟踪的准确性,模型可以在预测轨迹达到一定帧数后(如h=8),使用最新的掩码重新初始化查询点并迭代执行step1~4整个过程。这个过程包括丢弃不可靠或被遮挡的点并合并之后的帧里可见的对象部分的点,以提高跟踪精度。

1069

1069

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?