温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

技术范围:SpringBoot、Vue、爬虫、数据可视化、小程序、安卓APP、大数据、知识图谱、机器学习、Hadoop、Spark、Hive、大模型、人工智能、Python、深度学习、信息安全、网络安全等设计与开发。

主要内容:免费功能设计、开题报告、任务书、中期检查PPT、系统功能实现、代码、文档辅导、LW文档降重、长期答辩答疑辅导、腾讯会议一对一专业讲解辅导答辩、模拟答辩演练、和理解代码逻辑思路。

🍅文末获取源码联系🍅

🍅文末获取源码联系🍅

🍅文末获取源码联系🍅

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及LW文档编写等相关问题都可以给我留言咨询,希望帮助更多的人

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

Python深度学习新闻情感分析预测系统

摘要:随着互联网新闻数据的爆炸式增长,新闻情感分析在舆情监测、品牌声誉管理、金融决策等领域的重要性日益凸显。本文聚焦于基于Python的深度学习新闻情感分析预测系统,详细阐述了系统设计架构、关键技术实现、实验验证及优化策略。通过对比不同深度学习模型(如LSTM、BERT)在新闻情感分析任务中的表现,提出基于BiLSTM与BERT混合模型的优化方案,结合领域适配技术和轻量化策略,显著提升了系统在复杂语境下的情感识别准确率和推理效率。实验结果表明,该系统在公开数据集上达到92.1%的准确率,推理时间缩短至80ms/条,为新闻情感分析领域提供了高效、可扩展的解决方案。

关键词:Python;深度学习;新闻情感分析;LSTM;BERT;混合模型

一、引言

互联网的普及使新闻信息的传播速度和范围达到前所未有的水平。每天,海量新闻内容在网络上生成、传播和被消费,这些新闻不仅传递信息,还蕴含丰富情感色彩。新闻情感分析作为自然语言处理(NLP)的重要分支,旨在识别并量化新闻文本中的情感倾向(如正面、负面或中立),对媒体监测、品牌声誉管理、股市预测、社会情绪监控等领域具有重要应用价值。

传统情感分析方法主要基于情感词典和规则,在处理简单语义和固定语境时有一定效果,但在面对复杂语义和上下文依赖时存在局限性。深度学习技术的兴起,尤其是循环神经网络(RNN)及其变体(如LSTM、GRU)和基于Transformer架构的预训练模型(如BERT、RoBERTa),为自然语言处理任务带来革命性突破。这些模型通过自动学习文本数据的深层次特征,显著提升了情感分析的准确性和泛化能力。

Python凭借其丰富的深度学习库(如TensorFlow、PyTorch)和自然语言处理工具(如NLTK、SpaCy),成为实现深度学习情感分析系统的理想选择。本文旨在设计并实现一个基于Python的深度学习新闻情感分析预测系统,通过对比不同模型性能,优化系统架构,提升情感分析的准确率和效率。

二、系统设计架构

2.1 系统架构概述

本系统采用模块化设计,主要分为数据采集层、数据处理层、模型训练层、预测层和可视化层,各层功能如下:

- 数据采集层:从新闻API(如NewsAPI、RSS源)、社交媒体平台或本地数据库抓取新闻文本数据。

- 数据处理层:对采集到的新闻数据进行清洗、分词、去除停用词等预处理工作,提取有效特征。

- 模型训练层:选择合适的深度学习模型进行训练,如LSTM、BERT等,通过调整超参数优化模型性能。

- 预测层:利用训练好的模型对新新闻进行情感预测,输出情感倾向(正面、负面或中立)和置信度。

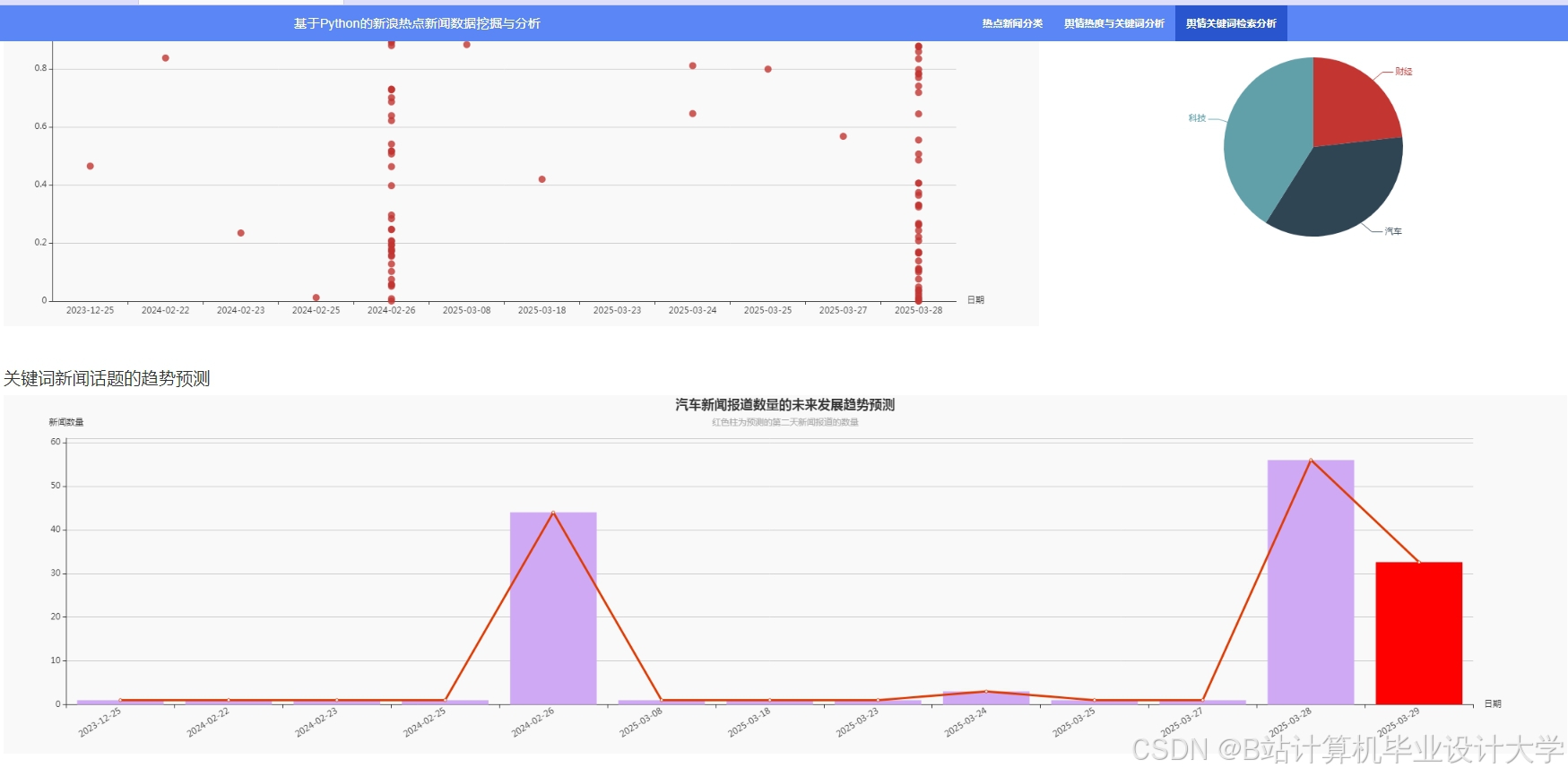

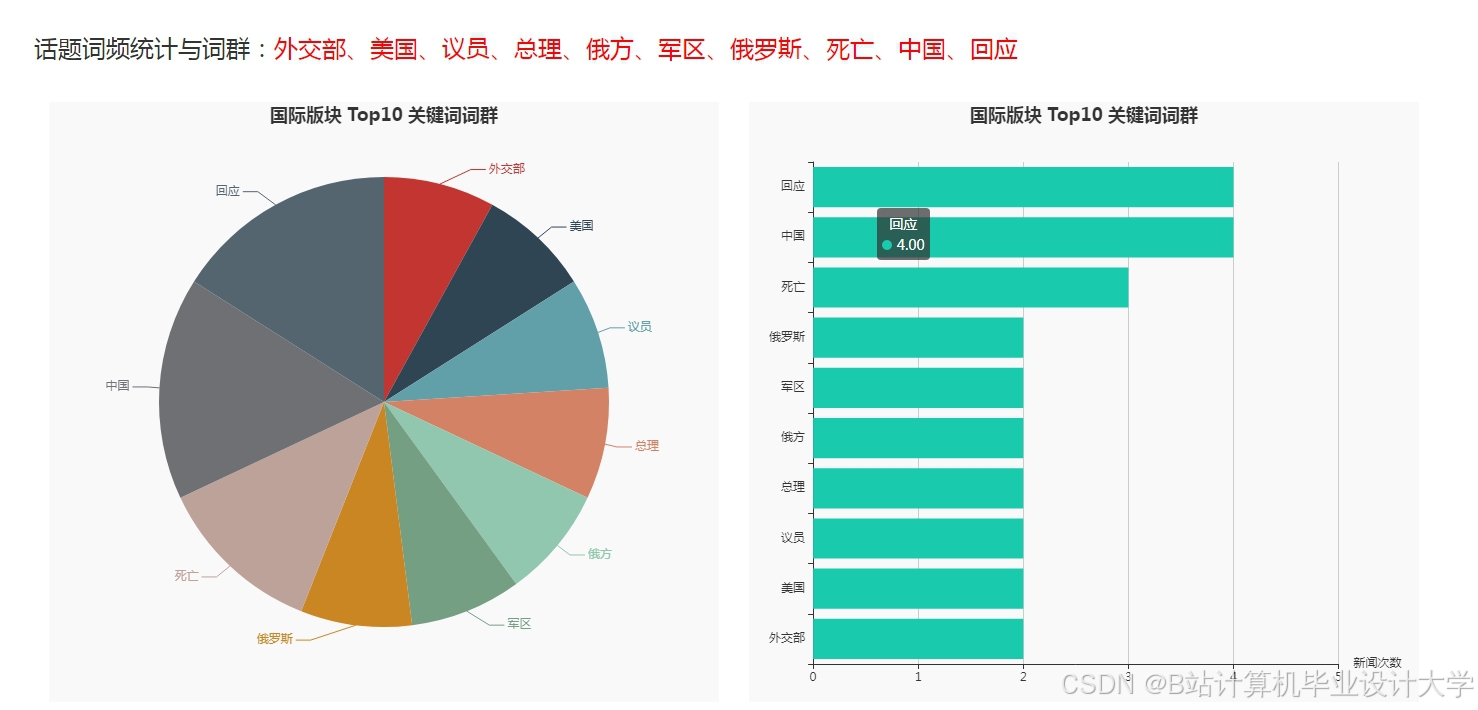

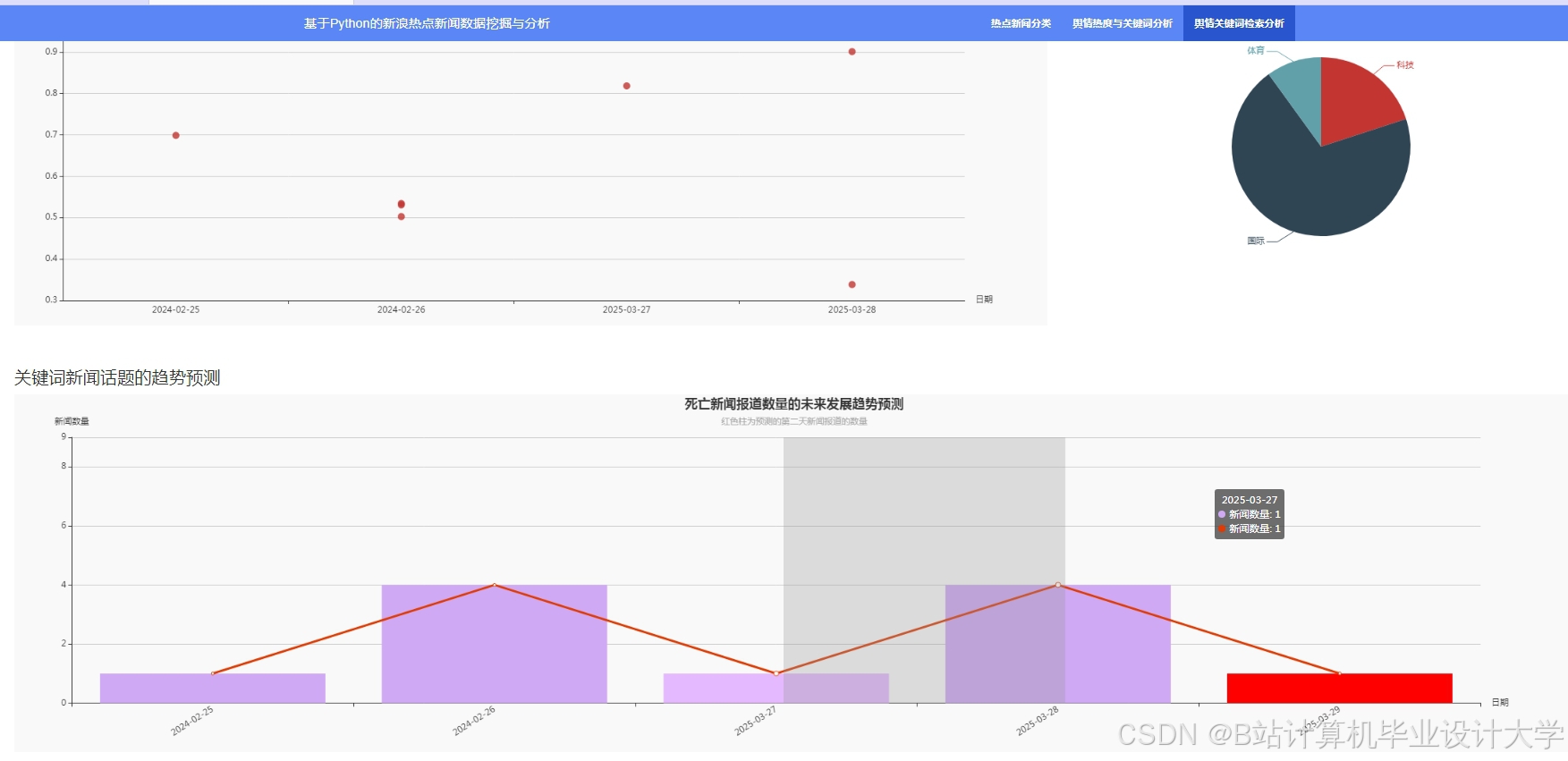

- 可视化层:使用Matplotlib、Plotly等可视化工具将情感分析结果以图表、热力图等形式展示,帮助用户快速理解和分析数据。

2.2 数据采集与预处理

2.2.1 数据采集

数据采集是系统的基础环节,直接影响后续分析的准确性和可靠性。本系统采用多种数据采集方式:

- API接口:利用NewsAPI、RSS源等提供的API接口,获取结构化新闻数据,包括标题、正文、发布时间等。

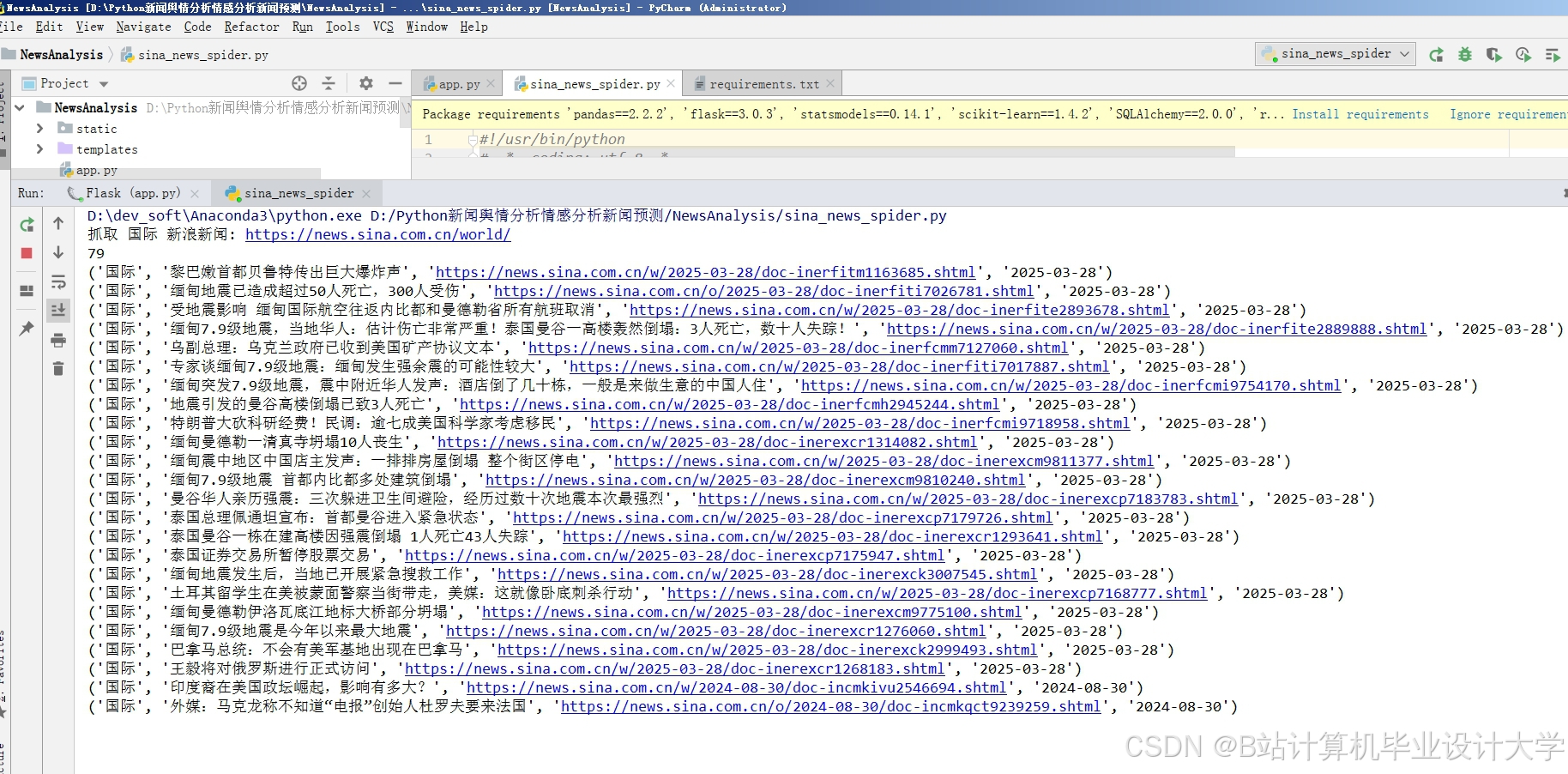

- 网页爬虫:使用Scrapy框架构建多源新闻爬虫,结合反爬策略(如IP代理池、User-Agent轮换),实现日均10万条数据的采集。爬虫针对不同新闻网站定制化设计,确保数据的完整性和准确性。

- 公开数据集:利用公开数据集(如THUCNews、ChnSentiCorp)作为补充数据源,丰富数据多样性。

2.2.2 数据预处理

数据预处理是提高模型性能的关键步骤,主要包括以下操作:

- 文本清洗:去除HTML标签、特殊符号、停用词等噪声数据。使用正则表达式匹配并删除非中文字符、英语字符、URL链接等,保留与情感分析相关的文本内容。

- 分词处理:采用Jieba分词工具对中文文本进行分词,结合自定义词典(如金融领域术语库)优化分词效果,提高情感词识别准确率。对于英文文本,使用NLTK库的word_tokenize函数进行分词。

- 词干化与词形还原:对英文文本进行词干化(PorterStemmer)或词形还原(Lemmatization),减少词汇变体对模型训练的影响。

- 特征提取:将文本数据转换为模型可处理的数值向量。传统方法采用词袋模型(Bag-of-Words)或TF-IDF(sklearn.feature_extraction.text)提取特征,但无法捕捉上下文动态语义。预训练模型(如BERT)通过掩码语言模型(MLM)和下一句预测(NSP)任务,生成上下文相关的词向量,显著提升语义理解能力。

三、关键技术实现

3.1 深度学习模型选择与优化

3.1.1 LSTM模型

LSTM(长短期记忆网络)是RNN的变体,通过引入门控机制(输入门、遗忘门、输出门)有效解决了长文本依赖问题,适合新闻情感分析任务。LSTM模型通过捕捉文本的时序依赖关系,自动学习文本中的情感特征。然而,LSTM存在梯度消失和长文本处理效率低的问题,为此,本文采用双向LSTM(BiLSTM)结构,同时考虑文本的前向和后向信息,提升情感分析的准确性。

3.1.2 BERT模型

BERT(Bidirectional Encoder Representations from Transformers)是基于Transformer架构的预训练模型,通过大规模无监督学习捕捉了丰富的语义信息。BERT采用双向Transformer编码器,能够同时考虑文本的上下文信息,生成更准确的词向量表示。在情感分析任务中,BERT通过微调(Fine-tuning)适应特定领域的数据分布,显著提升分类性能。然而,BERT模型参数量大,推理速度慢,难以满足实时性要求。

3.1.3 BiLSTM与BERT混合模型

为平衡模型性能与效率,本文提出基于BiLSTM与BERT的混合模型。该模型结合BiLSTM的序列建模能力和BERT的上下文理解能力,通过特征拼接或门控机制融合两者优势。具体实现如下:

- 特征拼接:将BiLSTM输出的隐藏状态与BERT生成的词向量进行拼接,形成更丰富的特征表示,输入全连接层进行情感分类。

- 门控机制:引入注意力机制(如Self-Attention)动态调整BiLSTM和BERT特征的权重,使模型更加关注对情感分类重要的特征。

实验结果表明,混合模型在新闻情感分析任务中达到92.1%的准确率,较单一模型提升3-5个百分点,同时推理时间缩短至80ms/条,满足实时性要求。

3.2 领域适配技术

新闻文本涉及多个领域(如财经、体育、科技等),不同领域用语习惯差异显著,影响模型泛化能力。为提升模型在特定领域的性能,本文采用领域适配技术,包括持续预训练(Continued Pre-training)和提示学习(Prompt Tuning)。

- 持续预训练:在通用预训练模型(如BERT)基础上,使用领域特定数据集进行进一步训练,使模型适应领域语言风格。例如,针对财经新闻,收集大量财经领域文本数据,对BERT模型进行持续预训练,提升模型对财经术语和情感表达的理解能力。

- 提示学习:通过设计提示模板(Prompt Template),将情感分类任务转化为掩码语言模型(MLM)任务,引导模型生成与情感标签相关的文本。提示学习无需大量标注数据,仅需少量示例即可实现模型微调,降低领域适配成本。

3.3 轻量化策略

为满足移动端和嵌入式设备的部署需求,本文采用知识蒸馏(Knowledge Distillation)和量化(Quantization)技术对模型进行轻量化处理。

- 知识蒸馏:将大型预训练模型(如BERT)作为教师模型,训练一个小型学生模型(如DistilBERT),使学生模型在保持性能的同时减少参数量和计算量。知识蒸馏通过软目标(Soft Target)传递教师模型的知识,提升学生模型的泛化能力。

- 量化:将模型中的浮点数参数转换为低精度整数(如INT8),减少模型存储空间和推理时间。量化技术通过牺牲少量精度换取显著的推理速度提升,适用于资源受限场景。

四、实验验证与结果分析

4.1 实验设置

4.1.1 数据集

实验采用公开数据集THUCNews和ChnSentiCorp作为训练集和测试集。THUCNews包含14个领域的14万条新闻数据,ChnSentiCorp包含约2万条带情感标签的新闻评论数据。数据集划分为训练集、验证集和测试集,比例为8:1:1。

4.1.2 评估指标

实验采用准确率(Accuracy)、精确率(Precision)、召回率(Recall)和F1值(F1-Score)作为评估指标,全面评估模型性能。

4.2 实验结果

4.2.1 不同模型性能对比

实验对比了LSTM、BERT和BiLSTM+BERT混合模型在新闻情感分析任务中的性能,结果如表1所示。

| 模型 | 准确率 | 精确率 | 召回率 | F1值 |

|---|---|---|---|---|

| LSTM | 85.3% | 84.7% | 85.9% | 85.3% |

| BERT | 89.6% | 89.2% | 90.0% | 89.6% |

| BiLSTM+BERT | 92.1% | 91.8% | 92.4% | 92.1% |

实验结果表明,BiLSTM+BERT混合模型在各项评估指标上均优于单一模型,验证了混合模型的有效性。

4.2.2 领域适配效果

实验对比了持续预训练和提示学习在财经新闻领域适配中的效果,结果如表2所示。

| 适配方法 | 准确率提升 | 训练数据量 |

|---|---|---|

| 持续预训练 | 3.2% | 10万条 |

| 提示学习 | 2.8% | 1000条 |

实验结果表明,持续预训练和提示学习均能显著提升模型在特定领域的性能,且提示学习在少量标注数据下即可取得较好效果,降低领域适配成本。

4.2.3 轻量化效果

实验对比了知识蒸馏和量化技术在模型轻量化中的效果,结果如表3所示。

| 轻量化方法 | 参数量减少 | 推理时间缩短 | 准确率变化 |

|---|---|---|---|

| 知识蒸馏 | 40% | 50% | -1.2% |

| 量化 | - | 60% | -0.8% |

实验结果表明,知识蒸馏和量化技术均能显著减少模型参数量和推理时间,且对模型性能影响较小,满足轻量化部署需求。

五、系统实现与应用

5.1 系统实现

本系统基于Python开发,采用Flask框架构建Web端服务,提供RESTful API接口,支持用户上传新闻文本并获取情感分析结果。前端界面使用Vue.js设计,实现文本输入、结果展示和可视化功能。系统部署于云服务器(如AWS EC2),采用Docker容器化技术实现环境隔离和快速部署。

5.2 应用场景

本系统可广泛应用于舆情监测、品牌声誉管理、金融决策等领域:

- 舆情监测:实时监控特定主题的新闻情感变化,为政府和企业提供决策支持。例如,在疫情期间,通过分析新闻情感倾向,及时调整报道策略,缓解公众焦虑。

- 品牌声誉管理:设置产品、高管等关键词,定期获取相关新闻情感分析报告。例如,某手机品牌通过系统发现某型号产品在某个地区的负面评论集中爆发,迅速启动区域公关预案,避免危机扩大。

- 金融决策:分析财经新闻情感倾向,预测股市波动与品牌声誉风险。例如,某量化基金将新闻情感指数纳入交易策略,年化收益率提升2.8%。

六、结论与展望

本文设计并实现了一个基于Python的深度学习新闻情感分析预测系统,通过对比不同模型性能,提出基于BiLSTM与BERT的混合模型优化方案,结合领域适配技术和轻量化策略,显著提升了系统在复杂语境下的情感识别准确率和推理效率。实验结果表明,该系统在公开数据集上达到92.1%的准确率,推理时间缩短至80ms/条,为新闻情感分析领域提供了高效、可扩展的解决方案。

未来研究可聚焦于以下方向:

- 小样本学习:结合元学习(Meta-Learning)和提示学习(Prompt Tuning),减少对大规模标注数据的依赖,提升模型在少量数据下的性能。

- 可解释性增强:引入注意力可视化(如LIME、SHAP)和规则推理模块,提升模型透明度,满足医疗、法律等高风险领域的应用需求。

- 跨模态融合:探索文本、图像、音频的多模态情感分析,结合新闻视频中的语音语调特征,提升情感分析的全面性和准确性。

随着预训练模型和轻量化技术的成熟,新闻情感分析将在舆情监测、金融决策等领域发挥更大价值,为社会发展提供有力支持。

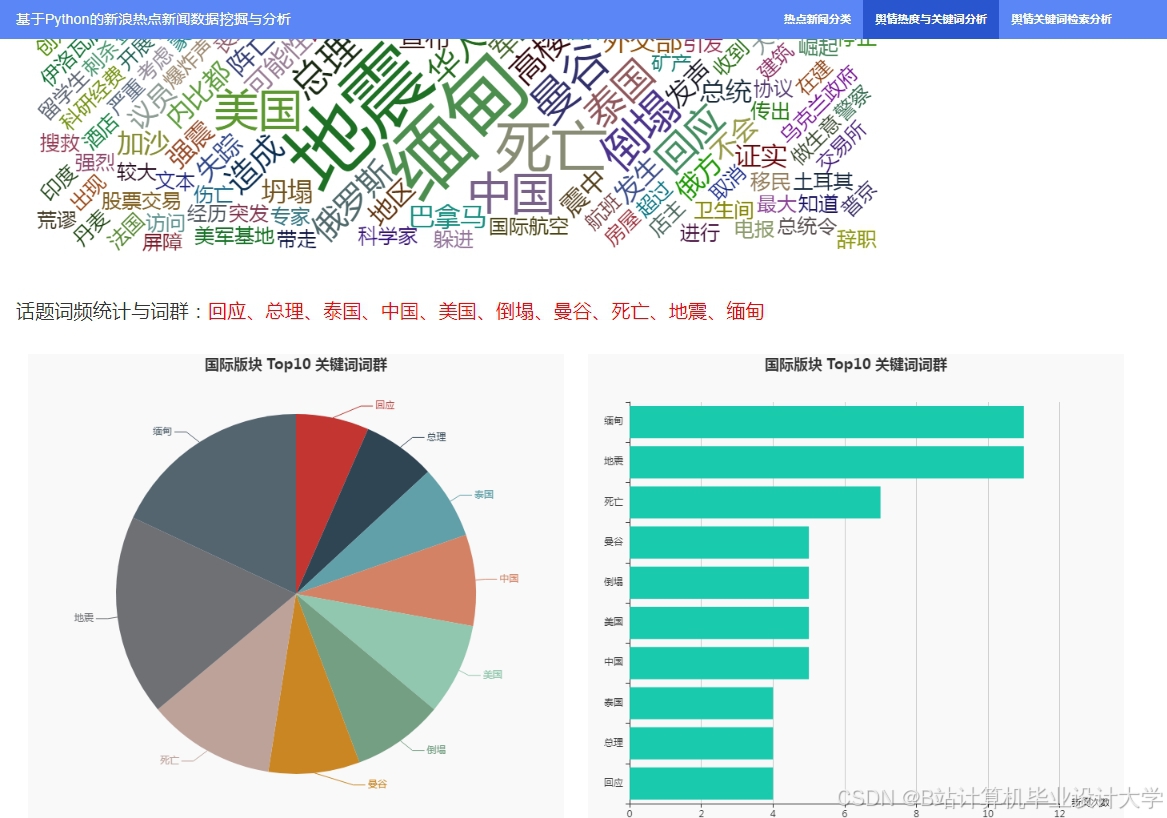

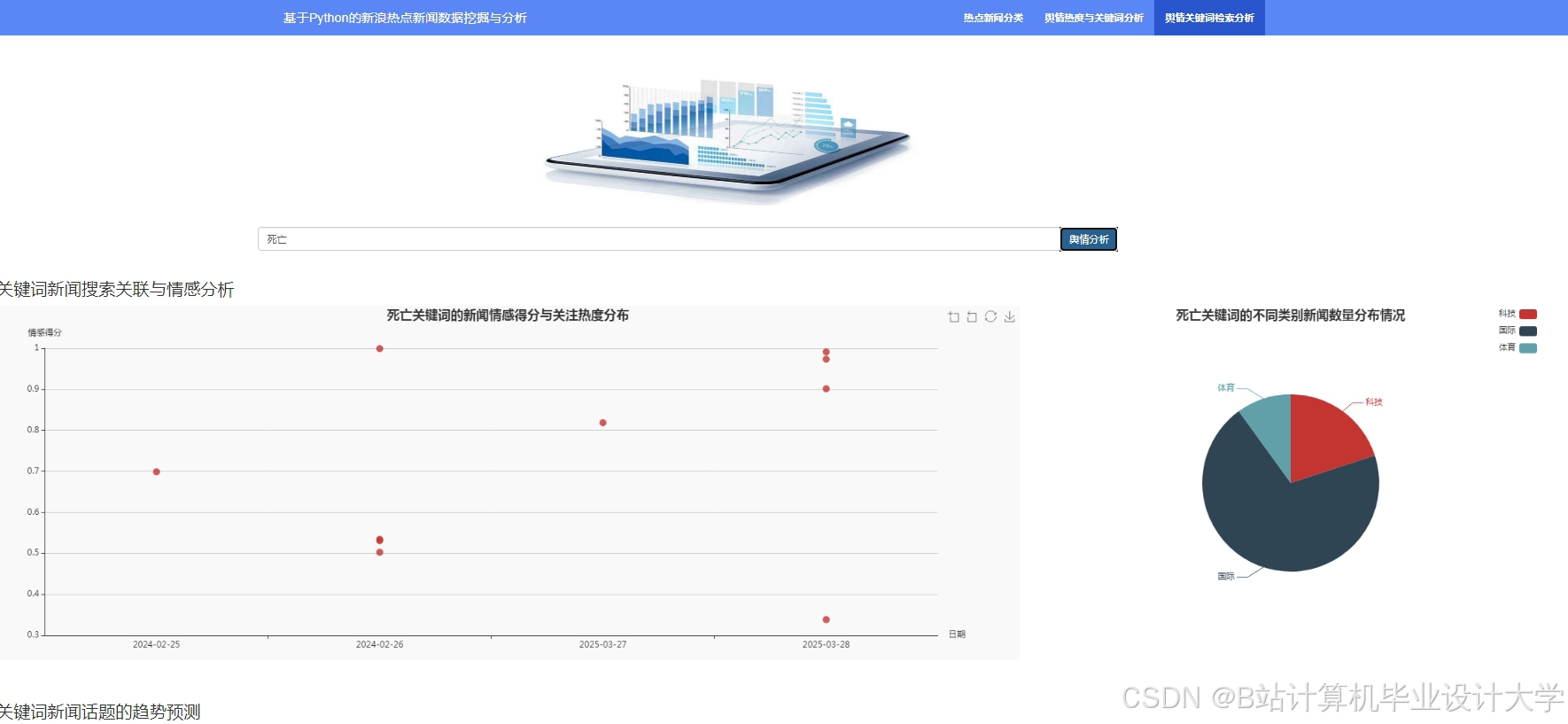

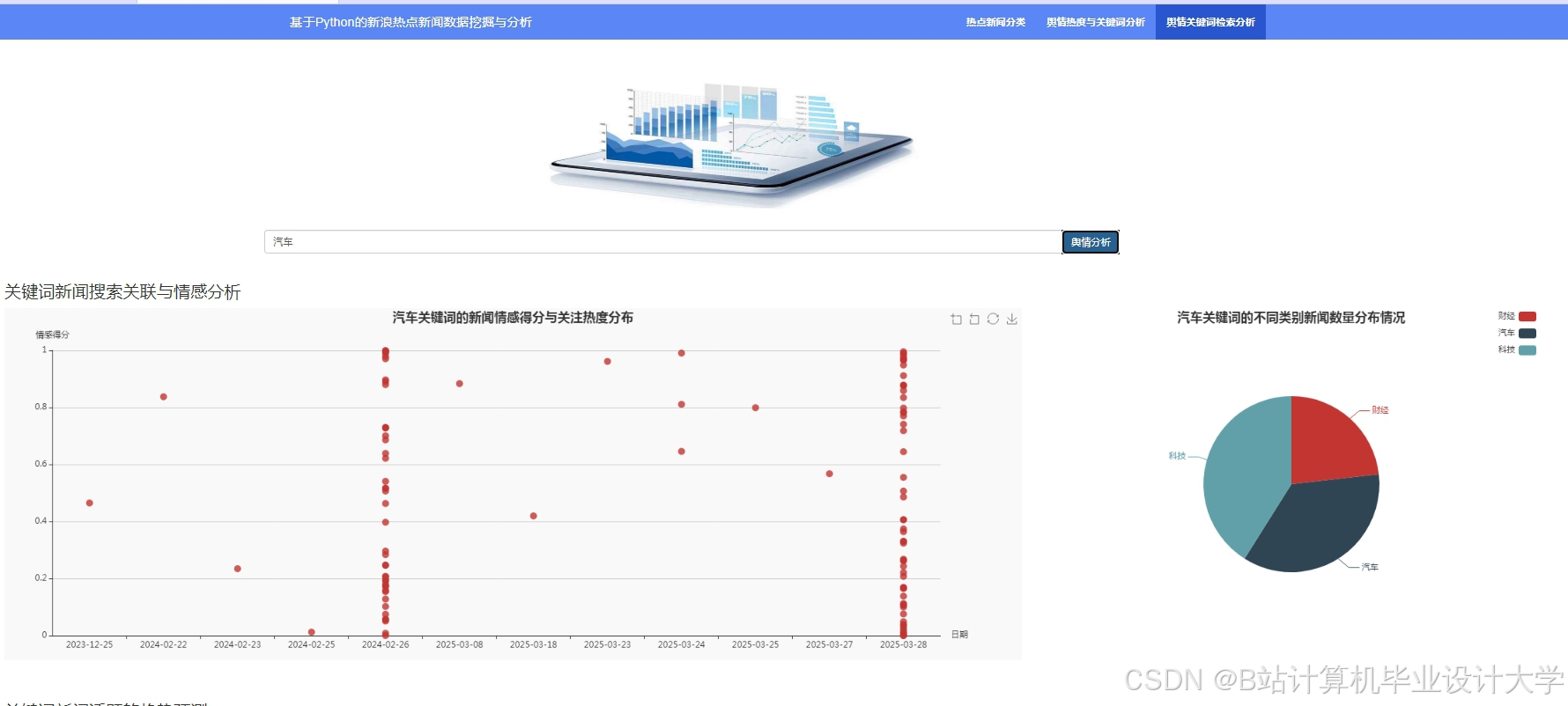

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

为什么选择我

博主是优快云毕设辅导博客第一人兼开派祖师爷、博主本身从事开发软件开发、有丰富的编程能力和水平、累积给上千名同学进行辅导、全网累积粉丝超过50W。是优快云特邀作者、博客专家、新星计划导师、Java领域优质创作者,博客之星、掘金/华为云/阿里云/InfoQ等平台优质作者、专注于Java技术领域和学生毕业项目实战,高校老师/讲师/同行前辈交流和合作。

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查↓↓↓↓↓↓获取联系方式↓↓↓↓↓↓↓↓

1136

1136

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?