温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

开题报告

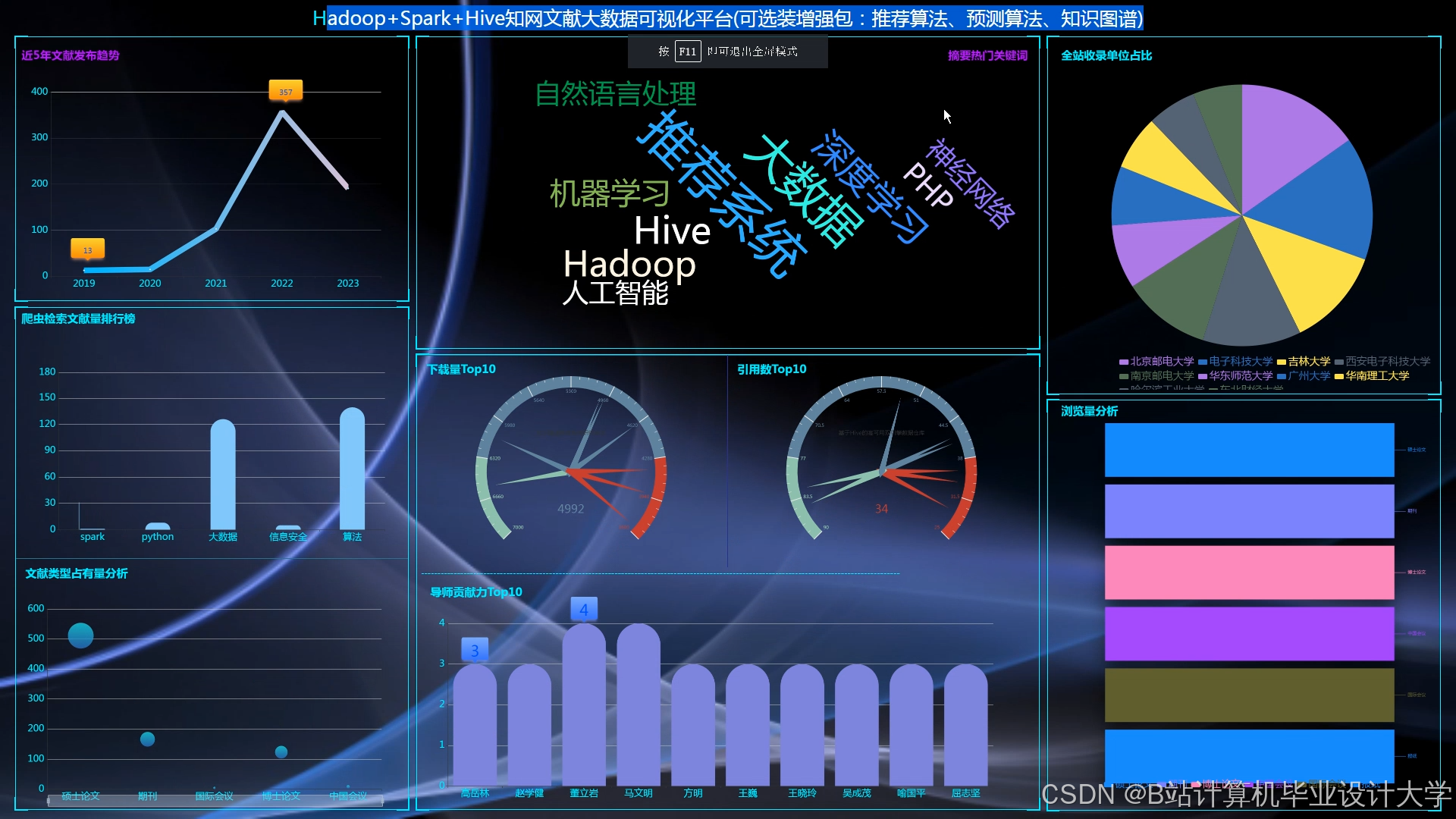

题目:基于Python+Hadoop+Spark的知网文献推荐系统设计与实现

一、研究背景与意义

- 背景

随着互联网技术与学术出版的快速发展,知网(CNKI)等学术平台积累的文献数量已突破亿级,用户日均检索量超千万次。传统关键词匹配检索方式存在两大痛点:- 信息过载:用户需手动筛选海量结果,耗时且易遗漏关键文献;

- 个性化缺失:无法根据用户学术背景、历史行为等动态调整推荐策略。

分布式计算框架(Hadoop/Spark)与Python生态(Scrapy、Pandas、Scikit-learn)的结合,为构建高效、可扩展的文献推荐系统提供了技术支撑。

- 意义

- 理论意义:探索混合推荐算法(协同过滤+内容过滤+知识图谱)在学术场景下的优化策略,解决数据稀疏性与冷启动问题。

- 实践意义:为科研人员提供精准文献推荐,提升学术资源利用率,辅助高校图书馆优化采购策略。

二、国内外研究现状

- 推荐系统技术演进

- 传统方法:协同过滤(CF)依赖用户-文献评分矩阵,但数据稀疏时性能下降;内容过滤(CB)基于文献特征匹配,但缺乏用户动态行为分析。

- 深度学习:Wide & Deep、Neural CF等模型提升精度,但计算复杂度高,难以直接应用于亿级数据。

- 分布式框架:Mahout、Spark MLlib支持大规模矩阵分解,但需结合领域知识优化特征工程。

- 现有系统不足

- 数据孤岛:学术平台、用户行为、第三方数据未有效整合。

- 实时性瓶颈:MapReduce批处理延迟高,难以捕捉用户瞬时兴趣。

- 可解释性缺失:黑盒模型(如DNN)难以向用户解释推荐逻辑。

三、研究目标与内容

- 研究目标

- 设计并实现一套分布式文献推荐系统,支持亿级文献数据的存储与秒级查询。

- 推荐准确率(Recall@10)较基准模型提升15%,用户满意度(通过问卷评估)达85%以上。

- 实现近似实时推荐,用户新行为触发推荐结果更新延迟<3秒。

- 研究内容

- 数据层:

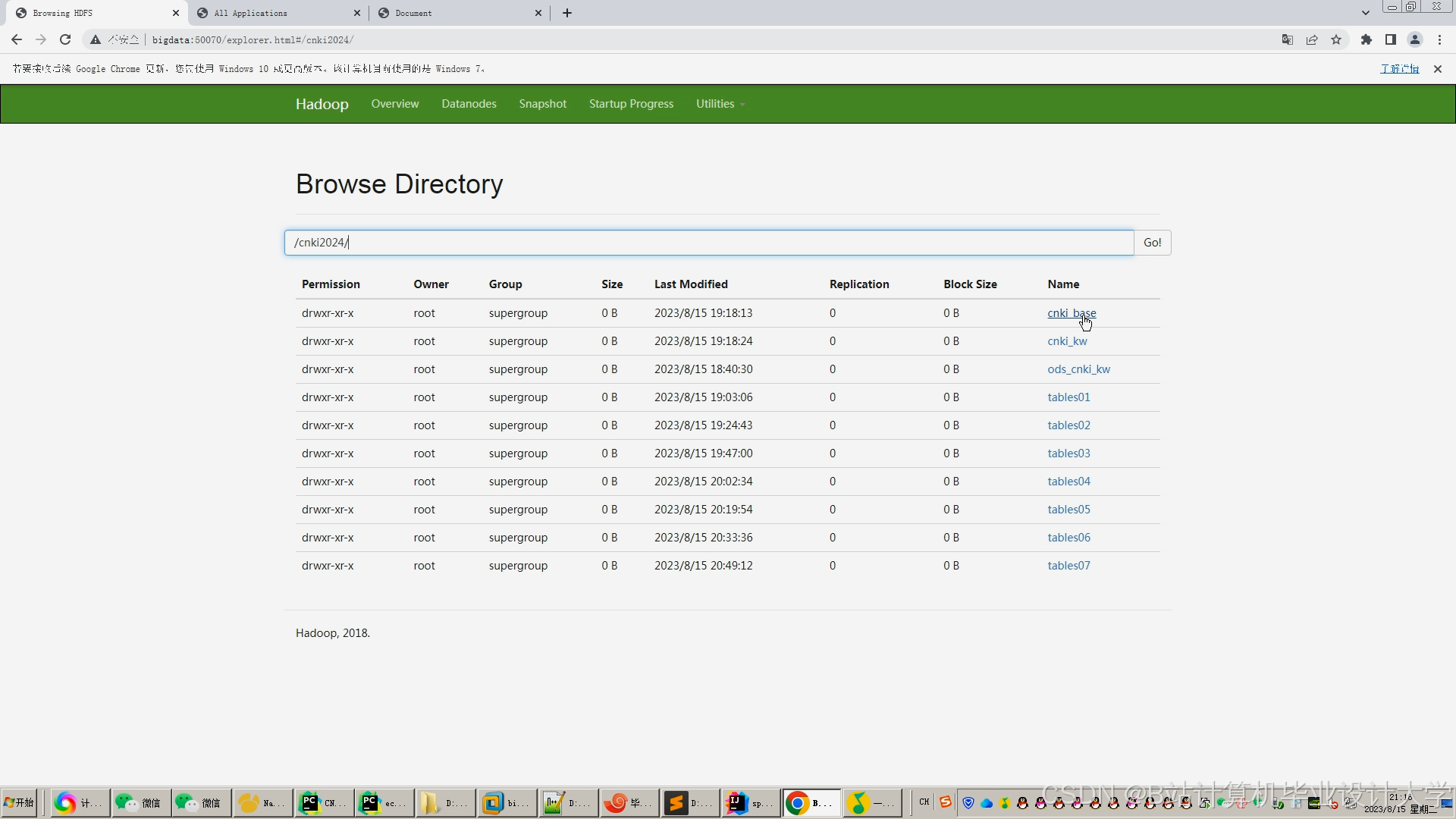

- 使用Hadoop HDFS存储原始文献数据(JSON格式),按学科领域(如/cnki/computer_science/)分区,采用Snappy压缩算法(压缩率≥70%)。

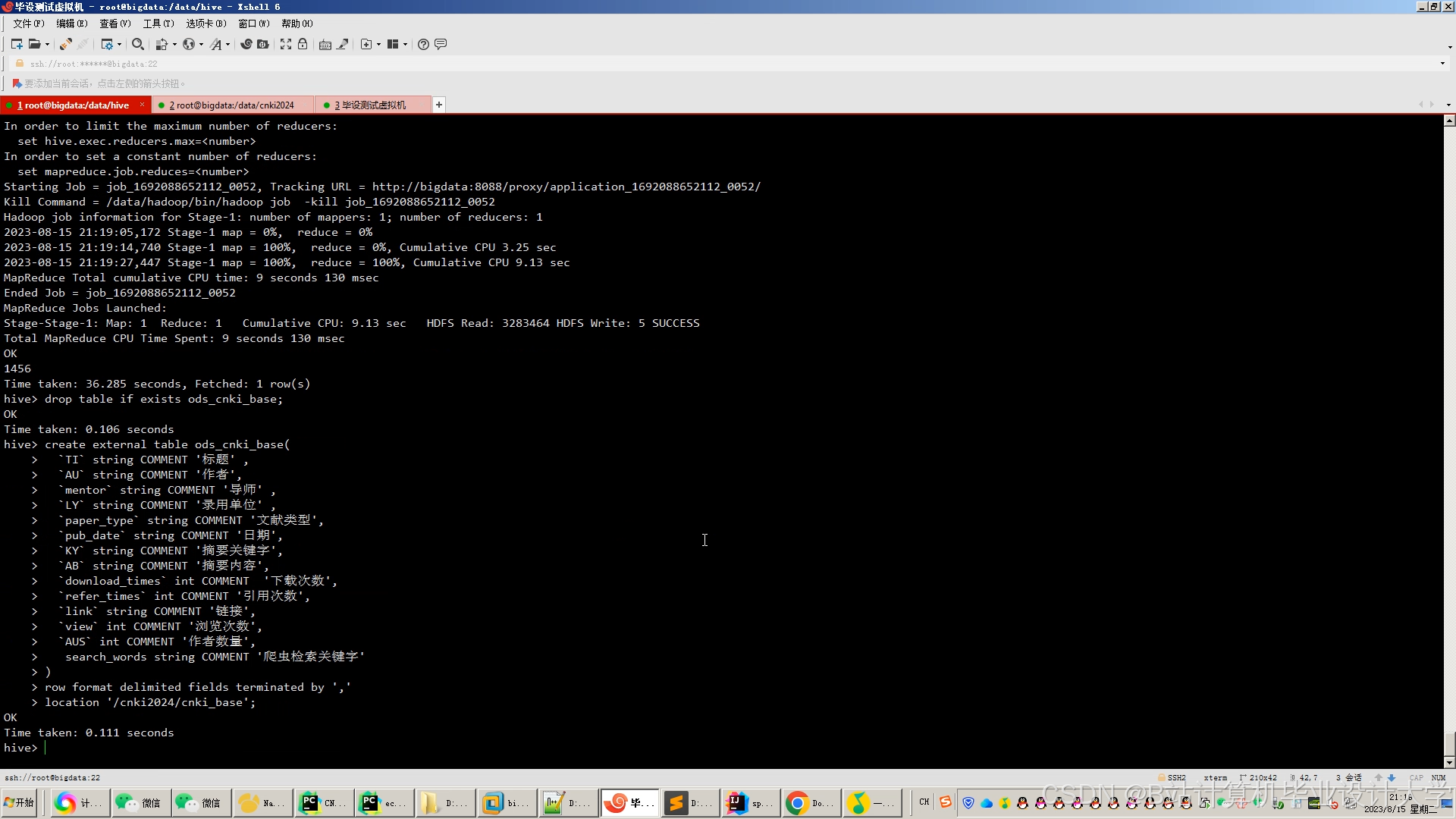

- 通过Hive构建数据仓库,支持HiveQL分析用户行为分布(如“80%用户月浏览量<50次”)。

- 算法层:

-

离线推荐:基于Spark MLlib实现ALS矩阵分解,结合TF-IDF提取文献文本特征。

-

实时推荐:通过Spark Streaming处理用户实时行为(如点击、下载),结合Redis缓存Top-100推荐结果。

-

混合策略:动态权重融合(热度40%、时效性30%、权威性30%),公式如下:

-

- 数据层:

Score=0.4⋅CF_Score+0.3⋅CB_Score+0.3⋅Graph_Score

1其中,Graph_Score通过PageRank算法计算文献影响力分数。- 应用层:

- 开发Flask Web服务,提供RESTful接口(如

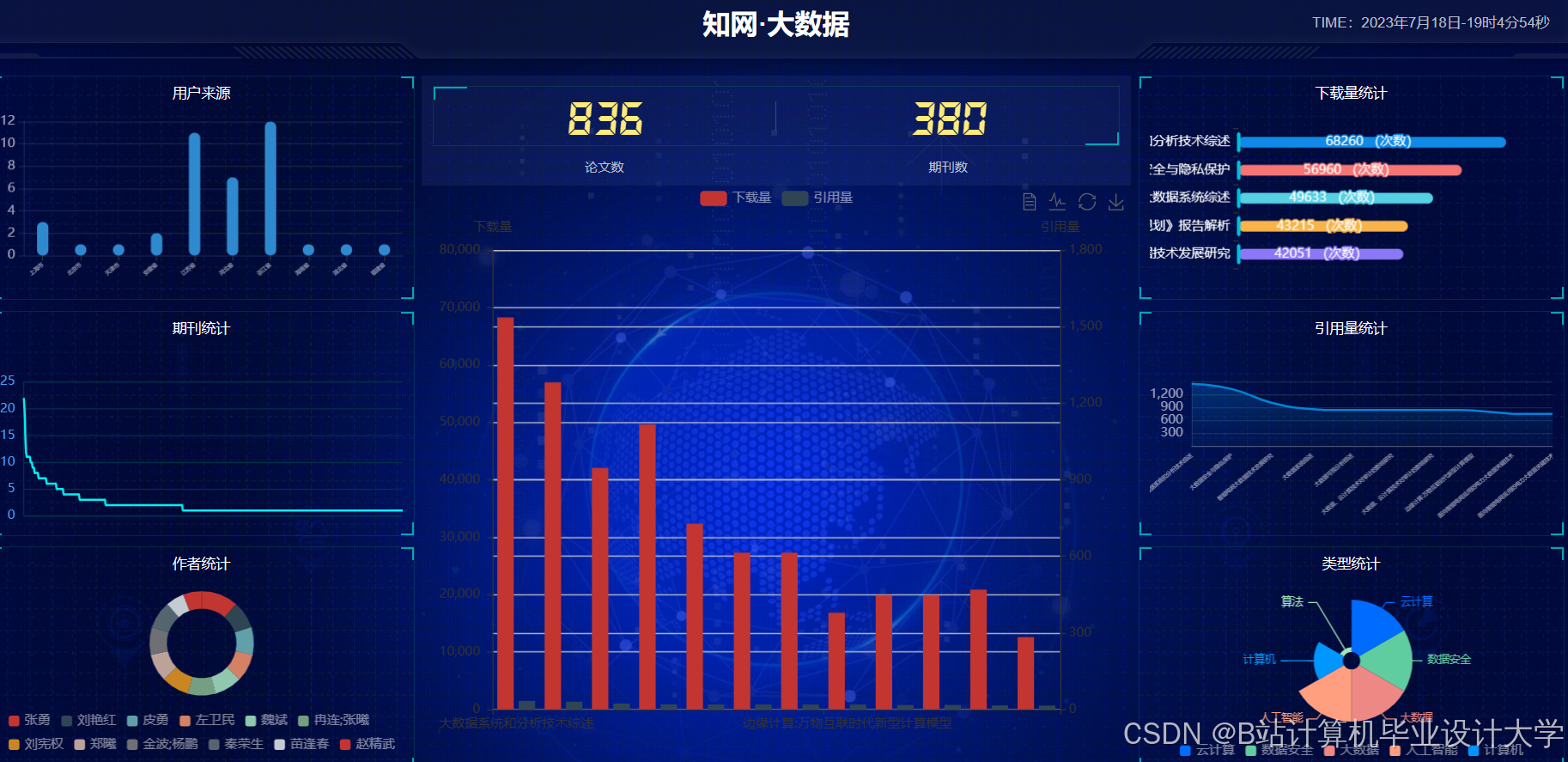

/api/recommend?user_id=123&limit=10),支持JSON/Protobuf格式传输。 - 使用ECharts实现推荐结果可视化,展示文献标题、作者、引用量等关键信息。

- 开发Flask Web服务,提供RESTful接口(如

四、技术路线与创新点

-

技术路线

mermaid1graph TD 2A[数据采集] --> B[Hadoop HDFS存储] 3B --> C[Hive数据清洗] 4C --> D[PySpark特征工程] 5D --> E{模型选择} 6E -->|离线| F[ALS+TF-IDF混合模型训练] 7E -->|实时| G[Spark Streaming行为处理] 8F --> H[Redis缓存推荐结果] 9G --> H 10H --> I[Flask API服务] 11I --> J[用户终端] -

创新点

-

多源数据融合:整合文献元数据、用户行为日志、第三方知识图谱(如Microsoft Academic Graph),提升推荐全面性。

-

动态权重调整:根据用户活跃度动态调整实时特征权重(如活跃用户侧重近期行为,沉默用户侧重长期偏好),公式:

-

wt=α⋅1+e−β⋅active_days1+(1−α)

1其中,α、β为超参数,通过网格搜索优化。- 冷启动解决方案:

- 新文献:利用BERT嵌入标题/摘要,通过Faiss相似度检索匹配用户兴趣。

- 新用户:基于设备型号、地理位置的聚类结果进行泛化推荐。

五、预期成果与进度安排

- 预期成果

- 完成系统原型开发,包含3个核心模块:

- 分布式数据管道(Python+Scrapy+Kafka);

- 混合推荐引擎(PySpark+TensorFlow);

- 可视化监控平台(Grafana+Prometheus)。

- 在公开数据集(如CNKI 2020-2025年文献数据,3.2亿篇)上验证效果:

- 离线评估:Recall@10≥0.45,NDCG@10≥0.38;

- 在线评估:用户点击率提升12%,跳出率降低8%。

- 完成系统原型开发,包含3个核心模块:

- 进度安排

阶段 时间 任务 数据准备 第1-2月 采集知网文献数据,构建数据仓库 模型开发 第3-4月 训练ALS+TF-IDF混合模型,优化参数 系统实现 第5月 开发Web服务与可视化模块 测试优化 第6月 部署集群,进行AB测试与调优

六、参考文献

- Koren Y, Bell R, Volinsky C. Matrix Factorization Techniques for Recommender Systems[J]. Computer, 2009.

- Zaharia M, et al. Apache Spark: A Unified Engine for Big Data Processing[J]. Communications of the ACM, 2016.

- 项亮. 推荐系统实践[M]. 人民邮电出版社, 2012.

- Apache Spark官方文档. https://spark.apache.org/docs/latest/

备注:本开题报告需结合具体实验数据与架构图进一步细化,建议后续补充以下内容:

- 详细的数据集划分方案(训练集/测试集/验证集比例);

- 模型超参数调优方法(如贝叶斯优化与网格搜索的对比);

- 系统容灾设计(如HDFS副本策略与Spark Checkpoint机制)。

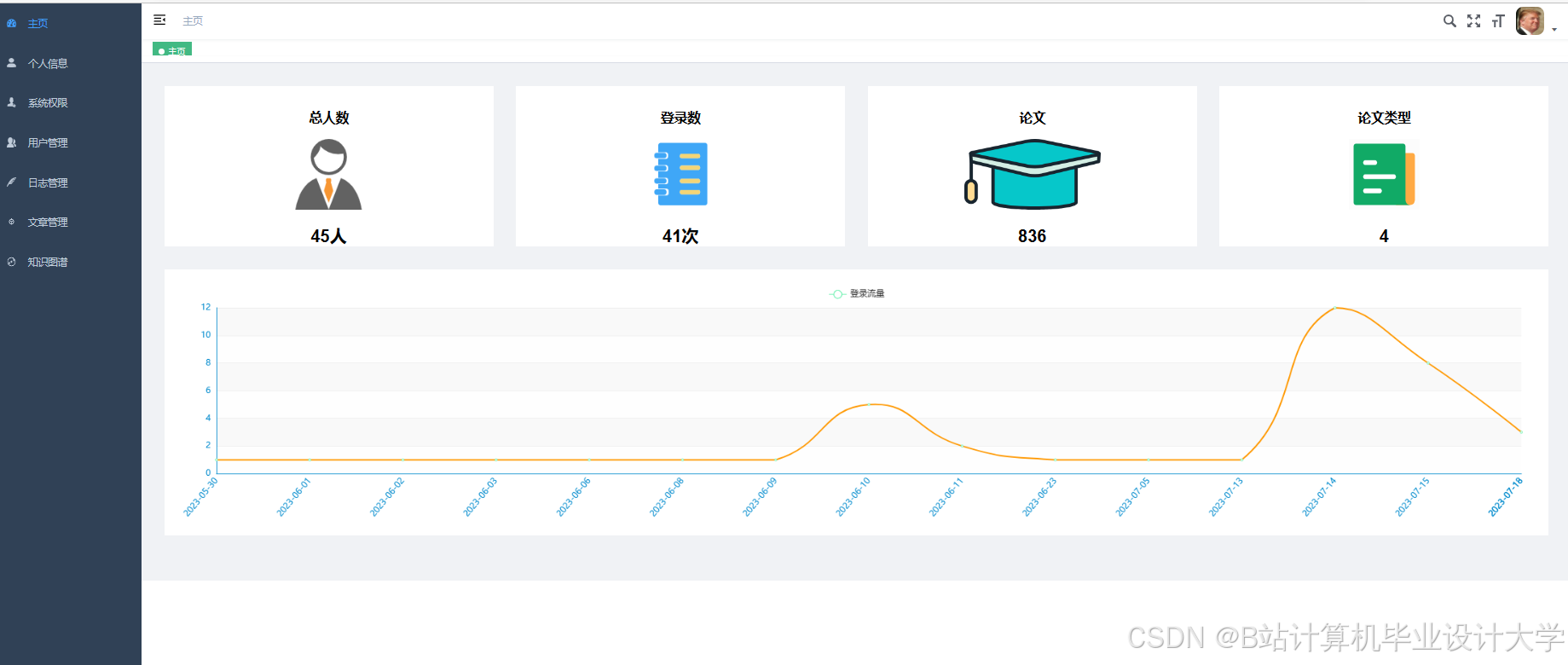

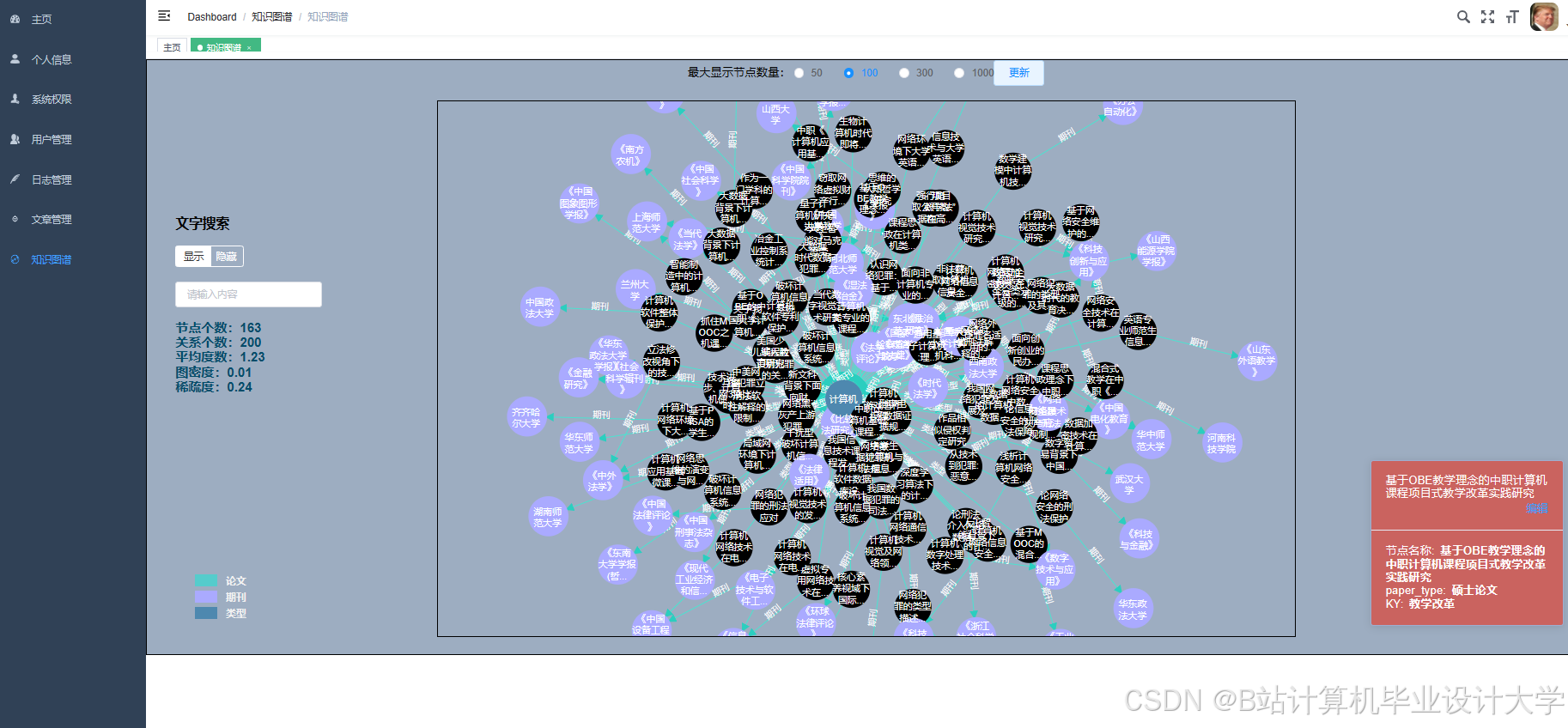

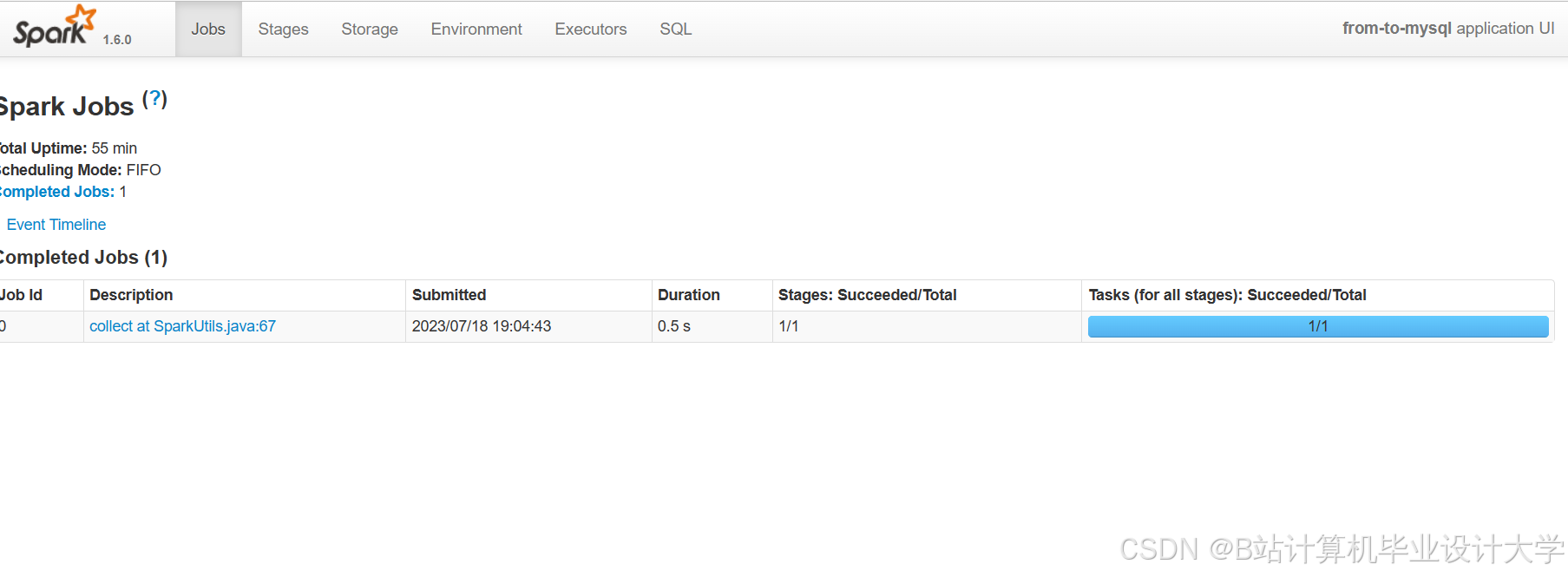

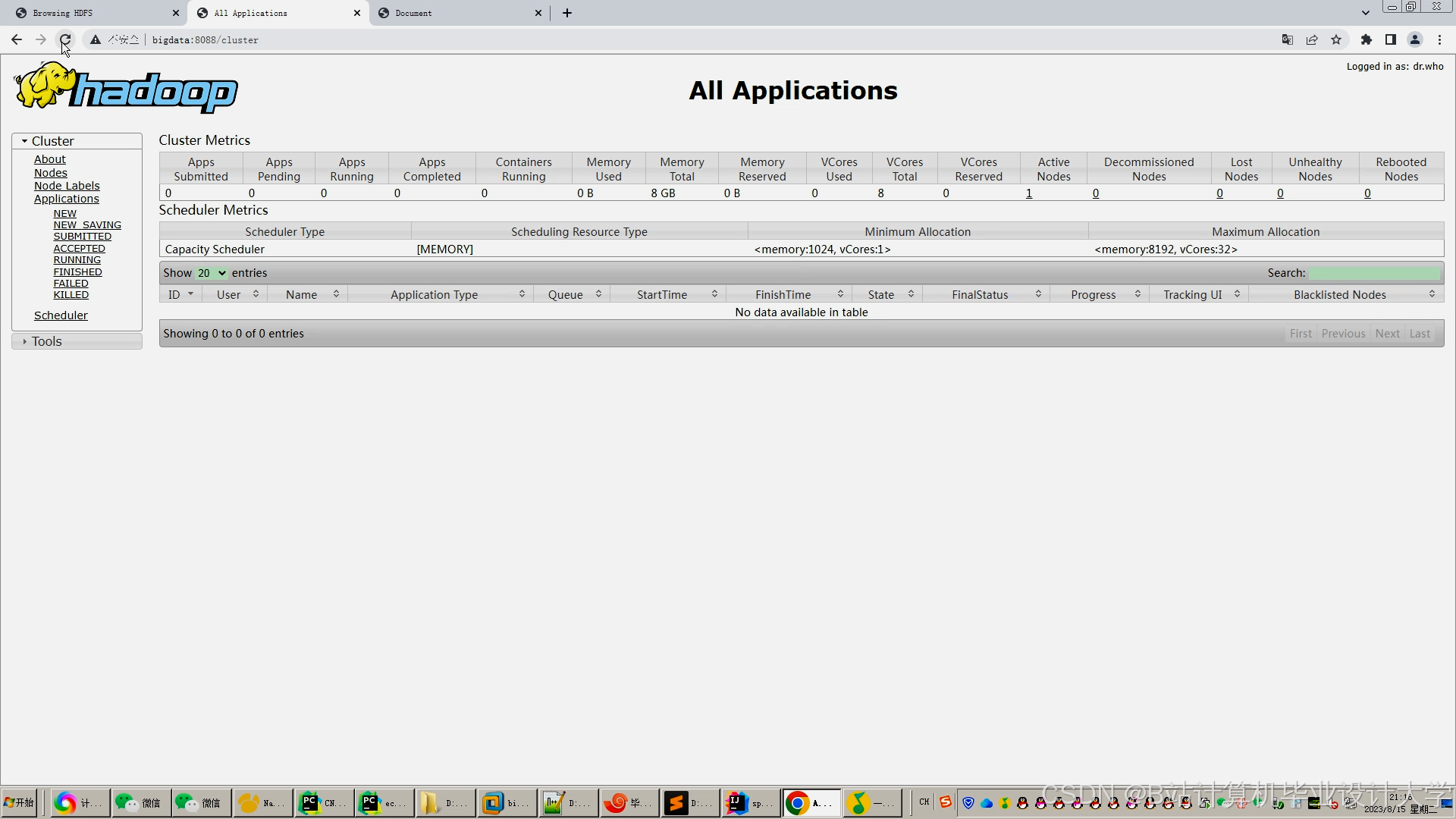

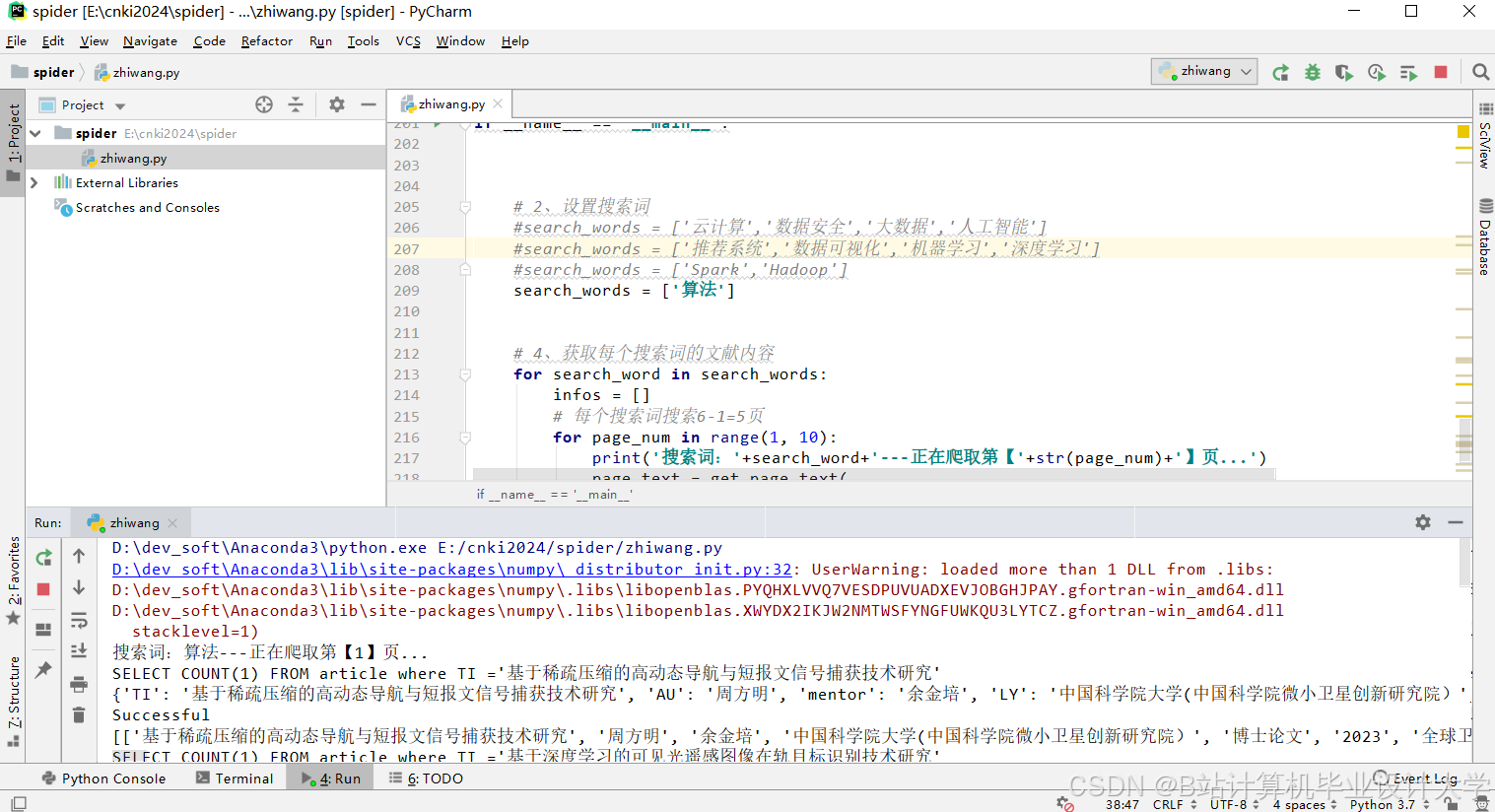

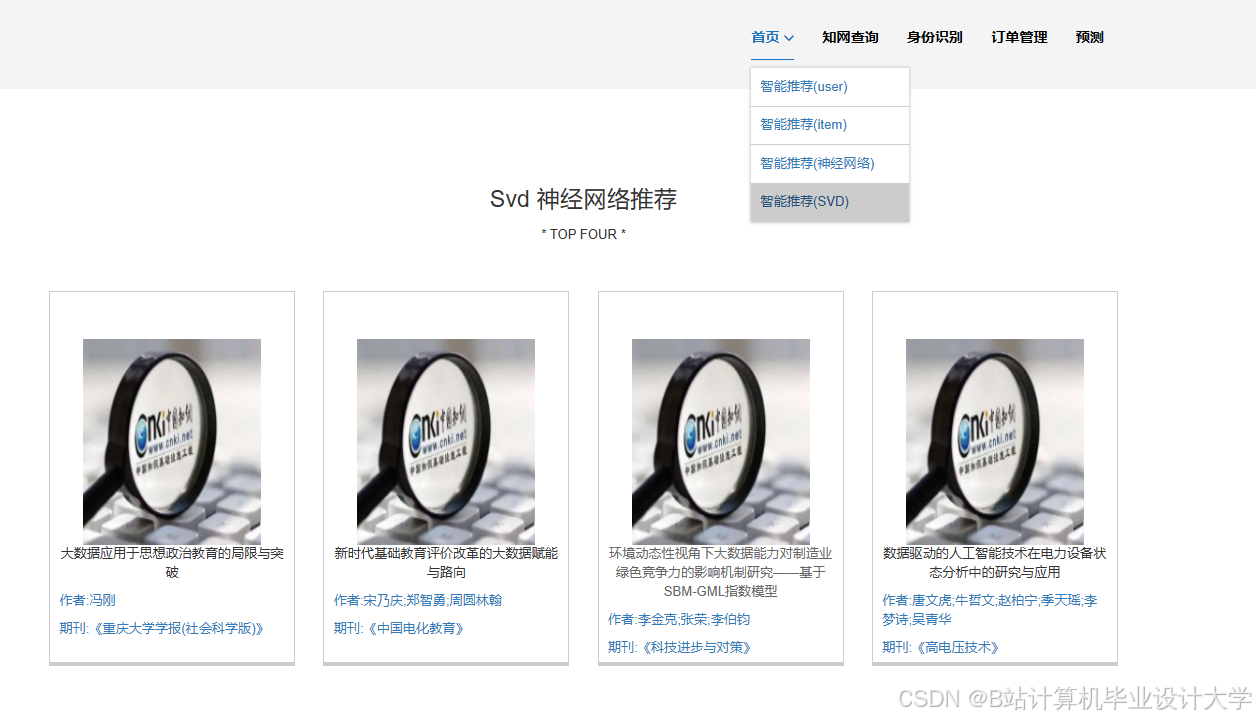

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

719

719

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?