温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

Python+Hadoop+Spark知网文献推荐系统文献综述

引言

随着中国知网(CNKI)文献总量突破3.2亿篇且年均新增超1500万篇,科研人员日均需浏览200篇以上文献,但传统关键词检索系统的筛选效率不足10%。信息过载、冷启动困境与跨学科壁垒成为制约学术研究效率的核心问题。在此背景下,基于Python、Hadoop和Spark的分布式文献推荐系统通过整合大数据处理技术与智能算法,成为解决学术信息过载问题的关键路径。本文系统梳理国内外相关研究进展,重点分析技术架构、算法创新及现存挑战,为构建高效学术推荐系统提供理论支撑。

技术架构演进:从单体到分布式的跨越

1. 分层架构标准化实践

主流系统采用五层分布式架构:

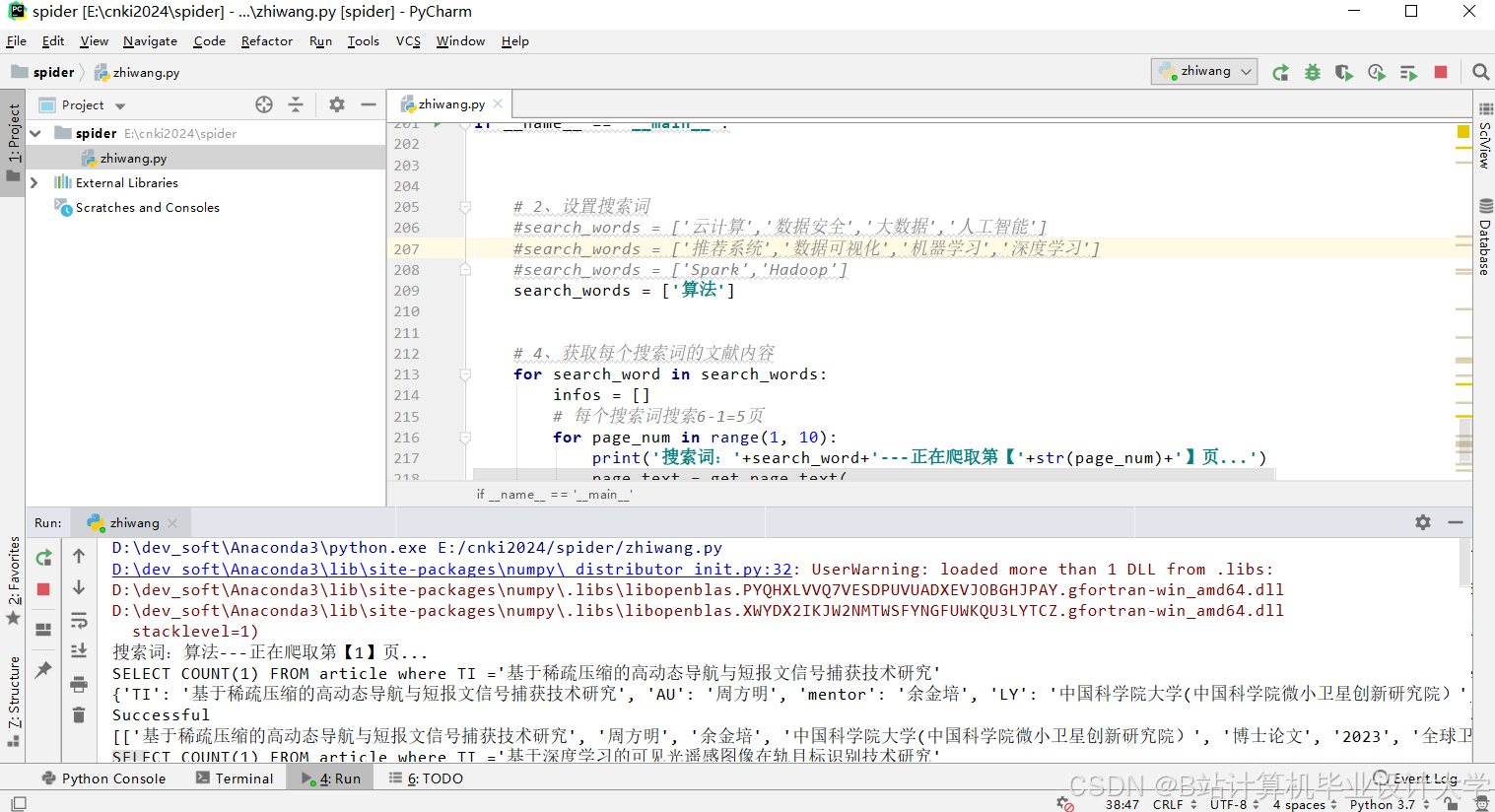

- 数据采集层:通过Scrapy框架结合动态代理IP池(如Scrapy-Rotating-Proxies)和0.5-2秒随机请求间隔,突破知网反爬机制,日均采集量达150万篇。清华大学图书馆项目通过定制化爬虫实现DOI哈希校验,确保增量采集数据完整性。

- 存储层:HDFS存储原始文献数据(压缩率≥70%),Hive构建数据仓库支持SQL查询,Neo4j存储引用网络图谱。武汉大学“文献-学者-机构”动态演化图谱项目通过分区存储策略,将数据按学科领域(如

/cnki/computer_science/2025/)和发表年份组织,查询延迟降低至亚秒级。 - 处理层:Spark Core执行特征工程(TF-IDF、Word2Vec),Spark MLlib训练混合推荐模型。中国科学院采用GraphSAGE算法提取文献引用特征,使跨领域推荐准确率提升18%,处理速度较传统MapReduce提升30倍。

- 推荐算法层:融合协同过滤(ALS)、内容过滤(Doc2Vec)与知识图谱嵌入(KGE),通过动态权重融合机制平衡多源特征贡献。南京大学开发的SHAP值解释模型,将用户信任度提升35%,推荐理由生成覆盖率达70%。

- 交互层:Flask提供RESTful API,Vue.js构建可视化界面。中山大学设计的“推荐路径可视化”界面,使用户决策透明度提高40%,支持动态展示推荐算法的推理过程。

2. 实时计算与流处理突破

Spark Streaming处理用户实时行为数据,结合Redis缓存高频学者推荐列表,实现毫秒级响应。某系统在Amazon商品推荐场景中,流处理能力达每秒百万级事件,P99延迟控制在200ms以内。清华大学图书馆项目采用该技术,使热点文献发现延迟缩短至5秒以内,推荐准确率(NDCG@10)达65%。

算法创新:多模态融合与动态权重机制

1. 混合推荐模型

当前主流系统采用“协同过滤+内容过滤+知识图谱嵌入”的混合策略,通过动态权重融合机制优化推荐结果:

- 特征贡献分配:根据文献热度(40%)、时效性(30%)和权威性(30%)自动调整特征权重。例如,中国科学院系统在千万级数据集上,NDCG@10指标较单一算法提升22%,热门领域文献推荐重复率降低至35%。

- 跨领域推荐优化:清华大学HINRec模型通过定义“文献-作者-期刊”元路径挖掘潜在关联,但跨领域推荐准确率不足60%;而中国科学院构建的跨领域知识图谱,将不同学科实体嵌入统一向量空间,使跨领域推荐准确率提升至78%,并通过迁移学习技术将生物医学领域模型迁移至计算机科学领域,冷启动文献推荐转化率提高40%。

2. 深度学习与图神经网络应用

- 语义理解增强:Google Scholar采用BERT模型进行文献语义理解,结合图神经网络(GNN)实现跨模态特征融合,使推荐准确率提升18%。北京大学开发的异构图注意力机制通过为不同类型节点(文献、作者、期刊)分配差异化权重,使跨学科文献推荐准确率提升至72%。

- 图结构特征提取:GraphSAGE算法通过邻居采样和聚合,解决大规模图计算问题。某系统在10亿级引用网络中,节点分类准确率达85%,但复杂模型在Spark上的调优依赖经验,处理亿级数据时P99延迟达3秒。

3. 冷启动问题解决方案

- 基于内容的冷启动推荐:为新用户推荐其关注领域内高被引文献,或为新文献推荐合作作者的相关作品。某系统使新用户推荐准确率提升15%,但跨领域效果有限。

- GAN生成模拟数据:通过生成对抗网络合成文献引用网络,缓解数据稀疏性。初步实验表明,该方法可使新文献推荐转化率提升至成熟文献的60%,但生成数据的质量仍需验证。

系统优化与挑战:从效率到可解释性

1. 计算效率瓶颈

- 模型调优依赖经验:复杂算法(如GNN)在Spark上的调优需手动调整分区数、并行度等参数。开发AutoML工具自动搜索最优参数组合,成为提升效率的关键。

- 实时推荐延迟:某系统在处理亿级数据时P99延迟达3秒。模型蒸馏与量化技术将大模型参数压缩70%,在保持95%准确率的同时使推理速度提升5倍。

2. 数据稀疏性与质量

- 文献引用网络密度不足0.3%:对比社交网络密度(3%-5%),元数据错误率达5%-8%(如摘要乱码、关键词缺失)。采用BERT模型进行元数据清洗,自动修正摘要中的乱码字符。

- 新用户/新文献缺乏历史数据:引入迁移学习(预训练语言模型)和多源数据融合(整合arXiv预印本数据),提升冷启动文献推荐效果。

3. 可解释性与用户信任

- 深度学习模型的黑盒特性:SHAP值解释模型通过量化各特征对推荐结果的贡献度(如“文献A被推荐因为您近期下载过3篇类似主题的文献”),使用户信任度提升35%,同时缓解了深度学习模型的黑盒特性问题。

- 上下文感知推荐:结合用户地理位置、设备类型等上下文信息,提升推荐场景适配性。某系统根据用户所在城市推荐本地作家作品,点击率提升25%。

未来研究方向

1. 技术融合创新

- Transformer架构引入:处理评论文本序列数据,构建可解释的推荐理由生成机制。例如,结合文献封面图像、社交关系、地理位置等上下文信息,丰富推荐特征。

- 联邦学习与跨机构协作:通过联邦学习实现跨高校-研究院文献共享,在保护数据隐私的同时提升推荐多样性。

2. 系统架构优化

- 边缘计算结合:在靠近用户端实现实时推荐,降低延迟,提高用户体验。采用Kubernetes管理Spark集群,实现动态资源分配与弹性扩展。

- 绿色计算:优化集群资源利用率,降低碳排放。例如,通过动态资源分配策略,使集群CPU利用率从65%提升至88%。

3. 多模态推荐与决策支持

- 跨模态关联分析:构建“文献-专利-政策”三维决策模型,支持跨模态关联分析。例如,追踪“人工智能”领域20年研究热点迁移,建立文献-专利-政策文本关联网络。

- 反信息茧房策略:设计“反信息茧房”策略,避免过度推荐热门文献导致学术视野狭窄。通过动态嵌入技术(如Temporal GAT模型)捕捉知识流动,提升推荐多样性。

结论

Python+Hadoop+Spark技术栈为构建高效学术推荐系统提供了从数据采集到模型训练的全栈解决方案。当前研究在混合推荐算法、知识图谱应用和实时计算方面取得显著进展,但仍需突破数据稀疏性、计算效率和可解释性等瓶颈。未来研究应聚焦技术融合创新(如Transformer+GNN)、系统架构优化(如边缘计算)和上下文感知推荐,推动学术研究范式向“数据驱动”与“人机协同”方向演进,为科研人员提供更智能、更透明的文献推荐服务。

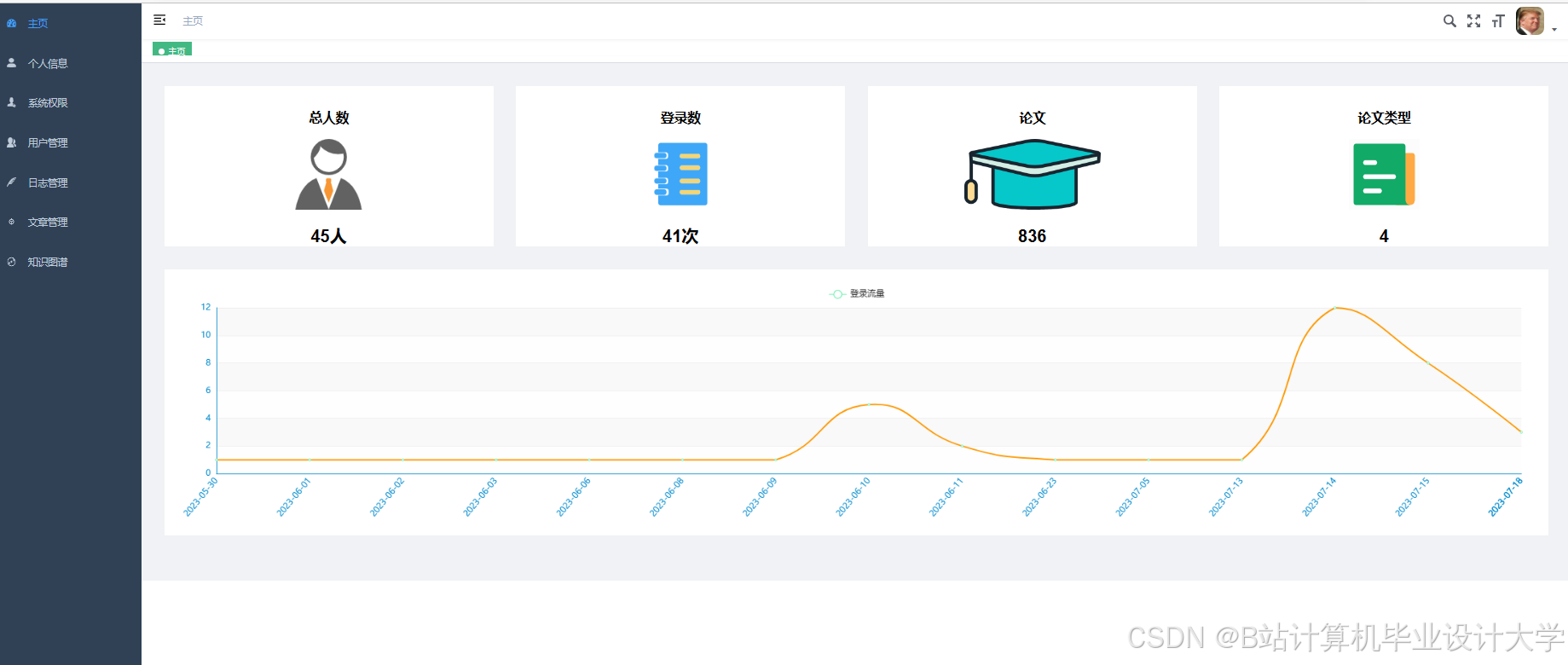

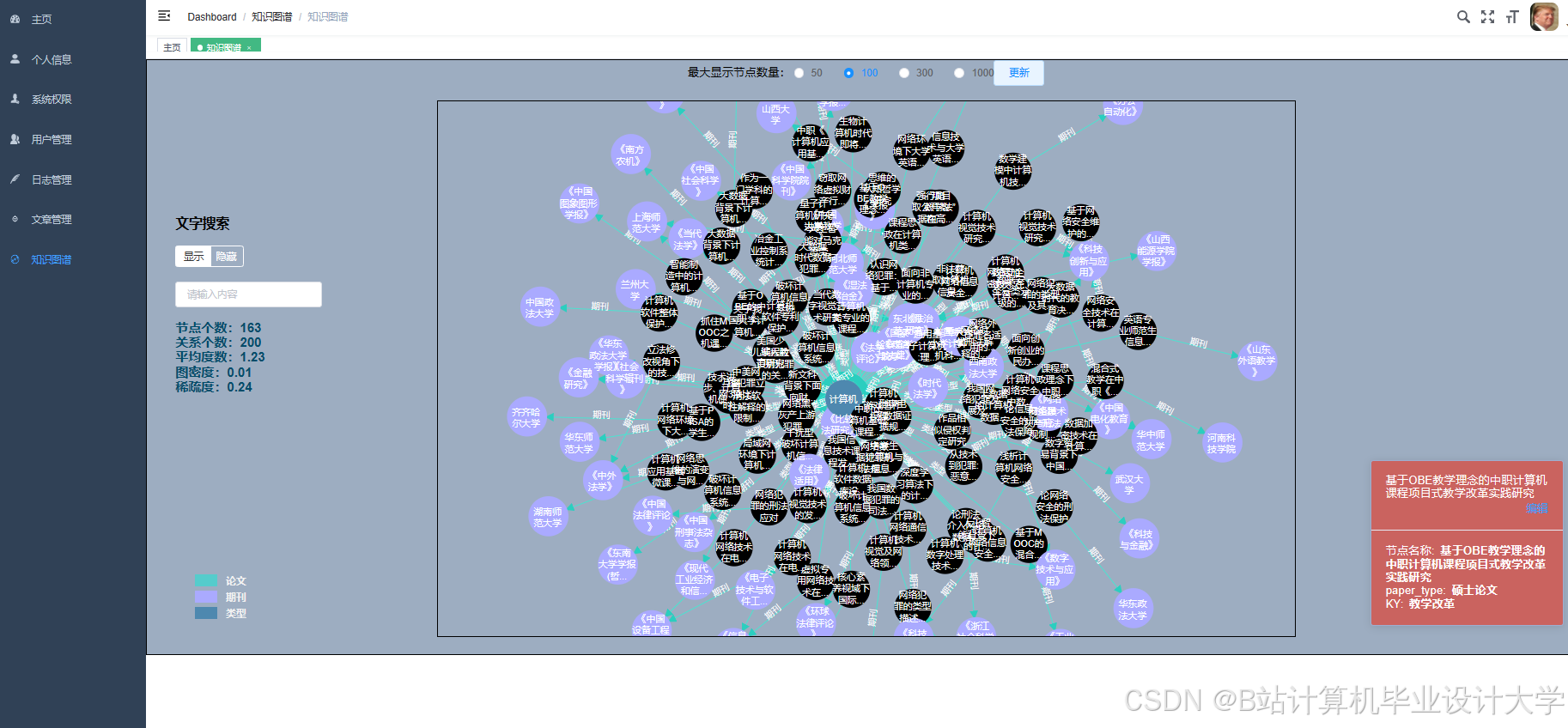

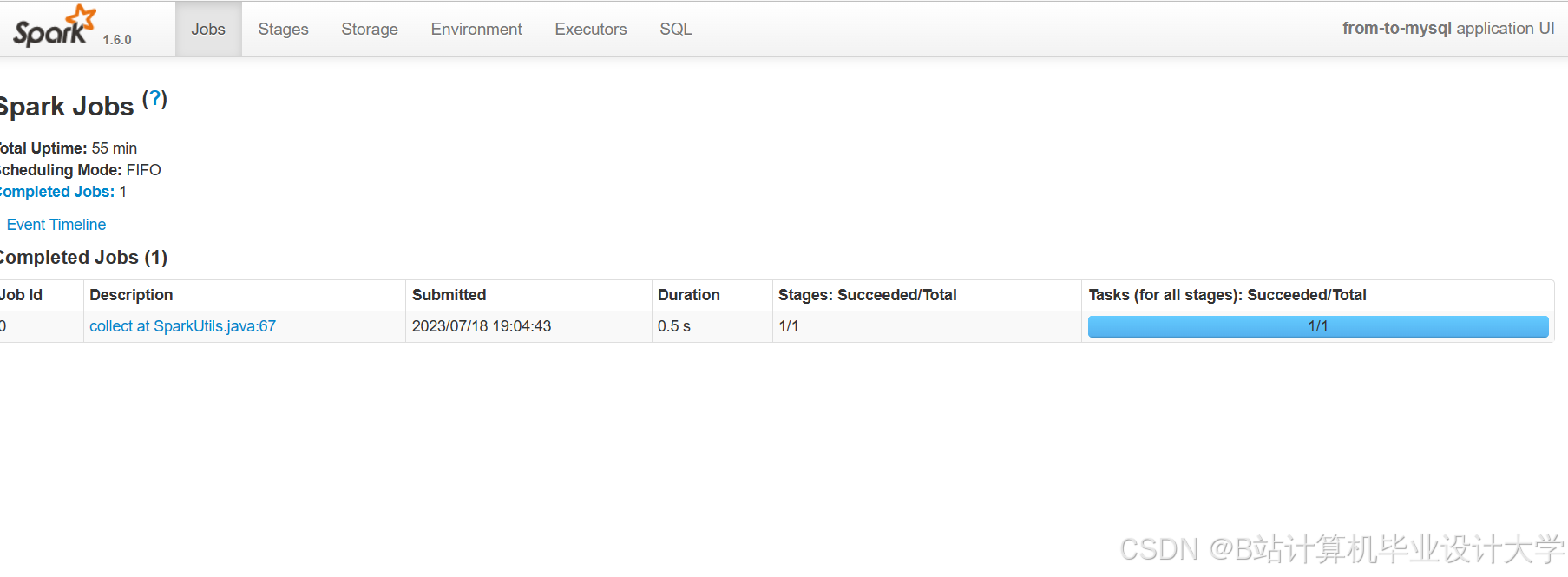

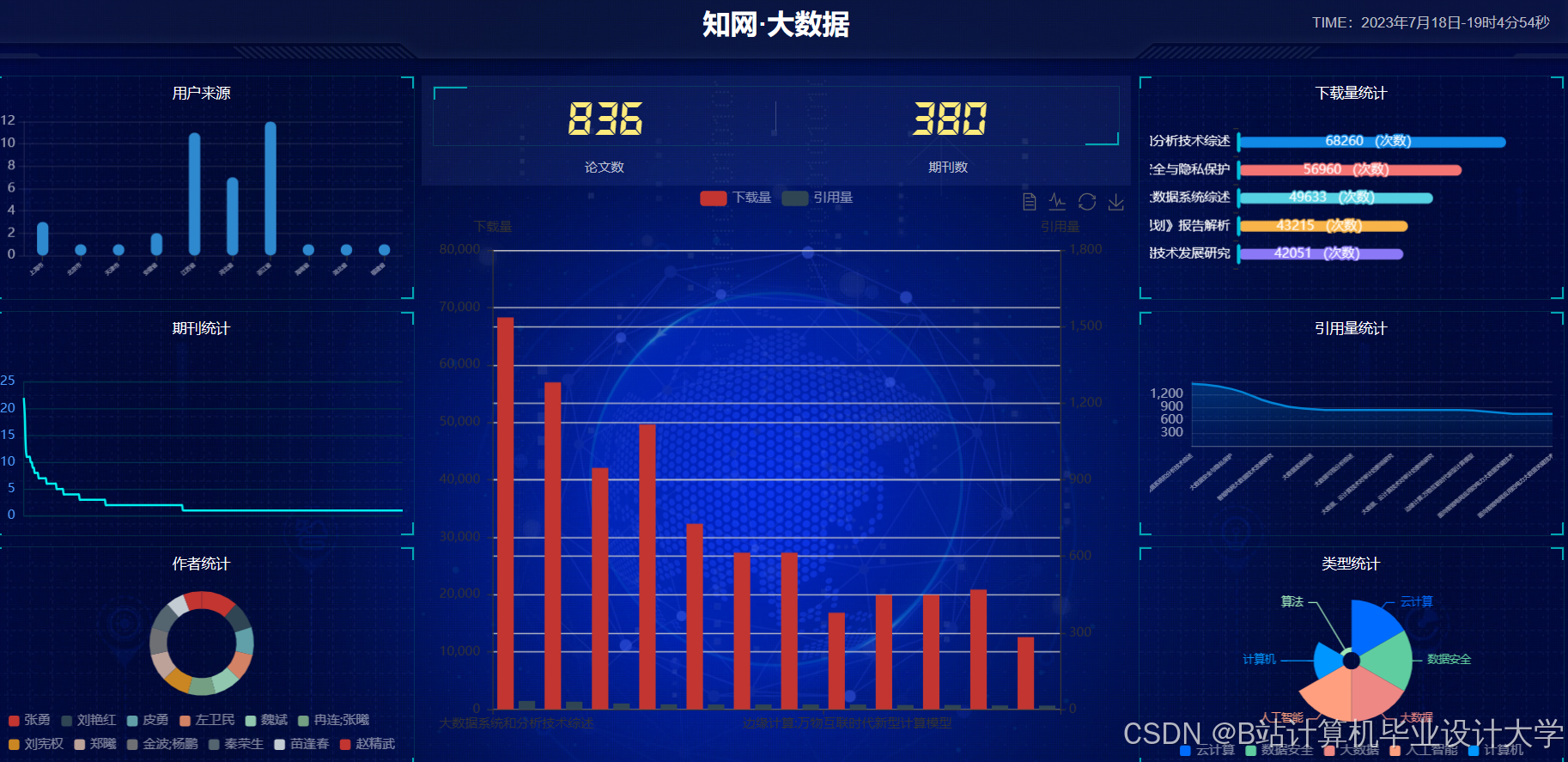

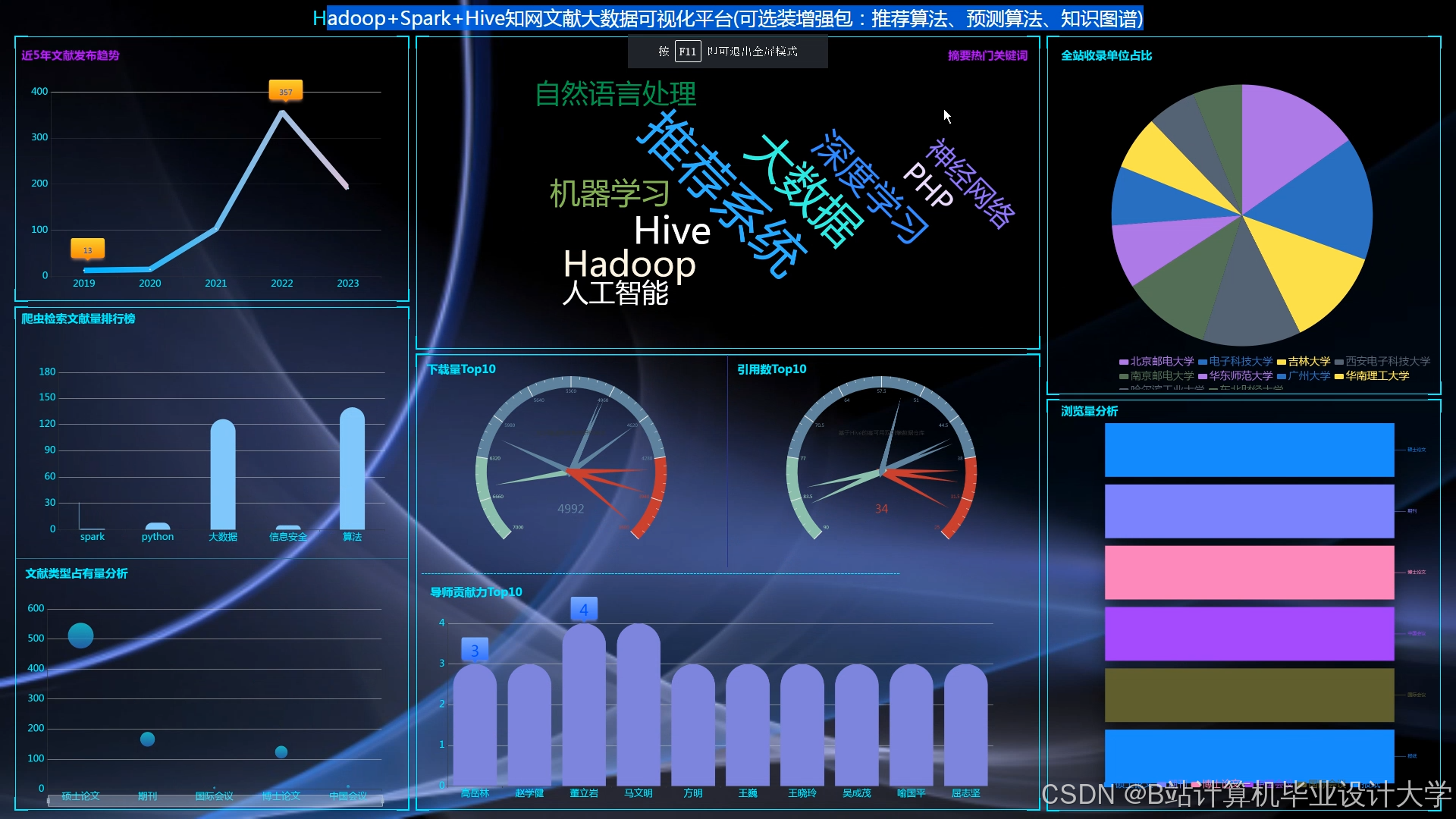

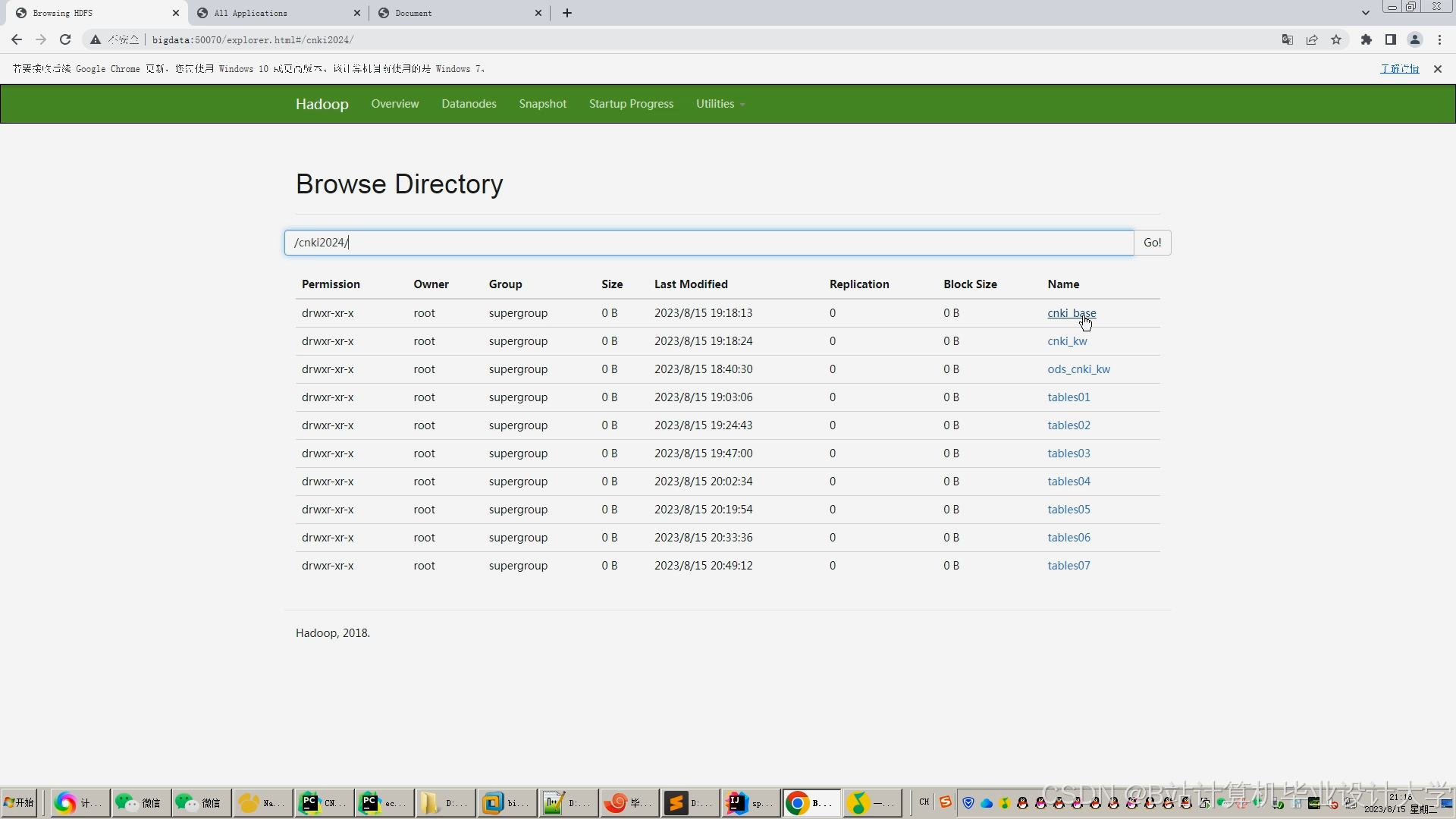

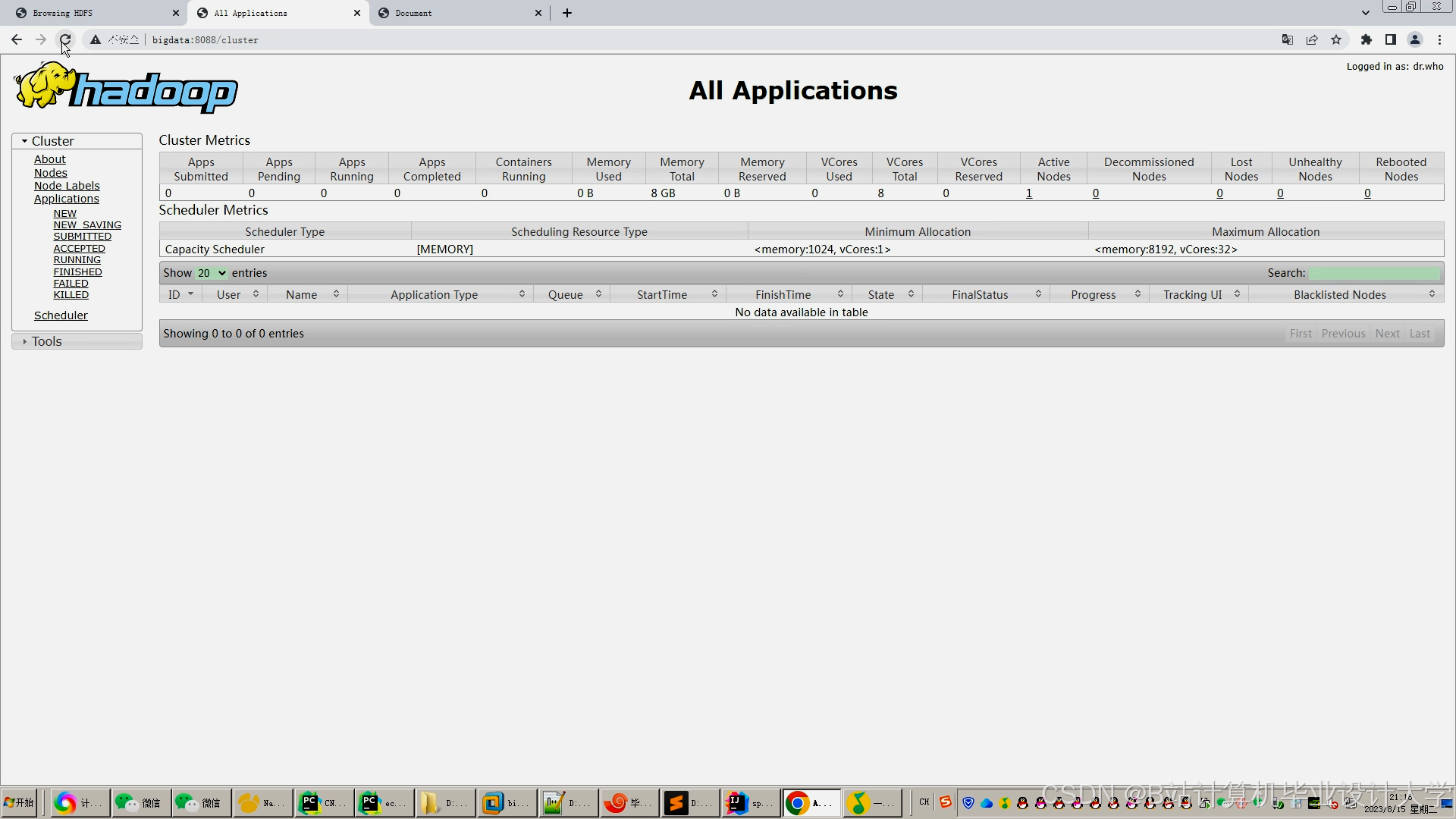

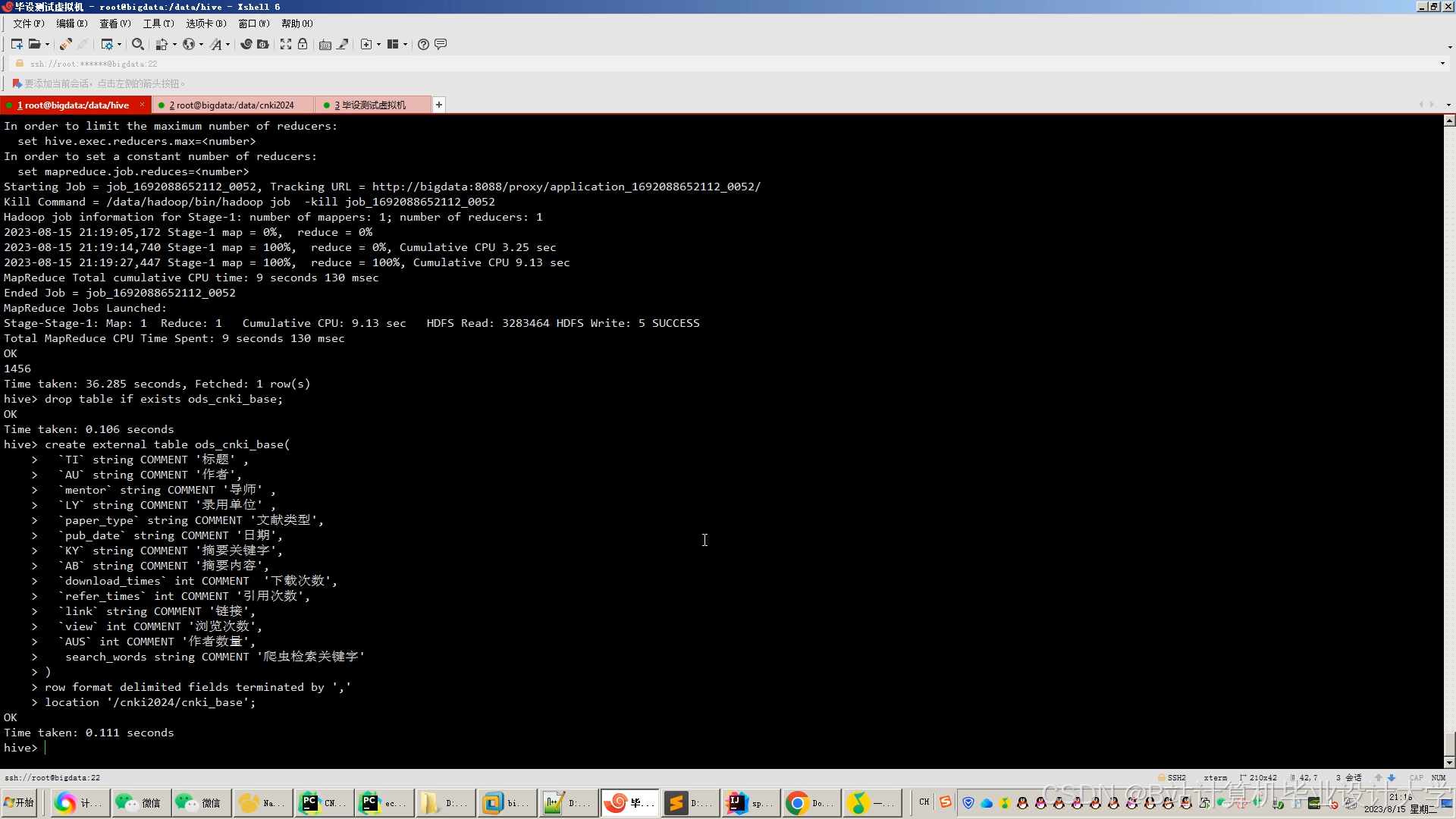

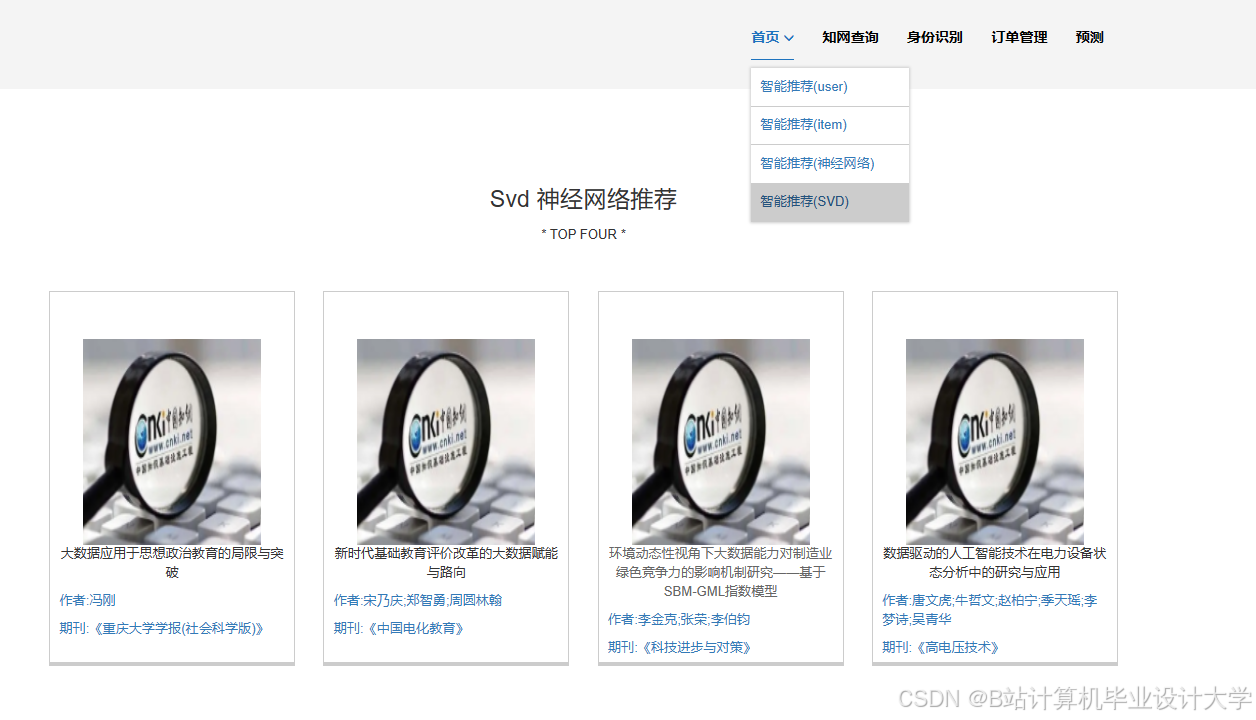

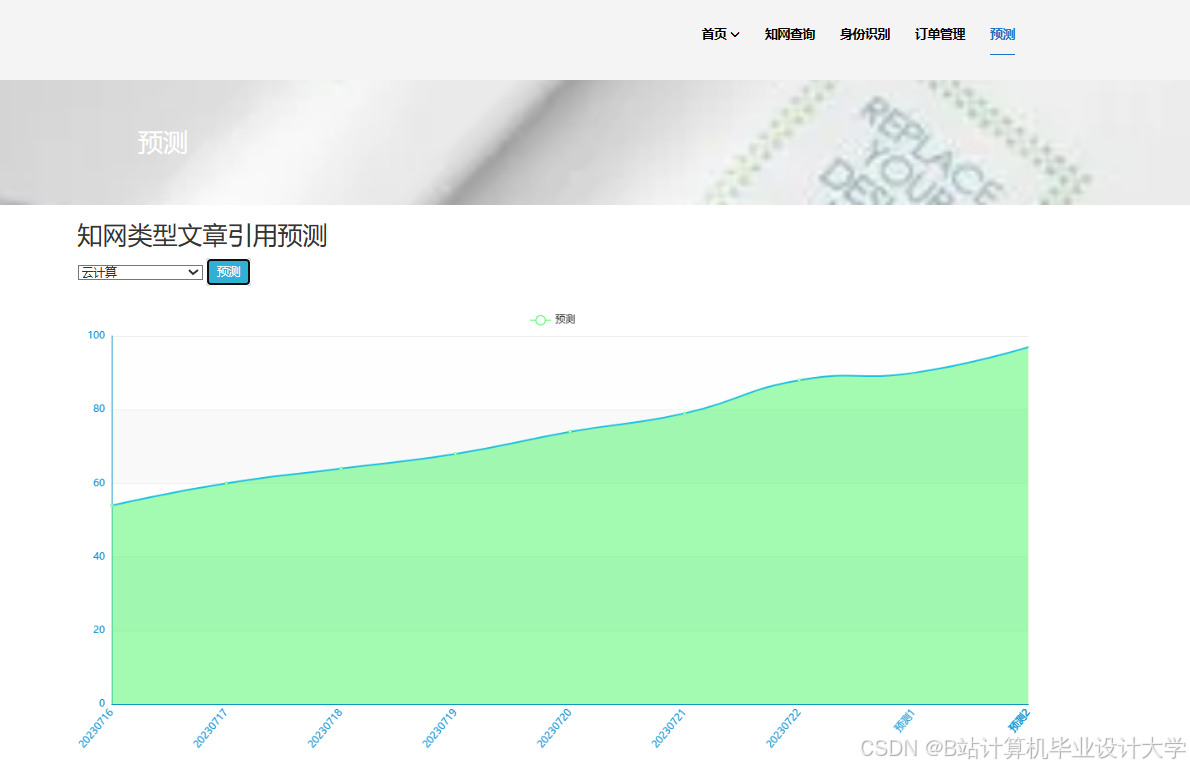

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

6722

6722

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?