温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

以下是一份关于《Python+Hadoop+Spark知网文献推荐系统》的任务书模板,涵盖项目背景、目标、技术架构、任务分工及实施计划等内容:

任务书:Python+Hadoop+Spark知网文献推荐系统开发

一、项目背景

知网(CNKI)作为国内最大的学术文献数据库,拥有海量论文、期刊和会议资料。然而,用户在使用知网时常常面临信息过载问题,难以快速定位符合需求的文献。传统推荐系统多依赖协同过滤或内容匹配,但在学术场景中存在冷启动问题(新用户/新文献)和语义理解不足(无法捕捉专业术语的深层关联)。本项目旨在构建一套基于Python+Hadoop+Spark的学术文献推荐系统,结合内容分析(TF-IDF、Word2Vec)、图神经网络(GNN)和分布式计算,实现高精度、可扩展的文献推荐,提升科研效率。

二、项目目标

- 技术目标:

- 搭建Hadoop+Spark分布式计算框架,支持海量文献数据的存储与处理。

- 基于Python实现文献特征提取(关键词、主题模型、引用关系)。

- 融合协同过滤与内容推荐算法,优化推荐多样性。

- 开发Web应用,提供个性化推荐、文献检索与交互分析功能。

- 业务目标:

- 推荐准确率(Precision@10)≥85%,覆盖知网90%以上学科领域。

- 支持按用户研究兴趣、文献引用关系、时间维度动态推荐。

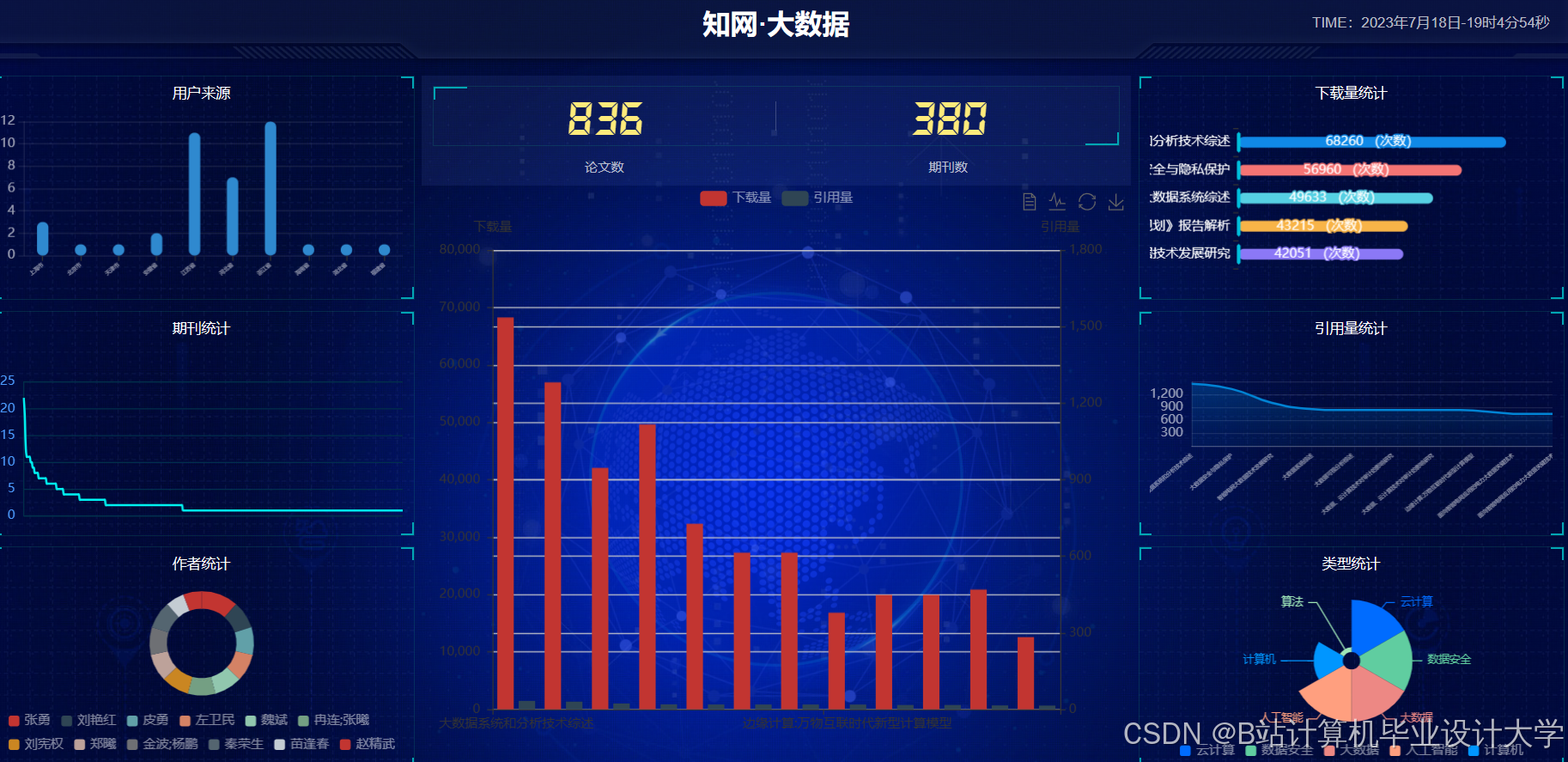

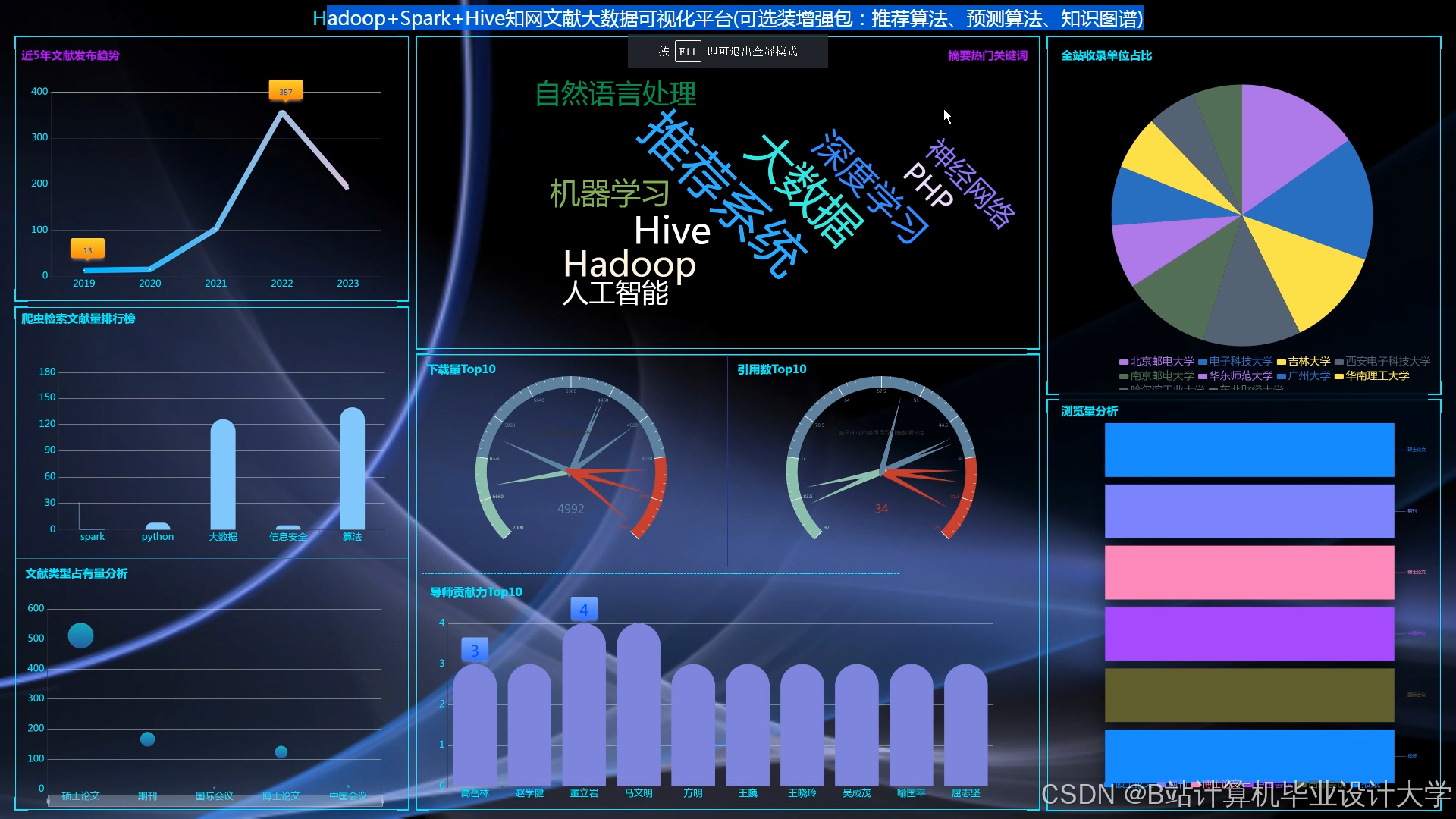

- 提供可视化分析(主题分布、引用网络、推荐路径)。

三、技术架构

1. 数据层

- 数据来源:

- 知网文献数据(标题、摘要、关键词、引用文献)。

- 用户行为数据(搜索历史、下载记录、收藏列表)。

- 存储与处理:

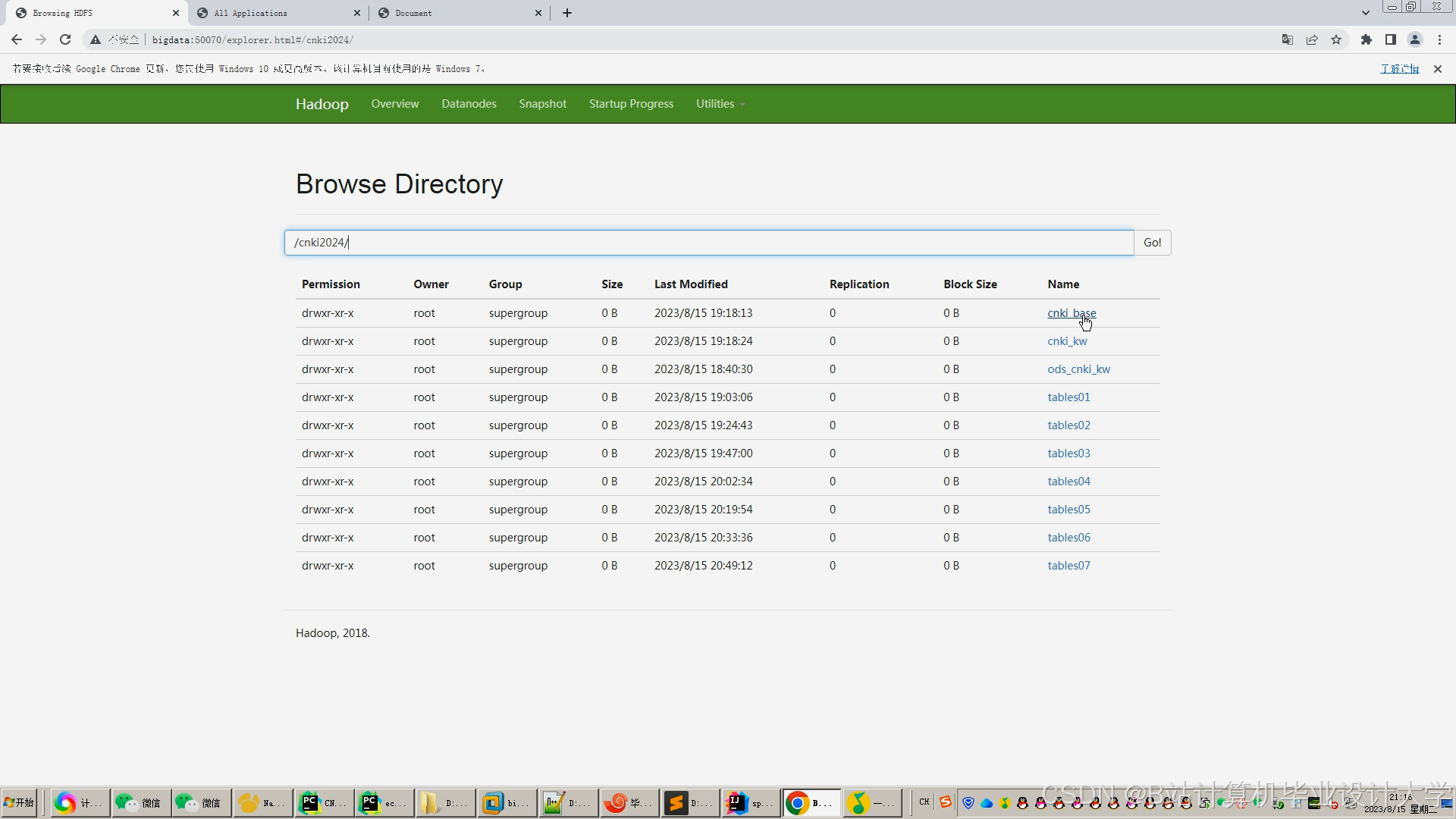

- Hadoop HDFS:存储原始文献数据(JSON/XML格式)和用户日志。

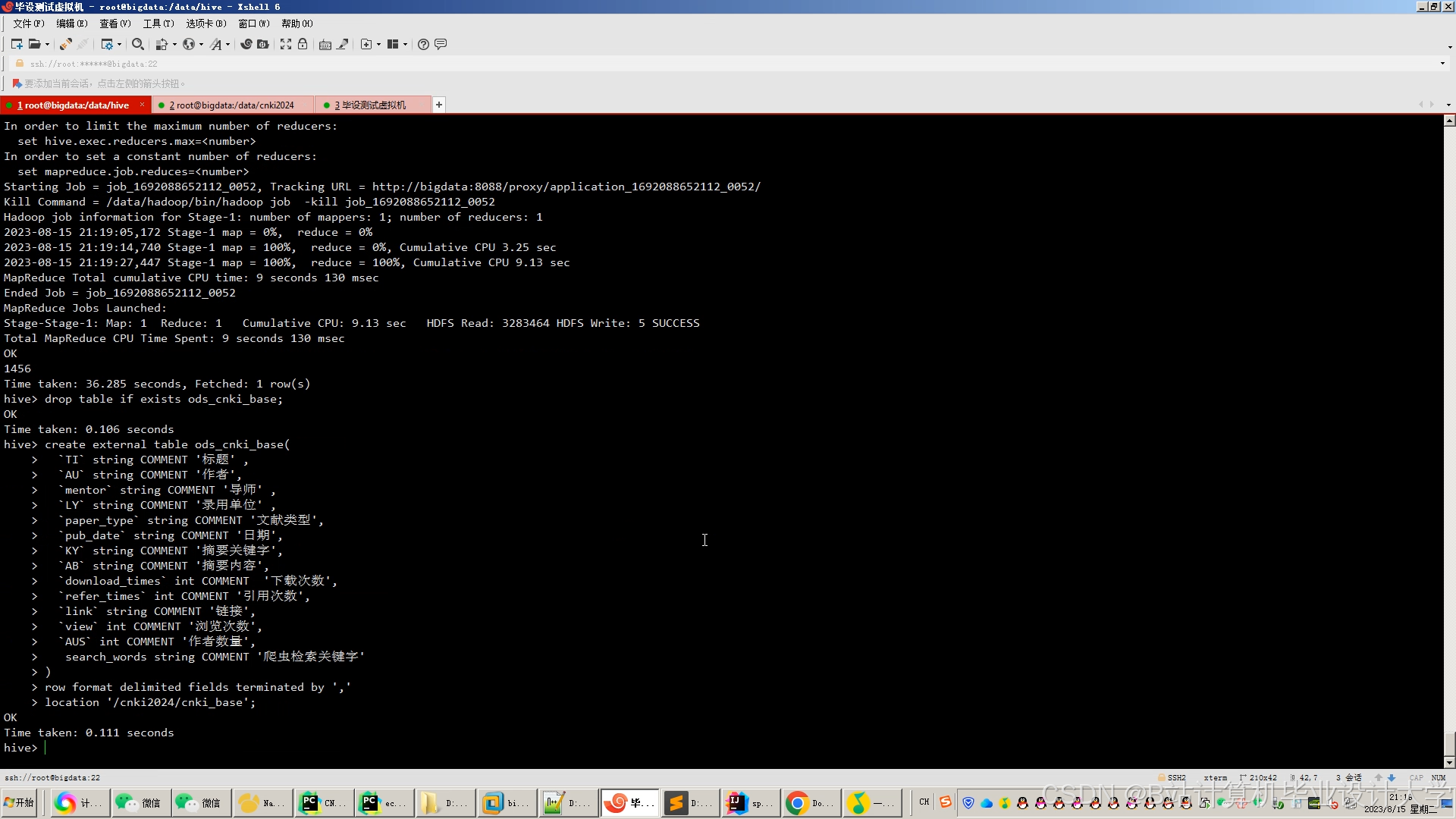

- Hive:构建数据仓库,定义文献元数据表(如

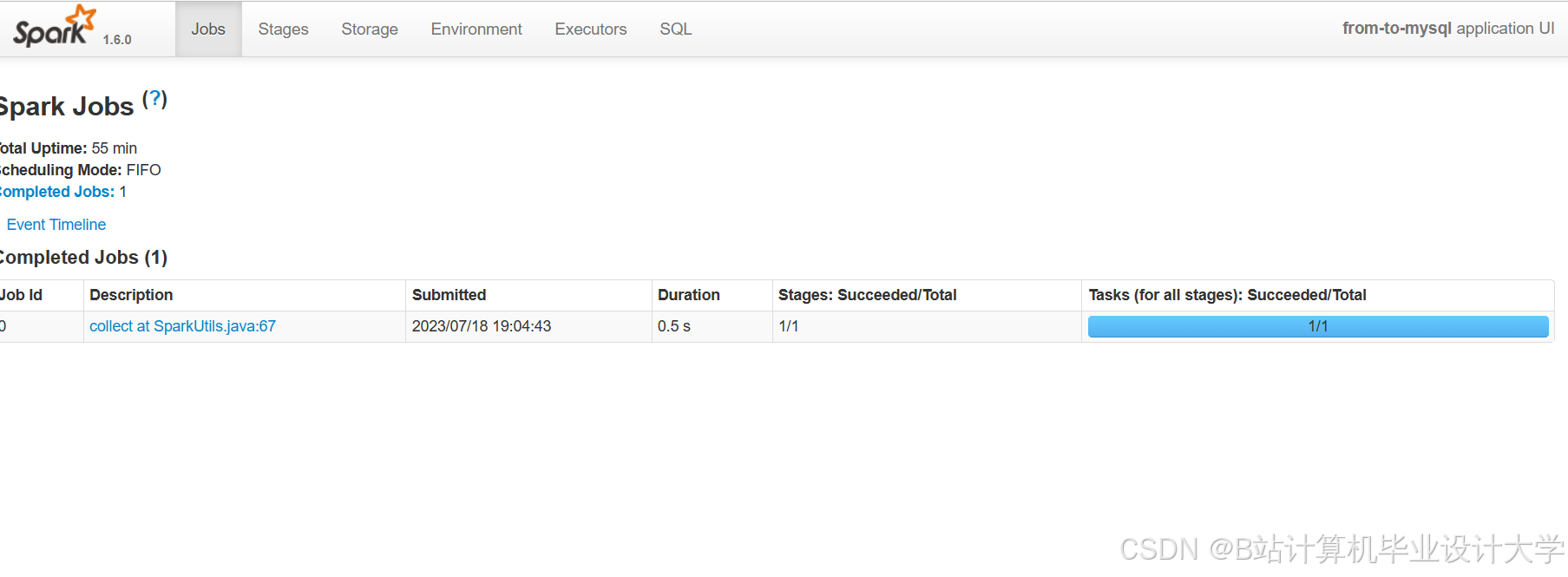

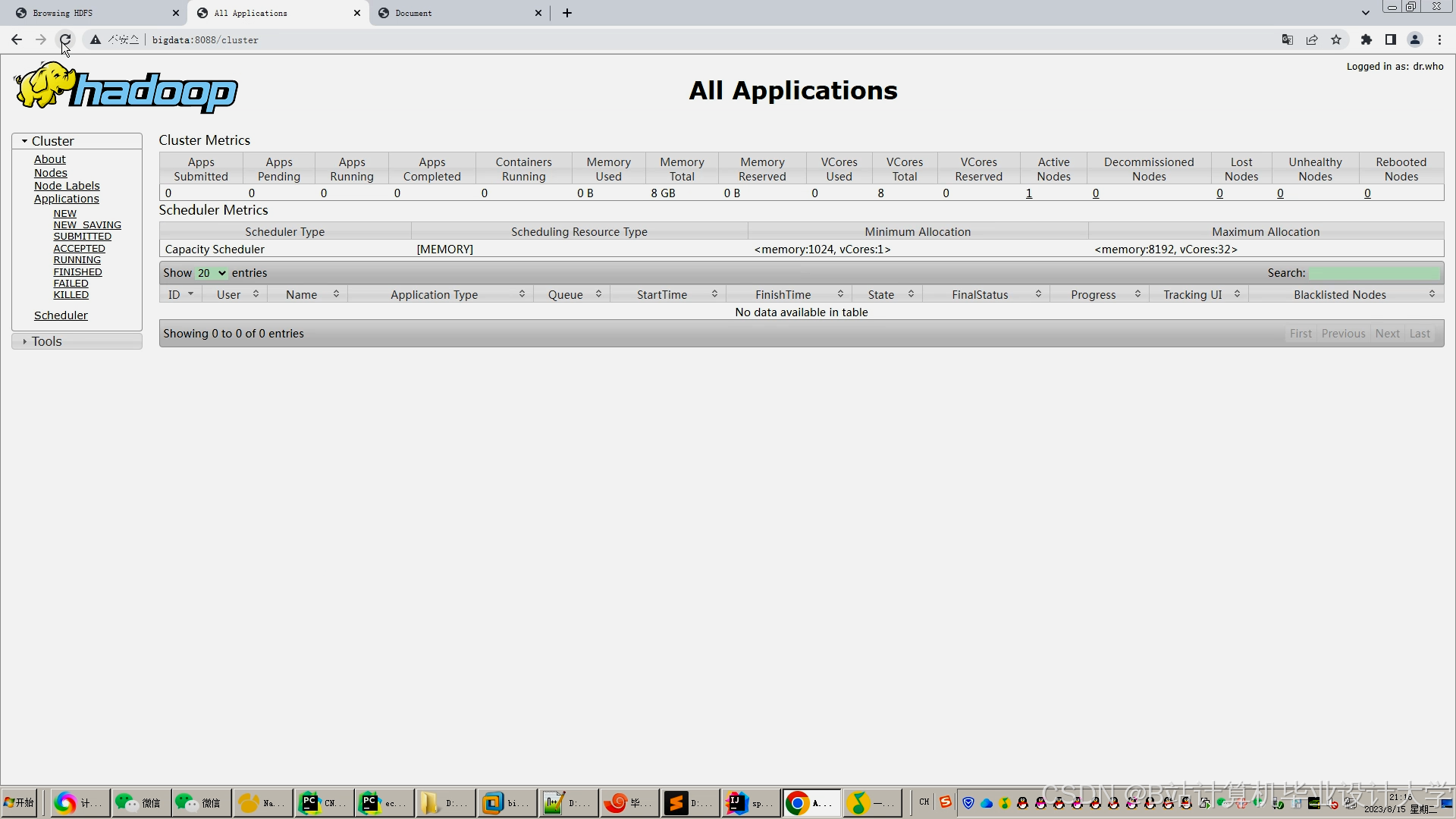

papers、users、citations)。 - Spark:实现分布式数据清洗、特征工程和模型训练。

2. 算法层

- 特征提取:

- 文本处理:使用Python的

jieba分词和Gensim训练Word2Vec模型,生成文献向量表示。 - 图结构分析:基于

NetworkX构建文献引用图,计算节点中心性(PageRank)。

- 文本处理:使用Python的

- 推荐算法:

- 基于内容的推荐:计算文献向量余弦相似度,推荐相似主题文献。

- 协同过滤:利用Spark ALS(交替最小二乘)实现用户-文献矩阵分解。

- 图神经网络(GNN):使用PyG(PyTorch Geometric)建模文献引用关系,捕捉深层语义关联。

3. 应用层

- Web应用(Django/Flask):

- 前端:Vue.js实现动态推荐列表、文献详情页和可视化组件(ECharts、D3.js)。

- 后端:Django REST Framework提供API接口,管理用户认证与推荐结果。

- 部署:Docker容器化,支持高并发访问。

四、任务分工

| 模块 | 负责人 | 任务描述 |

|---|---|---|

| 数据采集与预处理 | 张三 | 编写爬虫脚本获取知网文献数据,使用Spark清洗噪声(如HTML标签、重复记录)。 |

| Hadoop集群搭建 | 李四 | 部署Hadoop+Hive环境,配置HDFS存储策略与Hive分区表优化查询性能。 |

| 特征工程与模型训练 | 王五 | 使用Spark MLlib提取文本特征,训练Word2Vec/GNN模型,融合协同过滤结果。 |

| Web应用开发 | 赵六 | 设计Django后端接口,开发前端推荐页面与可视化图表,集成Elasticsearch全文检索。 |

| 系统测试与部署 | 全体成员 | 联合测试推荐精度与响应时间,优化Spark作业资源分配,编写部署文档。 |

五、实施计划

阶段1:需求分析与环境搭建(第1-2周)

- 确认推荐场景需求(如按学科、关键词、引用关系推荐)。

- 搭建Hadoop+Spark开发环境,配置Hive元数据管理。

阶段2:数据处理与特征工程(第3-5周)

- 完成数据清洗、分词与向量表示,构建文献-关键词共现矩阵。

- 使用Spark GraphX构建文献引用图,计算节点重要性指标。

阶段3:模型开发与训练(第6-8周)

- 训练Word2Vec模型生成文献嵌入向量,验证内容推荐效果。

- 实现Spark ALS协同过滤算法,优化超参数(如隐因子维度)。

- 开发GNN模型(如GCN),在引用图上预测文献相关性。

阶段4:Web应用开发与集成(第9-11周)

- 开发Django后端服务,集成推荐API与用户行为日志。

- 设计前端页面,实现推荐列表动态刷新与交互分析功能。

- 部署Elasticsearch,支持文献标题/摘要的快速检索。

阶段5:测试与优化(第12-13周)

- 离线评估推荐指标(Precision、Recall、NDCG)。

- 在线A/B测试用户点击率,调整推荐策略权重。

- 优化Spark任务执行计划,减少推荐延迟至<500ms。

阶段6:部署与验收(第14周)

- 部署系统至云服务器(如阿里云ECS),配置负载均衡。

- 组织用户试用反馈,迭代改进界面与算法。

- 提交项目验收报告与技术文档。

六、预期成果

- 系统代码库:GitHub托管,包含数据处理脚本、模型训练代码与Web应用源码。

- 部署环境:Docker镜像与云服务器配置文档,支持快速复现。

- 技术文档:架构设计图、API接口说明、模型评估报告。

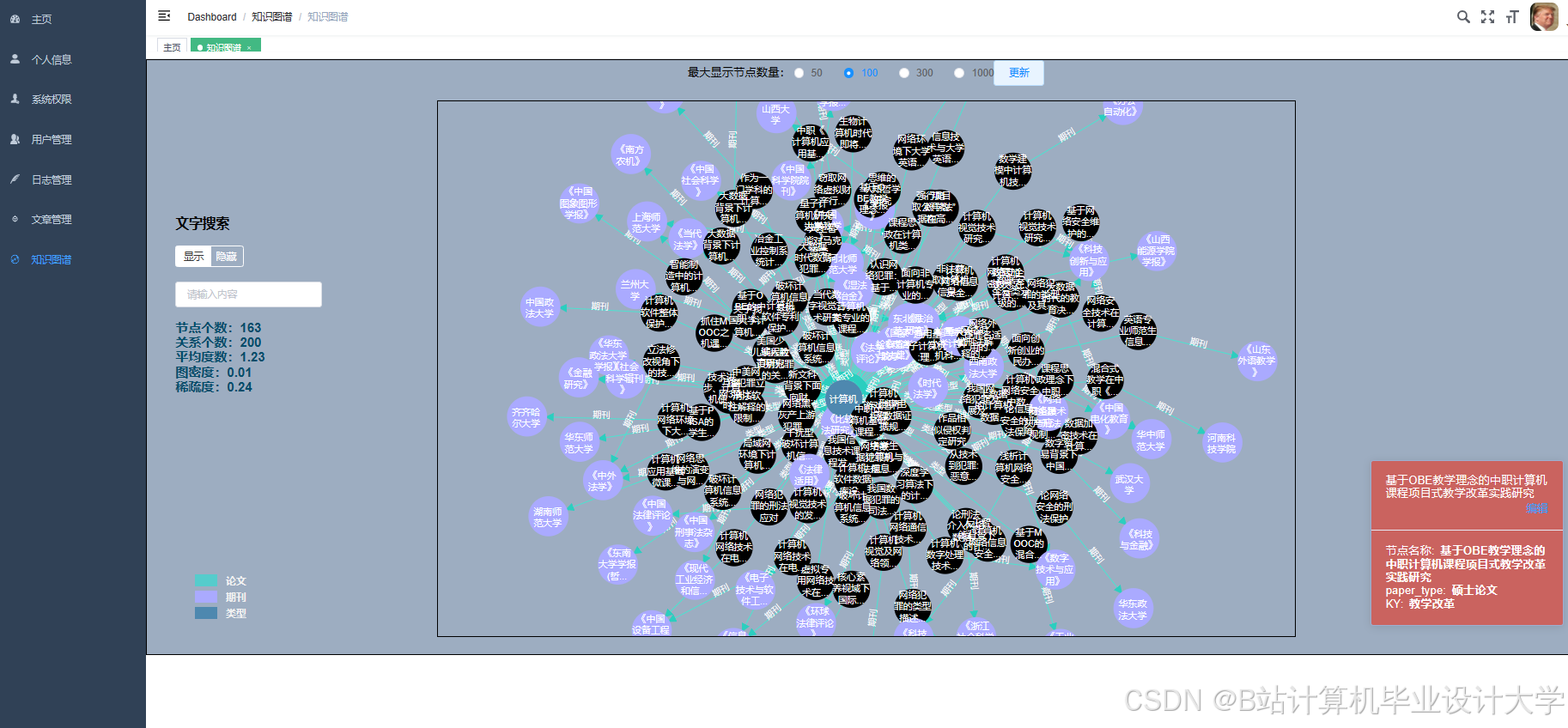

- 可视化报告:文献主题分布热力图、引用网络拓扑图、推荐路径溯源。

七、风险评估与应对

- 数据合规风险:确保知网数据使用符合版权协议,匿名化处理用户行为数据。

- 冷启动问题:结合用户注册时填写的学科领域,初始化推荐列表。

- 系统性能瓶颈:监控Spark任务内存使用,优化数据分区与缓存策略。

项目负责人:__________

日期:__________

此任务书可根据实际需求调整算法选型(如替换GNN为BERT语义匹配)或增加多模态推荐(结合文献PDF内容解析)。建议优先验证小规模数据上的推荐效果,再扩展至全量数据。

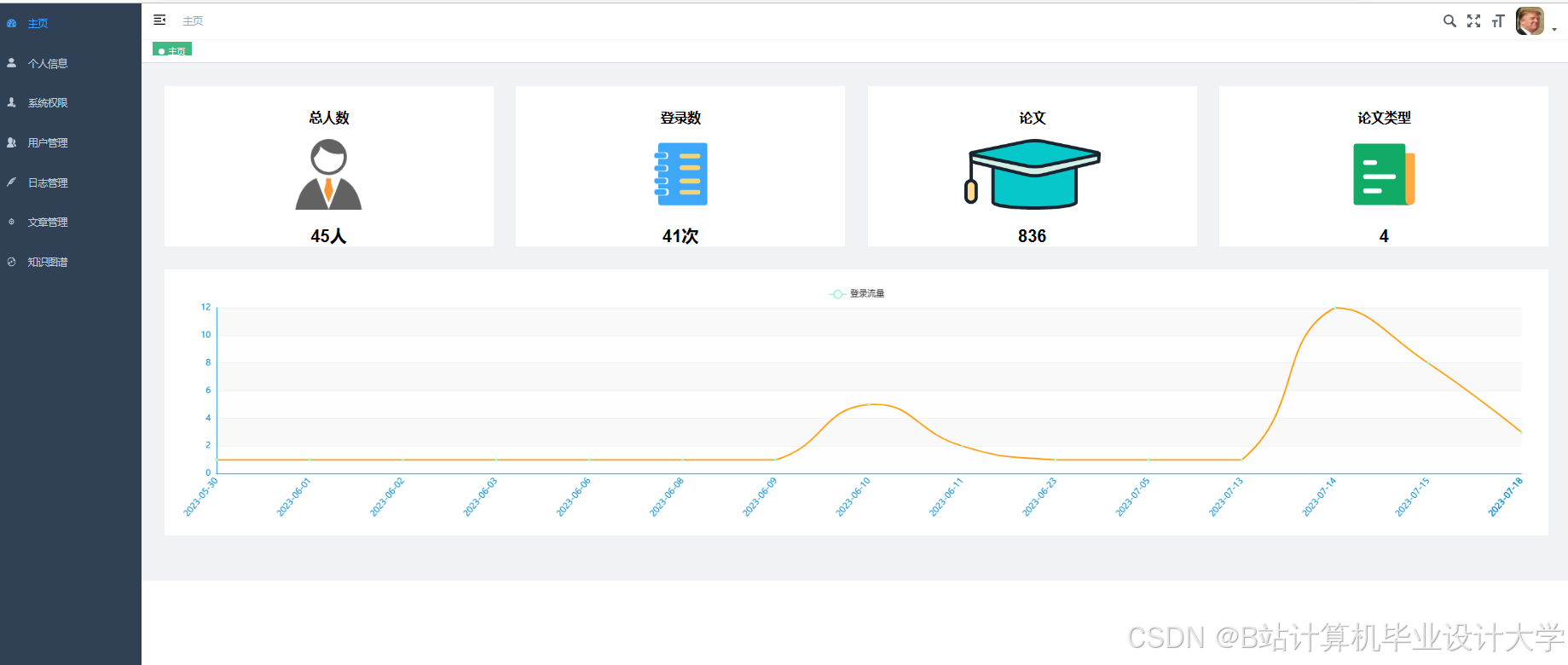

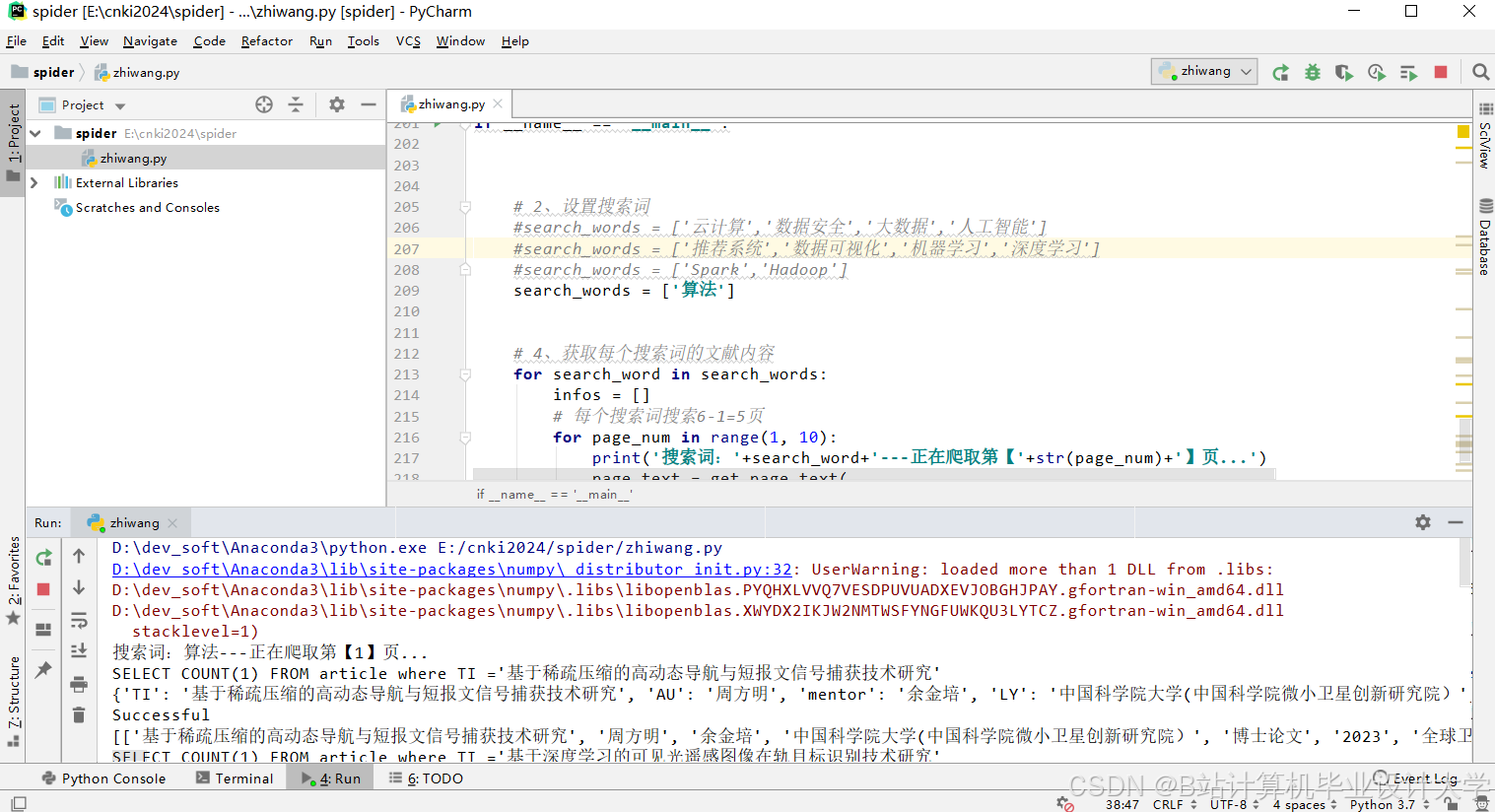

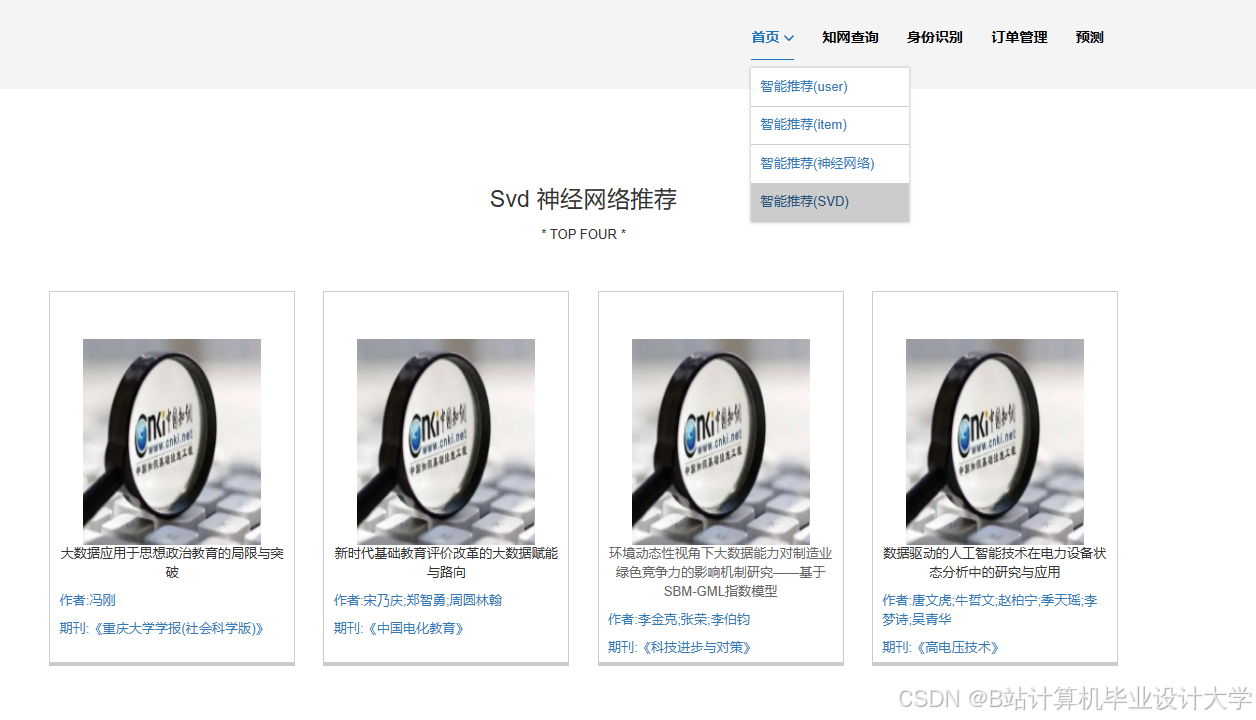

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

719

719

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?