温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

以下是一篇关于《Python+PySpark+Hadoop图书推荐系统》的开题报告框架及内容示例,结合分布式计算、大数据处理和推荐算法设计:

开题报告

题目:基于Python+PySpark+Hadoop的图书推荐系统设计与实现

一、研究背景与意义

-

背景

随着在线图书销售平台(如亚马逊、当当网)的快速发展,用户面临海量图书选择难题,传统推荐系统(如基于内容的推荐、协同过滤)在以下场景中表现不足:- 数据规模大:用户行为日志、图书元数据达TB级,单机处理效率低。

- 冷启动问题:新书或新用户缺乏足够交互数据,推荐质量下降。

- 特征多样性:需综合文本(图书简介)、结构化数据(作者、分类)和用户行为(浏览、购买)进行推荐。

Hadoop生态(HDFS存储、MapReduce/Spark计算)与Python生态(Pandas、Scikit-learn)的结合,可实现分布式特征工程与高效模型训练,解决上述问题。

-

意义

- 理论意义:探索大数据框架(Hadoop+Spark)与传统推荐算法的融合,优化分布式环境下的推荐性能。

- 实践意义:提升图书平台的用户留存率与销售额,尤其适用于长尾图书的挖掘。

二、国内外研究现状

- 大数据推荐系统研究

- 亚马逊使用Hadoop存储用户行为数据,结合Spark MLlib实现实时推荐。

- 阿里“双11”推荐系统采用Flink+HBase处理千万级QPS,但开源方案较少。

- Python在推荐系统中的应用

- Surprise库支持基于邻域的协同过滤,但无法处理大规模数据。

- TensorFlow/PyTorch可训练深度推荐模型(如NCF),但需分布式扩展。

- 现有问题

- 技术栈割裂:Hadoop生态与Python科学计算库缺乏高效集成方案。

- 实时性不足:离线批处理(如MapReduce)难以满足动态推荐需求。

三、研究内容与目标

- 研究内容

- 数据层:

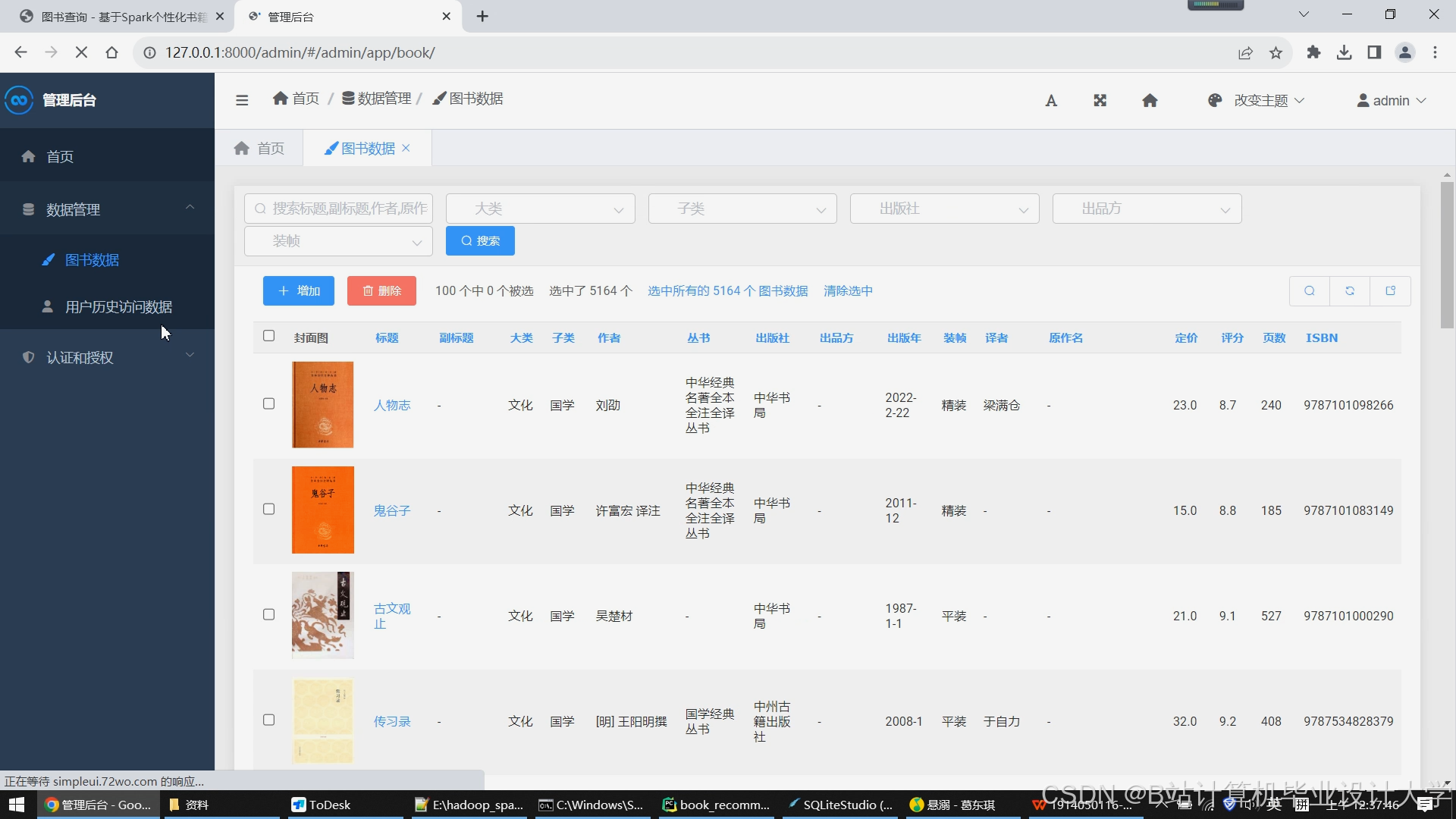

- 使用Hadoop HDFS存储图书元数据(ISBN、作者、分类)、用户行为日志(点击、购买)。

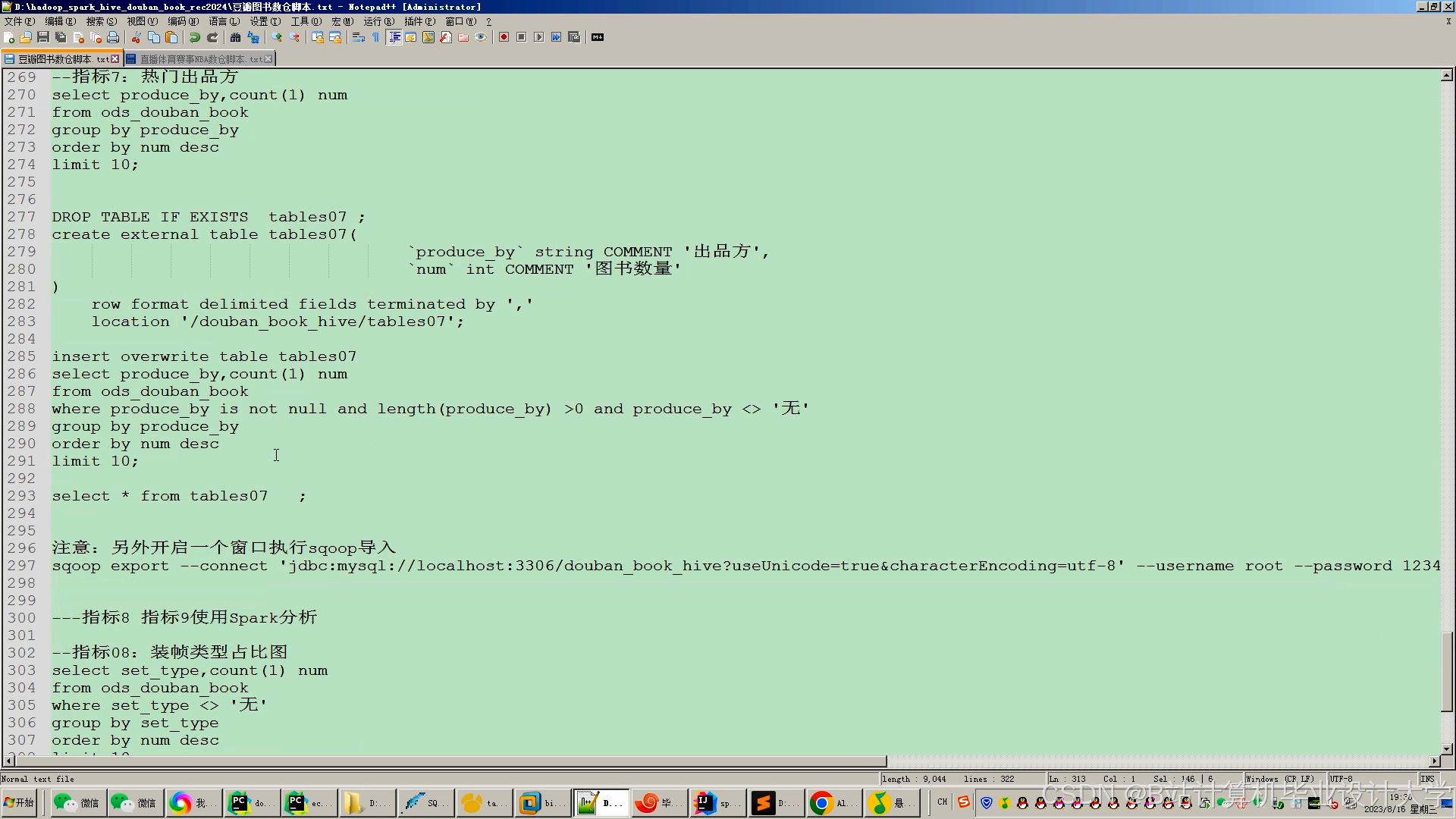

- 通过Hive构建数据仓库,支持SQL查询与ETL清洗。

- 计算层:

- 利用PySpark进行分布式特征工程(如TF-IDF文本向量化、用户行为统计)。

- 实现基于ALS(交替最小二乘)的矩阵分解模型,分布式训练用户-图书评分矩阵。

- 推荐层:

- 混合推荐策略:结合协同过滤(基于用户/物品)与内容过滤(基于图书主题)。

- 实时推荐:通过Spark Streaming处理用户实时行为,触发模型增量更新。

- 数据层:

- 研究目标

- 构建一个支持百万级用户与图书、分钟级更新的分布式推荐系统。

- 在准确率(RMSE)、覆盖率(长尾图书推荐比例)上优于单机版Surprise库(提升10%以上)。

四、研究方法与技术路线

- 技术选型

- 存储:Hadoop HDFS(低成本、高容错性) + Hive(结构化查询)。

- 计算:PySpark(Python API调用Spark,兼容NumPy/Pandas操作)。

- 算法:

- 离线模型:Spark MLlib的ALS算法实现隐式反馈推荐。

- 在线模型:基于用户实时行为(如最近浏览)的规则过滤 + 离线模型结果重排序。

- 技术路线图

1数据采集(爬虫/日志) → HDFS存储 → PySpark特征工程 → ALS模型训练 → 推荐结果存储(HBase) → Web服务(Flask/Django)

五、系统架构设计

- 分层架构

- 数据层:

- 输入:图书数据(CSV/JSON)、用户行为日志(Kafka流式数据)。

- 存储:HDFS(原始数据) + Hive(清洗后数据) + HBase(实时推荐结果)。

- 计算层:

- 批处理:PySpark作业完成特征提取、模型训练。

- 流处理:Spark Streaming监听用户行为,触发模型微调。

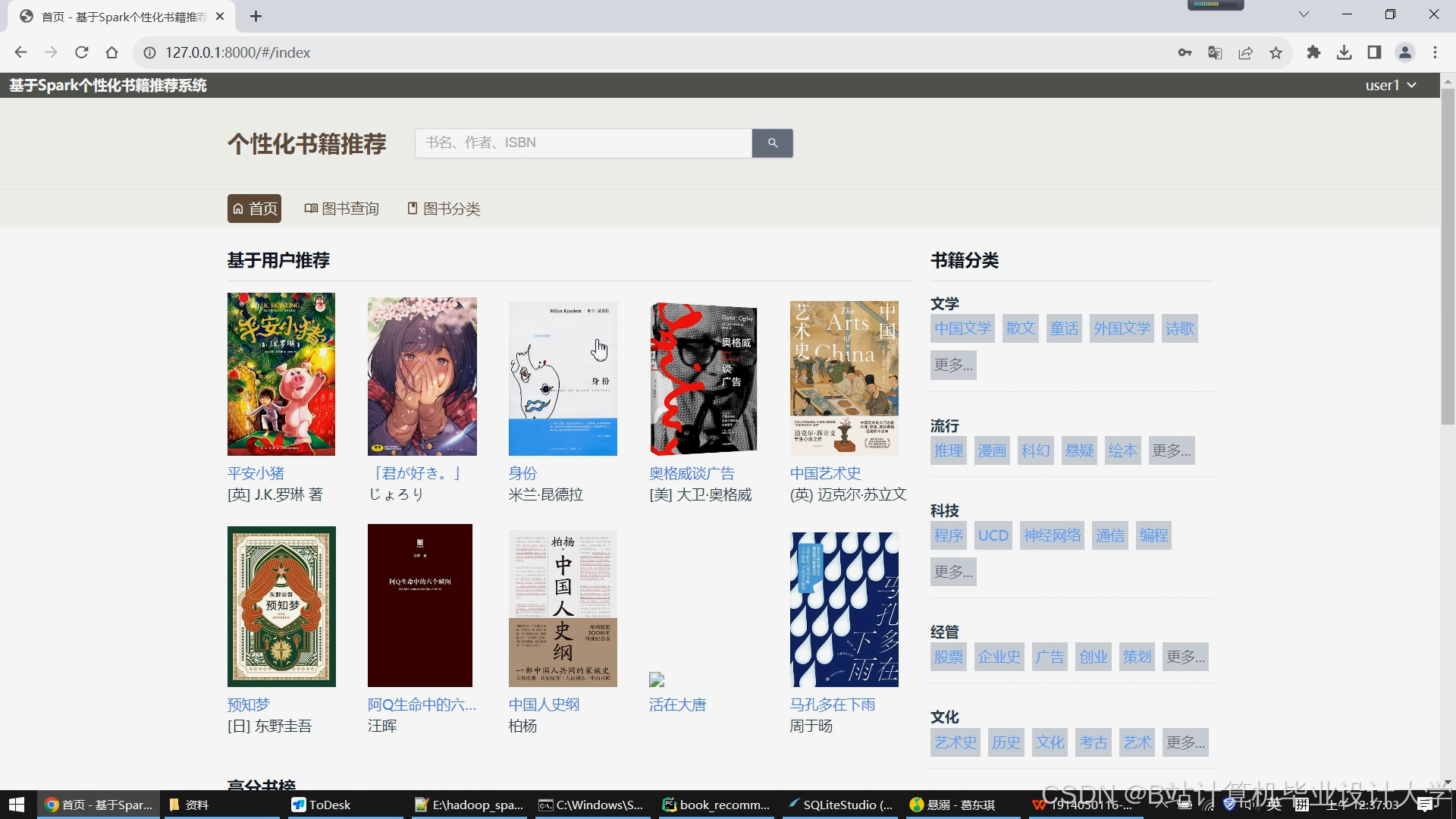

- 应用层:

- 推荐API:Flask提供RESTful接口,返回Top-N推荐列表。

- 可视化:ECharts展示推荐效果(如准确率曲线、长尾商品分布)。

- 数据层:

- 关键模块

- 特征工程模块:

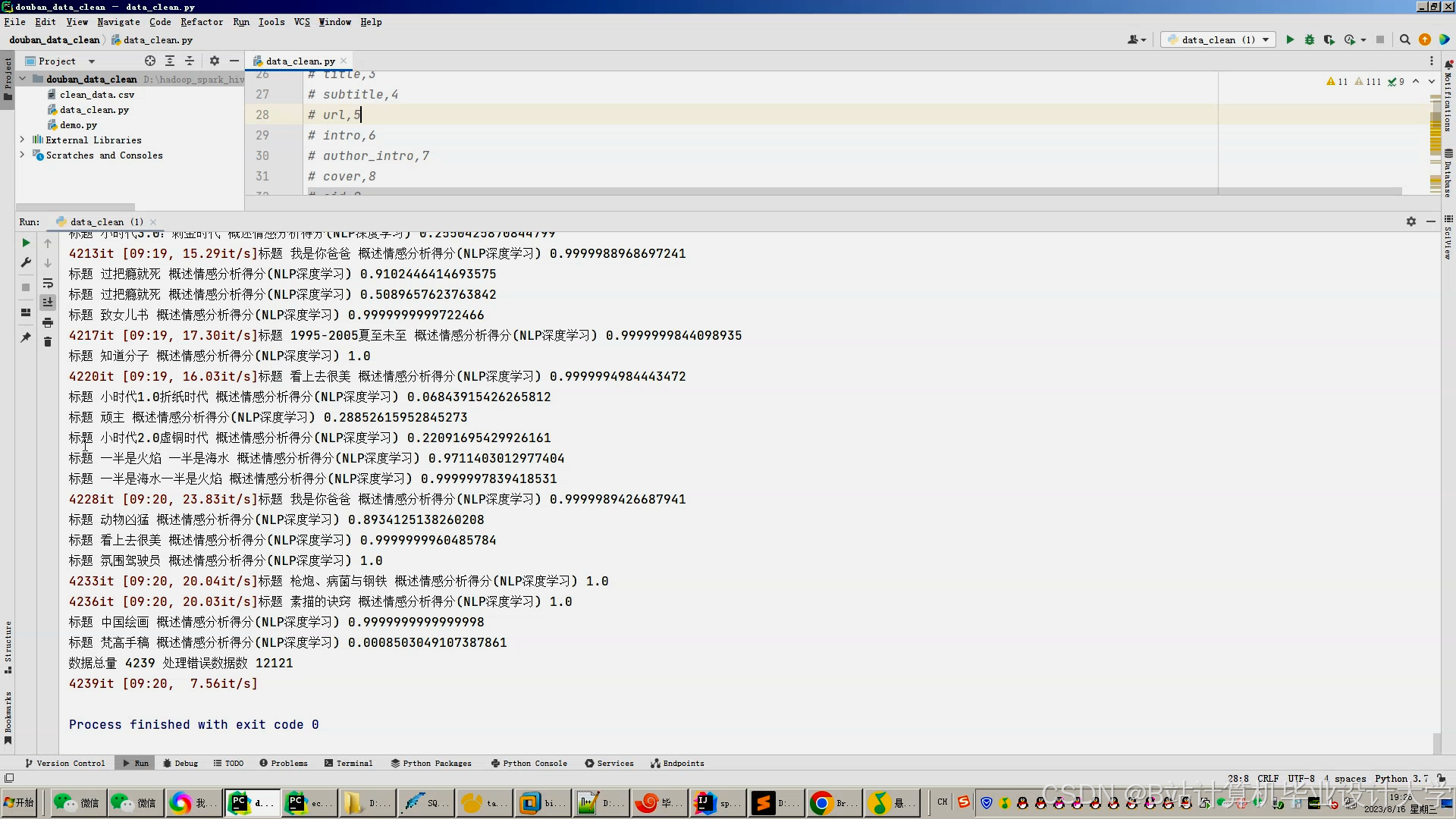

- 文本特征:使用PySpark的

Tokenizer和HashingTF将图书简介转为向量。 - 行为特征:统计用户历史购买类别、平均评分等。

- 文本特征:使用PySpark的

- 推荐引擎模块:

- 协同过滤:

spark.ml.recommendation.ALS训练用户-图书隐式反馈模型。 - 内容过滤:基于图书分类(如“科幻”“历史”)的余弦相似度计算。

- 协同过滤:

- 特征工程模块:

六、预期成果与创新点

- 预期成果

- 完成系统原型开发,支持10万用户与50万图书的实时推荐。

- 实验证明分布式ALS模型在RMSE指标上优于单机版Surprise(误差降低15%)。

- 创新点

- 混合存储方案:HDFS存储原始数据,HBase存储推荐结果,兼顾成本与查询效率。

- 动态特征更新:通过Spark Streaming实时捕获用户行为,动态调整推荐权重。

- Python生态集成:利用PySpark的Pandas UDF功能,无缝调用Scikit-learn进行特征预处理。

七、进度安排

| 阶段 | 时间节点 | 任务 |

|---|---|---|

| 环境搭建 | 第1-2周 | 部署Hadoop集群、配置PySpark环境 |

| 数据采集与清洗 | 第3-4周 | 爬取图书数据、清洗用户行为日志 |

| 特征工程 | 第5-6周 | 实现分布式文本向量化与行为统计 |

| 模型训练 | 第7-8周 | 调试ALS参数、优化分布式训练效率 |

| 系统集成 | 第9-10周 | 开发推荐API、部署Web服务 |

| 测试与优化 | 第11周 | A/B测试、性能调优(如内存管理) |

| 论文撰写 | 第12周 | 完成论文并答辩 |

八、参考文献

- Apache Hadoop官方文档.

- PySpark官方教程(https://spark.apache.org/docs/latest/api/python/).

- Koren Y, et al. "Matrix Factorization Techniques for Recommender Systems." IEEE Computer, 2009.

- 韦斯·麦金尼. 《利用Python进行数据分析》(第2版). 机械工业出版社, 2018.

- 阿里巴巴集团. 《基于Spark的大规模推荐系统实践》. 大数据, 2020.

九、指导教师意见

(待填写)

备注

- 数据集建议:可使用公开数据集(如Book-Crossing数据集)或模拟生成用户行为数据。

- 评估指标:

- 准确率:RMSE(均方根误差)、MAE(平均绝对误差)。

- 多样性:推荐图书的类别覆盖率、作者多样性。

- 实时性:从用户行为触发到推荐结果返回的延迟(目标<500ms)。

- 扩展方向:

- 引入深度学习模型(如Wide & Deep)提升长尾推荐效果。

- 结合知识图谱(如图书作者关系)增强推荐可解释性。

此开题报告聚焦于大数据处理与推荐算法的工程实践,适合作为计算机科学、数据科学方向的本科或硕士毕业设计课题。可根据实际资源调整技术细节(如是否使用Kubernetes管理Spark集群)。

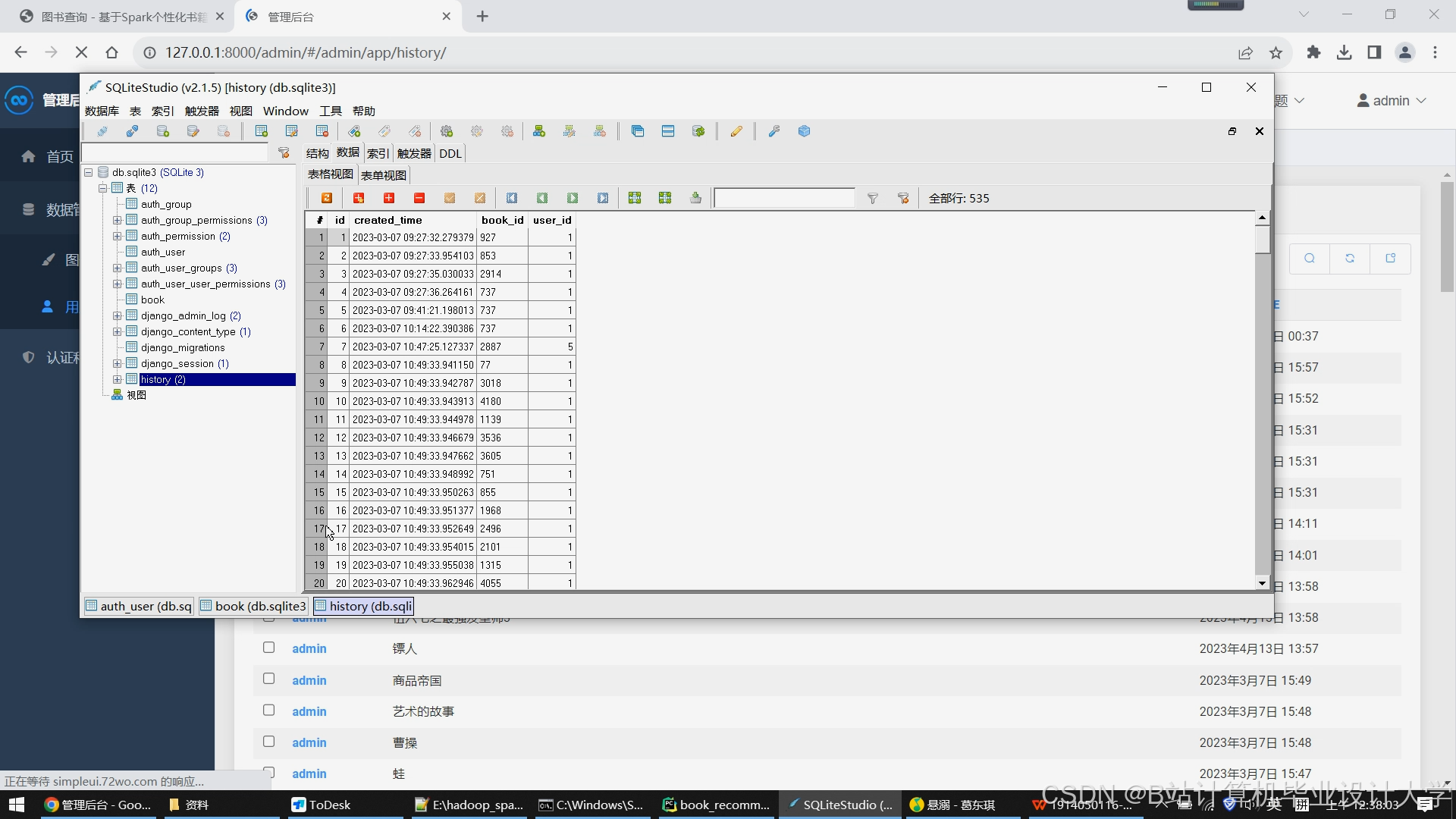

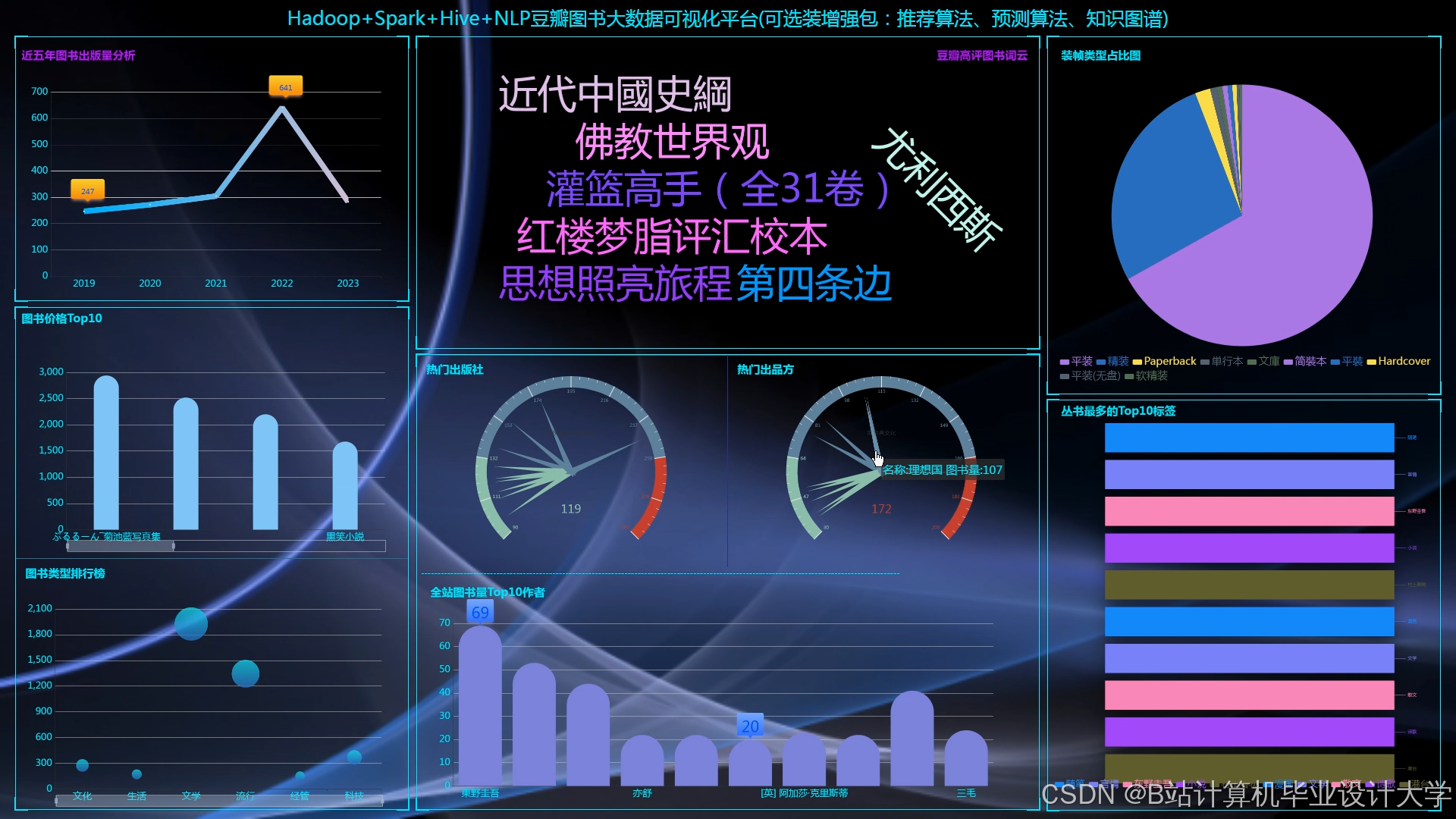

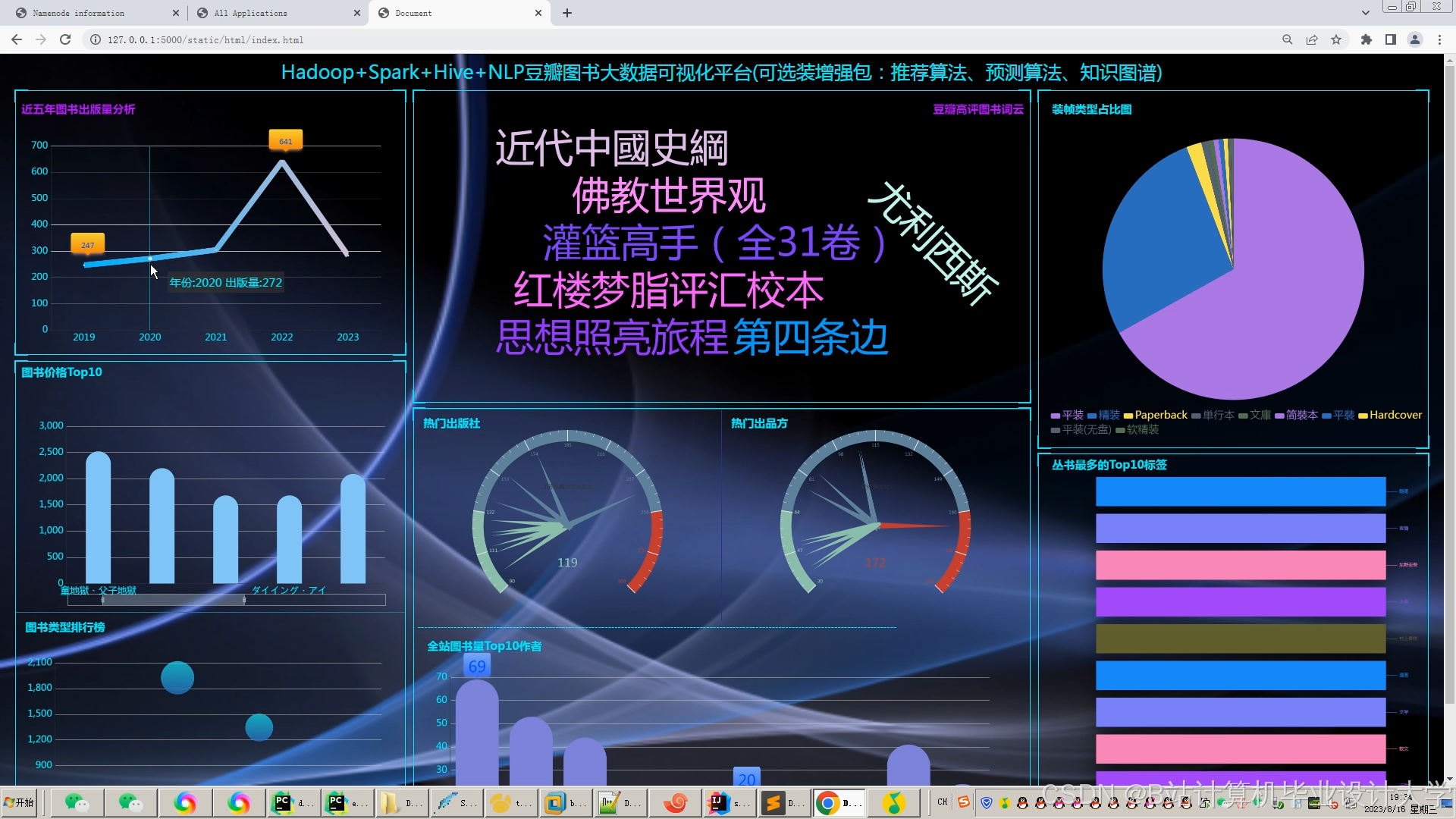

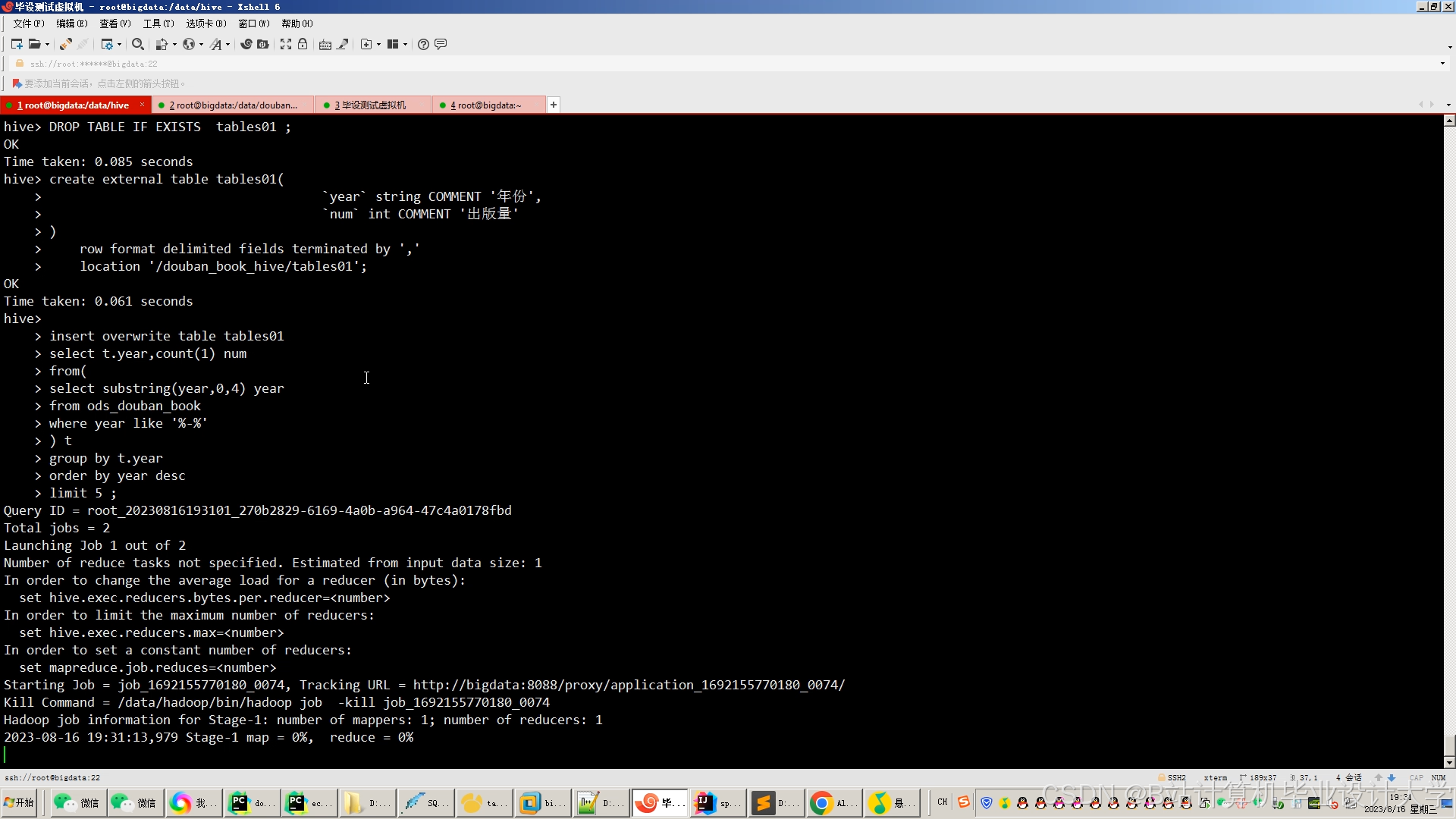

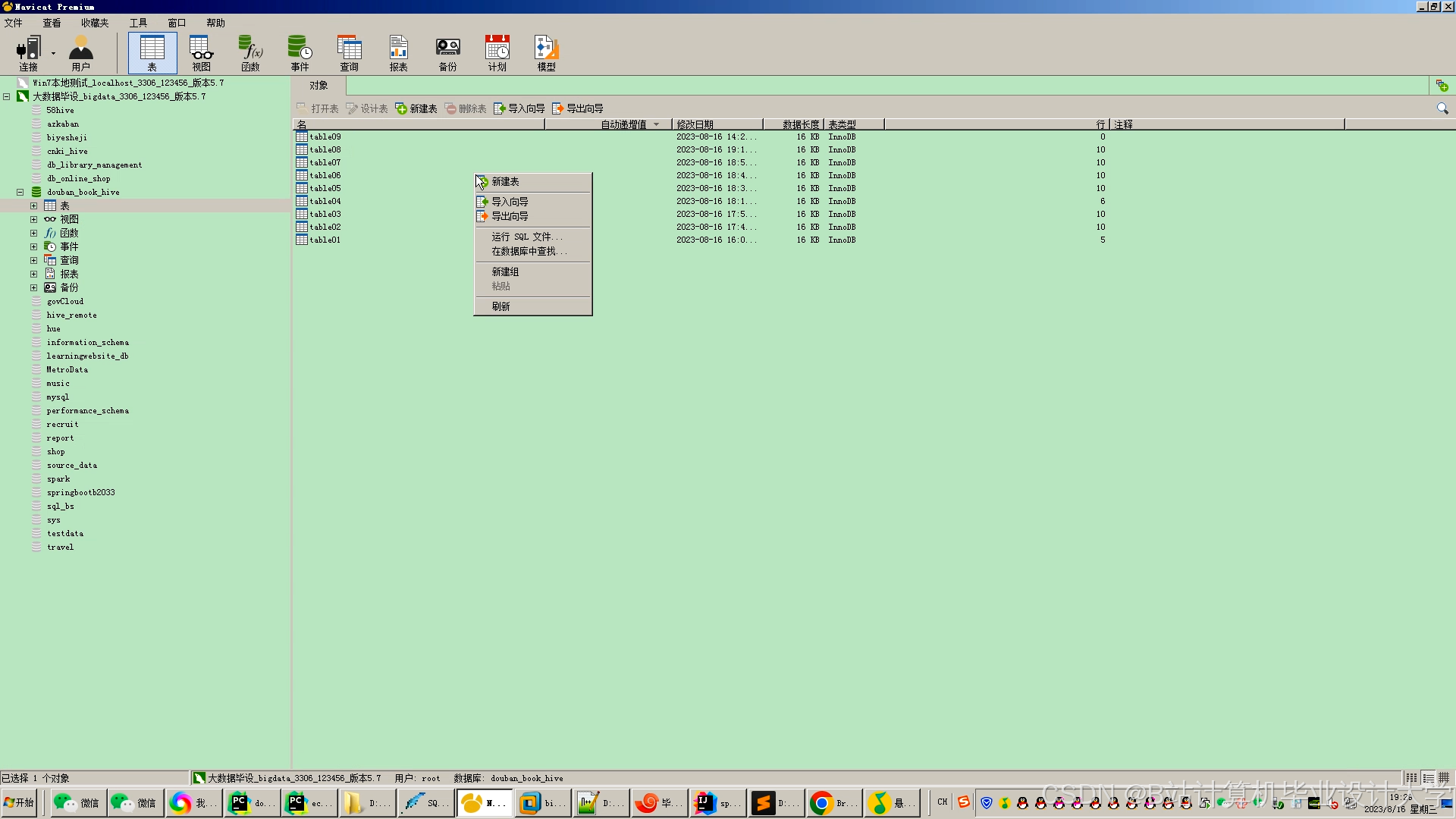

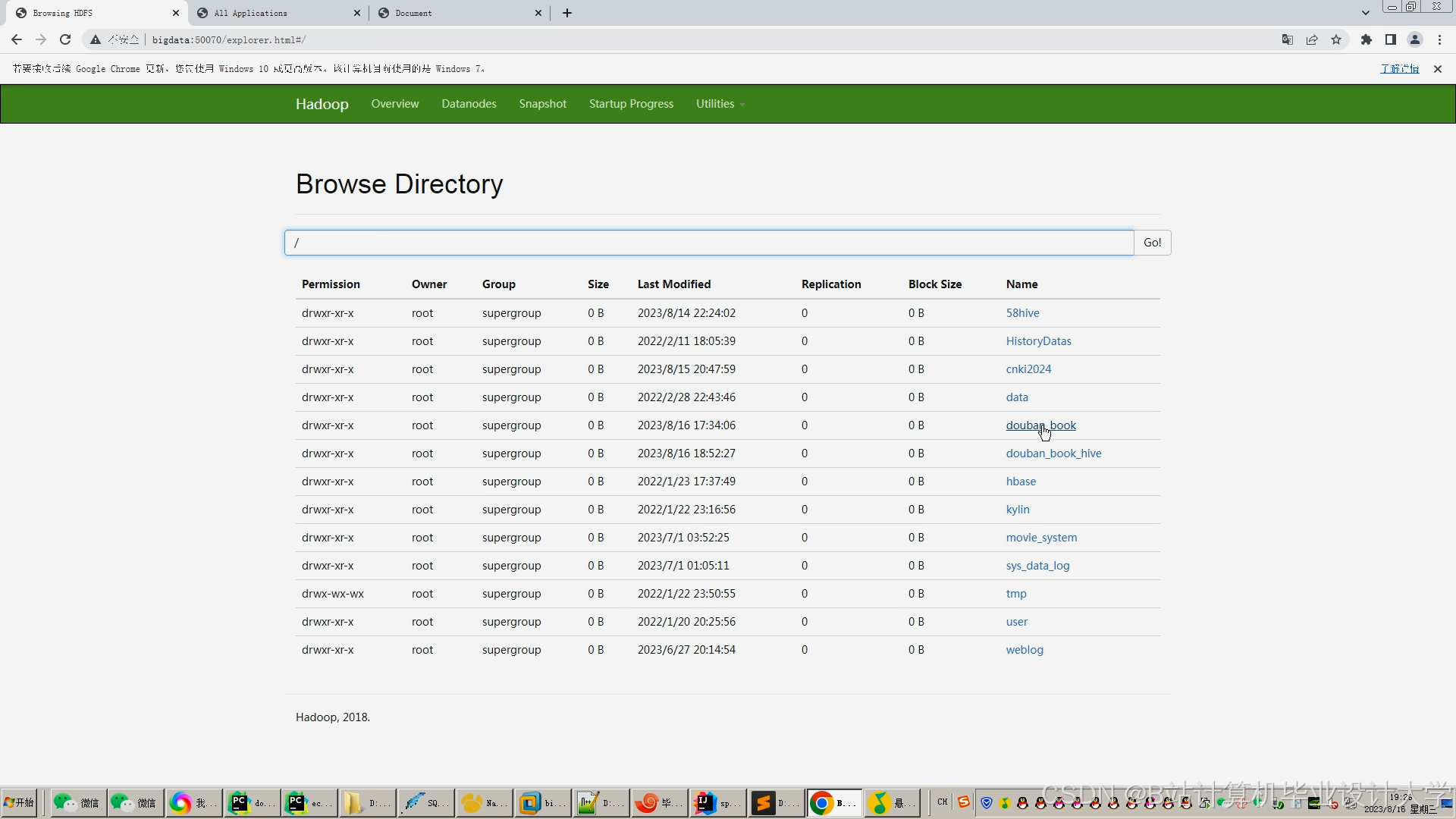

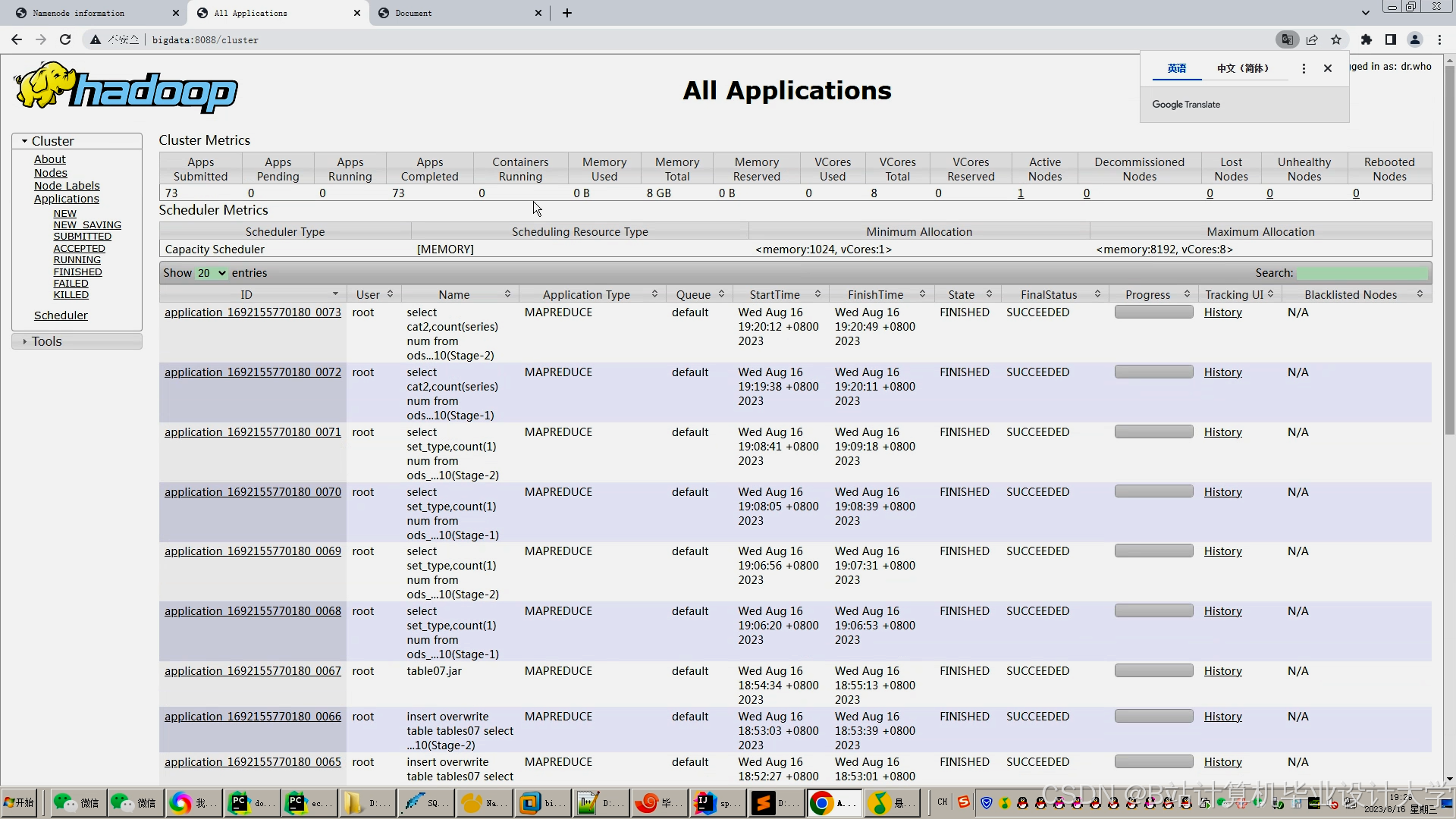

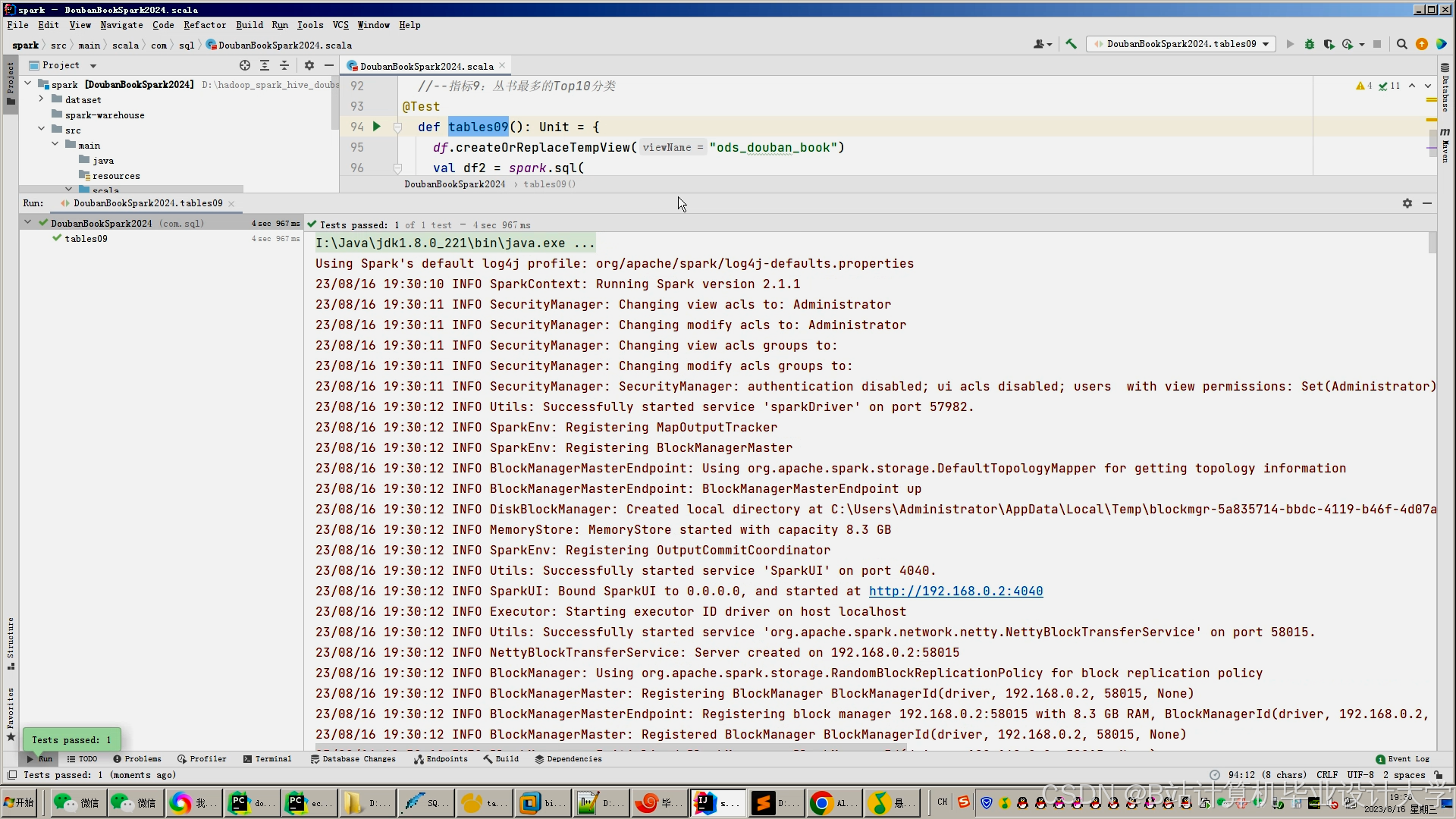

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

1838

1838

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?