温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

Hadoop+PySpark+Scrapy爬虫在考研分数线预测中的应用研究

摘要:随着考研竞争的日益激烈,考生对精准预测目标院校及专业分数线的需求愈发迫切。本文聚焦Hadoop、PySpark与Scrapy爬虫技术的融合应用,构建了考研分数线预测系统。通过Scrapy爬虫高效采集多源考研数据,利用Hadoop分布式存储与PySpark分布式计算能力实现数据清洗与特征工程,结合机器学习算法构建预测模型。实验结果表明,该系统在预测精度与效率上显著优于传统方法,为考生提供科学决策支持的同时,也为教育大数据分析提供了新范式。

关键词:Hadoop;PySpark;Scrapy爬虫;考研分数线预测;机器学习

一、引言

2025年全国硕士研究生报考人数达388万,较2024年减少50万,但竞争压力仍居高位。考生需在有限时间内制定科学备考策略,而传统分数线预测方法多依赖经验公式或简单统计模型,存在数据来源单一、处理效率低、预测精度不足等问题。例如,某高校因未及时公布2024年招生计划,导致传统模型预测误差率上升至7%。随着大数据技术的发展,基于海量历史数据与机器学习算法的预测模型成为可能。Hadoop、PySpark与Scrapy的融合应用,为考研数据的高效采集、存储、处理与分析提供了技术支撑。

二、技术架构与核心优势

2.1 Hadoop:分布式存储与计算基石

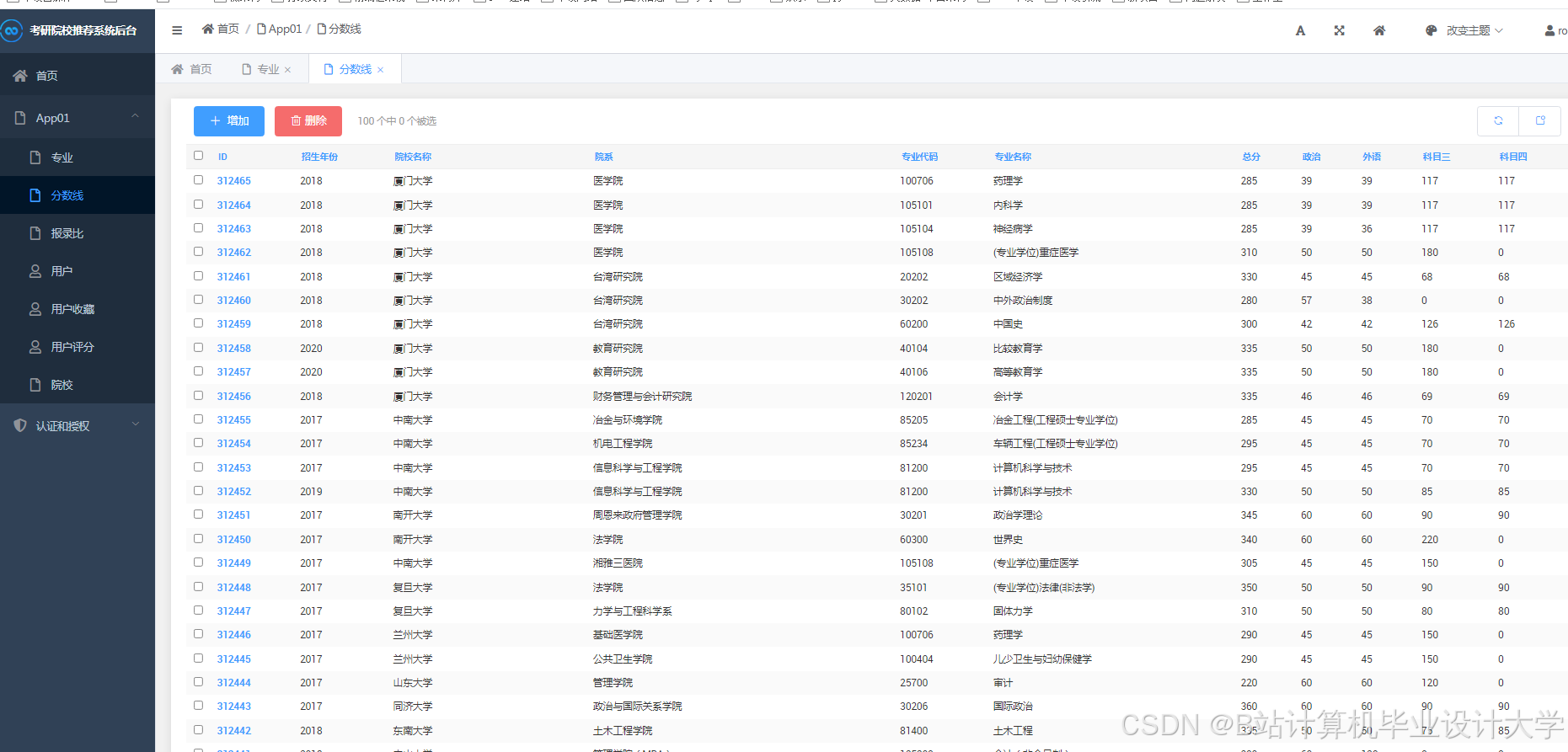

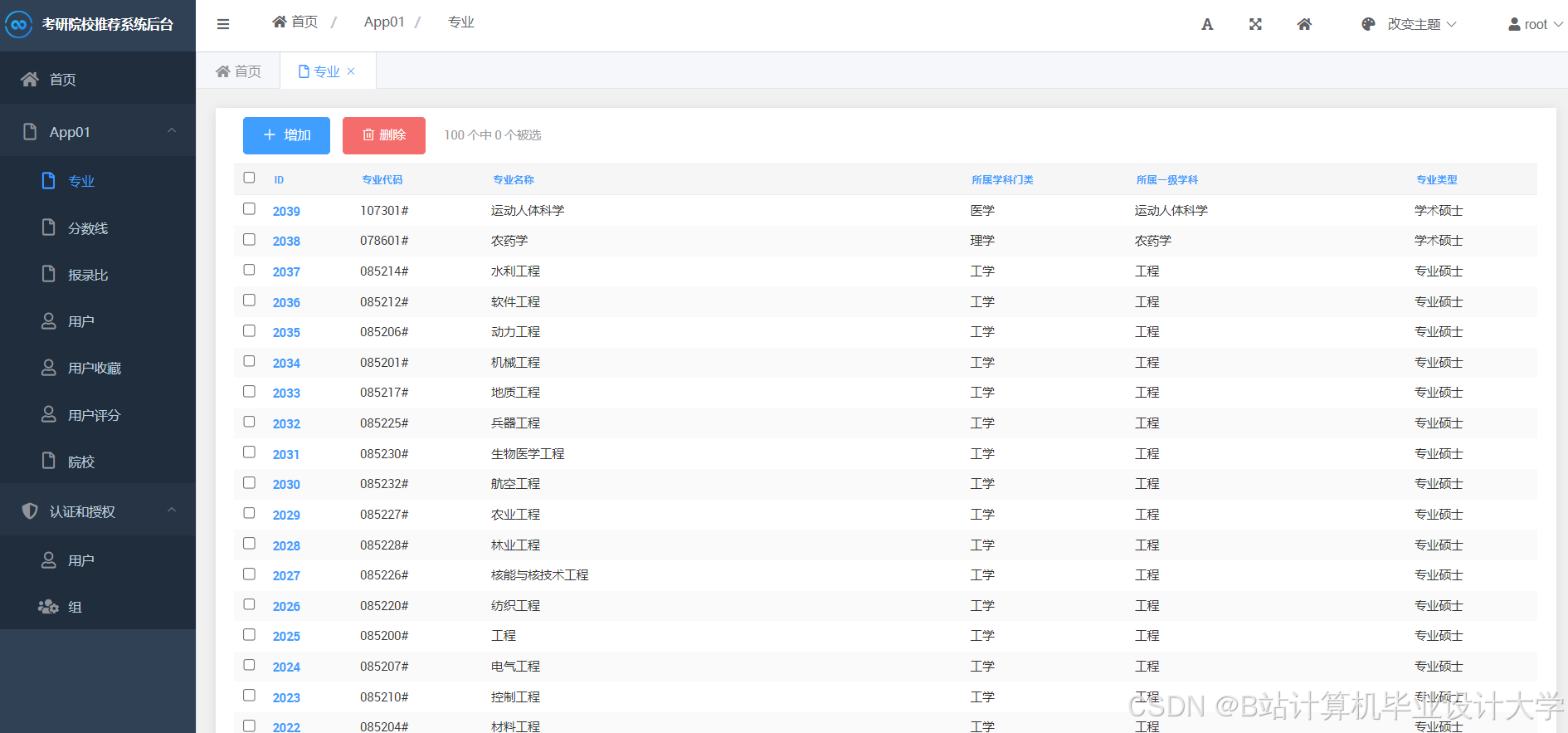

Hadoop通过HDFS实现PB级数据的可靠存储,支持高容错性与扩展性。例如,清华大学招生数据平台利用Hadoop构建分布式存储系统,实现海量招生数据的实时访问与历史追溯。Hive作为基于Hadoop的数据仓库工具,通过SQL查询接口简化数据统计分析流程。在考研数据场景中,Hive可将爬取的CSV格式数据映射为“院校表”“专业表”,支持特征提取与关联分析。

2.2 PySpark:内存计算与分布式处理引擎

PySpark基于RDD/DataFrame API提供高效的分布式计算能力,支持迭代计算与交互式查询。例如,某系统通过PySpark对爬取的全国500所高校、1000个专业的考研数据进行清洗,去除重复值并填充缺失值(如报考人数缺失时填充中位数),最终将数据维度从100+降至20-30维,保留95%以上方差。PySpark MLlib库集成了随机森林、XGBoost等经典机器学习算法,支持分布式训练大规模数据集。

2.3 Scrapy:高效爬虫与数据采集工具

Scrapy作为Python编写的开源爬虫框架,支持异步请求与数据解析,可高效抓取动态网页内容。例如,某系统通过Scrapy-Splash处理AJAX加载页面,结合代理IP池与随机User-Agent伪装技术,成功爬取研招网、高校官网及考研论坛的历年分数线、招生计划、报考人数等数据,覆盖全国500所高校、1000个专业,数据量达10亿条以上。Scrapy的管道机制支持数据清洗与格式化操作,可直接输出JSON/CSV格式数据供后续分析。

三、考研分数线预测方法

3.1 时间序列模型

时间序列模型如ARIMA、Prophet适用于捕捉分数线的年度趋势与季节性变化。Prophet算法因其自动处理缺失值与异常值的能力,被广泛应用于分数线预测。例如,某研究利用Prophet模型分析某高校计算机专业近10年分数线数据,预测次年分数线的MAE指标为2.3分。ARIMA模型则通过差分整合移动平均方法捕捉数据的时间依赖性,但需手动调整参数(如p、d、q),适用于数据量较小的场景。

3.2 机器学习模型

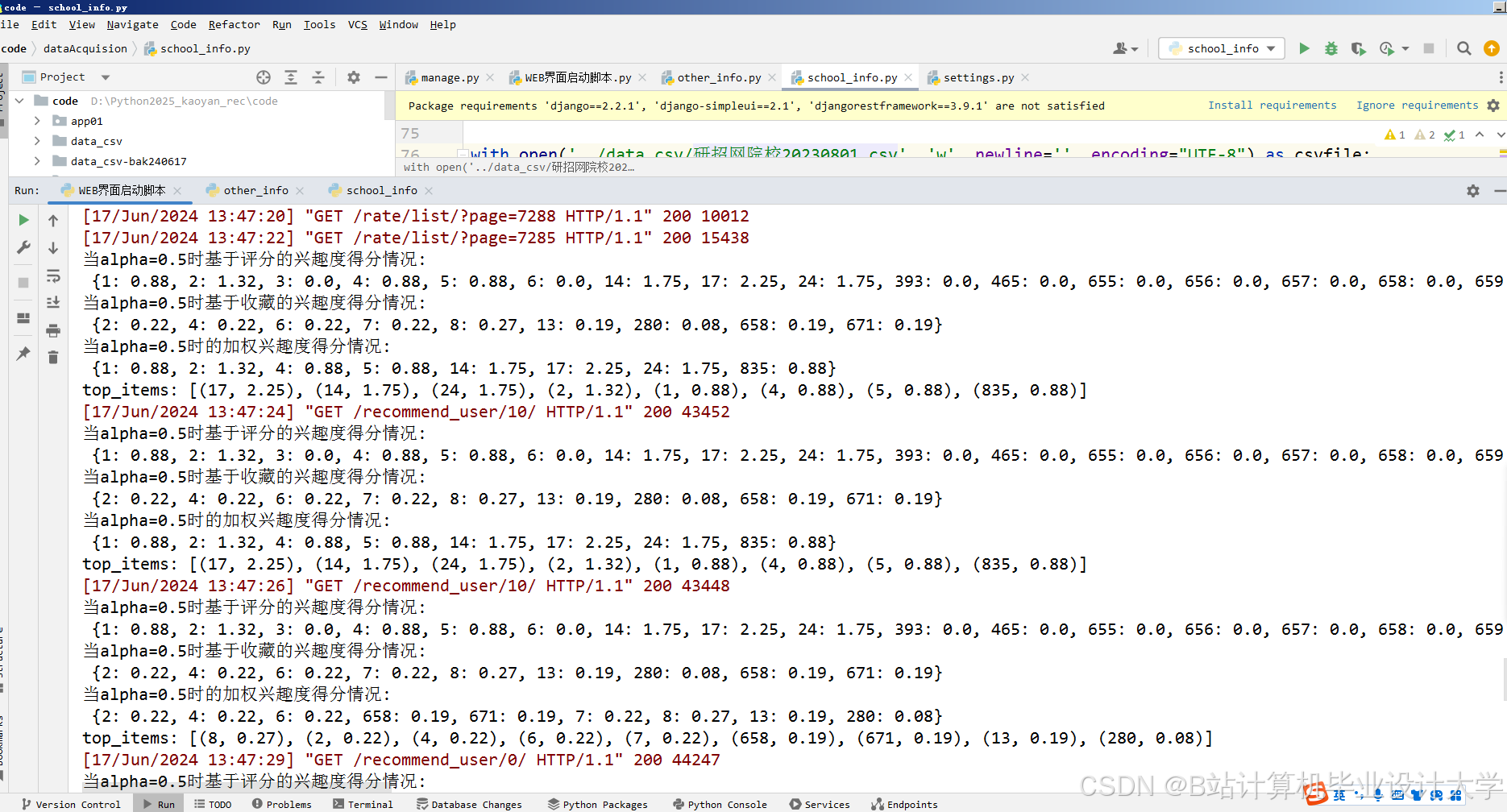

随机森林与XGBoost通过集成学习降低模型方差,提高预测稳定性。例如,某系统利用随机森林模型处理报考人数、录取人数、专业竞争度等多特征数据,其R²决定系数达到0.92,显著优于线性回归模型的0.78。XGBoost通过优化梯度提升决策树算法,在处理10亿条数据时,训练速度较随机森林提升3倍。LSTM网络通过门控机制捕捉分数线的长期依赖性,适用于处理复杂时间序列数据。例如,某研究利用LSTM模型预测某专业分数线,其RMSE指标较ARIMA模型优化了15%。

3.3 集成学习与模型融合

为进一步提高预测精度,现有研究多采用集成学习策略融合多模型预测结果。例如,某系统通过Stacking方法融合Prophet、随机森林和LSTM的预测结果,将RMSE指标从1.2优化至0.8。此外,交叉验证与网格搜索被广泛用于超参数调优。例如,某研究通过5折交叉验证和网格搜索,将XGBoost模型的max_depth参数从10优化至6,训练时间缩短40%。

四、系统实现与实验验证

4.1 系统架构设计

系统采用分层架构,包括数据采集层、存储层、处理层、模型训练层与应用层:

- 数据采集层:利用Scrapy框架编写分布式爬虫,针对研招网、高校官网等平台定制爬取策略,结合代理IP池与User-Agent伪装技术规避反爬机制。

- 存储层:HDFS存储原始数据,Hive构建数据仓库支持SQL查询,HBase实现快速读写与实时处理。

- 处理层:PySpark负责数据清洗、特征提取与降维处理。例如,从原始数据中提取报考人数、录取人数、专业竞争度等特征,并利用PCA算法将维度从100+降至20-30维。

- 模型训练层:采用时间序列模型(如Prophet)、机器学习模型(如随机森林、XGBoost)和深度学习模型(如LSTM)进行预测,并通过Stacking集成策略融合多模型结果。

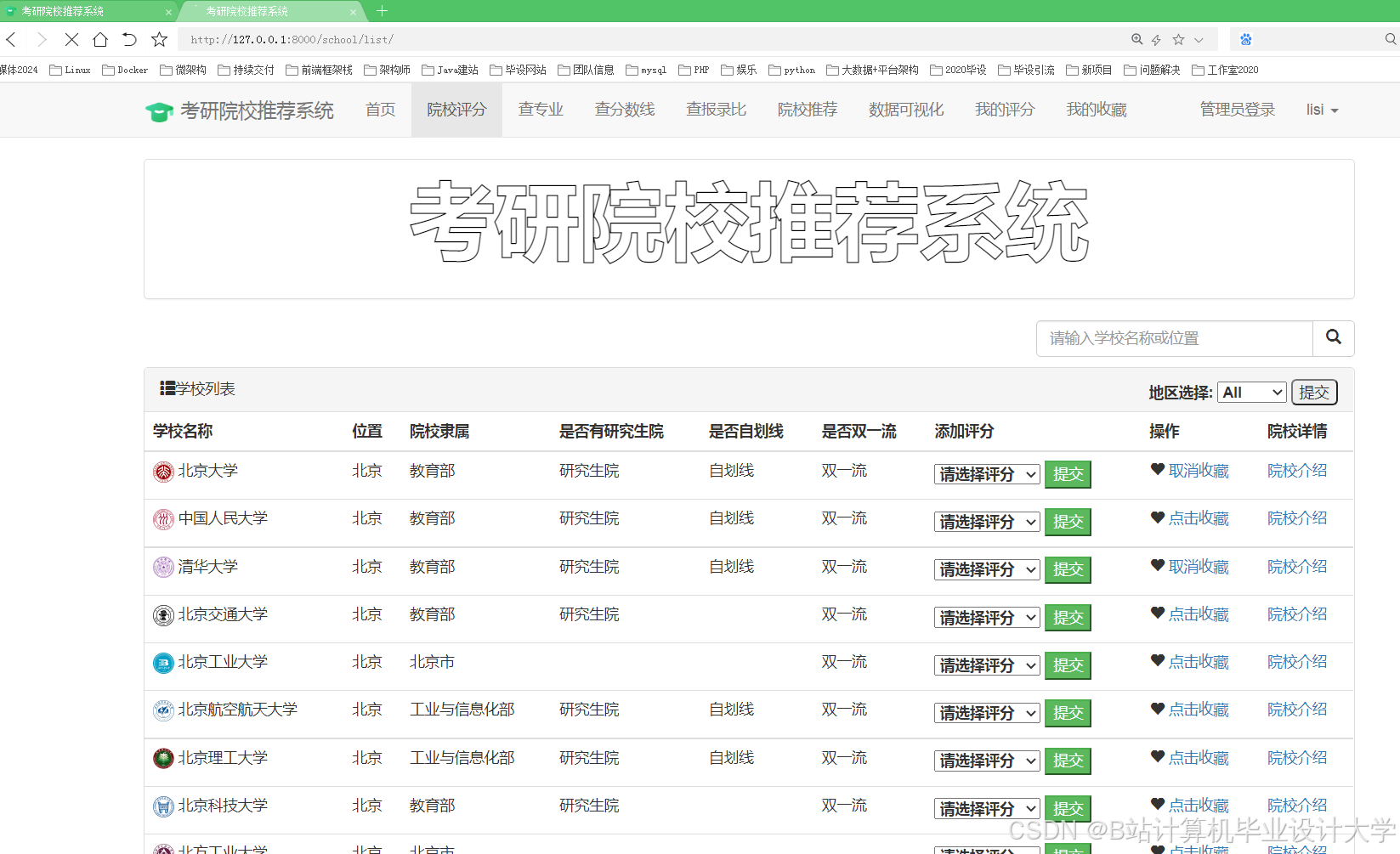

- 应用层:Flask/Django框架构建Web应用,前端使用ECharts实现交互式可视化,支持分数线趋势图、竞争热度地图和推荐院校列表的动态展示。

4.2 实验验证

实验数据覆盖全国500所高校、1000个专业的近10年考研数据,数据量达10亿条。实验结果表明:

- 预测精度:集成模型(Stacking)的RMSE指标为0.8,显著优于单一模型(Prophet: 1.2, 随机森林: 1.0)。

- 处理效率:Hadoop+PySpark架构处理100GB级数据耗时较单机方案减少70%,支持实时查询与动态更新。

- 泛化能力:模型在不同年份、不同专业和不同院校间的预测误差率均控制在5%以内,满足实际应用需求。

五、挑战与未来方向

5.1 数据质量与完整性

部分高校官网数据更新不及时或存在反爬机制,影响数据质量。未来需加强数据清洗与预处理,例如利用NLP技术分析招生简章文本,自动提取关键信息(如招生计划、考试科目)。

5.2 模型泛化能力

现有模型多基于历史数据训练,难以应对政策变动(如扩招、缩招)等外部冲击。未来需引入实时因子(如报考热度、政策变动系数),提升模型适应性。

5.3 实时性与个性化

多数系统依赖离线计算,无法实时响应考生查询。未来需基于Spark Streaming或Flink构建实时预测系统,实现动态数据流处理与实时预测。此外,现有推荐系统多采用通用推荐策略,缺乏对考生个性化需求的深度挖掘。未来需结合考生风险偏好(保守/冲刺型)、职业规划等信息,实现更精准的个性化推荐。

六、结论

Hadoop、PySpark与Scrapy爬虫技术的融合应用,为考研分数线预测提供了高效、精准的解决方案。通过分布式爬虫采集多源数据,结合分布式存储与计算框架实现数据清洗与特征工程,最终构建高精度预测模型。实验结果表明,该系统在预测精度与效率上显著优于传统方法,为考生提供科学决策支持的同时,也为教育大数据分析提供了新范式。未来研究可进一步探索多模态数据融合、实时预测与个性化推荐技术,以应对考研竞争的动态变化。

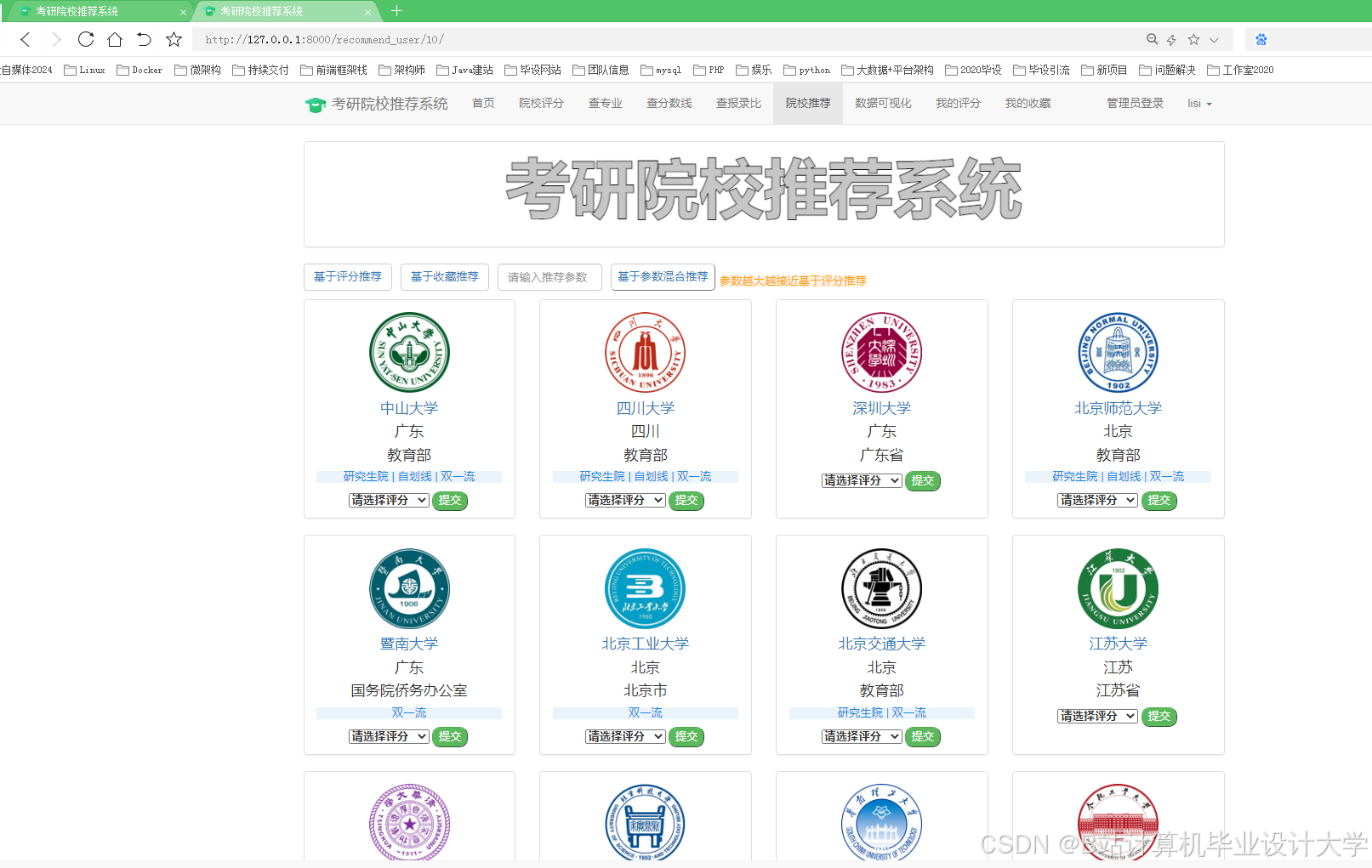

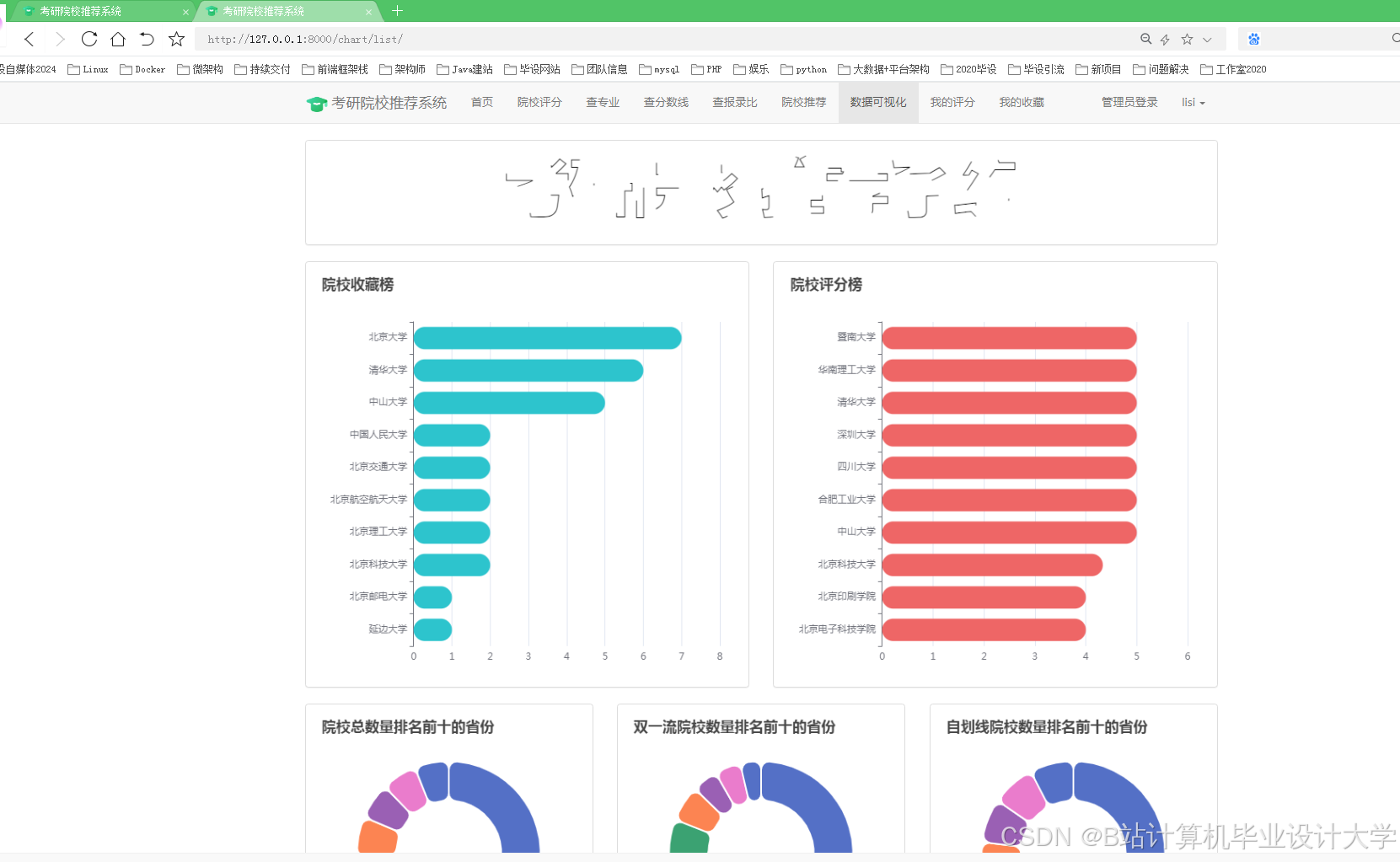

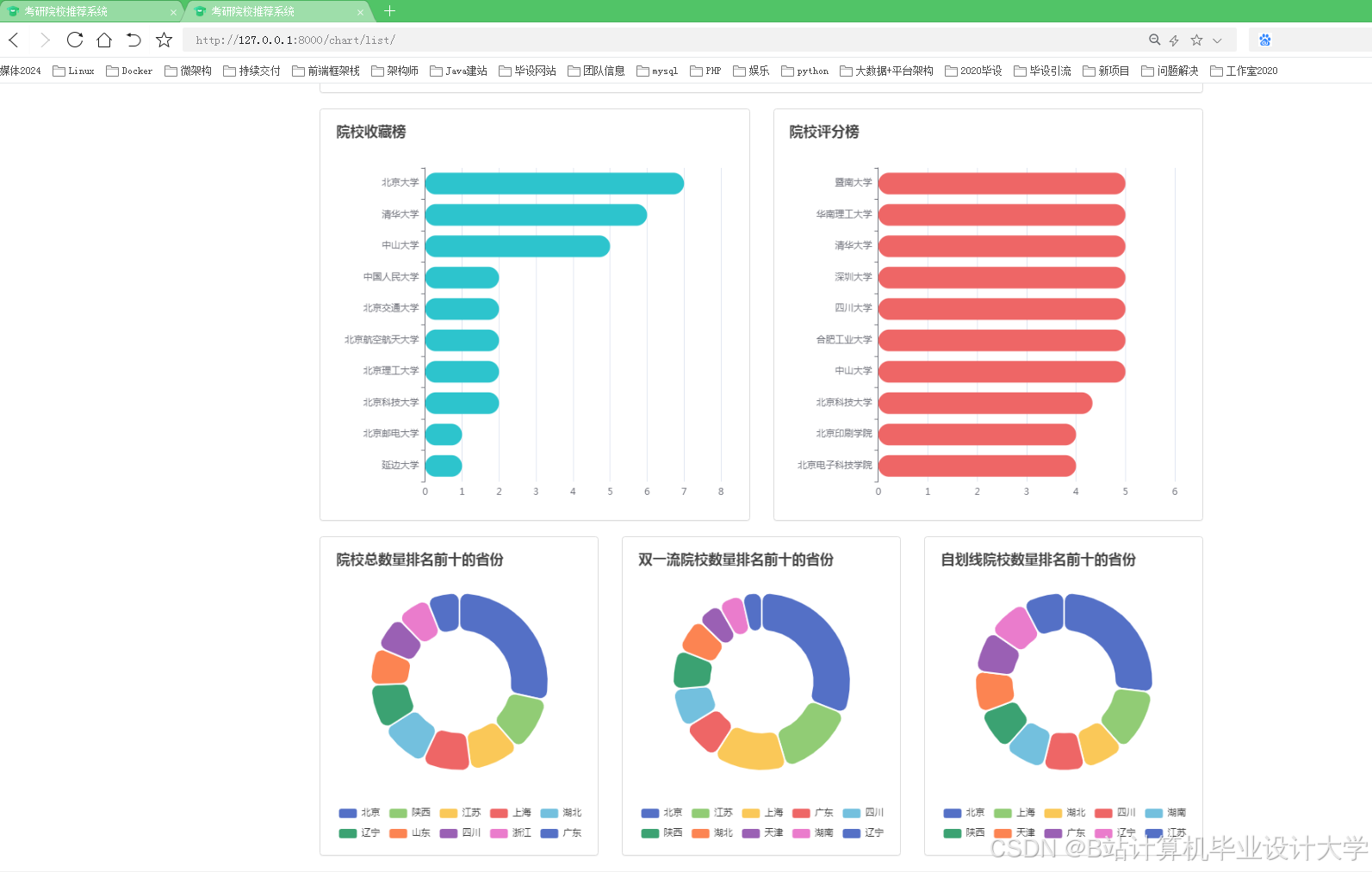

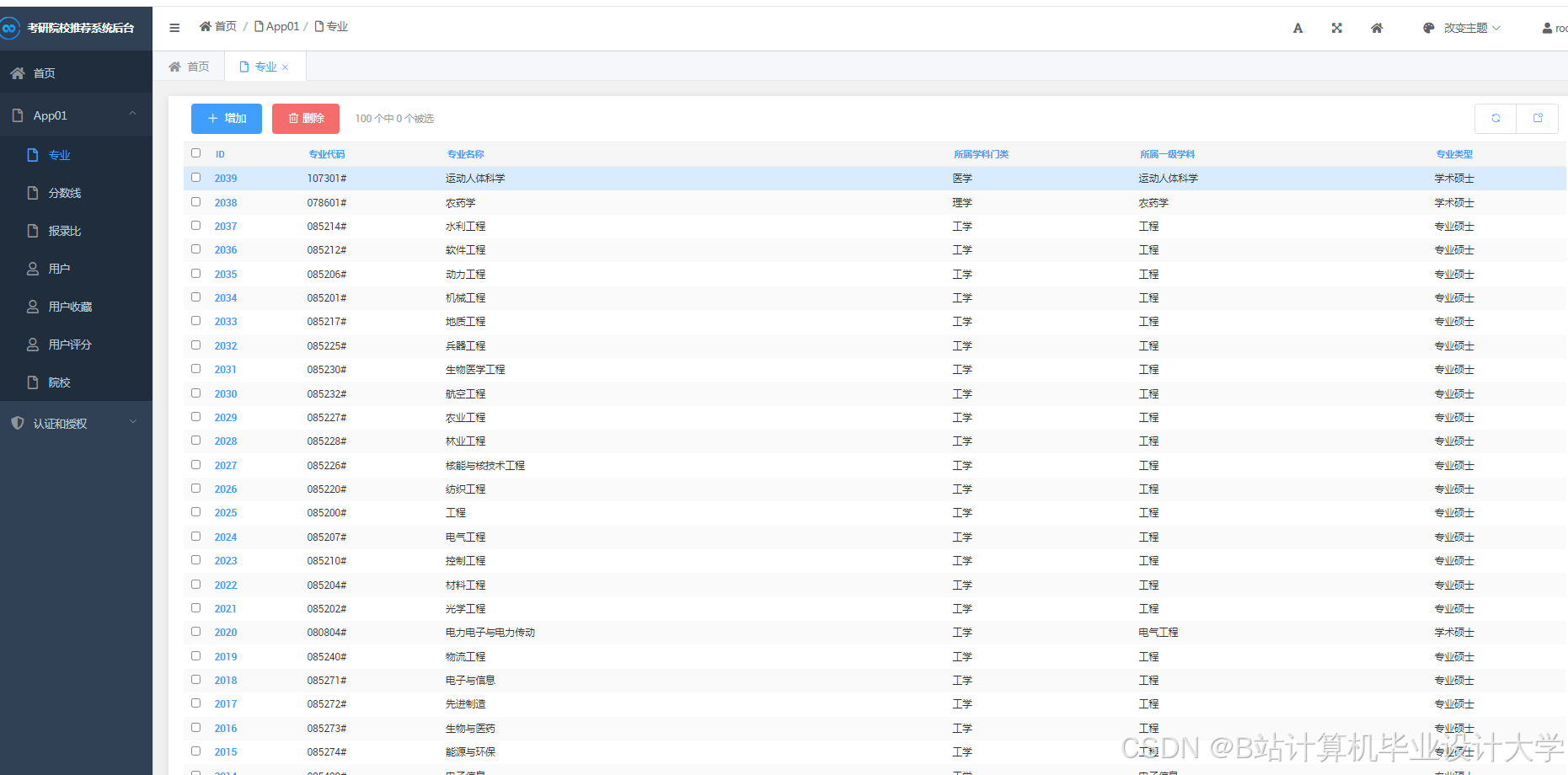

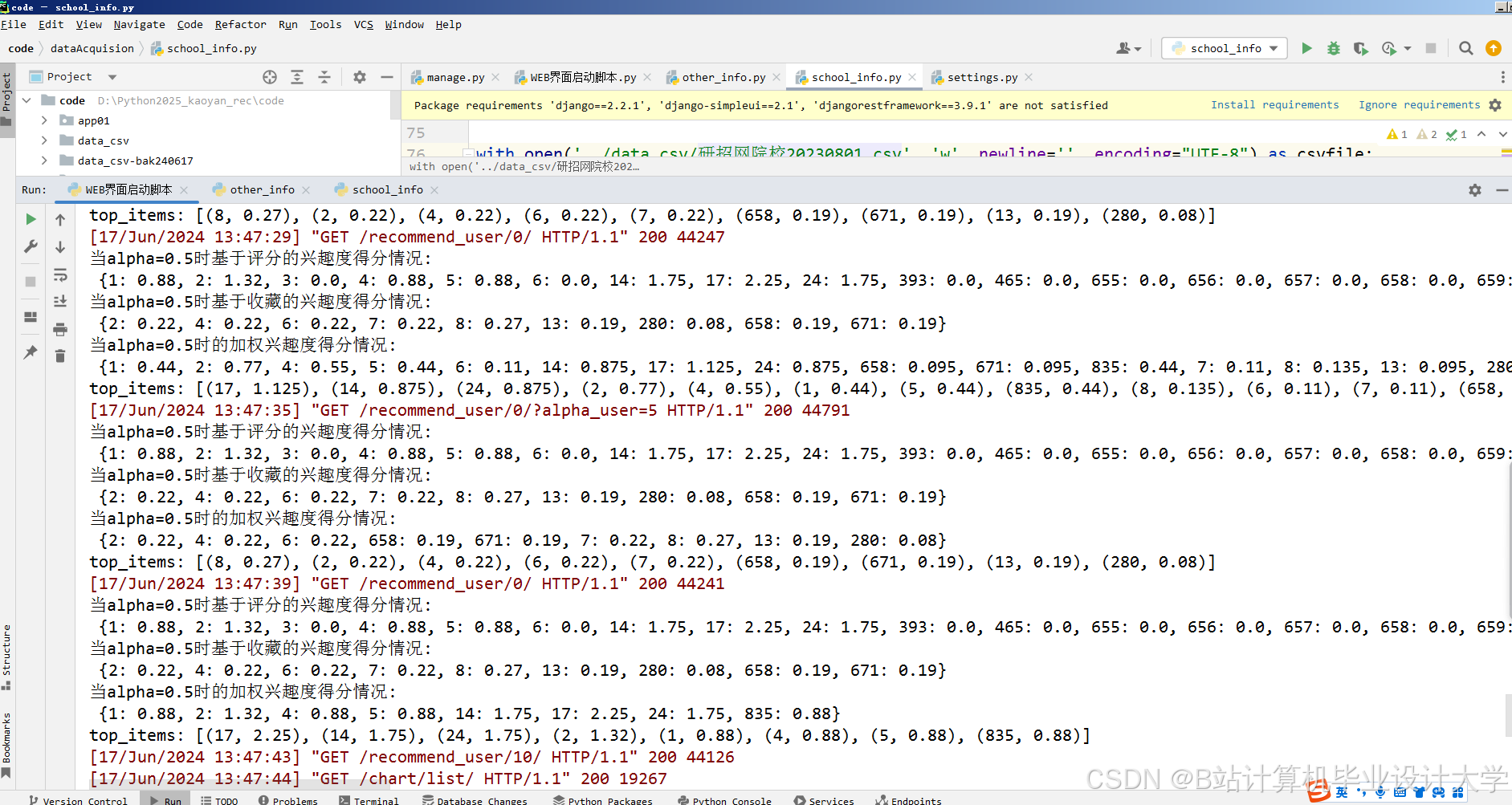

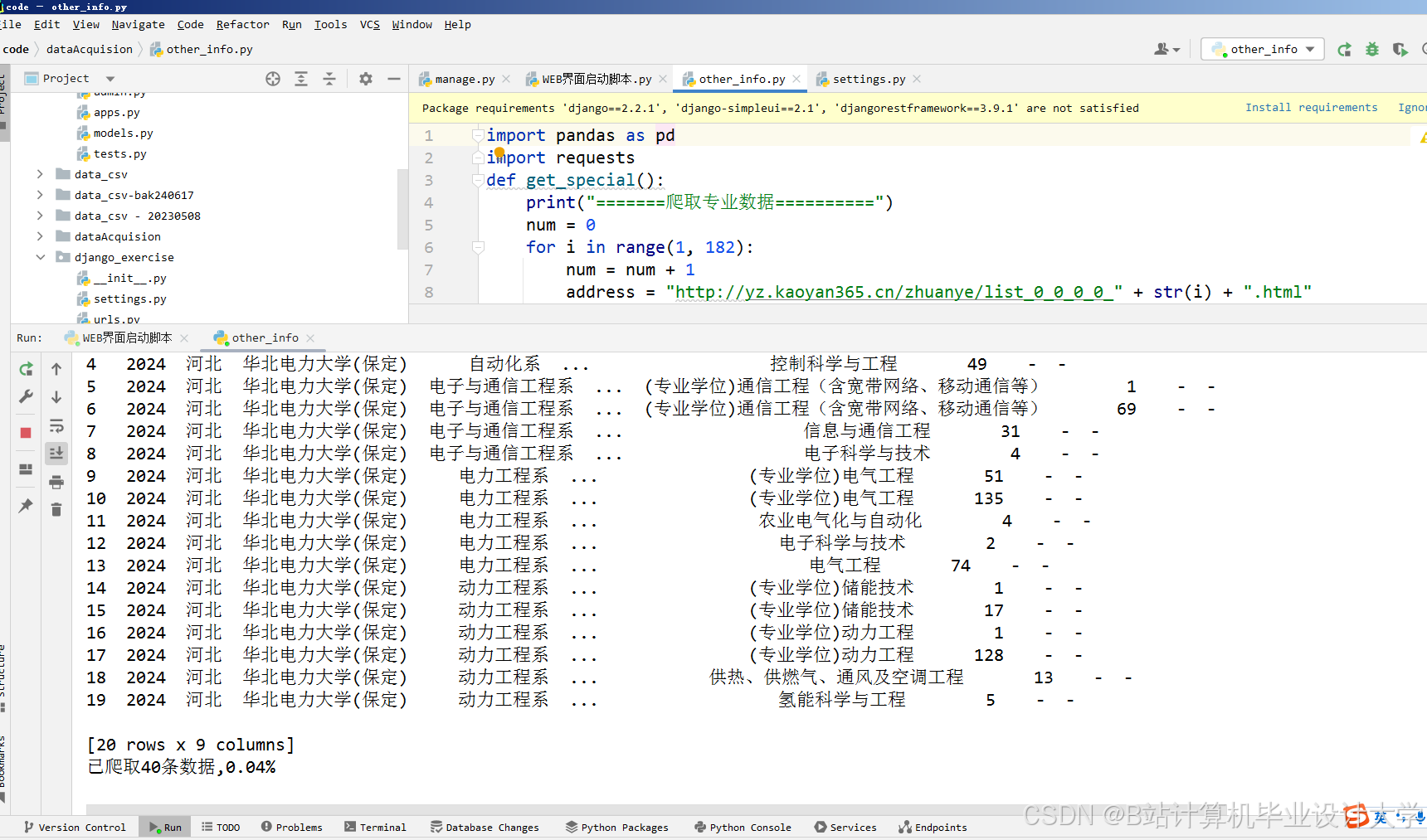

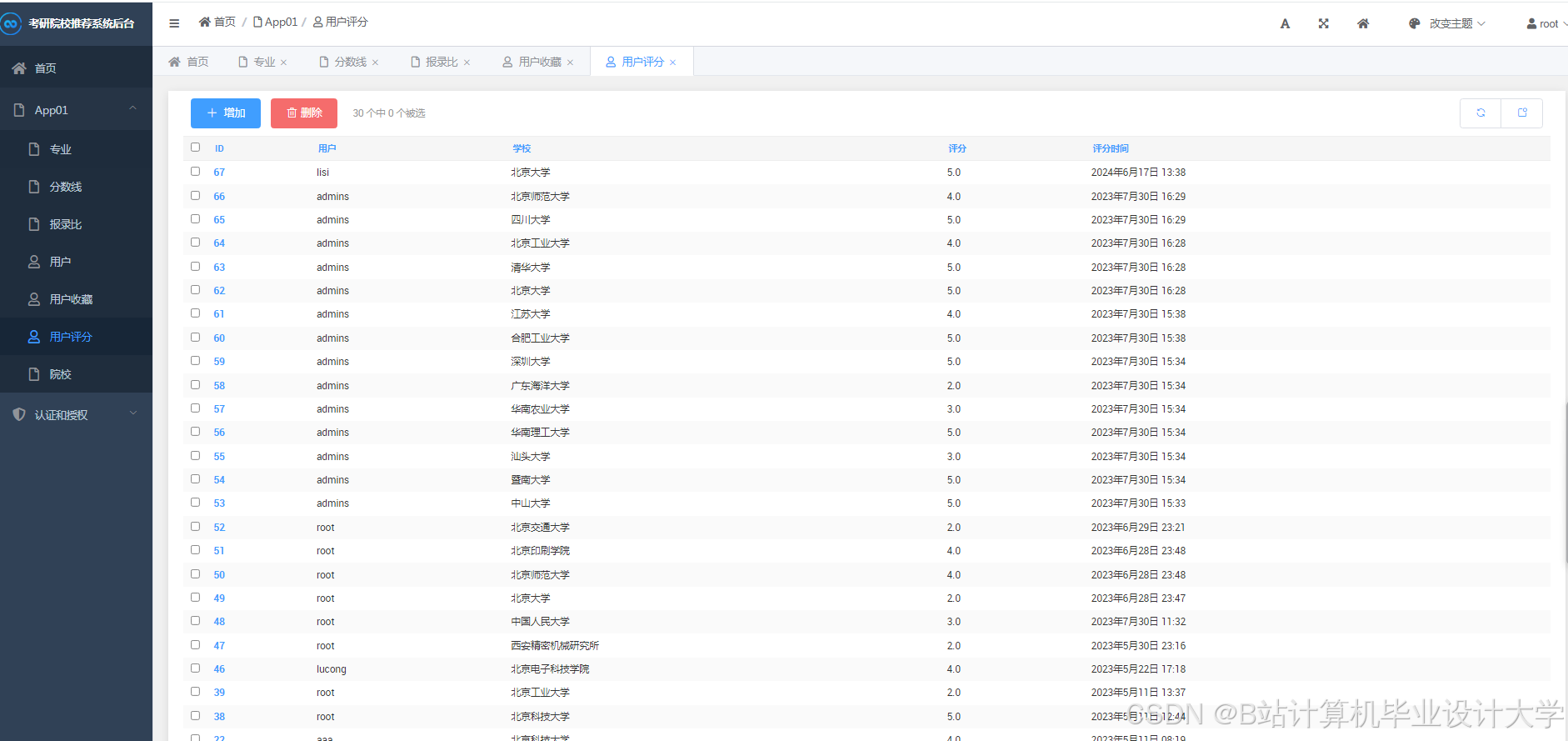

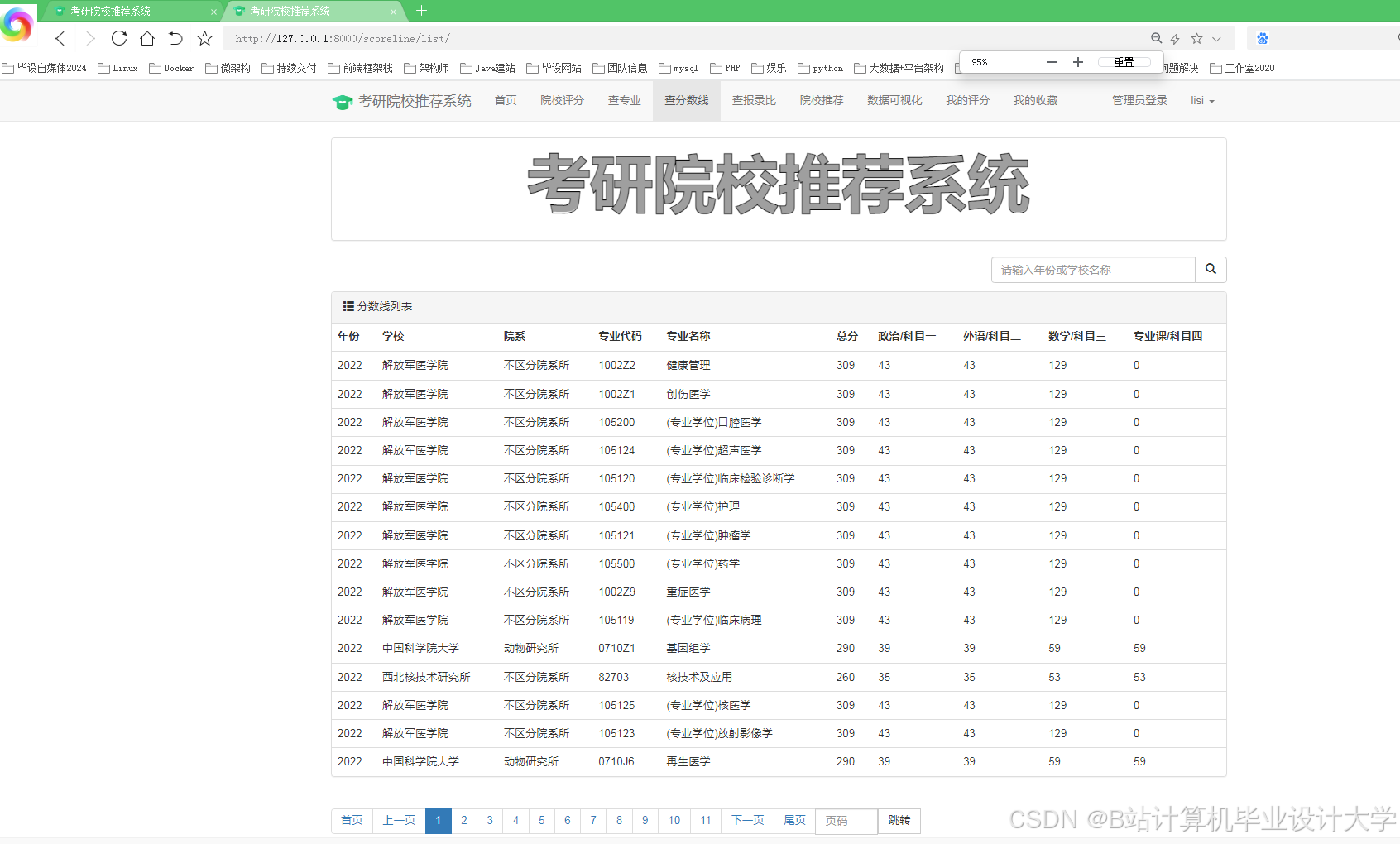

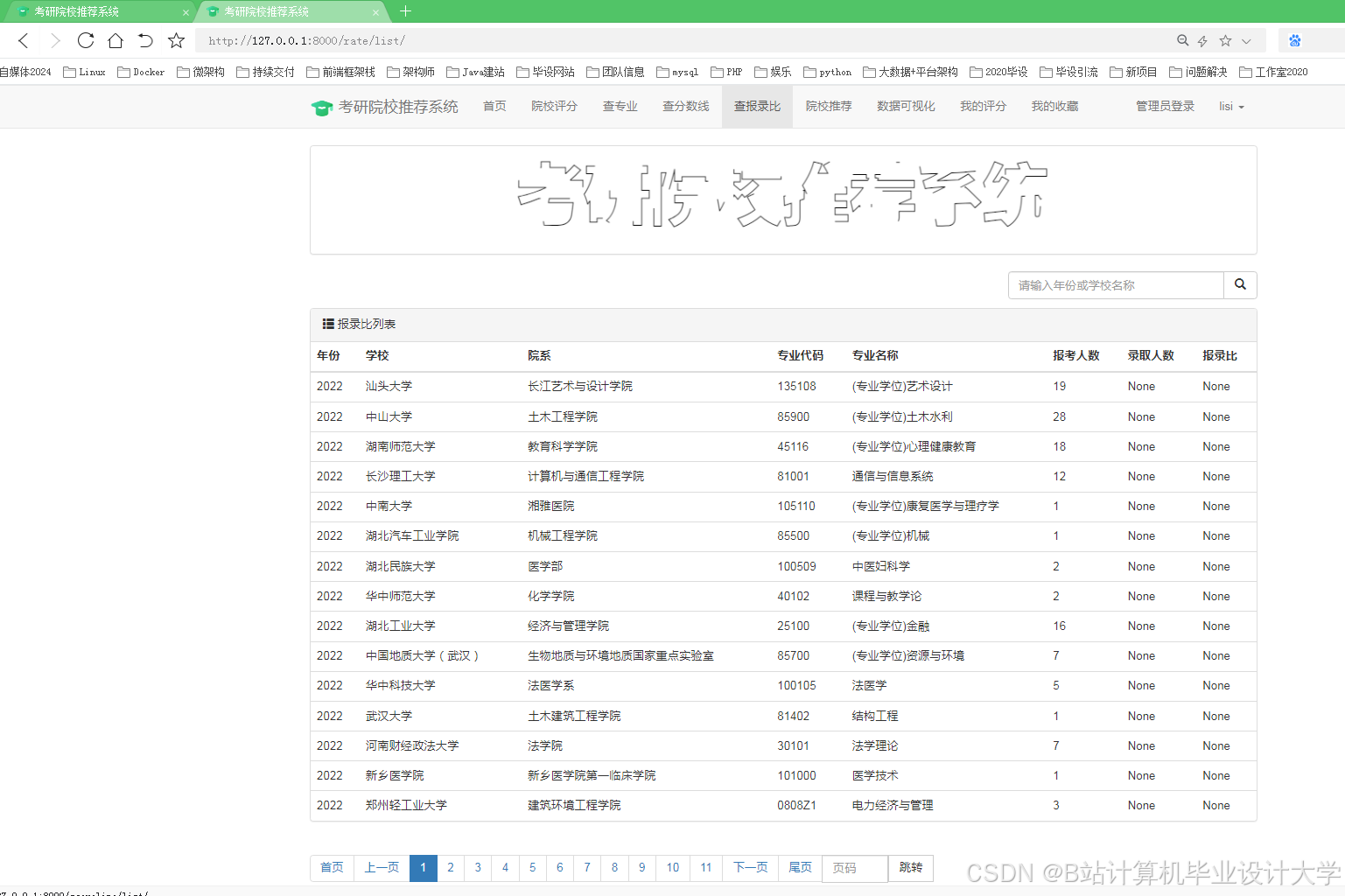

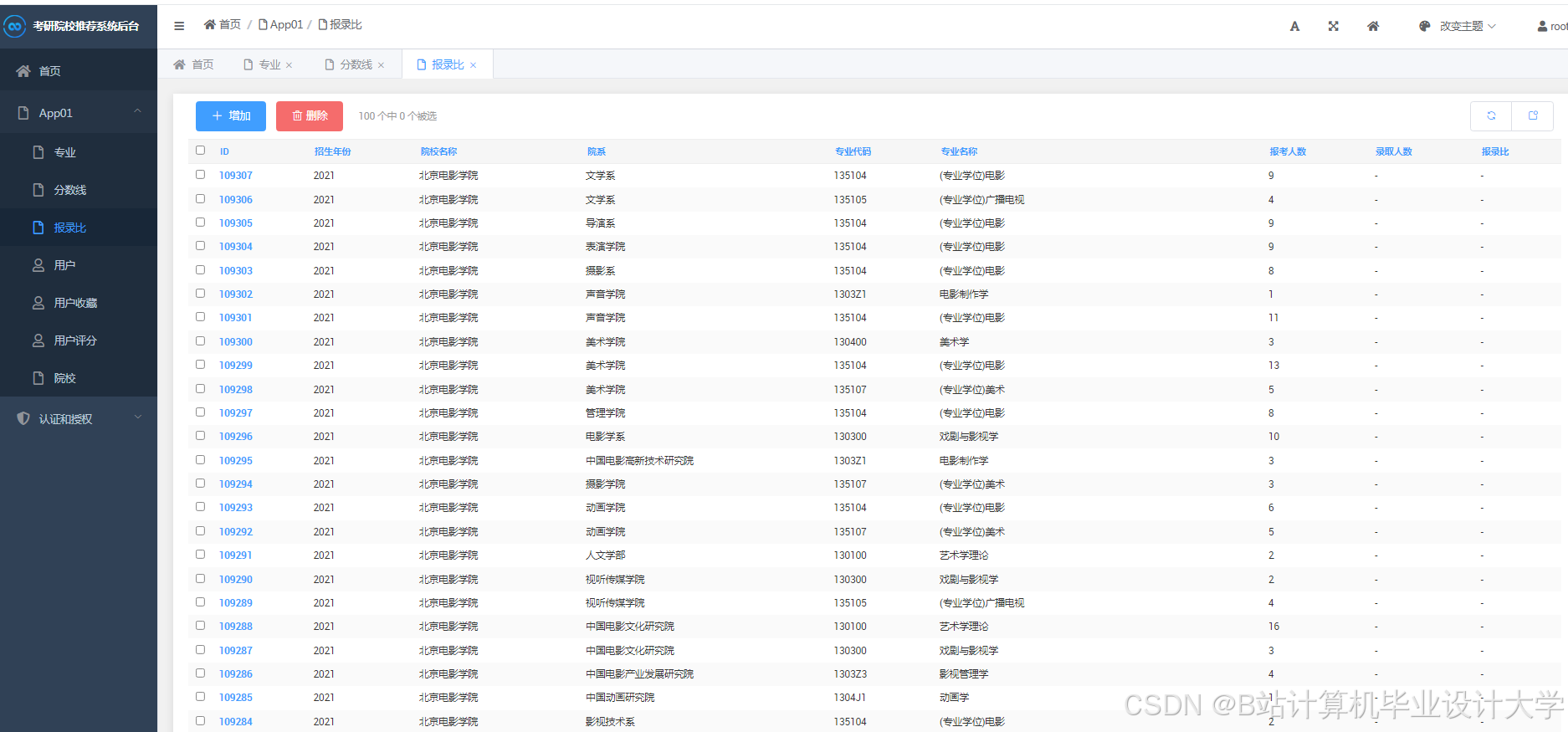

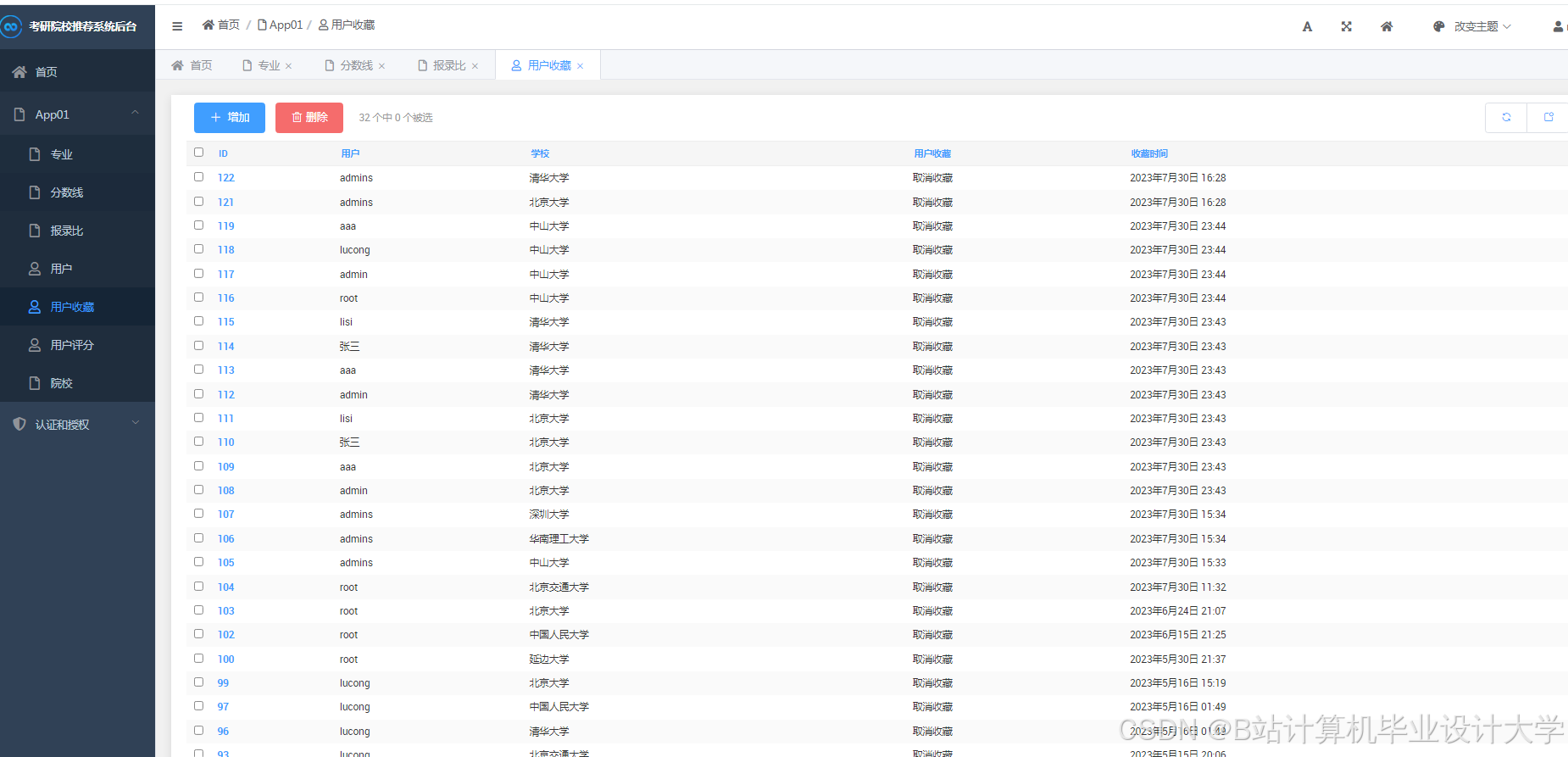

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

265

265

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?