📝 面试求职: 「面试试题小程序」 ,内容涵盖 测试基础、Linux操作系统、MySQL数据库、Web功能测试、接口测试、APPium移动端测试、Python知识、Selenium自动化测试相关、性能测试、性能测试、计算机网络知识、Jmeter、HR面试,命中率杠杠的。(大家刷起来…)

📝 职场经验干货:

目前AI生成测试用例已经聊了一段时间,但绝大多数同学还停留在浅层次调用以及包壳产品上,这样的使用方式必然导致生成测试用例质量差等问题。

基于我们团队的深度实践,总结一下当前的痛点问题和解决方式。

痛点一:领域知识缺失

核心策略:构建业务认知引擎

-

知识库分层建设

- 业务层

整理核心业务流程规则(如订单状态机)、关键业务术语表(金融领域需包含清算/轧差等术语),产出结构化文档

- 测试层

沉淀行业通用测试模板(如支付功能的等价类划分)、历史缺陷模式库(如并发场景下的数据不一致案例)

- 项目层

整合当前版本需求文档、接口契约、环境配置约束

- 业务层

-

轻量级RAG部署

-

中小企业采用开源方案:ChromaDB(向量库)+ (关键词检索)

-

每周人工验证召回准确率,目标>70%

-

需求文档预处理:通过文本分割将PRD拆解为功能点单元

-

混合检索策略:同时使用关键词匹配(召回基础概念)与语义搜索(捕捉关联场景)

-

痛点二:输入数据低质(垃圾进,垃圾出)

核心策略:数据治理

-

需求结构化

-

所有需求需包含

场景-条件-动作-结果四要素 -

规则:加入需求规范检查

-

-

用例库标记清洗

去重:基于语义相似度合并重复用例(阈值设定70%)

失效检测:关联需求管理系统,自动标记已下线功能用例

有效性评估:关联缺陷系统,保留近半年发现缺陷的用例

知识标记:人工标注高频复用场景用例(如用户登录组合异常)

-

知识显性化机制

定期举行“领域知识工作坊”:业务专家口述,测试人员记录成规则条目

建立知识卡审批流:新增条目需经开发/测试/产品三方确认

痛点三:AI生成幻觉

-

精准Prompt设计规范

-

-

[角色] 电商结算系统测试专家

-

[任务] 为{功能点}生成{测试类型}用例 -

[重点] 覆盖{业务规则1}/{业务规则2} -

[输出] 表格含:前置条件/测试步骤/预期结果/优先级

-

[约束] 排除{基础流程},优先{高风险场景}

-

Prompt修改可形成提示词库

2.人机协同工作流

AI生成初稿->业务专家校验业务逻辑->测试工程师补充异常场景->自动化冒烟测试

3.质量门禁规则

规则1:涉及资金/安全的用例必须人工双签

规则2:新功能首轮测试AI生成用例占比≤30%

痛点四:场景覆盖不全

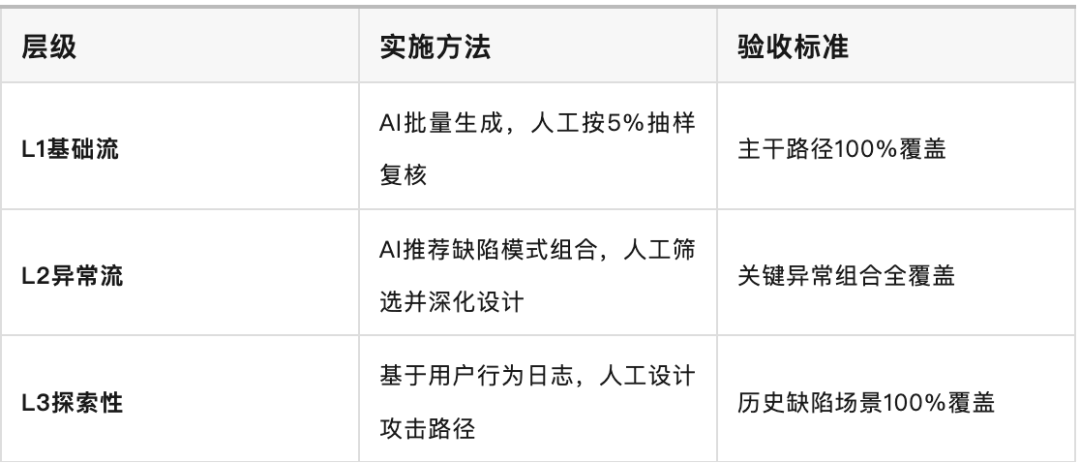

分层覆盖度保障机制

-

每日生成覆盖率报告:统计需求条目/代码分支/业务规则的覆盖状态

-

红黄绿灯看板:

-

绿灯:AI覆盖且通过验证

-

黄灯:人工补充覆盖

-

红灯:未覆盖的高风险区域

-

痛点五:知识更新延迟

动态同步方案

-

遗留系统处理

-

逆向工程流程:

日志分析 → 提取高频接口 → 生成API快照 → 人工补全业务语义 -

产出物:《遗留系统关键接口清单》(含业务说明/风险提示)

-

-

变更响应机制

-

需求变更:触发知识库更新任务(责任人24小时内完成)

-

代码提交:关联影响分析,自动标记需更新测试用例

-

生产问题:48小时内生成回归用例并加入基线

-

-

资产版本控制

-

知识库/Prompt模板纳入Git管理

-

发布流水线自动打标签

-

痛点六:上下文限制

分段生成实施流程

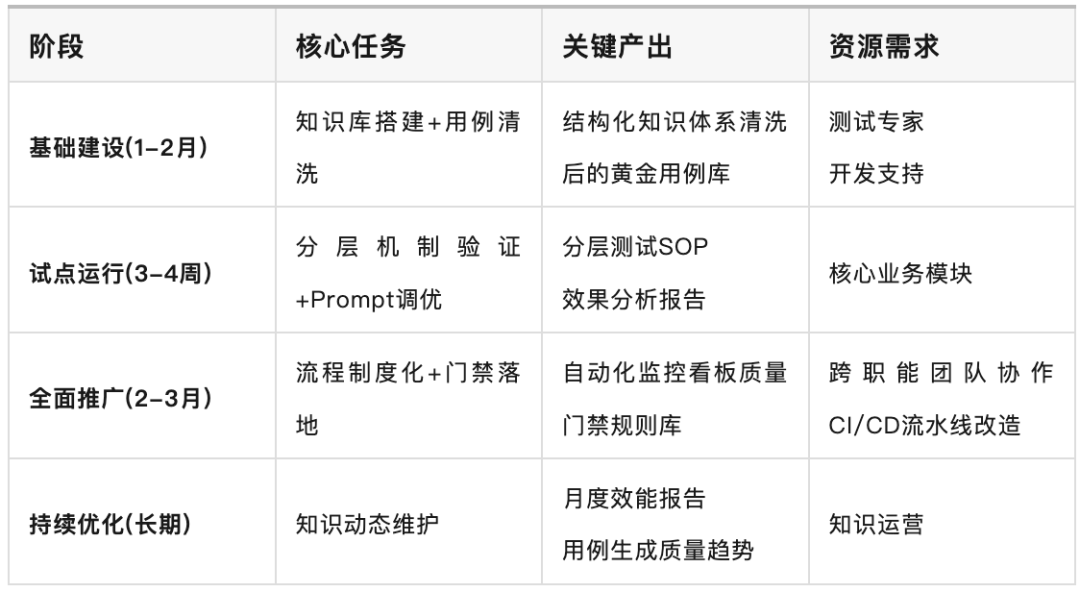

实施路线图与资源规划

效能指标:

-

目标1:AI生成用例采纳率≥70%(人工修改率≤30%)

-

目标2:测试设计效率提升3倍(测量单位:用例/人日)

-

目标3:上线缺陷率下降50%(对比基线版本)

最后: 下方这份完整的软件测试视频教程已经整理上传完成,需要的朋友们可以自行领取【保证100%免费】

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?