目录

1.1 1970s–1990s:机器人早期起源——“我碰到了什么?”

1.2 1990s–2010s:触觉开始走向任务——“我能抓稳它吗?”

1.3 2010s–2025:视觉-触觉时代到来——“摸得像人一样”

机器人产业:正在集体“绕过”触觉

——共识

半个世纪以来,机器人始终在努力获得一双“真实”的手。然而一个残酷的事实是:当前展示的绝大多数“灵巧手”,实质是预编程轨迹的“假手”——

这暴露了一个核心矛盾:

机器人系统的运动与感知能力进展迅速,但其与物理世界进行精细交互的执行终端,发展严重滞后。

面对这一核心短板,所有本体厂商都明白了下一个战场:灵巧手。宇树、智元、特斯拉……纷纷重金投入,要给自己造出真正的手指。

然而,资本市场的叙事逻辑往往更加超前:

它已经越过尚在攻坚的“手”,直接锚定了一个更底层、更终极的愿景——让机器拥有“触觉”。

在操作还只能颤颤巍巍的时候,资本市场就已为“触觉”这个瞬间的感知,提前支付了上万亿的狂热估值。

▲图源网络

然而,狂热的估值无法替代扎实的技术演进。

在愿景与现实之间,横亘着“触觉”技术自身长达半个世纪的、充满反复与停滞的发展历程。

因此,本文将搁置喧嚣,回归技术演进的本源,系统审视触觉感知领域的研究轨迹、核心挑战与范式迭代。

我们旨在厘清几个根本问题:

触觉技术本身经历了怎样的发展阶段?

其从实验室走向实际应用的核心瓶颈究竟何在?

以及,它如何能切实地、而不仅仅是概念上,成为下一代机器人物理智能的基石?

理解其过去与现状,是理性定义其未来的唯一前提。

01 触觉机器人50年进化史

1.1 1970s–1990s:机器人早期起源——“我碰到了什么?”

在最早期,触觉系统非常简单,机器人能做的事情也只有一件:

确认有没有发生接触。

早期触觉传感器本质上就是一张“压力垫子”,只有粗糙的开关结构:

-

按下 = 有接触;

-

松开 = 没有接触。

听上去很原始,但这就是机器人触觉的起点。

这个时期的机器人靠的是“纯机械联动,没有主动反馈”——

机器人碰了东西,人只能靠视觉看 “有没有碰到”,没法 “感觉” 到力度,更别说分辨其形状、材质。

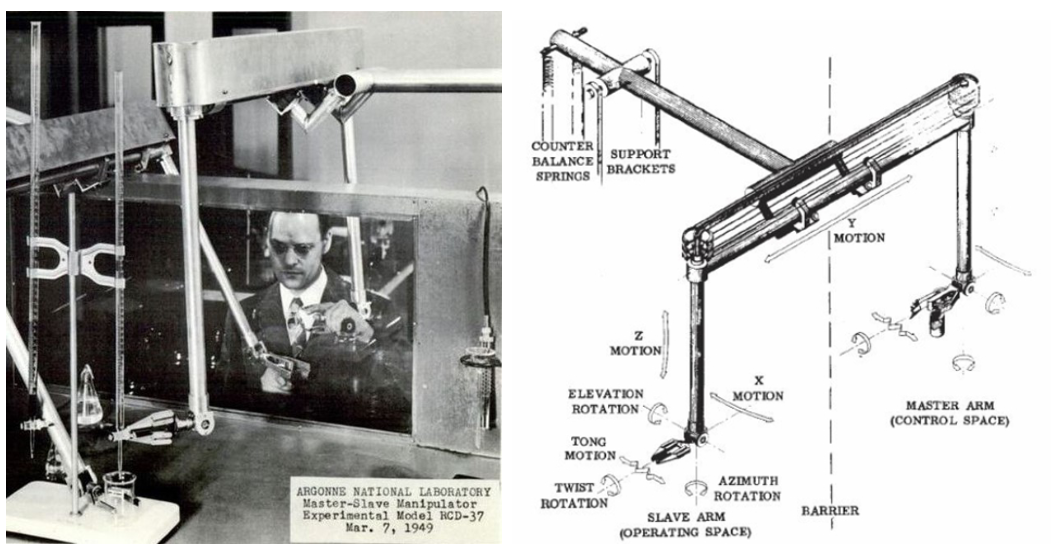

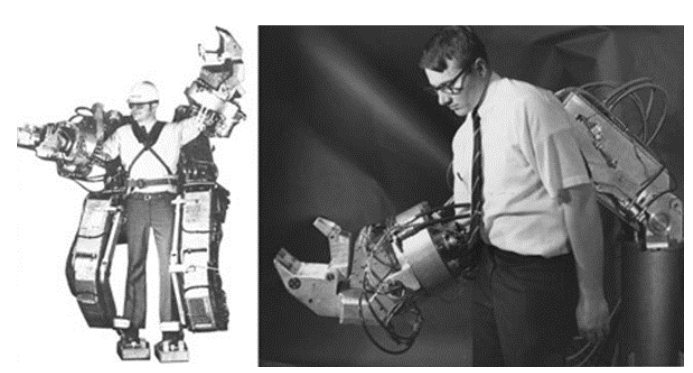

▲图1|早期远程操作机械臂的雏形。左图为1949年诞生的机械式遥操作系统,右图展示此类古早机械臂的双边控制结构——主操作臂和从动臂会同步运动。这类系统奠定了后续触觉与操作反馈研究的基础

尽管如此,这些简单的传感器已经能帮助机器人避免碰撞、确认接触,成为工业机器人时代最基础的安全保障。

1.2 1990s–2010s:触觉开始走向任务——“我能抓稳它吗?”

进入 21 世纪后,触觉从“存在感知”迈向“操作辅助”。

学界和工业界开始关心一个更具体的问题——

机器人能不能靠触觉抓稳物体?

▲图2|左图是五十年前的早期动力外骨骼实验,若要驱动手指抓握,需要整套穿戴操作;右图展示了当时笨重的机械臂和带力反馈的抓取装置。别看它像“工业怪兽”,今天人形机器人上灵巧的五指机械手,正是从这样的庞然大物一路进化而来——也由此能感受到触觉机器人领域这几十年到底经历了多大的飞跃

这个时期出现了两类重要技术:

(1)触觉阵列

它能提供二维压力分布,就像一个低分辨率的“触觉相机”。虽然图像很模糊,但已经能判断:

-

一是否出现滑动、抓取是否稳定:

理想触觉传感器的核心目标是测量接触力变化,包括切向力、滑动状态,确保物体安全抓取。

触觉阵列能提供 “接触状态特征”,包括滑动、抓取阶段转换(如从 “接触” 到 “稳定抓取”),解决了传统力传感器 “只能测力度、无法判状态” 的缺陷。

-

二是力分布是否均匀

触觉阵列的优势是 “能区分单点力与面分布力”—— 比如抓取鸡蛋时,阵列可检测到 “某区域压力过高”,从而指导机器人调节抓手力度,避免压碎物体。

机器人第一次能做出更精细的操作,比如调节抓手力量、避免打滑。

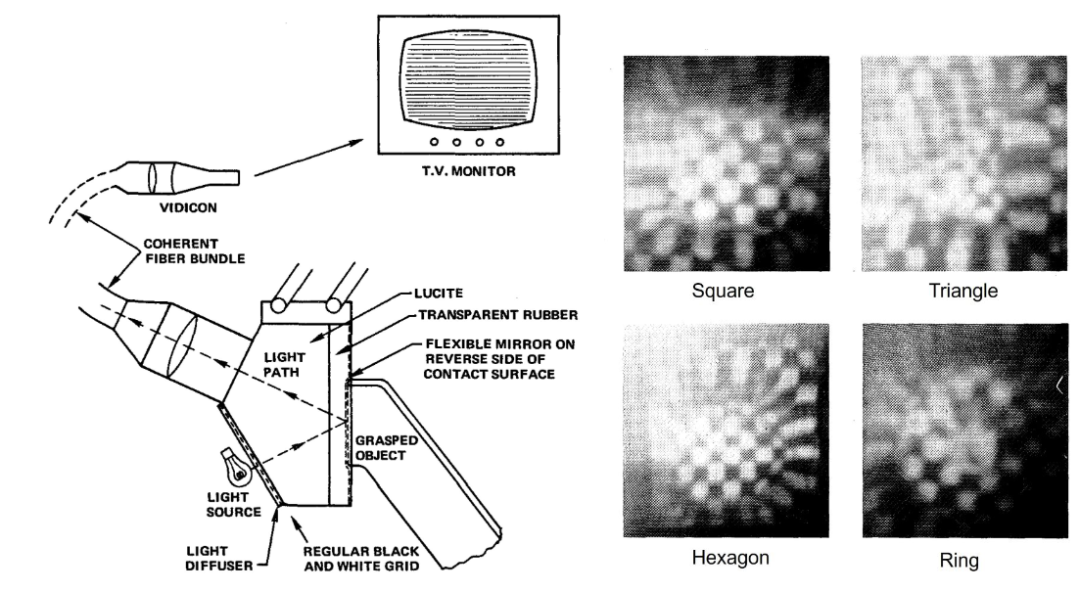

▲图3|MIT发明的光学触觉原型系统。左侧示意如何通过光纤束和柔性镜面记录触觉压痕;右侧展示不同形状物体的触觉图像。该系统能将触觉“转成一幅画面”,供人工观察,是最早的视觉触觉概念之一

(2)更成熟的柔性、嵌入式触觉材料

早期传感器多为刚性结构,要么无法适配复杂形状物体,要么在工业环境中易磨损、易受油污干扰。

而这一时期的柔性、嵌入式材料,本质是解决了 “传感器与环境 / 物体的适配性” 和 “实际场景耐久性” 两大核心问题。

——可以说,这是触觉走出实验室、走向真正有用的关键十年。

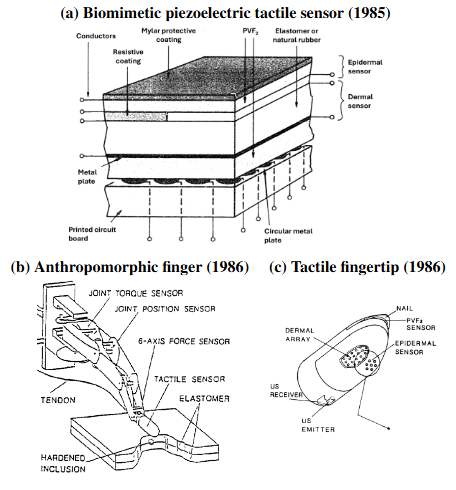

▲图4|上世纪 80 年代的仿生触觉皮肤与指尖设计。(a) 模仿表皮/真皮结构的分层触觉皮肤(基于 PVF2 压电材料)。(b)-(c) 具有人类手指结构的仿生触觉指尖。这些设计首次尝试让机器人“像人一样触摸”

1.3 2010s–2025:视觉-触觉时代到来——“摸得像人一样”

过去十几年,触觉机器人之所以能实现质变,核心是 “视觉式传感 + 深度学习” 的双重突破 ——

-

前者让触觉 “看得见”

随着视觉式触觉传感器的出现,触觉变得前所未有地清晰、细腻、可成像。

当指尖接触物体时,柔性材料会随压力变形,摄像头实时捕捉变形纹理(比如凹陷形状、光影变化),再通过图像反推接触状态;

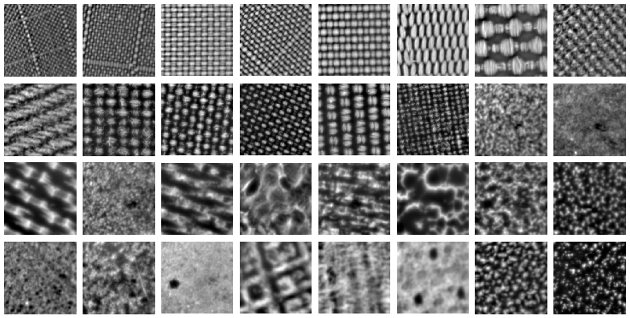

▲图5|触觉传感器“看到的”画面。在触觉传感器内部放置摄像头,能够在传感器接触到物体拍摄到高分辨率的物体表面材质图像,以及其在接触后的纹理变化,这种视觉上的形变能够间接反映出触觉信息

-

让触觉 “读懂” 数据

如果说视觉式传感器是 “数据采集器”,深度学习就是 “数据解码器”,彻底改变了触觉的解读方式——不再只用“计算几何”,而可以直接从触觉图像中预测:

接触力(多大劲不压碎物体)、表面纹理(棉 / 麻 / 塑料)、局部形状(球面 / 平面 / 棱角)、滑动趋势(是否要掉)、抓取稳定性(是否握牢),实现 “感知 - 预判” 闭环。

这让机器人第一次拥有了真正意义上的“高分辨率触觉感知”。

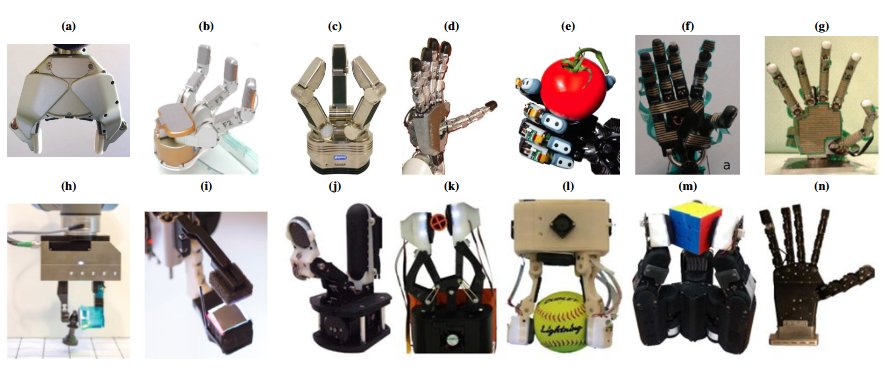

▲图6|触觉机器人手从 2000 年代到 2020 年的演进。上排是 2000–2010 年代表性触觉机械手,如 PR2、iCub、Shadow Hand 等,使用电阻、电容或压阻式传感阵列;下排是 2015–2020 年的新一代视觉触觉手,搭载 GelSight、TacTip 等高分辨率传感器,使机器人能“像人一样”通过指尖感知形状与纹理。这组图展示了触觉从低分辨率阵列走向视觉触觉时代的跨越

由此可见,触觉领域已满足大模型突破的关键前提 ——

统一高维数据形式 + 核心场景刚需 + 技术协同成熟,是具身智能中最易复刻视觉大模型成功路径的领域。

但,触觉大模型无需像视觉、语言大模型那样追求 “通用认知”,而是聚焦 “物理交互通用能力”—— 比如无论抓取纸箱、易碎品还是工具,都能通过触觉数据自适应调节。

这种 “窄而深” 的场景特性,反而容易快速形成技术闭环,率先实现突破。

02 触觉能感知什么?

在触觉机器人发展的历程中,它一直都在尝试回答六个最基本的问题。

它们几乎覆盖了我们人类借助触觉能做的所有事情,也是未来具身智能操作能力的基石。

Q1:“有没有碰到?”——触觉最原始但最重要的能力

这决定了机器人能否安全地和世界互动。

例如外科手术机器人,若没有精确的触觉反馈,可能因毫厘误差而造成严重损伤。

Q2:“碰到哪里?”——触觉告诉机器人接触的位置

机器人若想具备相同能力,需要知道触觉发生的具体位置,而不是只知道“碰到了”。

比如你摸手机侧边寻找音量键,你的手指自动在边缘搜寻。

Q3:“用了多大力?”——力觉与应力分布

这是机器人稳定抓取的核心。

过大:会捏碎物体;

过小:会滑落。

无论是夹取玻璃杯还是拧紧瓶盖,都离不开准确的力控制。

▲AnyRotate: Gravity Invariant In-Hand Object Rotation with Sim-to-Real Touch

Q4:“物体大概什么形状?”——触觉版 3D 重建

现代视觉触觉传感器能从指尖的一次触碰中重建局部几何形状,让机器人在黑暗中也能“看到”物体。

▲Rotatelt: General in-hand objectrotation using vision and touch

Q5:“是什么材质?”——纹理与材料识别

粗糙还是光滑?金属还是布料?干燥还是湿滑?

这对机器人处理未知物体、完成家庭任务有决定性意义。

Q6:“接触如何变化?”——滑动、摩擦、振动等动态触觉

这是实现灵巧操作(dexterous manipulation)的关键。

拧瓶盖、系鞋带、插 USB、弹吉他……

这些动作都依赖动态触觉反馈。

未来的具身智能机器人若想具备人类级的操作能力,这一类触觉感知能力必不可少。

03 触觉对具身智能的重要性

部分人认为:触觉不仅是一个传感器问题,更是具身智能机器人走向现实世界的关键能力。

视觉能看到世界,但触觉告诉机器人“如何接触世界”

毕竟视觉再强,也绕不开 5 个致命短板 —— 遮挡、光照反射、透明物体、小物体识别、深度误差,这些都是具身智能机器人 “看得到却做不对” 的高频失败场景。

触觉给机器人提供了一种“近距离真相”——

只要摸到,就能确认它是什么、在哪里、有什么属性。

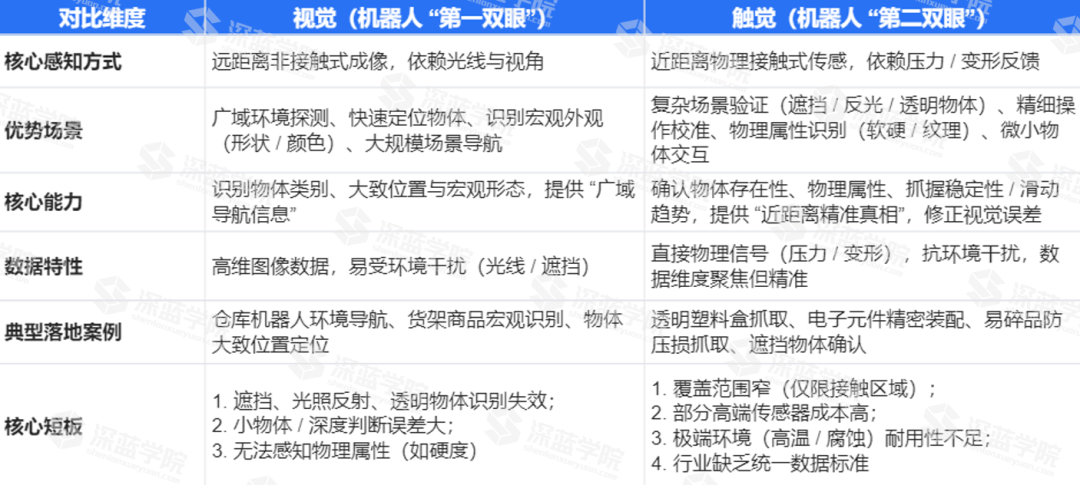

▲图7|基于视觉视觉 vs 触觉核心能力对比表

这或许正是视觉永远无法完全替代的能力。

具身智能需要“操作闭环”,触觉是最可靠的反馈信号

因此,触觉的价值,正是填补视觉的盲区,让闭环形成 “反馈 - 修正” 的循环。

你能成功夹娃娃,是因为你在过程中不断调整力道,而不是靠“看图说话”。

同理,大模型想真正操纵现实世界,也必须具备:

视觉 → 决策 → 动作 → 触觉反馈 → 再决策

这是一个完整的感知–行动闭环,没有触觉,机器人只能“盲目操作”。

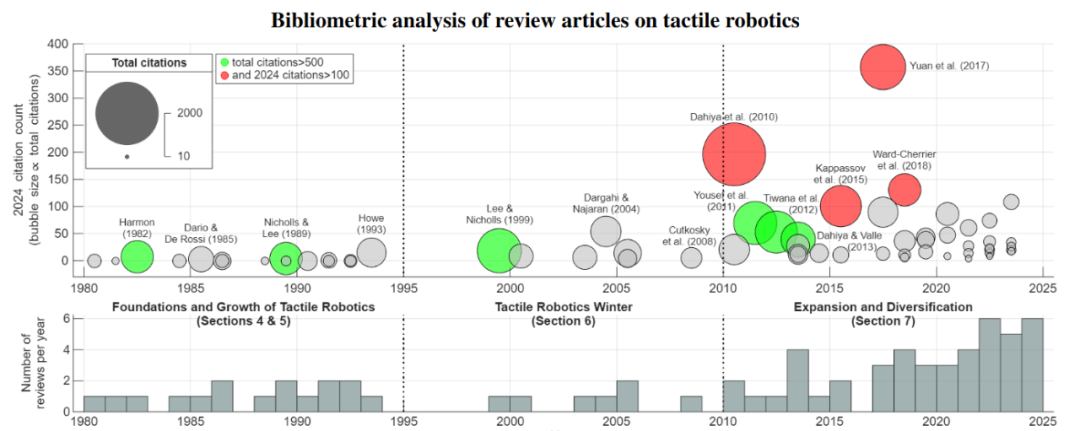

▲图8|触觉机器人 50 年文献影响力分布。每个气泡代表一篇综述论文,高度表示 2024 年引用量,气泡大小对应截至 2024 年的累计引用次数。绿色气泡为累计引用超过 500 次的代表性工作,红色气泡表示既有长期影响又在 2024 年保持高引用的论文。在2020前后,具身智能概念兴起时,机器人触觉方面的相关研究也随之突飞猛进,反映出触觉和具身智能相辅相成的关系

04 触觉机器人下一个十年

不过,当资本为“触觉”的未来狂欢时,机器人产业应该直面一个更根本的命题:它的核心使命是,如何在现实世界中可靠地完成任务?

而当前绝大多数成功的应用证明,这一使命对复杂触觉的依赖,远不及对稳定运动、环境理解与鲁棒策略的需求。

工程上,通过视觉、柔性设计或流程优化(例如用吸盘代替抓取),足以巧妙绕过大多数伪“触觉”场景。

也就是说,触觉——往往只用于优化那最后1%的极限操作体验。

为了这1%的体验,资本愿意为愿景支付万亿,但消费者只愿意为结果支付千元……

然而,这1%恰恰是区分“功能”与“智能”的关键所在。在那些无法被简单规则定义、充满物理不确定性的场景中,例如微创手术中辨别组织层次、精密装配中感知微小卡顿——

触觉提供的实时力与纹理反馈,是视觉和算法模型难以替代的终极物理信息。

所以,产业的成熟不取决于追逐技术的所有“可能性”,而取决于清醒界定其真正的“必要性”。

触觉技术的下一个十年,是划定其能力界限的十年。只有明确知道“何时没有它不行”,我们才会真正明白它无可替代的价值……

Ref:

论文标题:Tactile Robotics: Past and Future

论文链接:https://arxiv.org/pdf/2512.01106

1070

1070

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?