导读 近年来,大语言模型(LLMs)因其卓越的推理和理解能力在多个领域取得了显著成就,尤其是在分类、预测和优化等任务上。然而,传统算法(如凸优化和强化学习)常常面临可扩展性问题,特别是在高维度和复杂任务中,往往需要大量的计算和训练周期。相比之下,LLM通过在上下文中进行学习,无需额外的模型训练或参数微调,展现出了更高的灵活性和效率。LLM的这种优势使其在通信环境中具有广泛的应用潜力,尤其是在处理动态变化的网络环境时。 本文提出了一种新颖的优化方法,将LLM与强化学习技术(特别是双深度Q学习网络,DDQN)相结合,旨在联合优化车与基础设施(V2I)通信和自动驾驶(AD)策略。通过使用LLM来支持自动驾驶决策,可以提高交通流量,减少碰撞并确保道路安全;而使用DDQN优化V2I通信,可以最大化数据传输速率并减少频繁的基站切换。这种混合方法能够通过迭代优化,动态地调整AD和V2I的策略,最终实现更高的系统效率和更快的收敛速度。仿真实验结果表明,所提出的方法相较于传统的DDQN方法,具有更高的学习效率和优化性能。

©️【深蓝AI】编译

论⽂题目:Hybrid LLM-DDQN based Joint Optimization of V2I Communication and Autonomous Driving

论文作者:Zijiang Yan, Hao Zhou, Hina Tabassum, Xue Liu

论文地址:https://arxiv.org/abs/2410.08854

1.研究背景

大语言模型(LLMs)作为一种新兴的技术,近年来受到广泛关注,它能够处理多种下游任务,如分类、预测和优化。与传统算法(如凸优化和强化学习(RL))相比,LLM在处理复杂任务时展现了其独特的优势。传统的强化学习常面临大量迭代和采样效率低等问题,而凸优化则需要专门的数学变换来保证问题的凸性。与此相比,LLM启发的优化方法,特别是在上下文学习中的应用,展现了多方面的优势。首先,LLMs可以进行上下文学习,无需额外的模型训练或参数微调,从而节省大量的人力。其次,LLM的上下文优化可以通过调整提示语迅速扩展到新任务或目标,从而快速适应不同的通信环境。最后,LLMs能够为其优化决策提供合理的解释,帮助人类理解复杂的网络系统。凭借这些吸引人的特性,LLMs在优化问题的解决中有着巨大的潜力。

然而,预计6G网络将面临较短的信道相干时间(这是由于较高的传输频率和窄束波)以及对网络服务质量的严格要求,这意味着需要更快的响应时间和更高的智能水平。例如,车与基础设施(V2I)通信与车辆的驾驶行为密切相关,例如频繁的加速和减速可能会导致额外的切换(HOs),甚至可能导致V2I连接中断(如果没有及时处理)。因此,联合优化V2I通信和自动驾驶策略变得至关重要。这种V2I和AD的集成也与国际电信联盟(ITU)定义的6G使用场景相一致。

LLM支持的自动驾驶(AD)已经引起了大量研究关注,现有研究已经利用LLM的推理能力来实现决策支持,并推动了类人驾驶行为的实现。这些研究主要集中在使用LLM进行自动驾驶(AD)的应用,但将LLM应用于联合优化AD政策和V2I通信的问题尚未得到研究。虽然联合优化问题主要通过强化学习(RL)技术来解决,但近期的进展表明LLM技术有着巨大的潜力。因此,使用LLM解决联合V2I和AD问题的性能提升仍然没有被充分探索,特别是提高学习效率和可解释性决策。更重要的是,这种联合优化问题能够更好地展示LLM技术在解决高度耦合的控制问题中的潜力,即LLM可能需要与其他智能体进行交互,以做出全面的决策。

鉴于LLMs的潜力以及6G网络中的挑战,本文旨在利用LLMs联合优化V2I通信和AD策略。具体而言,我们首先使用LLMs进行AD决策,旨在最大化速度并减少车道变换和碰撞。通过利用预训练的现实世界知识,LLMs能够更好地理解复杂的道路环境并快速做出AD决策。我们介绍了基于语言的任务描述、示例设计和基于距离的选择,促使LLMs从先前的经验中学习。与以前的研究不同,本文进一步考虑了LLM与常规RL智能体之间的交互。具体而言,AD决策将被用来优化V2I系统中的基站选择(BSs),以提高数据速率并减少频繁的切换。整个问题将通过迭代优化直到收敛。此联合优化问题和迭代优化方案也可以推广到许多其他实际场景,突显了本文工作的独特贡献。最后,仿真结果表明,所提出的LLM-DDQN混合方法在学习效率和收敛速度上均优于基线方法。

2.系统模型及马尔可夫决策过程

本节介绍了自动驾驶(AD)和车与基础设施(V2I)连接的系统模型,并定义了相应的马尔可夫决策过程(MDP)。MDP是一种很有用的方法,用来定义优化任务,因此我们将AD和V2I任务分别建模为两个MDPs,以便进行优化。

2.1 V2I和自动驾驶系统模型

首先,我们考虑一个下行链路网络,包含了多个射频基站(RBS)和太赫兹基站(TBS)。这些基站用于支持自动驾驶汽车(AVs)的通信。每辆车都连接到一个基站,接收来自网络的数据并收集实时信息(例如速度、加速度、相邻车辆的位置等)。从V2I的角度来看,我们的目标是最大化数据传输速率并减少频繁的切换。而从交通运输的角度来看,我们的目标则是优化车辆的速度,并通过减少碰撞来确保道路安全。 车辆的连接是基于信号质量来选择基站的。如果信号强度低于设定的阈值,车辆会切换到下一个可用的基站。这种频繁的切换会影响数据传输速率,因此需要最小化切换的频率。

2.2 自动驾驶的MDP模型

在自动驾驶的模型中,状态空间表示车辆的运动学特征,包括车辆的坐标(x,y)、速度(v)和航向角(ψ)。每一辆自动驾驶车辆(AV)都在系统中扮演一个角色,并且周围会有其他车辆影响它的决策。 状态: 在每一个时间步,自动驾驶系统的状态由目标车辆的位置、速度、航向等特征组成。同时,还会包括周围车辆的信息,这些信息共同构成了自动驾驶的环境。 动作: 在每一个时间步,车辆可以选择五种不同的动作:加速、保持当前车道、减速、向左换道和向右换道。 奖励: 自动驾驶的奖励主要依赖于车辆的速度、是否发生碰撞以及车辆是否处于正确的车道上。奖励函数中包含多个因素:加速时的奖励会较高,保持较高的速度会增加奖励;如果发生碰撞,则会受到较大的惩罚;如果车辆偏离了最右侧的车道或驶离高速公路,也会受到惩罚。

2.3 V2I的MDP模型

对于V2I模型,我们假设每个基站(RBS或TBS)最多可以支持一定数量的自动驾驶车辆(AV)。在每一个时刻,基站可以为这些车辆提供服务。车辆的连接质量由信号与干扰加噪比(SINR)来衡量,当SINR低于设定的阈值时,车辆会切换到另一个基站。 状态: V2I的状态由每个基站可以服务的车辆数量、可连接的基站数量以及车辆的交通决策等组成。 动作: 在每个时间步,车辆可以选择三种V2I动作之一:选择一个最大化加权数据速率的基站、选择一个基站(如果当前基站过载,则选择下一个可用基站)或者选择信号强度最大的基站。 奖励: V2I的奖励依赖于基站的加权数据速率和切换的频率。选择一个高数据速率的基站可以获得较高的奖励,而频繁切换基站则会因为延迟增加而降低奖励。

3.混合LLM-DDQN双目标优化算法

在这一部分,提出了一种混合LLM与DDQN(双深度Q学习网络)的优化框架,用于联合优化自动驾驶(AD)决策和车与基础设施(V2I)通信策略。整个优化过程是通过两个阶段进行的,其中LLM用于自动驾驶决策,DDQN用于V2I决策。

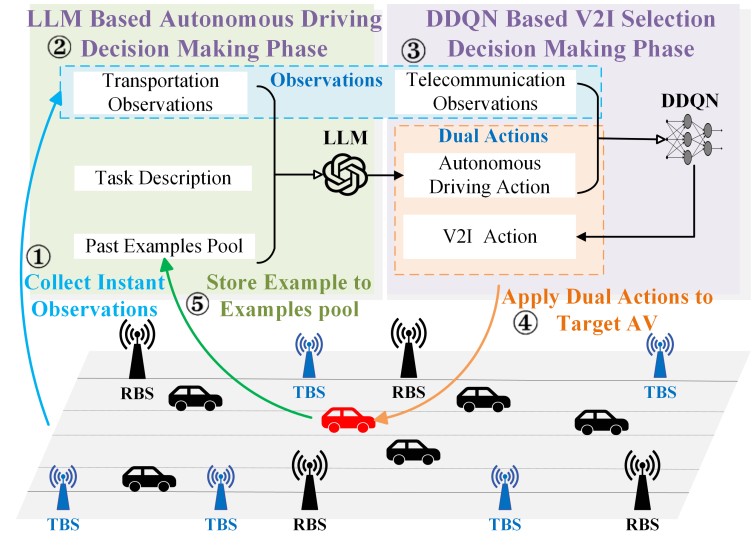

▲图1|混合LLM-DDQN优化算法©️【深蓝AI】编译

3.1 任务描述

在混合LLM-DDQN算法的第一个阶段,使用LLM生成自动驾驶决策。为了使LLM理解任务并做出合理的决策,采用了任务描述、任务目标、任务定义和决策标准等元素。具体来说,LLM接收一个关于自动驾驶任务的描述,并基于环境信息生成合适的驾驶决策。

任务描述示例:任务描述用于定义自动驾驶任务的目标和要求,示例包括:

-

任务描述:“协助驾驶目标车辆在四车道单向高速公路上行驶。”

-

任务目标:最大化目标车辆的速度,同时尽量减少碰撞。

-

除非出于安全原因,否则减少不必要的车道变换(如向左或向右换道)。

-

在安全的情况下,尽量保持车辆在最右侧车道上行驶。

-

任务定义:任务定义包括对车辆状态特征的描述,如车辆的横向偏移(x)、纵向偏移(y)、横向速度(vx)、纵向速度(vy)等。

LLM通过分析先前的驾驶经验,生成适合当前环境的动作。具体地,LLM会基于“良好示例”和“不良示例”来学习和选择最优的动作。

3.2 示例设计与基于距离的选择

在自动驾驶决策过程中,LLM需要根据环境状态从过往经验中选择合适的示例。每一个示例包含了车辆的状态、采取的动作和相应的奖励。通过比较当前环境状态与历史经验中的示例,LLM可以选择与当前情境最相似的经验进行决策。

为了解决选择合适示例的问题,采用了基于欧几里得距离的方法用来衡量当前状态与历史经验中每个示例的相似度。距离越小,表示当前环境与历史经验越相似,从而有助于选择更合适的动作。具体而言,当前环境的状态信息将与历史示例进行比较,计算出欧几里得距离,从而挑选出距离当前状态最接近的示例进行参考。这些示例会被分为“好示例”和“差示例”,LLM将根据这些示例来调整其决策。

3.3 DDQN 基于V2I的动作选择

在第二阶段,DDQN被用来优化V2I决策。自动驾驶决策(如加速、换道等)将作为V2I决策的输入。DDQN基于当前网络状态和自动驾驶决策来选择最佳的基站连接,以最大化数据速率并最小化频繁切换的影响。

DDQN使用神经网络来逼近Q值函数,Q值函数用于衡量每个状态-动作对的长期回报。通过以下步骤来执行V2I动作选择:

1)神经网络评估:DDQN网络通过输入当前的V2I状态和AD决策,计算每个动作的Q值。网络会根据这些Q值来选择最优的V2I动作。

2)目标网络:为了保持学习的稳定性,DDQN还使用了目标网络。这一网络通过更新和评估Q值来帮助计算期望的回报,并且通过最小化Q值的差异来优化动作选择。

DDQN的目标是通过Q学习来优化V2I通信,选择适当的基站以提高数据传输速率,并减少切换带来的延迟。

3.4 混合LLM-DDQN的迭代优化过程

混合LLM-DDQN方法通过迭代优化的方式来联合优化自动驾驶和V2I通信决策。该过程包括以下几个步骤:

1)收集观察信息:首先收集来自自动驾驶和V2I的状态信息,包括车辆的交通状态和通信环境状态。

2)LLM决策:基于当前交通状态,LLM生成自动驾驶决策。LLM通过任务描述和示例学习来做出决策,这些决策会影响车辆的行驶行为。

3)DDQN决策:基于自动驾驶决策和V2I通信状态,DDQN生成V2I决策,选择最佳的基站连接,以优化数据传输速率。

4)应用决策:将LLM和DDQN生成的决策应用到目标车辆中,执行相应的自动驾驶和V2I动作。

5)存储示例:在车辆执行动作后,系统会根据是否发生了碰撞或其他异常,将所采取的决策记录到“好示例”或“差示例”中。

这一过程会持续进行,直到系统的行为收敛。通过这种迭代优化方法,LLM和DDQN可以有效地学习并优化自动驾驶和V2I通信系统中的决策。

3.4 语言任务和决策的结合

LLM不仅在交通决策中起到作用,它还通过不断更新的任务描述和经验示例来提高自身的性能。在DDQN阶段,AD决策直接影响V2I的优化,反之,V2I优化的结果也可以反馈到AD决策中,从而实现两者之间的良性互动。

4.仿真与性能评估

在仿真与性能评估部分,作者设计了一系列实验来验证所提出的混合LLM-DDQN算法的效果,并将其与传统方法进行比较。仿真环境模拟了一个典型的交通场景,其中21辆自动驾驶车辆行驶在一条3公里长的单向四车道高速公路上。公路两侧随机部署了5个射频基站(RBS)和20个太赫兹基站(TBS)。这些实验为验证算法的有效性提供了基础。

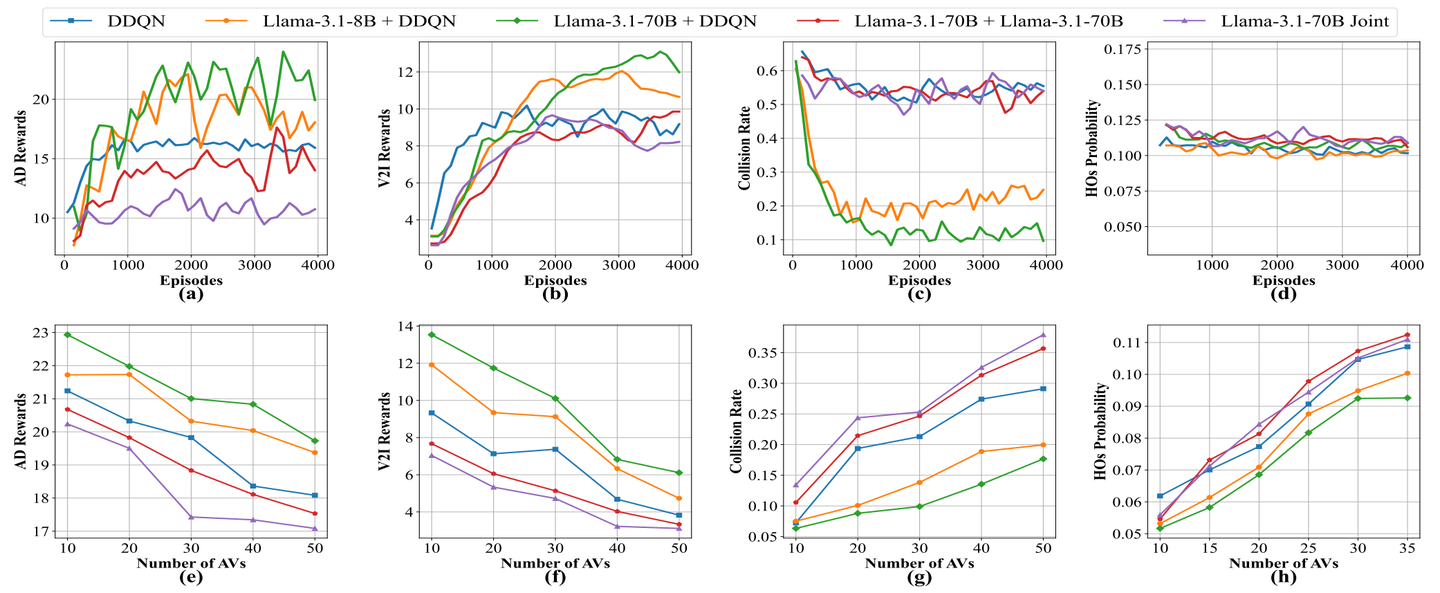

▲图2|实验结果©️【深蓝AI】编译

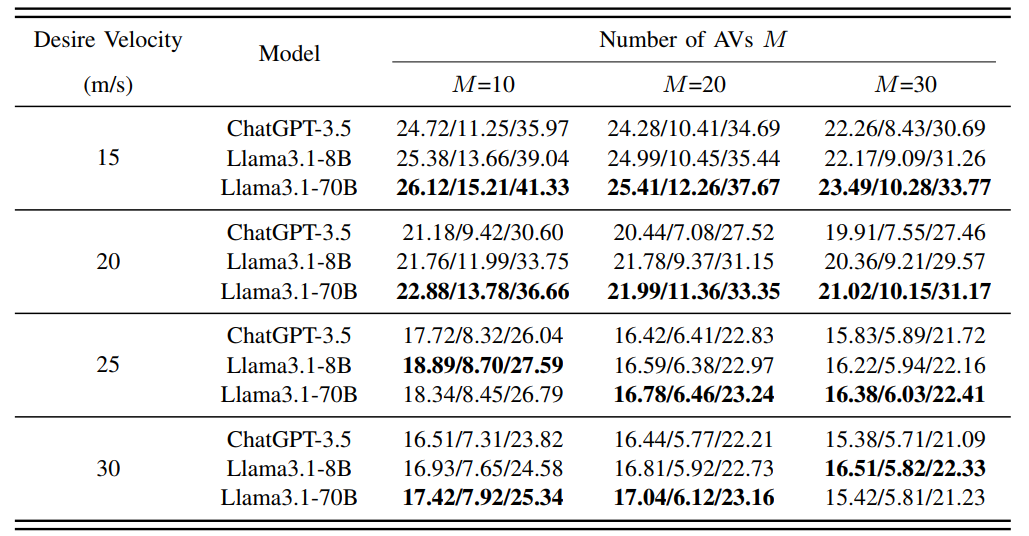

▲表1|不同语言模型的对比©️【深蓝AI】编译

在实验中,作者使用了两种不同规模的LLM模型来进行自动驾驶决策。首先是Llama3.1-8B模型,它包含80亿个参数,适合部署在边缘计算设备上。第二个是Llama3.1-70B模型,具有700亿个参数,推理能力更强。为了对比不同方法的效果,作者还设计了几种实验设置,包括使用两个Llama3.1-70B模型分别处理AD决策和V2I决策,或者使用一个Llama3.1-70B模型同时处理AD和V2I决策。此外,还引入了基准方法——仅使用DDQN进行V2I和AD联合优化。 仿真过程中,作者通过几个关键性能指标来评估各方法的表现。首先是AD奖励,它衡量自动驾驶决策的效果,主要考虑车辆的速度和碰撞情况。其次是V2I奖励,评估V2I通信决策的表现,重点在于数据传输速率和切换频率。总奖励则综合考虑了AD和V2I两方面的效果。 实验结果表明,Llama3.1-70B模型的表现明显优于其他模型。在AD奖励和V2I奖励方面,Llama3.1-70B模型能够有效提高数据传输速率并减少碰撞。此外,Llama3.1-70B的推理能力使其在复杂环境中表现出色,能够更好地适应多变的交通和通信条件,从而提供更高的系统性能。 混合LLM-DDQN方法还表现出更快的收敛速度。与基准方法相比,这种混合方法能够在较短的时间内达到较高的奖励水平,证明了其学习效率和优化能力的优势。在碰撞率和基站切换概率的比较中,混合方法也显示出了明显的优势。它能够有效减少碰撞发生率,并通过减少频繁的基站切换来提升通信稳定性,尤其是在车流量较大的情况下,依然能够保持较低的碰撞率和较高的数据速率。 随着自动驾驶车辆数量的增加,交通环境变得更加拥堵,基站资源竞争也更加激烈。结果表明,车辆数量的增加确实导致了碰撞率和切换概率的上升,但即使在这种情况下,混合LLM-DDQN方法仍然能够保持较优的性能,表现出较低的碰撞率和较高的数据传输速率。 通过与不同规模的LLM模型进行对比,实验还发现,Llama3.1-70B在处理复杂任务时展现出更强的推理和决策能力,因此表现更加优越。尽管Llama3.1-8B模型也表现较好,但在更复杂的任务和环境中,其性能不如Llama3.1-70B。此外,实验还表明,分开使用两个LLM模型分别处理AD决策和V2I决策,通常会比使用一个单独的LLM模型同时处理两者更有效。这说明,分离的LLM模型能够在各自的任务上发挥更大的优势,从而优化整体系统的性能。 总的来说,仿真结果证明了混合LLM-DDQN方法的优势,不仅在速度和数据传输方面超越了传统的DDQN方法,而且在高车流量和复杂环境下表现更为稳定。特别是Llama3.1-70B模型的应用,展现了强大的推理和优化能力,使得系统能够快速适应并优化自动驾驶和V2I通信决策,提升了整体效率和安全性。

5.结论

本文提出的混合LLM-DDQN方法在解决自动驾驶和V2I通信的联合优化问题中展现了显著的优势。通过引入大语言模型,能够在复杂的驾驶环境中快速生成合理的决策,提升了自动驾驶的效率和安全性。同时,DDQN被有效地应用于V2I通信优化,减少了基站切换的频率并提高了数据传输速率。

仿真结果表明,混合LLM-DDQN方法比传统的DDQN方法表现更优,尤其是在收敛速度和学习效率方面。此外,较大的LLM模型(如Llama3.1-70B)在处理复杂任务时展现了更强的推理和优化能力,从而显著提升了整体系统的性能。尽管随着自动驾驶车辆数量的增加,系统面临更大的资源竞争和交通拥堵问题,但该方法仍能保持较低的碰撞率和较高的数据传输速率,展现出其在高负载环境下的鲁棒性。

总体而言,混合LLM-DDQN方法不仅在自动驾驶与V2I通信的联合优化中表现出了卓越的性能,而且在未来的6G网络等复杂通信环境中具有广泛的应用前景。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?