目录

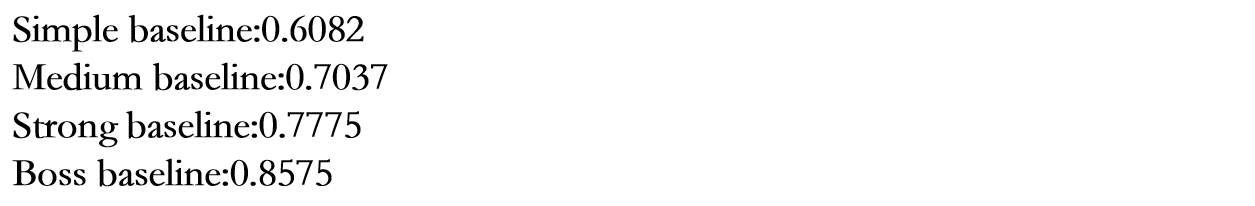

4.2 Medium Baseline (acc>0.7037)

4.3 Strong Baseline (acc>0.7775)

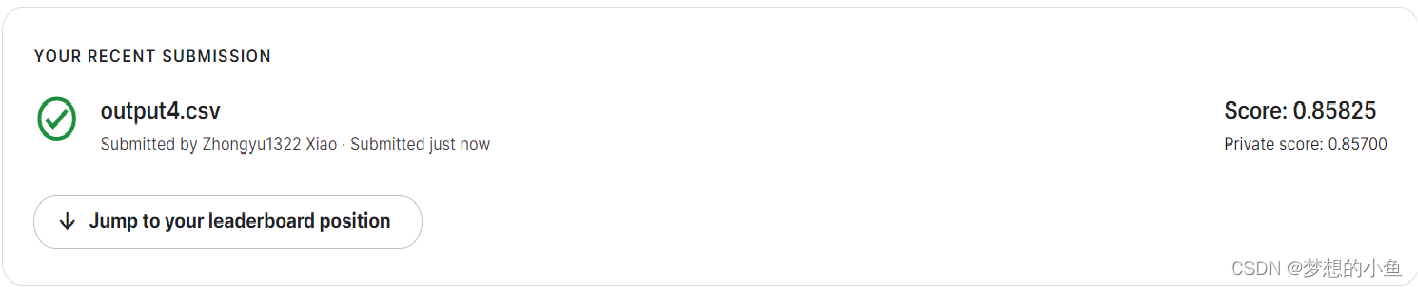

4.4 Boss Baseline (acc>0.8575)

加入Self-Attention Pooling和Additive Margin Softmax,并对conformer进行调参。

Machine Learning HW4

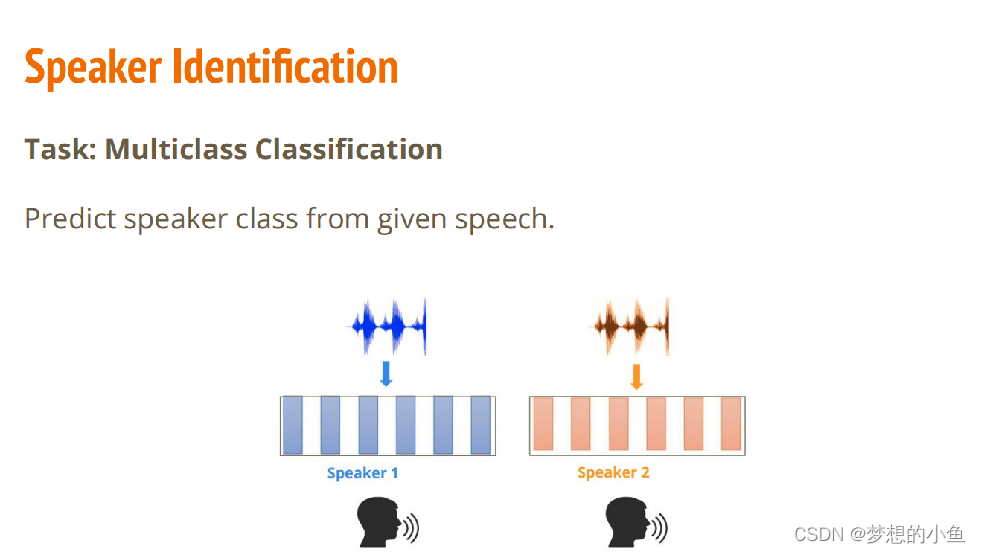

一、任务

对于一段语音判断它是哪一个人发出的。

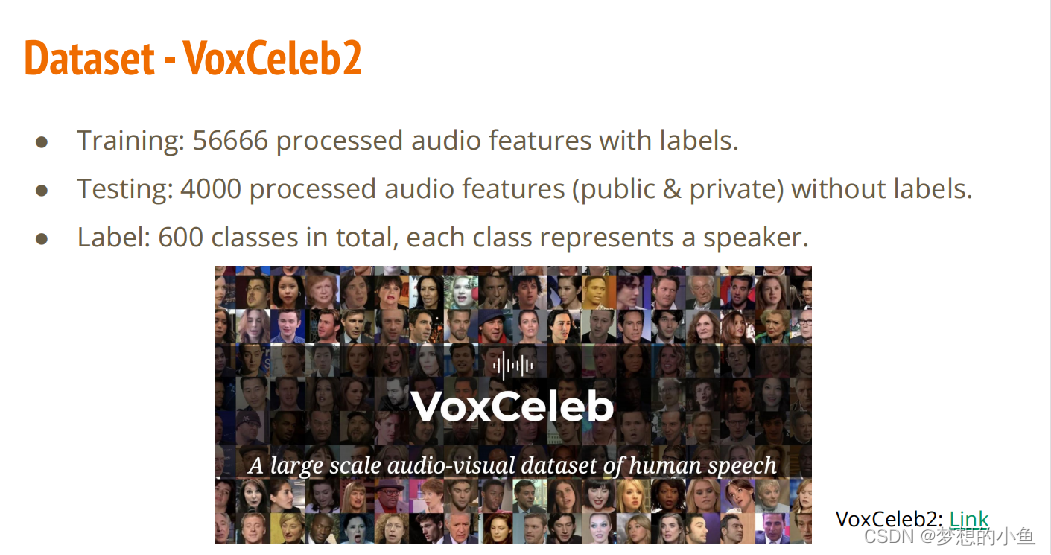

二、数据集

VoxCeleb2,数据集过大,可以在官网下载

三、结果

全过bossline。

本文是李宏毅机器学习课程的HW4,涉及VoxCeleb2语音识别任务。通过逐步改进模型,从简单线性模型到Boss Baseline,实现了超过0.8575的准确率,包括使用Conformer架构和Self-Attention Pooling等技术。

本文是李宏毅机器学习课程的HW4,涉及VoxCeleb2语音识别任务。通过逐步改进模型,从简单线性模型到Boss Baseline,实现了超过0.8575的准确率,包括使用Conformer架构和Self-Attention Pooling等技术。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

5516

5516

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?