word2vec和由其衍生出的item2vec是embedding技术的基础性方法,但二者都是建立在“序列”样本(比如句子、推荐列表)的基础上的。而在互联网场景下,数据对象之间更多呈现的是图结构。典型的场景是由用户行为数据生成的和物品全局关系图(图1),以及加入更多属性的物品组成的知识图谱

经典的Graph Embedding方法——DeepWalk

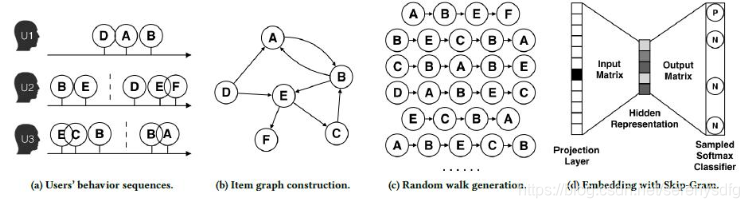

2014年提出的DeepWalk,它的主要思想是在由物品组成的图结构上进行随机游走,产生大量物品序列,然后将这些物品序列作为训练样本输入word2vec进行训练,得到物品的embedding

1基于原始的用户行为序列构建了物品相关图

2物品A,B之间的边产生的原因就是因为用户U1先后购买了物品A和物品B,所以产生了一条由A到B的有向边。如果后续产生了多条相同的有向边,则有向边的权重被加强。在将所有用户行为序列都转换成物品相关图中的边之后,全局的物品相关图就建立起来了。

3采用随机游走的方式随机选择起始点,重新产生物品序列。

4最终将这些物品序列输入word2vec模型,生成最终的物品Embedding向量。

DeepWalk的进一步改进——Node2vec

2016年,通过调整随机游走权重的方法使graph embedding的结果在网络的同质性(homophily)和结构性(structural equivalence)中进行权衡。BFS反映了结构性,DFS反而反应了同质性

同质性:距离相近节点的embedding应该尽量近似,“结构性”:指的是结构上相似的节点的embedding应该尽量接近

node2vec算法中主要是通过节点间的跳转概率控制BFS和DFS的倾向性。图5显示了node2vec算法从节点t跳转到节点v后,下一步从节点v跳转到周围各点的跳转概率。

2018阿里的Graph Embedding方法EGES

为了使“冷启动”的商品获得“合理”的初始Embedding,阿里团队通过引入了更多补充信息来丰富Embedding信息的来源,从而使没有历史行为记录的商品获得Embedding。

本文介绍了图嵌入技术的发展,从DeepWalk开始,通过在物品图上进行随机游走生成序列,利用word2vec训练物品Embedding。随后介绍Node2vec如何在DeepWalk基础上改进,平衡同质性和结构性。最后提及2018年阿里的EGES方法,为解决冷启动问题引入更多信息。

本文介绍了图嵌入技术的发展,从DeepWalk开始,通过在物品图上进行随机游走生成序列,利用word2vec训练物品Embedding。随后介绍Node2vec如何在DeepWalk基础上改进,平衡同质性和结构性。最后提及2018年阿里的EGES方法,为解决冷启动问题引入更多信息。

4231

4231

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?