数据不平衡

指的是不同类别的样本差异非常大,或者少数样本代表了业务的关键数据,需要对少量样本的模式有很好的下也许。

其中分布不均衡分为两种:

- 大数据分布不均衡:数据规模较大,某类别样本占比较小。

- 小数据分布不均衡:整体数据规模较小,某类别的样本数量也少。

三种解决方式

1.欠采样

在少量样本数量不影响模型训练的情况下,可以通过对多数样本欠采样,实现少数样本和多数样本的平衡。(减少多数样本的样本量)

1.1 随即删除

1.2 原型生成(PG算法)

2.过采样

在少量样本数量不支撑模型训练的情况下,可以通过对少量样本过采样,实现少数样本和多数样本的均衡。(增加少数样本的样本量)

2.1 随即复制

2.2 样本构建(SMOTE算法)

3. 模型算法

3.1 Cost Sensitive算法

通过引入有倚重的模型算法,针对少量样本着重拟合,来提升对少量样本的特征学习。

3.2 Focal Loss算法(重点)

通过减少易分类样本的权重,是的模型在训练时更专注于难分类的样本。

NLP中数据增强

UDA

一种半监督学习方法,减少对标注数据的需求,增加对未标注数据的利用

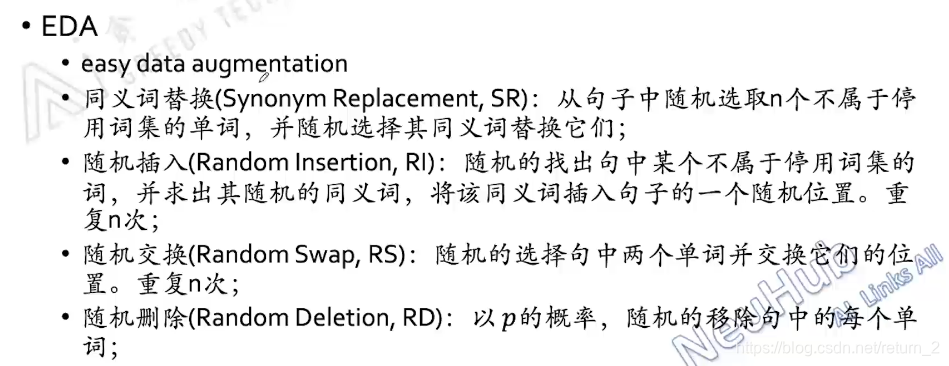

EDA

数据不平衡是指各类样本数量差异大,影响模型训练。解决方案包括欠采样(如随机删除、原型生成)、过采样(如随机复制、SMOTE算法)和模型算法调整(如CostSensitive、FocalLoss)。NLP中,UDA和EDA等方法能有效利用未标注数据,降低对标注数据的依赖。

数据不平衡是指各类样本数量差异大,影响模型训练。解决方案包括欠采样(如随机删除、原型生成)、过采样(如随机复制、SMOTE算法)和模型算法调整(如CostSensitive、FocalLoss)。NLP中,UDA和EDA等方法能有效利用未标注数据,降低对标注数据的依赖。

766

766

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?