Structure Invariant Transformation for better Adversarial Transferability

本文 “Structure Invariant Transformation for better Adversarial Transferability” 提出结构不变变换(SIA)攻击方法,通过对图像块进行多种变换生成多样图像计算梯度,提升对抗样本迁移性,实验证明其在多种模型上优于现有方法。

摘要-Abstract

Given the severe vulnerability of Deep Neural Networks (DNNs) against adversarial examples, there is an urgent need for an effective adversarial attack to identify the deficiencies of DNNs in security-sensitive applications. As one of the prevalent black-box adversarial attacks, the existing transfer-based attacks still cannot achieve comparable performance with the white-box attacks. Among these, input transformation based attacks have shown remarkable effectiveness in boosting transferability. In this work, we find that the existing input transformation based attacks transform the input image globally, resulting in limited diversity of the transformed images. We postulate that the more diverse transformed images result in better transferability. Thus, we investigate how to locally apply various transformations onto the input image to improve such diversity while preserving the structure of image. To this end, we propose a novel input transformation based attack, called Structure Invariant Transformation (SIA), which applies a random image transformation onto each image block to craft a set of diverse images for gradient calculation. Extensive experiments on the standard ImageNet dataset demonstrate that SIA exhibits much better transferability than the existing SOTA input transformation based attacks on CNN-based and transformer-based models, showing its generality and superiority in boosting transferability.

鉴于深度神经网络(DNNs)在对抗样本面前存在严重的脆弱性,迫切需要一种有效的对抗攻击方法,来识别DNNs在安全敏感应用中的缺陷。作为一种常见的黑盒对抗攻击方式,现有的基于迁移的攻击仍然无法达到与白盒攻击相媲美的性能。在这些攻击方法中,基于输入变换的攻击在提升迁移性方面表现出了显著的效果。在本研究中,我们发现现有的基于输入变换的攻击对输入图像进行全局变换,导致变换后的图像多样性有限。我们假设变换后的图像多样性越高,其迁移性就越好。因此,我们研究如何在输入图像上局部应用各种变换,在保留图像结构的同时提高这种多样性。为此,我们提出了一种新颖的基于输入变换的攻击方法,称为结构不变变换(SIA)。该方法对每个图像块应用随机图像变换,生成一组多样化的图像用于梯度计算。在标准的ImageNet数据集上进行的大量实验表明,与现有的基于输入变换的最优攻击方法相比,SIA在基于卷积神经网络(CNN)和基于Transformer的模型上都展现出了更好的迁移性,证明了其在提升迁移性方面的通用性和优越性。

引言-Introduction

这部分主要介绍了研究背景、现有对抗攻击的分类及问题,提出新假设并阐述研究内容与贡献,具体如下:

- 研究背景:深度神经网络(DNNs)在安全敏感领域广泛应用,但易受对抗样本攻击。这些对抗样本能以难以察觉的扰动误导模型,给现实应用带来巨大威胁,因此需要有效的攻击方法来识别DNNs的缺陷。

- 对抗攻击分类及问题:现有对抗攻击分为白盒攻击和黑盒攻击。白盒攻击可获取目标模型的所有信息,黑盒攻击对目标模型的访问受限。对抗样本的一个重要特性是迁移性,即一个模型上生成的对抗样本能误导其他模型,这使得在黑盒设置下攻击现实应用成为可能。然而,现有对抗攻击往往在白盒攻击性能上表现出色,但迁移性较差。

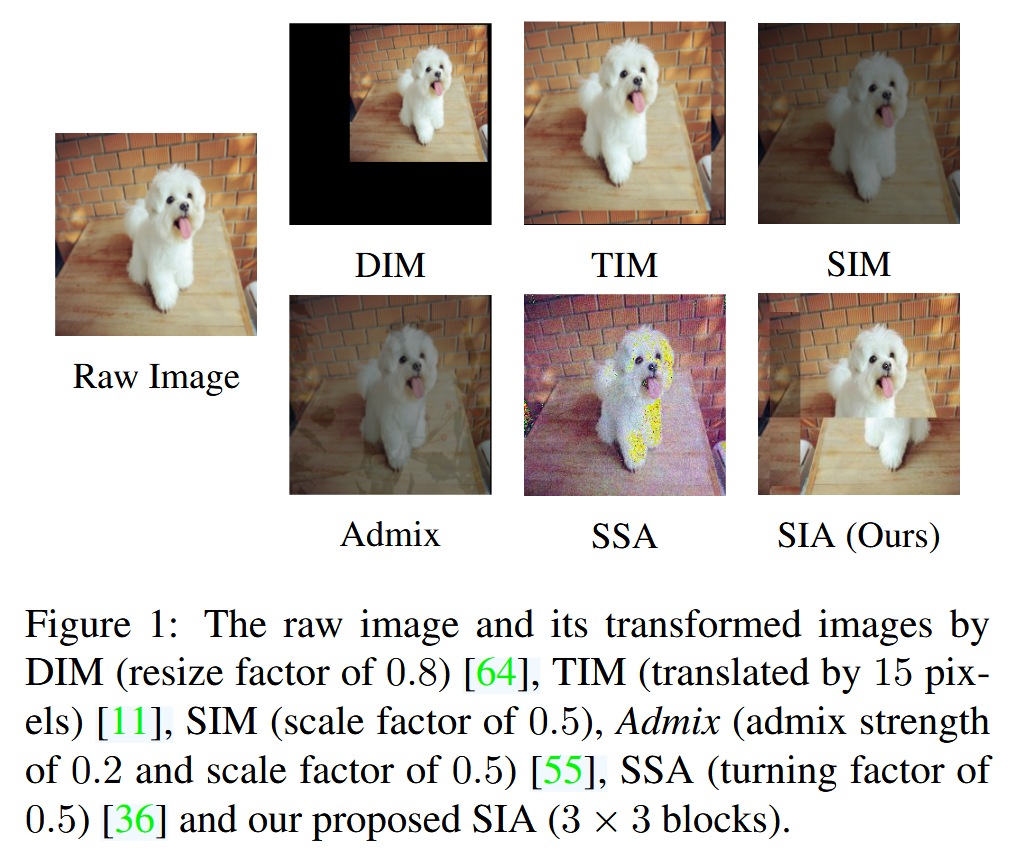

- 提升迁移性的方法及问题:为了生成更具迁移性的对抗样本,人们提出了多种技术,如动量法、输入变换法等。其中,输入变换法通过在梯度计算前对图像进行变换,取得了较好的迁移性,受到广泛关注。但现有基于输入变换的攻击,包括当前最优的Admix和SSA,都是对图像进行全局变换,未改变输入图像中对象间的局部关系,导致变换后图像的多样性仍不足,限制了迁移性的提升 。

- 新假设与研究内容:本文假设变换后图像的多样性越高,对抗样本的迁移性越好,并通过实验进行了验证。基于这一假设,本文不再对输入图像应用单一变换,而是在图像的不同部分局部应用不同变换,以增强变换后图像的多样性,同时保持对象的全局结构。

- 研究贡献:通过实验验证了变换后图像的高多样性有利于提高迁移性;设计了一种新的图像变换方法,在保持图像全局结构的同时,通过局部变换生成更多样化的图像;基于该图像变换,设计了一种新的基于输入变换的攻击方法SIA,以生成更具迁移性的对抗样本;在ImageNet数据集上的大量实验表明,SIA在基于CNN和Transformer的模型上均优于基线方法,展现了其优越性和通用性。

图1:原始图像以及经过DIM(缩放因子为0.8)、TIM(平移15像素)、SIM(缩放因子为0.5)、Admix(混合强度为0.2且缩放因子为0.5)、SSA(旋转因子为0.5)和我们提出的SIA

相关工作-Related Work

该部分主要围绕对抗攻击、对抗防御和数据增强三个方面,对相关研究进展进行了梳理和介绍,为后续研究提供了坚实的理论和方法基础,具体内容如下:

- 对抗攻击:对抗样本对基于DNN的应用构成严重威胁,为此人们提出多种攻击方法。基于梯度的攻击中,FGSM效率高但性能有限,I-FGSM是其迭代版本,白盒攻击性能好但迁移性差。在此基础上,又发展出多种提升迁移性的方法:

- 动量法:如MI-FGSM 引入动量稳定优化方向,NI-FGSM 采用Nesterov加速梯度积累动量,方差调整方法 利用前一次迭代的梯度方差调整当前梯度,EMI-FGSM 通过积累样本梯度增强动量。

- 输入变换法:DIM 率先提出在梯度计算前对随机调整大小的图像添加填充;TIM 在平移图像集合上优化扰动;SIM 用不同缩放因子缩放图像;DEM 对多种变换图像的梯度求平均;Admix 将输入图像与其他类别图像混合计算梯度;还有通过训练对抗变换网络或在频域变换图像等方式实现的攻击。

- 集成攻击:Liu等人发现多模型生成的对抗样本迁移性更强,Xiong等人通过减少模型间梯度方差进一步提升。

- 高级目标函数:一些研究采用如最大化良性样本和对抗样本中间特征图差异、关注注意力图距离等正则化方法提升迁移性。

- 模型特定方法:利用代理模型架构,如Li等人在每层后添加dropout创建幽灵网络,SGM 采用ResNets中更多跳跃连接的梯度,LinBP 修改ReLU导数提升模型线性等方法提升迁移性。

- 对抗防御:为应对对抗攻击,提出诸多防御方法。对抗训练在训练过程中使用对抗样本,效果好但计算成本高;输入预处理也是有效方式,如HGD设计去噪器消除扰动,随机调整大小和填充可减轻威胁,NRP通过自监督对抗训练净化输入样本。此外,还有认证防御方法,如随机平滑为模型提供可证明的鲁棒性保证。

- 数据增强:常见数据增强方法,如Mixup插值生成虚拟样本、Cutmix粘贴图像补丁并混合标签、AutoAugment自动搜索增强策略,主要用于训练过程提升模型泛化性。而本文旨在通过对图像块进行多种变换构建多样化图像,用于梯度计算提升对抗样本迁移性,与这些数据增强策略目的不同。

方法-Methodology

该部分详细阐述了结构不变攻击(SIA)的动机、具体方法以及与AutoAugment的差异,为理解该攻击方法提供了关键依据,具体内容如下:

-

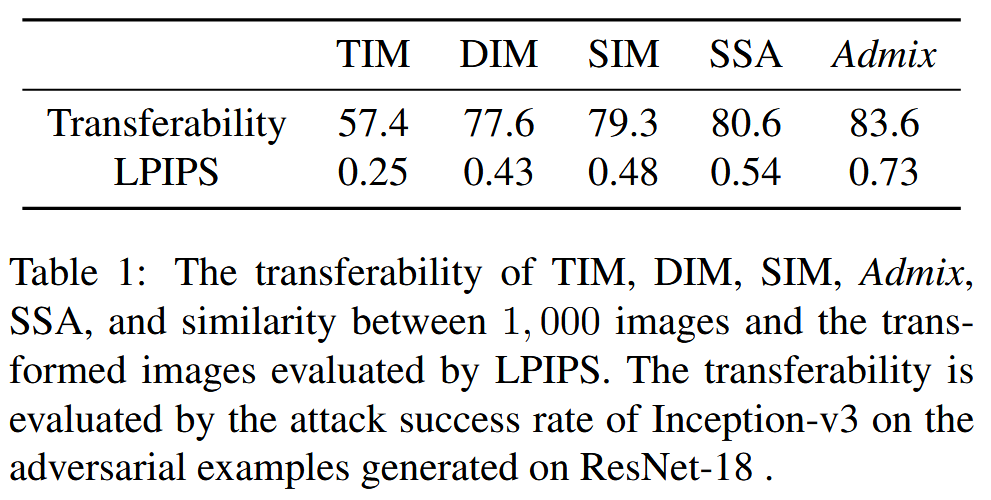

动机:自发现随机调整大小和填充图像可生成更具迁移性的对抗样本后,多种基于输入变换的攻击方法涌现。研究发现,具有更好迁移性的输入变换往往会给图像带来更明显的视觉变化。由此提出假设:在不损害语义信息的前提下,变换后的图像越多样,对抗样本的迁移性越好。通过利用学习感知图像块相似性(LPIPS)评估原始样本和变换图像的语义相似性,结果表明随着攻击迁移性增加,变换图像多样性增加,相似性降低。但多样的图像在计算梯度时会引入不稳定性,强大的基于输入变换的攻击需要在多个变换图像上计算梯度以消除这种不稳定性。因此,生成更多样化的图像用于梯度计算,有助于制作更具迁移性的对抗样本。

表1:TIM、DIM、SIM、Admix、SSA的迁移性,以及1000张图像与其变换后图像之间通过LPIPS评估的相似性。迁移性通过Inception-v3对在ResNet-18上生成的对抗样本的攻击成功率来评估。 -

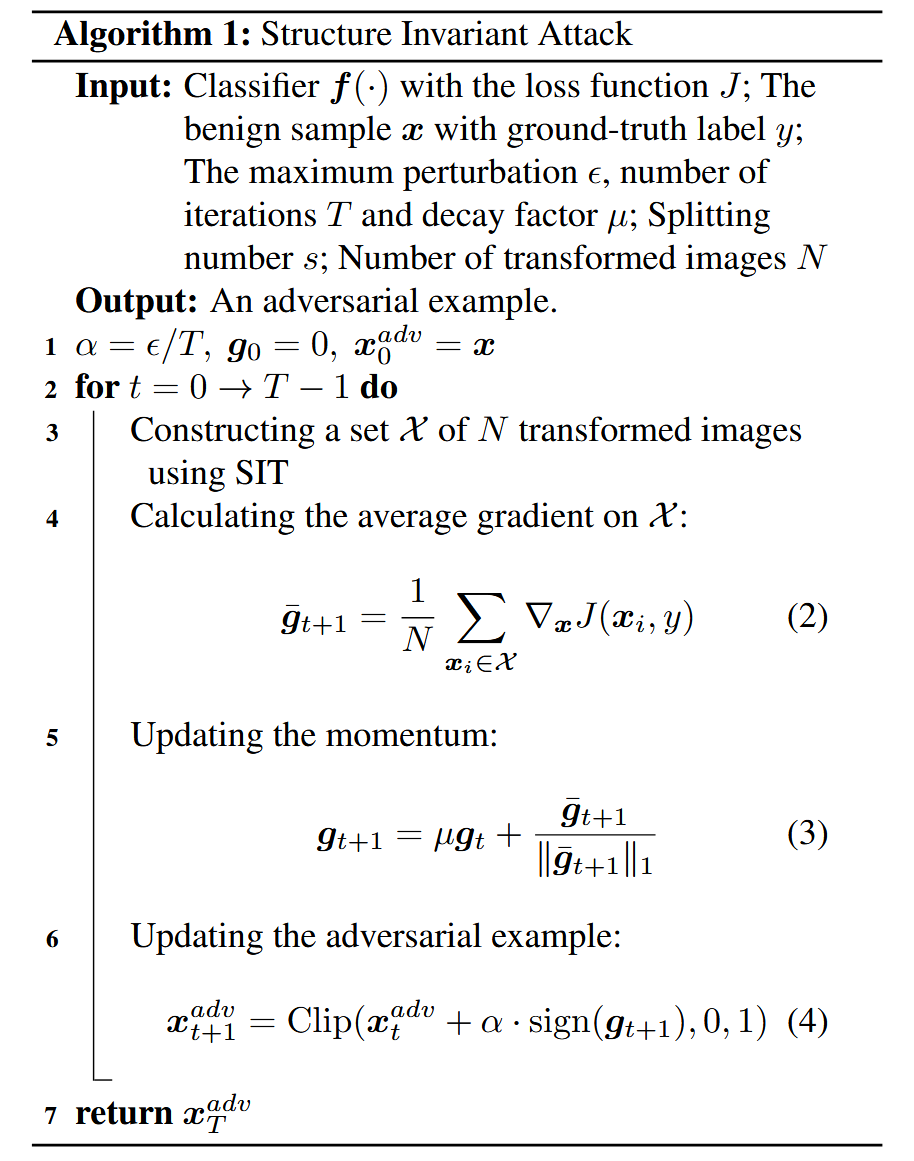

结构不变攻击(SIA)

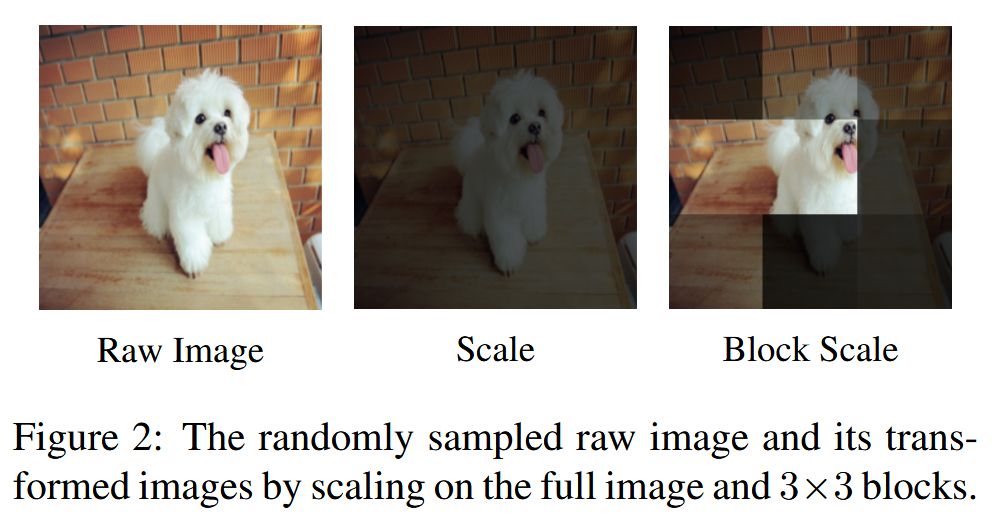

- 生成多样图像:以缩放变换为例,传统对整幅图像进行缩放操作,产生的图像多样性有限。为提高缩放图像的多样性,将图像随机分割成多个图像块,对每个图像块独立应用不同的缩放因子。这样既能生成更多样的变换图像,又能保持图像的结构,人类和深度模型仍可正确识别图像内容。

图2:随机采样的原始图像,以及对整幅图像进行缩放和对其 3 × 3 3×3 3×3 图像块进行缩放后的变换图像。

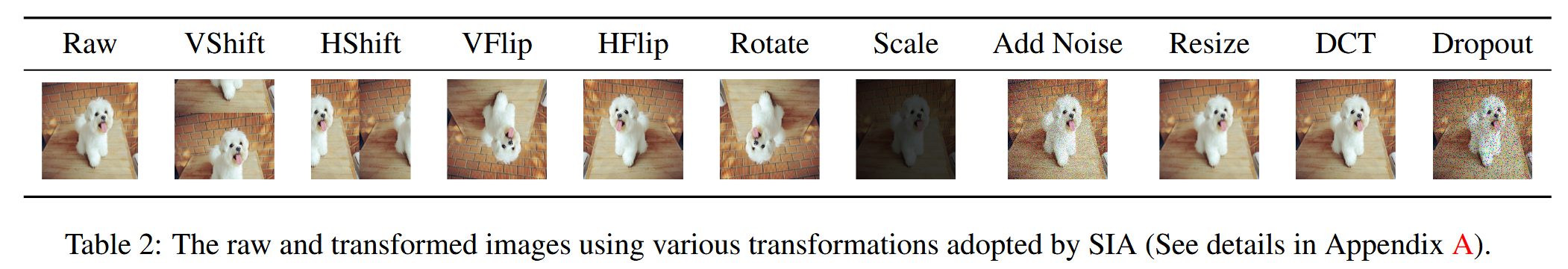

表2:SIA采用的各种变换下的原始图像和变换后图像(详见附录A)。 - 定义图像结构:将图像随机分割成 s × s s×s s×s 的块,各锚点(图像块中心)之间的相对关系定义为图像的结构。图像结构描绘了重要的语义信息,对图像块进行各种变换不会改变这种结构。

- 具体攻击算法:将多种图像变换应用于不同图像块,为避免信息损失,对部分变换添加约束,如旋转限制为180°。这种变换方式被称为结构不变变换(SIT)。SIA采用SIT作为输入变换进行对抗攻击,在多个由SIT变换后的图像上计算梯度,而非直接在输入图像上计算。算法将SIA集成到MI-FGSM中,通过迭代计算平均梯度、更新动量和对抗样本,最终输出对抗样本。

- 生成多样图像:以缩放变换为例,传统对整幅图像进行缩放操作,产生的图像多样性有限。为提高缩放图像的多样性,将图像随机分割成多个图像块,对每个图像块独立应用不同的缩放因子。这样既能生成更多样的变换图像,又能保持图像的结构,人类和深度模型仍可正确识别图像内容。

-

SIT与AutoAugment对比

- 目的不同:SIT旨在攻击模型时提高对抗迁移性;AutoAugment则是在训练过程中提升模型的泛化能力。

- 变换选择方式不同:SIT随机采样变换;AutoAugment需要为每个数据集上的每种变换搜索合适的策略。

- 变换应用方式不同:SIT在不同图像块上局部应用多种变换,同时保持图像全局结构;AutoAugment则是在图像上顺序应用两种变换。

- 生成图像多样性不同:SIT的细粒度变换能生成比AutoAugment更多样的图像。

实验-Experiment

该部分通过一系列实验,全面评估了结构不变攻击(SIA)的有效性,包括在不同模型上的攻击性能、与其他方法集成的效果、对集成模型和防御方法的攻击能力,以及进行消融研究和参数研究,具体内容如下:

-

实验设置

- 数据集:从ILSVRC 2012验证集中随机选取1000个类别中的1000张图像,这些图像能被所选模型正确分类。

- 基线方法:将SIA与DIM、TIM、DEM、Admix和SSA这五种基于输入变换的攻击方法进行对比,同时将基线方法与LinBP和SGM这两种模型特定方法集成。

- 受害模型:在卷积神经网络(如ResNet - 18、ResNet - 101等)和Transformer(如Vision Transformer、Swin Transformer)两类模型上评估攻击性能,并研究多种防御方法。

- 评估设置:参照MI - FGSM设置实验参数,如扰动预算 ϵ = 16 \epsilon = 16 ϵ=16 、迭代次数 T = 10 T = 10 T=10 、步长 α = ϵ / T = 1.6 \alpha=\epsilon / T = 1.6 α=ϵ/T=1.6 、衰减因子 μ = 1 \mu = 1 μ=1 ,并对各对比方法的关键参数进行设定,SIA设置图像分块数 s = 3 s = 3 s=3 ,用于梯度计算的变换图像数 N = 20 N = 20 N=20.

-

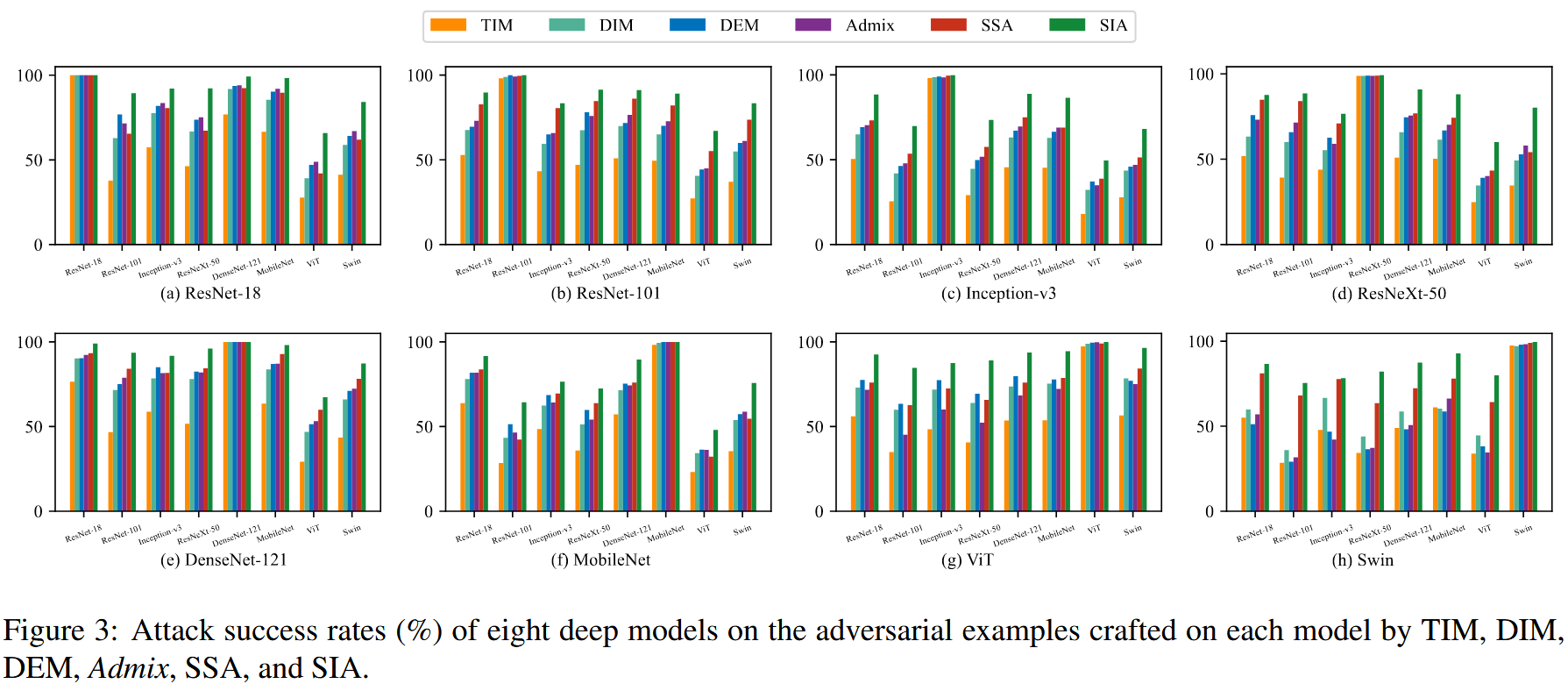

攻击单一模型:在单个模型上生成对抗样本并在其他模型上测试,结果显示所有攻击者在白盒攻击下成功率都很高,证明基于输入变换的攻击不会降低白盒攻击性能。在黑盒攻击性能方面,不同方法表现各异,SIA在所有八个不同架构的模型上,性能均优于最佳基线方法,平均攻击成功率比次优方法高14.3% ,在所有模型上至少高出2.8% ,表明SIA对多种模型架构具有通用性,能有效提升对抗样本迁移性。

图3:由TIM、DIM、DEM、Admix、SSA和SIA在每个模型上生成的对抗样本,在八个深度模型上的攻击成功率(%)。 -

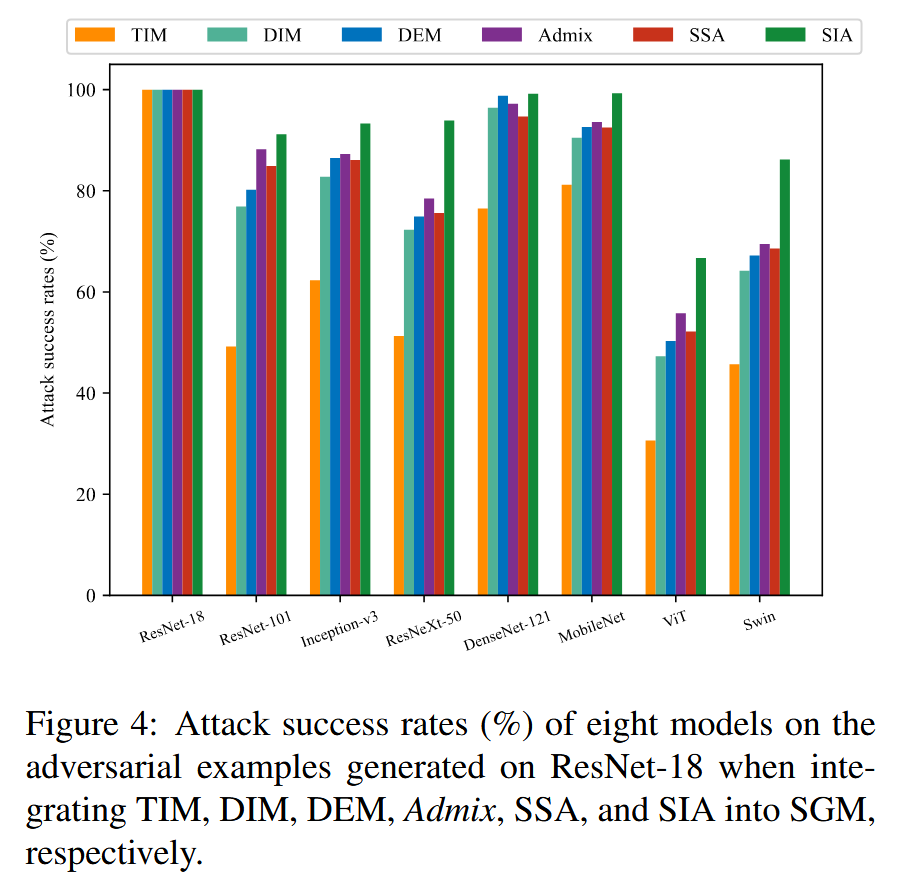

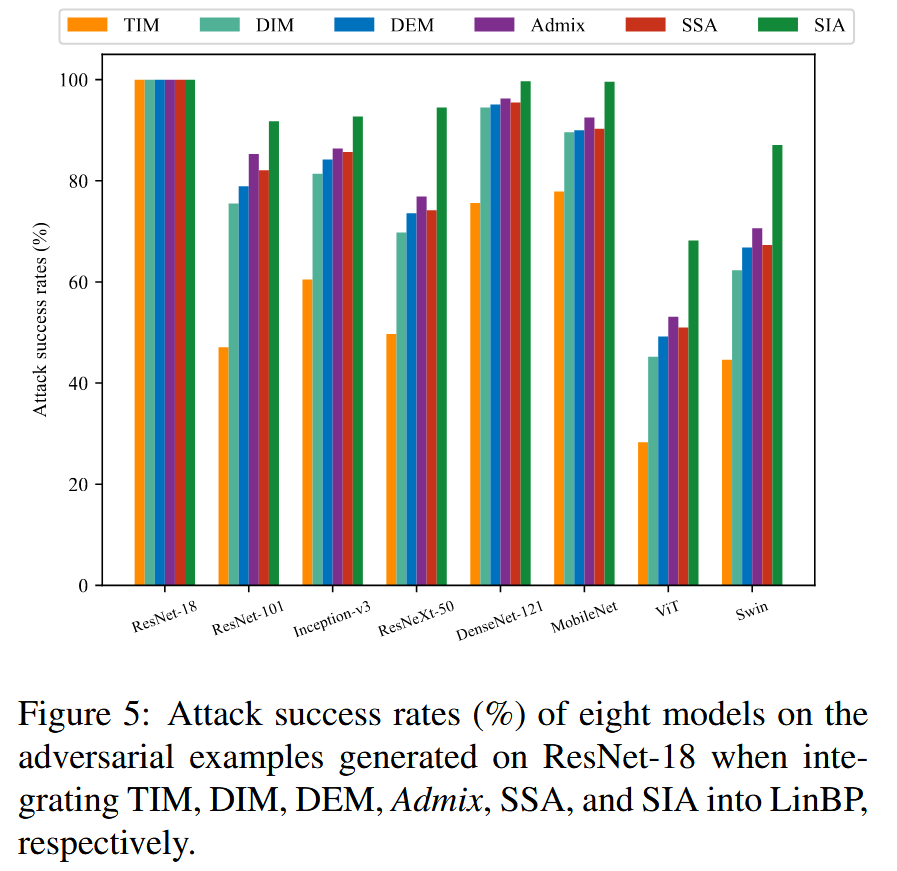

集成到模型特定方法:将现有基于输入变换的攻击方法集成到SGM和LinBP中,进一步验证SIA的可扩展性。结果表明,SGM和LinBP能提升攻击迁移性,而SIA在集成到这两种方法后,迁移性提升更为显著,平均分别提高3.3%和3.6% ,再次证明SIA的通用性和增强迁移性的潜力。

图4:当分别将TIM、DIM、DEM、Admix、SSA和SIA集成到SGM中时,在ResNet-18上生成的对抗样本在八个模型上的攻击成功率(%)。

图5:分别将TIM、DIM、DEM、Admix、SSA和SIA集成到LinBP中时,在ResNet - 18上生成的对抗样本在八个模型上的攻击成功率(%)。 -

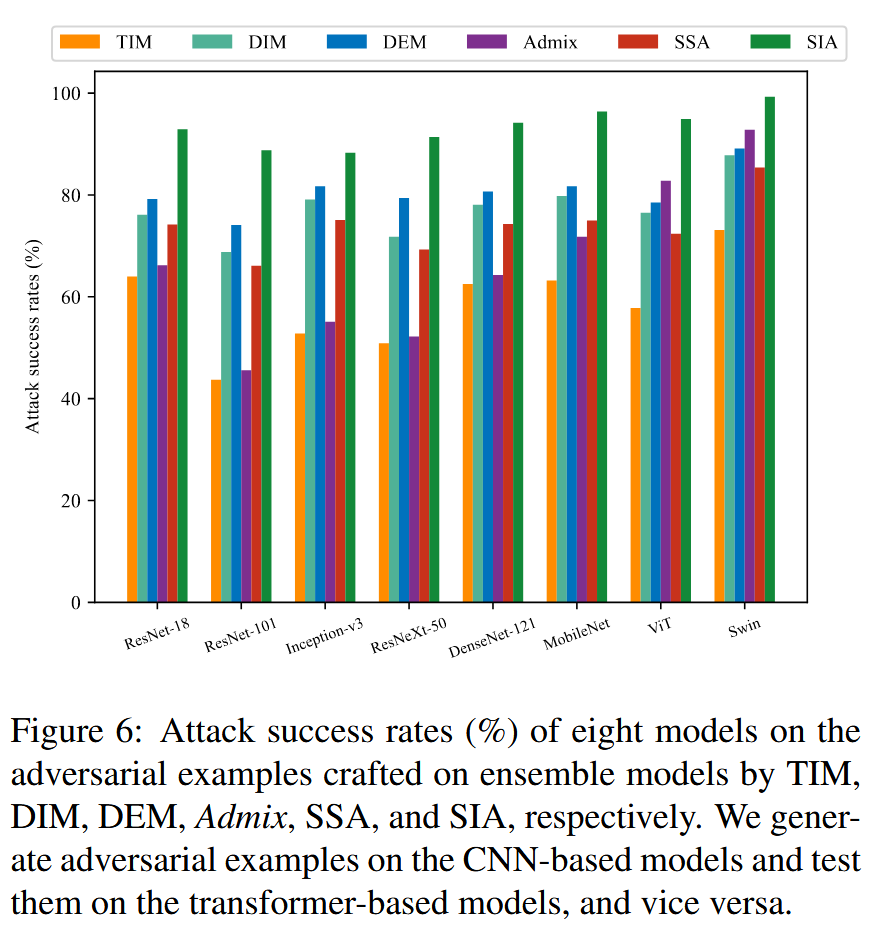

攻击集成模型:生成对抗样本攻击集成的CNN和Transformer模型,并在其余模型上测试。结果显示所有攻击在攻击集成模型时,生成的对抗样本迁移性都更好,SIA在所有八个模型上攻击成功率至少为88.3% ,比次优方法平均高6.5% ,在特定模型上攻击成功率更高,进一步支持了提高变换图像多样性可提升迁移性的观点。

图6:分别由TIM、DIM、DEM、Admix、SSA和SIA在集成模型上生成的对抗样本,在八个模型上的攻击成功率(%)。我们在基于卷积神经网络(CNN)的模型上生成对抗样本,并在基于Transformer的模型上进行测试,反之亦然。 -

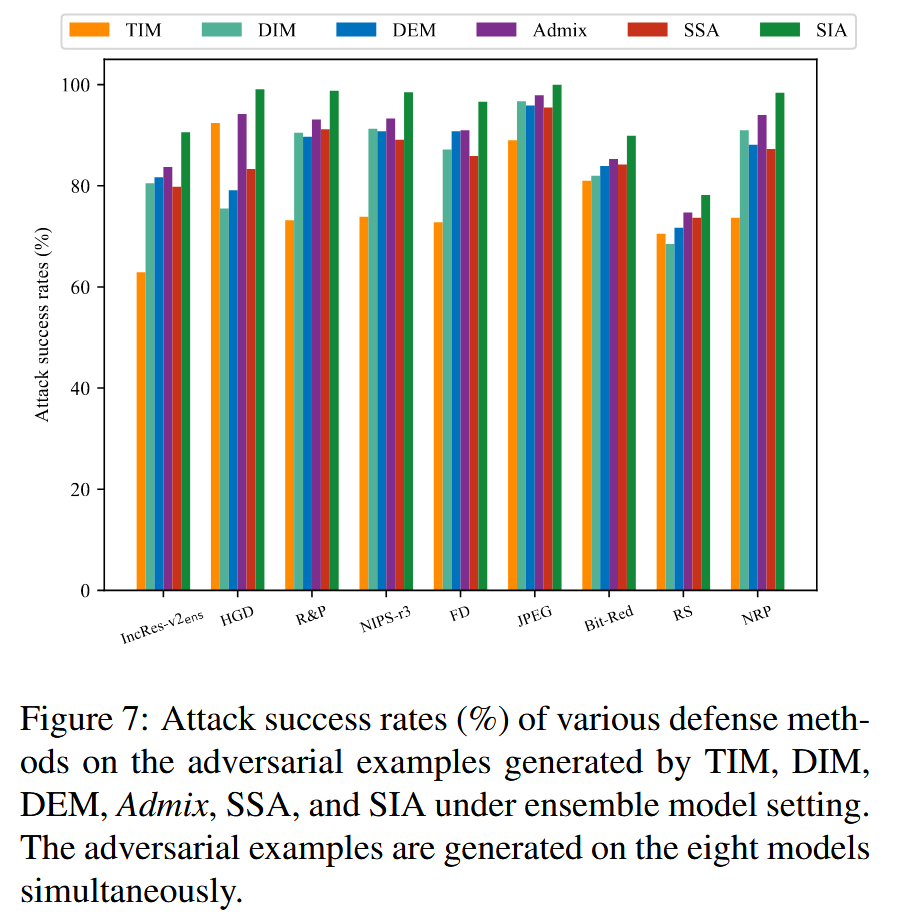

攻击防御方法:采用在八个模型上生成的对抗样本攻击多种防御模型,包括对抗训练模型、输入预处理防御方法、认证防御方法等。结果显示SIA在所有防御方法上的迁移性都优于基线方法,对认证防御方法RS的攻击成功率达78.2% ,对其他多数防御方法至少为89.9% ,表明现有防御方法存在不足。

图7:在集成模型设置下,由TIM、DIM、DEM、Admix、SSA和SIA生成的对抗样本对各种防御方法的攻击成功率(%)。这些对抗样本是同时在八个模型上生成的。 -

消融研究

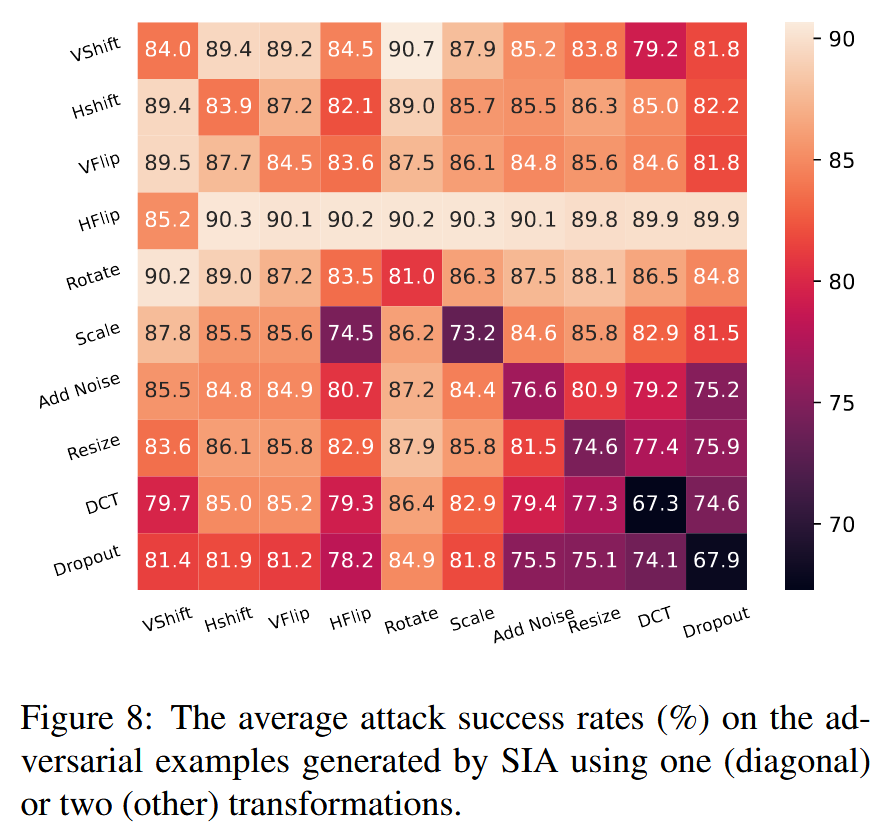

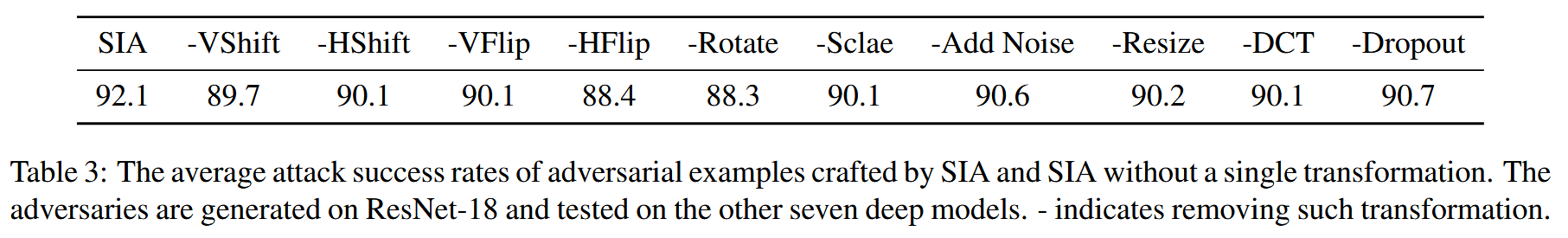

- 变换的有效性:研究SIA中不同变换对提升迁移性的作用,分别采用一两种变换实现SIA,结果表明单个变换就比MI - FGSM效果好,组合两种变换可进一步提升迁移性。去除任何一种变换都会降低迁移性,证明每种变换都有助于生成更具迁移性的对抗样本。

图8:使用一种(对角线上的数据)或两种(其他数据)变换的SIA生成的对抗样本的平均攻击成功率(%)。

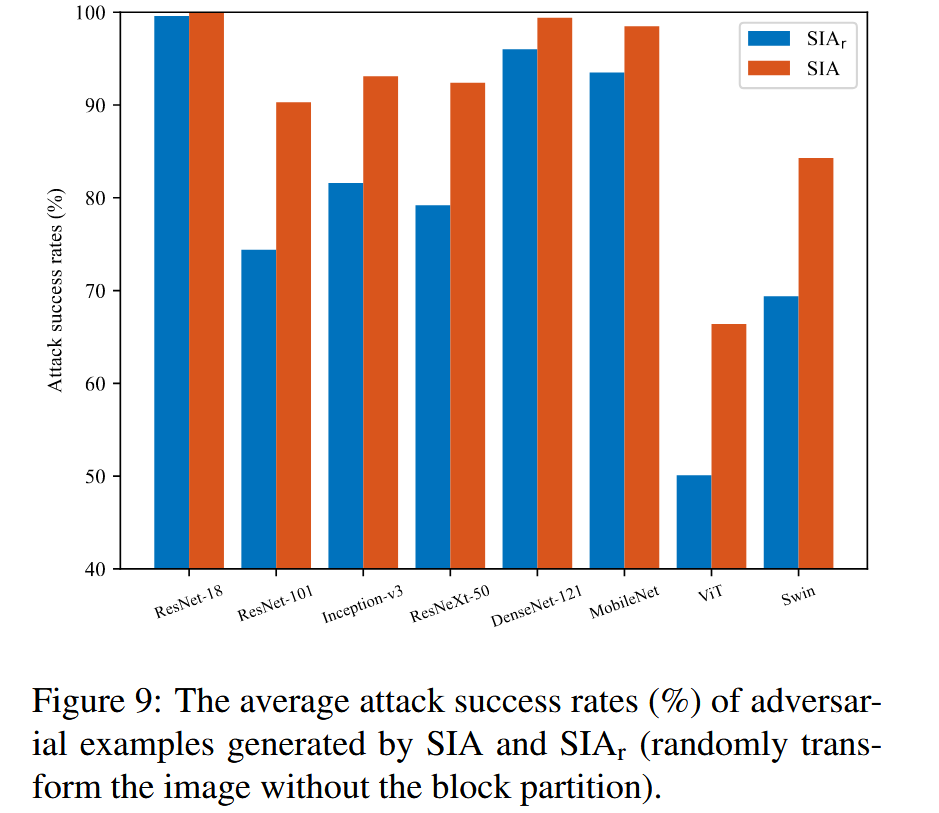

表3:由SIA生成的对抗样本以及去掉单一变换的SIA生成的对抗样本的平均攻击成功率。这些对抗样本在ResNet-18上生成,并在其他七个深度模型上进行测试。“-” 表示去除相应变换。 - 图像块的作用:对比将变换应用于图像块和随机应用于原始图像的效果,发现SIA比随机应用变换(SIA

r

_{r}

r )的迁移性更好,说明对图像块进行变换更有利于提升迁移性。

图9:由SIA和 SIA r _{r} r(在不进行图像分块的情况下随机变换图像)生成的对抗样本的平均攻击成功率(%)。

- 变换的有效性:研究SIA中不同变换对提升迁移性的作用,分别采用一两种变换实现SIA,结果表明单个变换就比MI - FGSM效果好,组合两种变换可进一步提升迁移性。去除任何一种变换都会降低迁移性,证明每种变换都有助于生成更具迁移性的对抗样本。

-

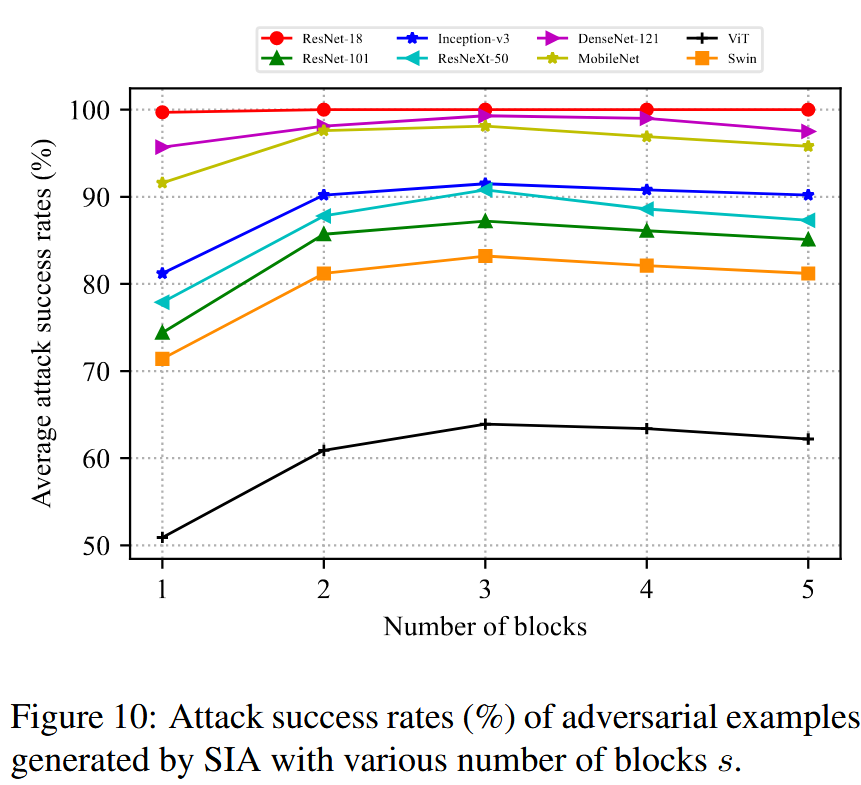

参数研究

- 图像块数量

s

s

s:研究

s

s

s 对攻击性能的影响,发现

s

≤

3

s\leq3

s≤3 时,增加

s

s

s 可提高图像多样性,提升攻击性能;但

s

s

s 过大时,会增加梯度方差,降低攻击性能,因此选择

s

=

3

s = 3

s=3 平衡图像多样性和梯度方差。

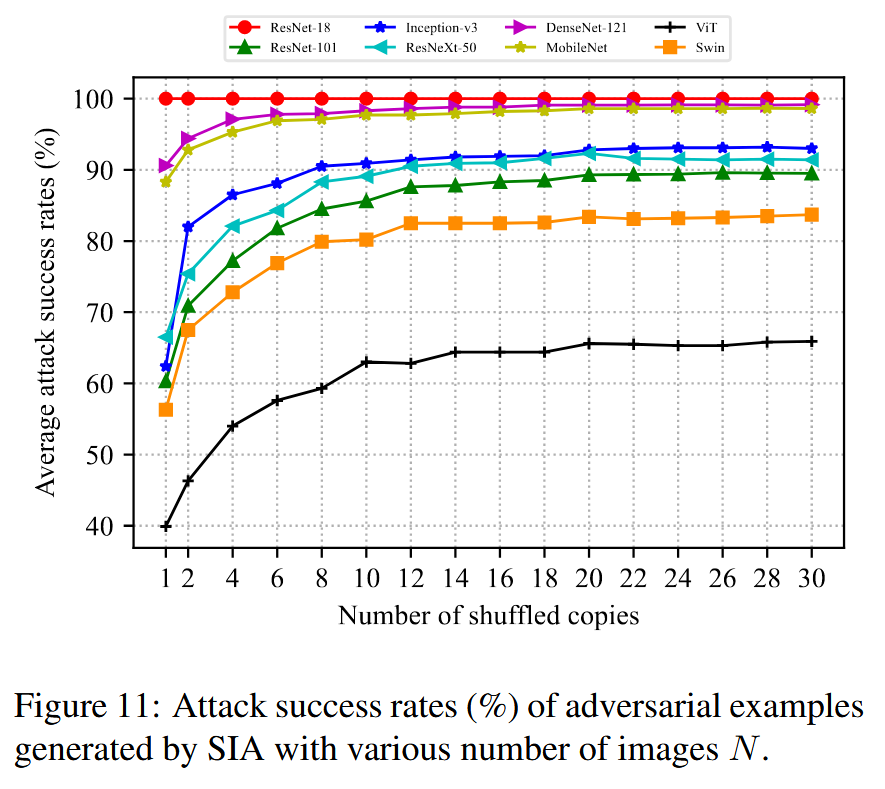

- 梯度计算图像数量

N

N

N:研究N对攻击性能的影响,当

N

=

1

N = 1

N=1 时,SIA性能最低;

N

N

N 增加时,梯度方差减小,迁移性提升,

N

>

20

N>20

N>20 后增加

N

N

N 只增加计算成本而无性能提升,所以选择

N

=

20

N = 20

N=20 平衡攻击性能和计算成本。

图11:由SIA生成的、具有不同图像数量 N N N 的对抗样本的攻击成功率(%)。

- 图像块数量

s

s

s:研究

s

s

s 对攻击性能的影响,发现

s

≤

3

s\leq3

s≤3 时,增加

s

s

s 可提高图像多样性,提升攻击性能;但

s

s

s 过大时,会增加梯度方差,降低攻击性能,因此选择

s

=

3

s = 3

s=3 平衡图像多样性和梯度方差。

结论-Conclusion

本文最后一部分对研究进行全面总结,概括主要发现、创新方法、实验成果及研究意义,为理解研究核心价值提供关键信息,具体内容如下:

- 研究发现:发现现有迁移性较好的基于输入变换的攻击,通常会生成更多样化的变换图像,这为后续研究提供了重要依据。

- 方法创新:设计结构不变变换(SIT),将图像分割为多个块并对每个块独立随机变换,保持图像全局结构。基于SIT提出结构不变攻击(SIA),通过在多个经SIT变换的图像上计算平均梯度来更新扰动。

- 实验成果:大量实验表明,SIA在迁移性上显著优于现有最优攻击方法。在不同架构的模型,包括基于CNN和Transformer的模型上,SIA都展现出卓越的性能,有力地证明了其有效性。

- 研究意义:SIA为提升对抗样本迁移性提供新方向,即通过对图像块进行细粒度变换来有效增强迁移性,为后续生成更具迁移性的对抗样本研究提供了新思路,具有重要的理论和实践价值。

1324

1324

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?