一、树剪枝概述

1.什么是剪枝?

通过降低决策树的复杂度来避免过拟合的过程称为剪枝。

2.为什么要剪枝?

决策树算法在学习的过程中为了尽可能正确的分类训练样本,不停地对结点进行划分,因此这会导致整棵决策树的分支过多,也就导致了过拟合。所以我们可通过“剪枝”来一定程度避免因决策分支过多,以致于把训练集自身的一些特点当做所有数据都具有的一般性质而导致的过拟合。

2.剪枝的基本策略:

- 预剪枝:预剪枝就是在决策树生成过程中,对每个结点在划分前先进行估计,若当前结点的划分不能带来决策树泛化性能提升,则停止划分并将当前结点记为叶结点,其类别标记为该节点对应训练样例数最多的类别。

- 后剪枝:后剪枝就是先从训练集生成一棵完整的决策树,然后自底向上地对非叶结点进行分析计算,若将该结点对应的子树替换为叶结点能带来决策树泛化性能提升,则将该子树替换为叶结点。

二、预剪枝

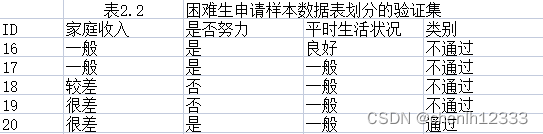

1.数据集:

2.未剪枝决策树:

本文介绍了决策树剪枝中的预剪枝策略,旨在避免过拟合。通过实例展示了预剪枝的过程,比较了未剪枝和预剪枝决策树的差异。预剪枝在决策树生成时对每个节点进行评估,若划分不能提高验证集精度,则停止划分,从而简化决策树并减少过拟合风险。然而,这种策略可能导致潜在的欠拟合,因为它基于贪心策略限制了分支的扩展。

本文介绍了决策树剪枝中的预剪枝策略,旨在避免过拟合。通过实例展示了预剪枝的过程,比较了未剪枝和预剪枝决策树的差异。预剪枝在决策树生成时对每个节点进行评估,若划分不能提高验证集精度,则停止划分,从而简化决策树并减少过拟合风险。然而,这种策略可能导致潜在的欠拟合,因为它基于贪心策略限制了分支的扩展。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1733

1733

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?