在机器学习和计算机视觉领域,特别是在评估分类和目标检测模型性能时,Precision(精确率)、Recall(召回率)、AP50、mAP50和F1指标是几个非常重要的评价指标。下面是这些指标的定义和解释:

-

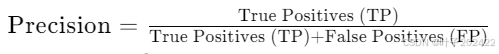

Precision(精确率): 精确率是指在所有被模型预测为正类的样本中,实际为正类的比例。它反映了模型预测的准确性。

-

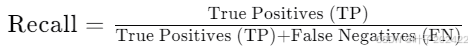

Recall(召回率): 召回率是指在所有实际为正类的样本中,被模型正确预测为正类的比例。它反映了模型捕获所有正类样本的能力。

-

AP50(Average Precision at 50% Recall): AP50是一种平均精确率的度量,它在召回率为50%时计算。这是在目标检测任务中常用的指标,特别是在速度和精度之间需要平衡的场景下。AP50衡量的是当召回率固定在50%时,精确率的平均值。

-

mAP50(mean Average Precision at 50% Recall): mAP50是所有类别的AP50的平均值。它是一个综合指标,用于评估模型在多个类别上的整体性能。mAP50是目标检测领域中一个非常重要的指标,特别是在评估模型在不同类别上的性能时。

-

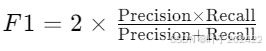

F1指标: F1指标是精确率和召回率的调和平均值,它试图在精确率和召回率之间找到一个平衡。F1指标的值总是在0和1之间,值越高表示模型的性能越好。

这些指标在不同的应用场景中有不同的侧重点。例如,在医疗诊断中,可能更关注召回率,因为不想错过任何真正的病例;而在垃圾邮件检测中,可能更关注精确率,以避免将正常邮件错误地分类为垃圾邮件。在实际应用中,根据具体需求选择合适的评价指标是非常重要的。

参考资料

1.kimi.ai

10万+

10万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?