一、本文介绍

🔥本文给大家介绍利用EVA高效视觉注意力模块改进YOLOv11网络模型,能够显著提升模型的目标检测能力。特别是在 复杂场景 和 小物体检测 上表现优异。EVA的优势在于通过扩展感受野、动态调整感受野和增强边界细节,能够让YOLOv11在效率和精度之间实现更好的平衡,从而为实时目标检测提供更强大的支持。

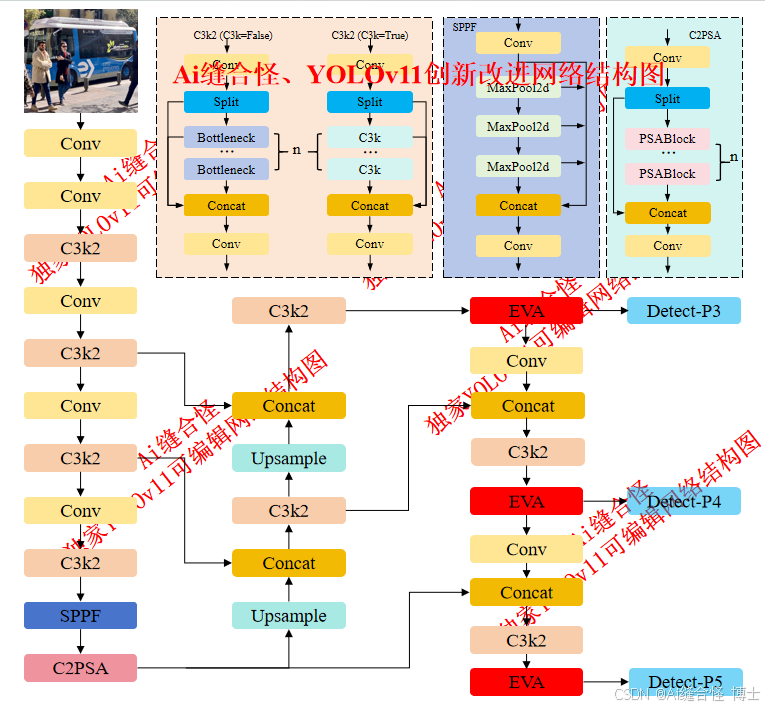

展示部分YOLOv11改进后的网络结构图、供小伙伴自己绘图参考:

🚀 创新改进结构图: yolov11n_EVA.yaml

专栏改进目录:YOLOv11改进专栏包含卷积、主干网络、各种注意力机制、检测头、损失函数、Neck改进、小目标检测、二次创新模块、C2PSA/C3k2二次创新改进、全网独家创新等创新点改进

全新YOLOv11-发论文改进专栏链接:全新YOLOv11创新改进高效涨点+永久更新中(至少500+改进)+高效跑实验发论文

本文目录

1.首先在ultralytics/nn/newsAddmodules创建一个.py文件

2.在ultralytics/nn/newsAddmodules/__init__.py中引用

🚀 创新改进1: yolov11n_C3k2_EVA.yaml

二、EVA高效视觉注意力模块介绍

摘要:实时语义分割面临着设计高效架构的双重挑战:既要捕获大范围的感受野以进行语义理解,又要精细化地提取细节轮廓。视觉变换器(Vision Transformers)能够有效地建模长程依赖关系,但计算开销较大。为了解决这些挑战,我们引入了大卷积核注意力(LKA)机制。我们提出的双边高效视觉注意力网络(BEVANet)通过稀疏分解的大可分离卷积核注意力(SDLSKA)扩展感受野,以捕获上下文信息,并提取视觉和结构特征。综合卷积核选择(CKS)机制动态调整感受野,进一步增强性能。此外,深度大卷积核金字塔池化模块(DLKPPM)通过结合扩张卷积和大卷积核注意力协同工作,丰富上下文特征。双边架构促进了两个分支之间的频繁通信,而边界引导自适应融合(BGAF)模块通过在边界指导下融合空间和语义特征,增强了边界的描绘。BEVANet在实时分割任务中达到了每秒33帧的速度,在Ci

订阅专栏 解锁全文

订阅专栏 解锁全文

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?