池化层的作用:

- 缩减模型的大小,提高运算速度

- 提高所提取特征的鲁棒性

池化层只是计算神经网络某一层的静态属性,没有需要学习的参数。

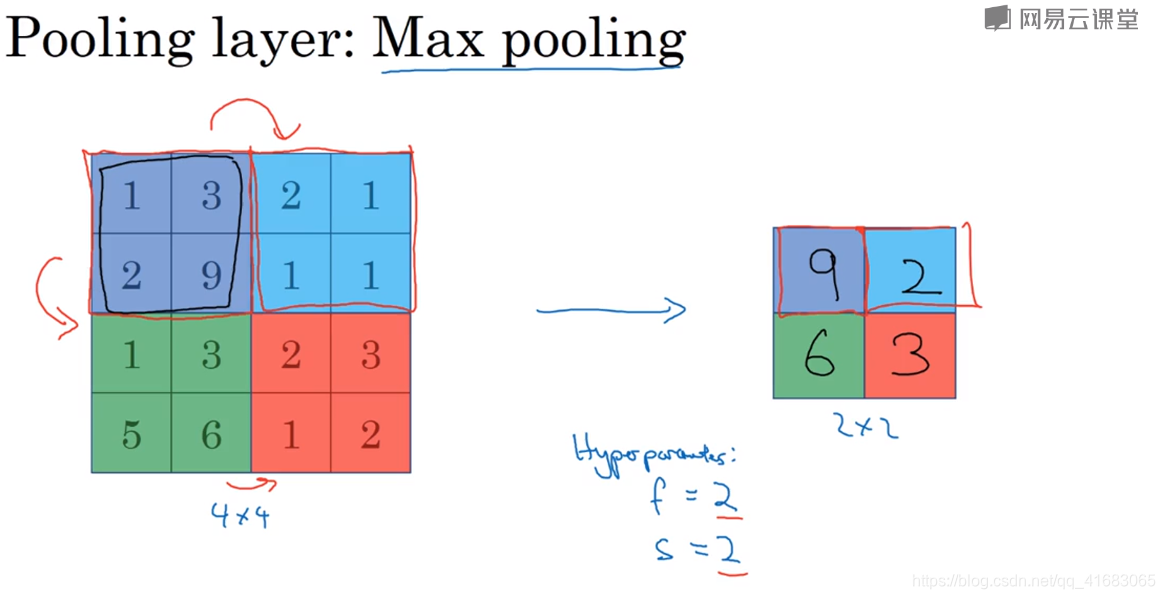

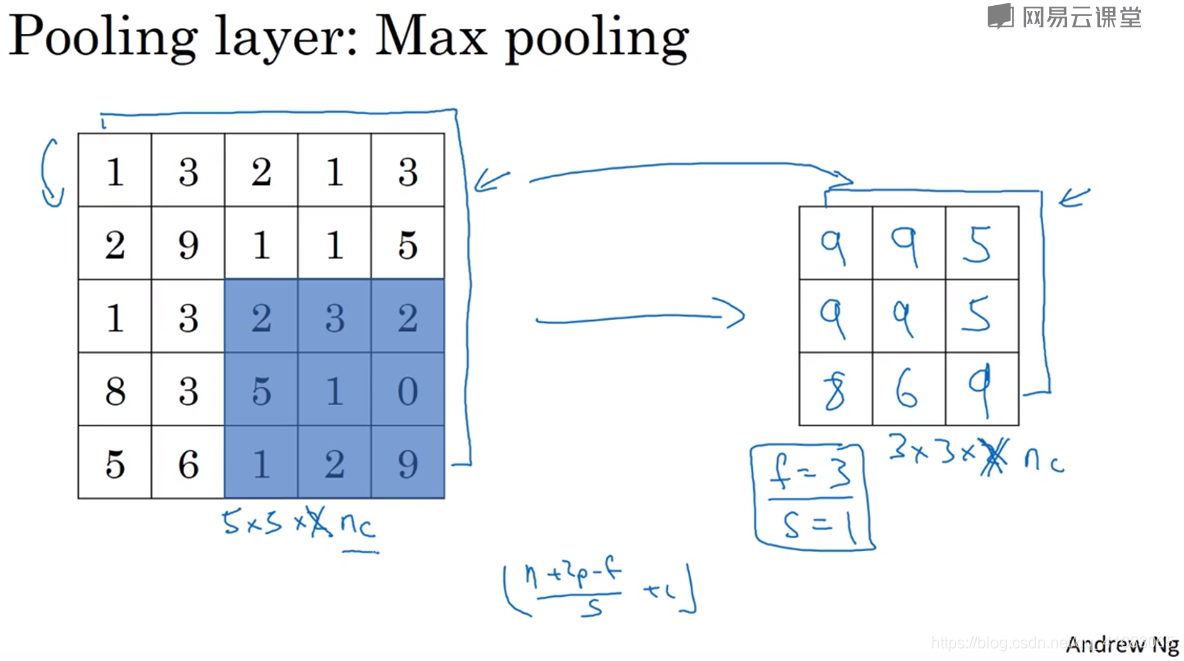

最大池化

最大池化的实际作用就是:

如果在过滤器中提取到某个特征,那么保留其最大值。如果没有提取到这个特征,可能相应部分不存在这个特征。

必须承认,人们使用最大池化的主要原因是其在很多试验中效果都很好。尽管刚刚描述的直观理解经常被引用,I don’t know if anyone fully knows if that’s the real underlined reason that max pooling works well in confidence.

其中一个有意思的特点是:它有一组超参数,但是没有参数需要学习。

计算池化层输出维度的公式与卷积层一致

另外,大部分情况下,MaxPooling很少用到Padding。

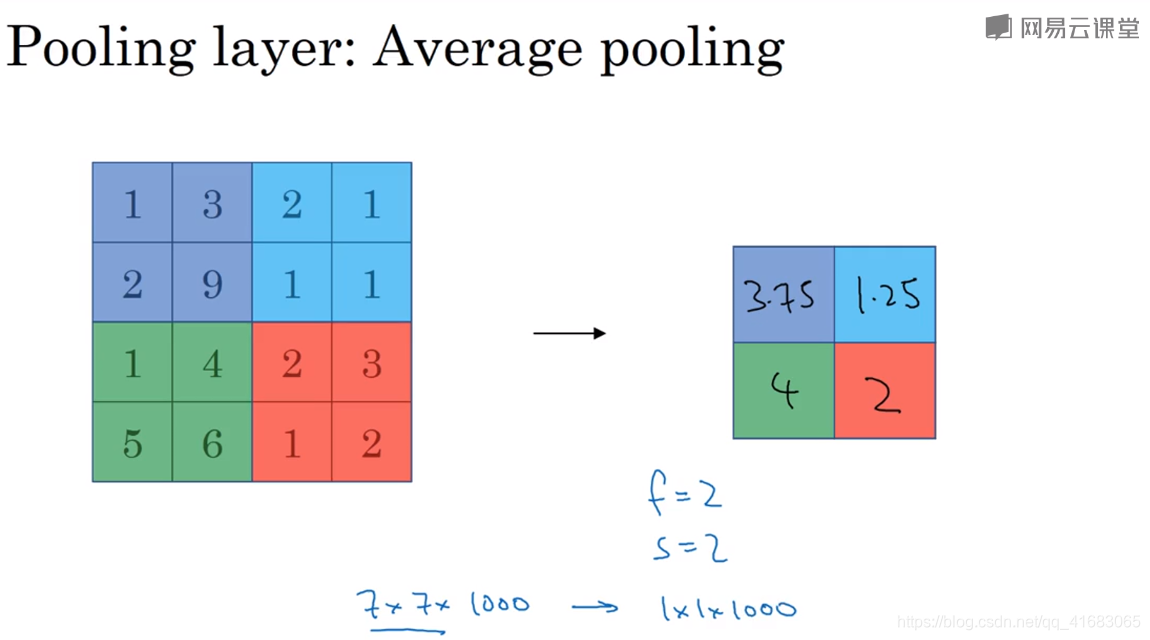

平均池化

在神经网络中,最大池化要比平均池化用的更多。

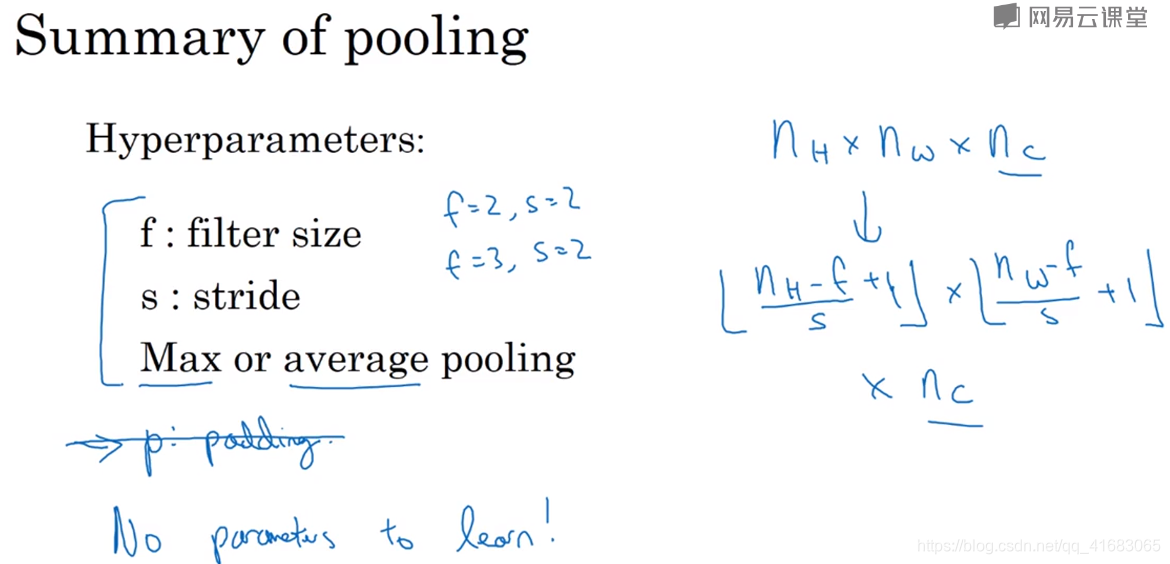

小结

上图有两个重点:

- 输出维度的计算。

- 不用Padding,没有需要更新的参数。

本文介绍了池化层在卷积神经网络中的作用,包括减少模型大小、提高运算速度及增强特征鲁棒性等。详细探讨了最大池化和平均池化的应用,并强调了池化层在计算上不需要学习参数的特点。

本文介绍了池化层在卷积神经网络中的作用,包括减少模型大小、提高运算速度及增强特征鲁棒性等。详细探讨了最大池化和平均池化的应用,并强调了池化层在计算上不需要学习参数的特点。

1884

1884

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?