1 信息论基础

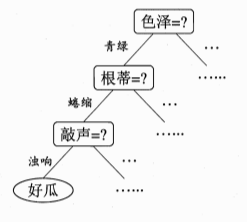

决策树我们都知道它的样子,就像树一样一级一级的细分,正如西瓜树上的图示

在构造决策树时,遇到的第一个问题就是,当前数据集上哪个特征在划分数据分类时起决定作用。为了找到决定性的特征,划分出最好的结果,我们要评估每个特征。怎么来评估这些特征,这就需要先了解一些概念

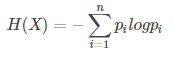

熵(entropy)是表示随机变量不确定性的度量,熵越大,随机变量的不确定性越大。

熵定义为

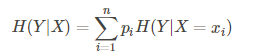

条件熵:条件熵H(Y|X)表示在已知随机变量X的条件下随机变量Y的不确定性。

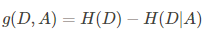

信息增益:

信息增益表示得知特征X的信息而使得类Y的信息的不确定性减少程度

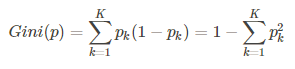

基尼指数:

基尼指数Gini(D)表示集合D不确定性,基尼指数Gini(D,A=a)表示集合D经A=a分割后的不确定性(类似于熵),基尼指数越小,样本的不确定性越小。

基尼指数定义为

本文深入探讨了决策树算法的基础,包括信息熵、信息增益和基尼指数等概念。介绍了ID3、C4.5和CART三种决策树算法及其区别,如C4.5通过信息增益率克服信息增益的不足。接着,讨论了回归树的原理,以及决策树防止过拟合的策略,如Pruning(裁剪)。同时,阐述了模型评估方法,如保持方法、随机二次抽样、交叉验证和自助法。最后提到了Sklearn库中决策树的相关参数,如criterion、splitter、max_depth等。

本文深入探讨了决策树算法的基础,包括信息熵、信息增益和基尼指数等概念。介绍了ID3、C4.5和CART三种决策树算法及其区别,如C4.5通过信息增益率克服信息增益的不足。接着,讨论了回归树的原理,以及决策树防止过拟合的策略,如Pruning(裁剪)。同时,阐述了模型评估方法,如保持方法、随机二次抽样、交叉验证和自助法。最后提到了Sklearn库中决策树的相关参数,如criterion、splitter、max_depth等。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

622

622

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?