【视频分割】

[2024] SMITE: SEGMENT ME IN TIME

论文链接:https://arxiv.org/pdf/2410.18538

代码链接:https://segment-me-in-time.github.io/

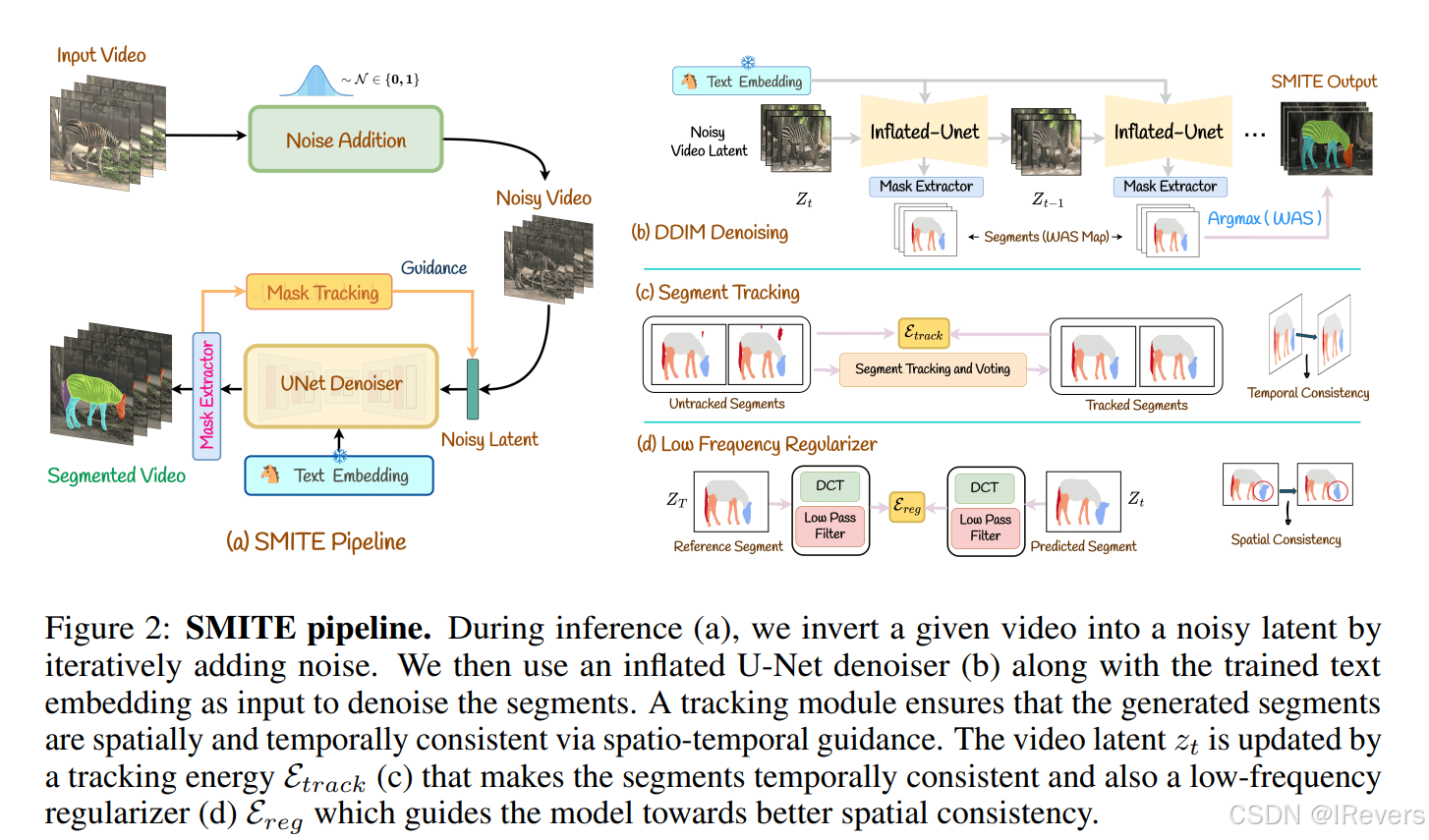

在视频中分割对象面临着重大挑战。每个像素都必须被准确标记,并且这些标签必须在帧之间保持一致。当分割的粒度是任意的时候,难度会进一步增加,这意味着段数可以随意变化,且遮罩仅基于一个或几个样本图像定义。在这篇论文中,我们通过采用一个预训练的文本到图像扩散模型并补充额外的跟踪机制来解决这个问题。我们展示了我们的方法能够有效应对各种分割场景,并且优于最先进的替代方案。

实验结果

【CNN】

[NeurIPS 2024 (Oral)] Convolutional Differentiable Logic Gate Networks

机构:斯坦福大学

论文链接:https://arxiv.org/pdf/2411.04732

代码链接:

随着机器学习模型推理成本的增加,人们对快速高效推理的模型越来越感兴趣。最近,有人提出了一种通过可微分松弛直接学习逻辑门网络的方法。逻辑门网络比传统的神经网络方法更快,因为它们的推理只需要逻辑门操作符,如NAND、OR和XOR,这些是当前硬件的基本构建块,可以高效执行。我们基于这一思想进行了扩展,引入了深度逻辑门树卷积、逻辑OR池化和残差初始化。这使得逻辑门网络的规模可以增加一个数量级以上,并利用卷积范式。在CIFAR-10上,我们仅使用6100万个逻辑门就达到了86.29%的准确率,这在提高最先进水平的同时,模型大小缩小了29倍。

实验结果:

【图像修复】

[2024] ReviveDiff: A Universal Diffusion Model for Restoring Images in Adverse Weather Conditions

论文链接:https://arxiv.org/pdf/2409.18932

代码链接:无

在具有挑战性的环境中拍摄的图片,例如夜间、雾天、雨天和水下环境,通常会遭受严重的质量退化,导致视觉质量显著下降。有效恢复这些退化的图像对于后续的视觉任务至关重要。虽然许多现有方法成功地为各个任务引入了特定的先验知识,但这些针对性的解决方案限制了它们在其他退化情况下的适用性。这项工作提出了一个通用的网络架构,名为“ReviveDiff”,它能够应对广泛的退化情况,并通过增强和恢复图像质量使其重获生机。所提方法受到了以下观察的启发:与运动或电子问题导致的退化不同,恶劣条件下的质量退化主要源于自然介质(如雾、水和低亮度),这通常保留了物体的原始结构。为了恢复这类图像的质量,作者利用了扩散模型的最新进展,并开发了ReviveDiff,以从宏观和微观层面恢复图像质量,涵盖了一些决定图像质量的关键因素,如锐度、失真、噪声水平、动态范围和色彩准确性。在涵盖五种退化条件的七个基准数据集上对ReviveDiff进行了严格评估:雨天、水下、低光、烟雾和夜间雾霾。实验结果表明,无论在定量还是视觉上,ReviveDiff均优于最先进的方法。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?