π^3:可扩展的置换等变视觉几何学习

1. 摘要(Abstract)

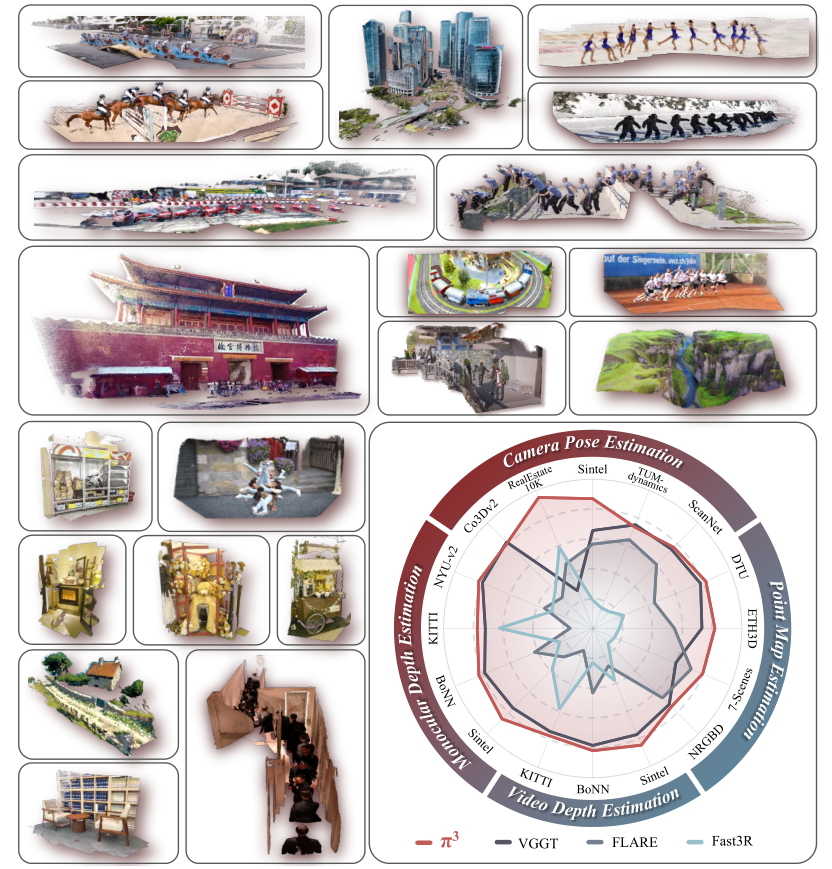

π³ 的神经网络模型,它主要用于视觉几何重建,简单来说就是从图片中还原出 3D 场景。

过去的方法在做这件事时,通常会选一张图片作为参考视角,所有的重建都基于这个视角。但这样有个问题,如果选的参考视角不好,重建效果就会大打折扣。而 π³ 不一样,它采用了一种完全置换等变的架构,不需要固定参考视角,就能预测出具有仿射不变性的相机姿态和具有尺度不变性的局部点图。

这一设计让 π³ 有很多优势:它对输入图片的顺序不敏感,非常稳健;而且扩展性很强,模型越大,性能越好;训练时收敛也更快。

在实验中,π³ 在很多任务上都表现出色,比如相机姿态估计、单目 / 视频深度估计、密集点图重建等,超过了之前的先进方法。比如在 Sintel 基准测试中,它把相机姿态估计的 ATE 从 VGGT 的 0.167 降到了 0.074,视频深度估计的绝对相对误差也从 0.299 提升到 0.233。同时,它还很高效,推理速度能达到 57.4 FPS,比很多同类模型都快。

不过,π³ 也有局限性,比如处理不了透明物体,重建的几何细节不如一些扩散模型,生成点云时还可能出现网格状伪影。

2. 引言(Introduction)

“Learning always beats inductive biases.” — Jonathan T.Barron, Radiance Fields and the Future of Generative Media

“学习永远胜过归纳偏置。”—— 乔纳森・T. 巴伦,《辐射场与生成式媒体的未来》

首先,研究者首次系统地指出并挑战了视觉几何重建中对固定参考视角的依赖,认为这种常见的设计选择引入了不利的归纳偏置,会限制模型的鲁棒性和性能。

其次,提出了一种名为π³的全新全置换等变架构,该架构消除了上述偏置,能够以纯相对的、逐视角的方式预测具有仿射不变性的相机姿态和具有尺度不变性的点图,完全无需全局坐标系。

再者,通过大量实验证明,π³在相机姿态估计、单目/视频深度估计以及点图重建等多个基准测试中都达到了新的最先进水平,性能超过了之前的主流方法。

最后,还表明该方法不仅对输入视角的顺序具有更强的鲁棒性,且随着模型规模扩大的扩展性更好,在训练过程中的收敛速度也明显更快。

3. 相关工作(Related Work)

传统 3D 重建方法:如运动恢复结构(SfM)、多视图立体匹配(MVS),依赖多阶段 pipeline 和迭代优化(如光束平差),流程复杂且耗时。

前馈 3D 重建方法:如 Dust3R、Fast3R、FLARE、VGGT 等,直接从图像回归 3D 结构,但均依赖固定参考帧,存在与传统方法相同的局限。

强调π³与现有方法的本质区别:完全摆脱参考帧依赖,采用置换等变设计。

4. 方法(Method)

π³置换等变架构:网络对输入图像序列的顺序不敏感,输入 permutation 时输出也相应 permutation,确保每个图像与输出(姿态、点图)一一对应,且无需位置嵌入或参考帧标记。

尺度不变局部几何:为每个图像预测基于自身相机坐标系的 3D 点图,通过求解最优尺度因子对齐预测与真值,解决单目重建的尺度模糊问题,并引入法向量损失和置信度损失优化重建。

仿射不变相机姿态:预测的相机姿态仅定义在相似变换(刚性变换 + 全局尺度)下,通过相对姿态监督(旋转用 geodesic 距离损失,平移用 Huber 损失)消除全局参考帧依赖。

模型训练:端到端训练,损失函数包含点重建损失、法向量损失、置信度损失和相机姿态损失,在 15 个多样化数据集上训练,涵盖室内外、合成与真实场景。

模型训练

我们的模型通过最小化一个复合损失函数L进行端到端训练,该函数是点重建损失、置信度损失和相机姿态损失的加权和:

为确保模型的鲁棒性和广泛适用性,我们在 15 个多样化数据集的大规模聚合数据上对其进行训练。这个组合数据集广泛涵盖了室内和室外环境,包含从合成渲染到真实世界拍摄的各类场景。具体数据集包括 GTA-SfM [35]、CO3D [21]、WildRGB-D [41]、Habitat [23]、ARKitScenes [2]、TartanAir [40]、ScanNet [5]、ScanNet++ [44]、BlendedMVG [43]、MatrixCity [15]、MegaDepth [16]、Hypersim [22]、Taskonomy [45]、Mid-Air [8] 以及一个内部动态场景数据集。模型训练的详细信息可参见附录。

5. 实验(Experiments)

任务评估:在四类任务上验证性能:

相机姿态估计:在 RealEstate10K、Co3Dv2、Sintel 等数据集上,角度精度和距离误差均优于 VGGT 等方法。

点图重建:在 DTU、ETH3D、7-Scenes 等数据集上,精度、完整性和法向量一致性表现优异。

视频深度估计:在 Sintel、Bonn、KITTI 上,绝对相对误差(Abs Rel)和阈值精度(δ<1.25)领先,且推理速度达 57.4 FPS,快于 VGGT(43.2 FPS)。

单目深度估计:与专门优化单帧的 MoGe 性能相当,在多帧前馈方法中最优。

鲁棒性与扩展性分析:

对输入顺序变化的鲁棒性:在 DTU 和 ETH3D 上,重建指标的标准差接近 0,远低于 VGGT 等方法。

消融实验:验证尺度不变点图和仿射不变姿态是性能提升的关键。

扩展性:模型规模(小 / 中 / 大)增大时,性能持续提升,且收敛速度更快。

6. 结论(Conclusion)

总结π³的核心贡献:通过全置换等变架构消除参考视角依赖,提升视觉几何重建的鲁棒性、扩展性和性能。证明无参考帧系统的可行性,为更稳定、通用的 3D 视觉模型提供了新思路。

1129

1129

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?