趁我未失忆之前,记录过去曾经的自己

文章目录

前言

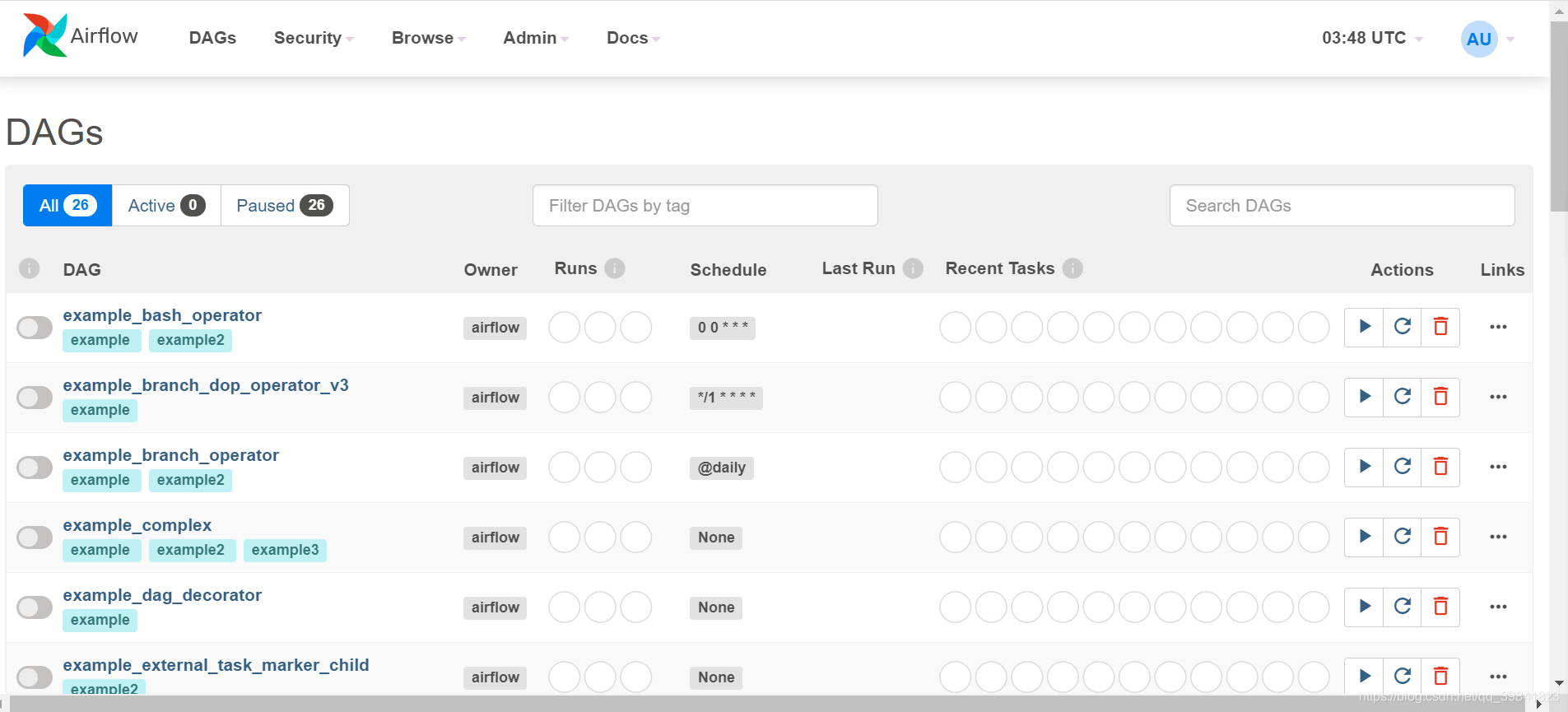

这一篇只介绍Airflow web 页面介绍,想要了解架构或是安装或是workflow的编写,可以参考我发布的其他相关文章,首先我们进入 http://localhost:8080会进入 Airflow的管理页面!。

一、DAG

標題是 DAGs,這是 Directed Acyclic Graph (有向无环图)的簡稱,也是 Airflow 區分不同 Data Pipeline 的方式,這裡我們要先知道的是一個 DAG 是由多個 Task 組成,每個 Task 是分開執行的,而 Task 是 Airflow 執行基礎單位,後面我們會在更深入的探討 DAG & Task 的關係。

- 最左邊有一排 On & Off 的開關,如果是 Off 的狀態代表 Scheduler 不會依照 Schedule 欄位的時間去排程,但我們一樣可以手動 trigger 一個 DAG 去執行。

- DAG 欄位代表的是每一個 DAG 的名稱,DAG 的名稱同時也是 DAG 的 id,所以之後我們在實作自己的 DAG 時,不能與已經有的 DAG 名稱重複。

- Owner 欄位則代表這個 DAG 是屬於誰的,實際開發中,可以把 Owner 欄位當成實作該 DAG 人員的名稱。

- Runs 欄位則代表這個 DAG 整体状态是成功还是失败还是进行中。

圈1 success:总共执行成功的dag数,执行次数

圈2 runing:正在执行dag数

圈3 faild:执行失败的dag数 - Schedule 欄位代表什麼時間要執行 DAG,表示方式跟 Crontab 類似。

- Last Run栏位表示dag最后执行的时间点

- Recent Tasks 栏位这里包含9个圆圈,每个圆圈代表task的执行状态和次数。

圈圈1 success:现实成功的task数,基本上就是该tag包含多少个task,这里基本上就显示几。

圈圈2 running:正在运行的task数

圈圈3 failed:失败的task数

圈圈4 unstream_failed:上游的失败的task数

圈圈5 skipped:跳过的task数

圈圈6 up_for_retry:执行失败的task,重新执行的task数

圈圈7 up_for_reschedule :执行重排程的数

圈圈8 queued:队列,等待执行的task数

圈圈9 none :

圈圈10 scheduled:刚开始调度dag时,这一次执行总共调度了dag下面多少个task数,并且随着task的执行成功,数值逐渐减少。

圈圈11 sensing: - Actions: 针对这DAG有Trigger,Refresh,Delete动作

- Links :会触发这个DAG更多细节的相关操作页面,分别为Tree View,tree Graph View,Task Duration,Task Tries,Landing Times,Gantt,Details,Code这几个标签,以下针对这些标签的功能进行讲解。

1.Tree View

这里有将DAG做成树表示形式,每个跨时间的跨度。 如果管道延迟,您也可以从这个页面快速查看不同的步骤在哪里,并确定阻塞在哪一个步骤。

当dag执行的时候,可以点入,查看每个task的执行状态(基于树状视图),状态:queued,running,success,failed,up_for_retry,up_for_reschedule,upstream_failed,skipped,scheduled,no_status.在未來dag执行的时候,我們會很常進入 Tree View 查看每一次 DAG 的執行狀況。看看每个任务进行的状态如何。

2.Graph View

点进Graph View 後,Airflow 会用图形的方式呈现 Directed Acyclic Graph(有向无环图),这一页没有很明显看到每次执行的情况在這一頁雖然沒辦法很明顯看到每次執行的情況, 但對於理解每個 DAG 執行的流程很有幫助。

3.Tasks Duration

您在过去N次运行中的不同任务的持续时间。该视图使您可以找到异常值,并快速了解DAG在许多运行中所花费的时间。这个图片是截至于官网。

4.Task Tries

每个task的重试次数。

5.Gantt

这里的甘特图使您可以分析任务持续时间和重叠情况。您可以快速确定卡在那里以及特定DAG运行所花费的时间。这个图片是截至于官网。

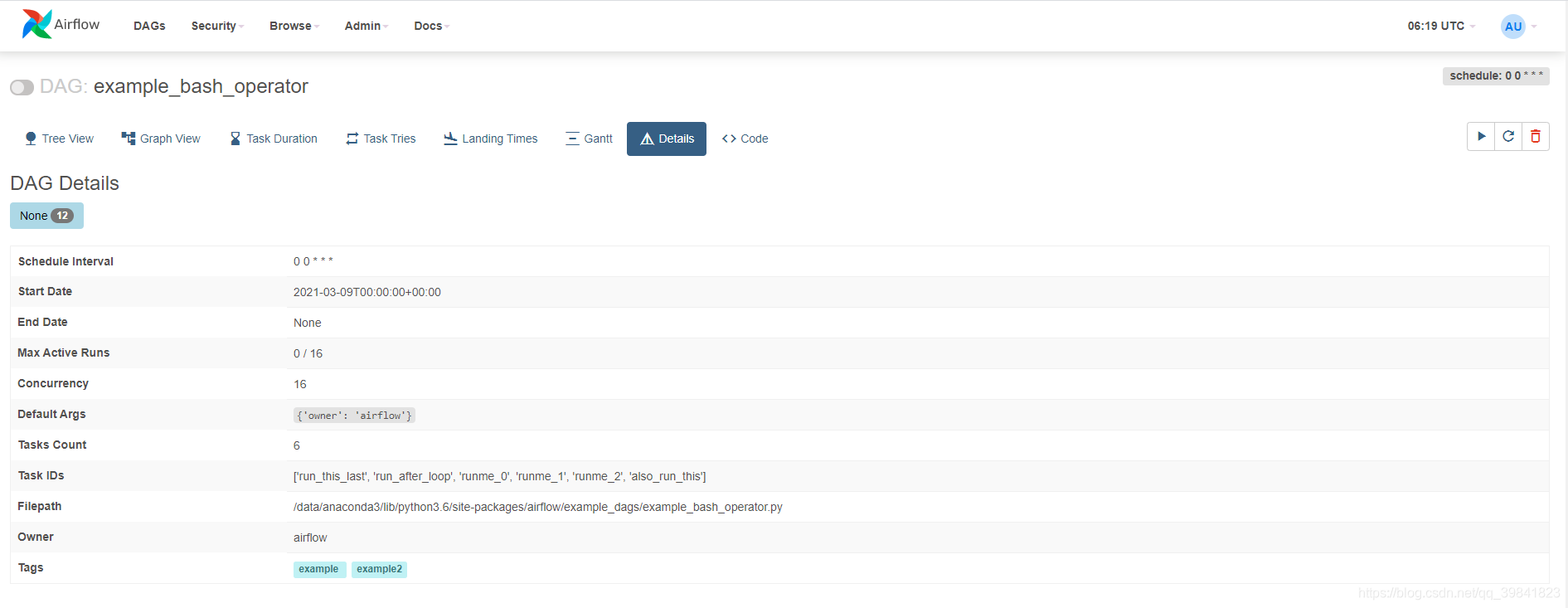

6.Details

这个DAG详细讯息。

7.code

在这个Code 分页,可以看到实际的程序编码。这个DAG的怎么进行与那个任务有依赖关系然后任务失败成功做什么等等,都可以在这个code页面下定义。ˊ至于怎么写可以再我其他文章中查看。

二、執行 DAG

我们执行一个 DAG 这里用 example_branch_dop_operator_v3 做范例,先点击最左边的选项将 Off 变成 On,然后过一阵子,会发现 Scheduler 已经是 Schedule */1 * * * * 开始执行example_branch_dop_operator_v3 了。

点这个DAG ,进入Tree View页面,深绿是执行成功,浅绿是正在run等,相对应的颜色就如同右上角一般。把滑鼠移到每个图框上会出现黑色底白字框框,分别记录每个触发trigger 执行过程。

最后,随意点击一个有颜色的方形框框,右上角会有 View Log按钮,点进去会看到Task执行的Log,透过这个功能我们能查看每个Task执行记录。

三、Browse 浏览标签

1.SLA Misses

如果有一个或多个实例未成功,则会发送警报电子邮件,详细说明错过其SLA的任务列表。 该事件也记录在数据库中,并在Web UI中的Browse-> Missed SLA下可用,可以分析和记录事件。

2.DAG Runs

显示所有DAG状态

3.Jobs

查看dag的执行状态,开始时间和结束时间等指标

4.Audit logs

查看所有dag下面对应的task的日志,并且包含检索.

5.Task Instance

查看每个task实例执行情况

6.Task Reschedule

跟踪重新安排的任务实例,暂无图表。

四、Admin标签

- Pools: 可以将DAG建立在同一个池中,统一管理分类,我们点进去default_pool就可以发现这池的任务清单。也可以建立不同的池。

-

Configuration:查看airflow的配置,即:./airflow_home/airflow.cfg

-

Connections:最后我们来看看Airflow 如何管理 Credential,进来后会发现已经有预设的 Connections。我们的Task需要通过Hook访问其他资源, Hook仅仅是一种访问方式, 就像是JDBC driver一样, 要连接DB, 我们还需要DB的IP/Port/User/Pwd等信息. 这些信息不太适合hard code在每个task中, 可以把它们定义成Connection, airflow将这些connection信息存放在后台的connection表中. 我们可以在WebUI的Admin->Connections管理这些连接.

-

Variables:没有包含task_id/dag_id属性。用来定义一些系统级的常量或变量, 我们可以在WebUI或代码中新建/更新/删除Variable. 也可以在WebUI上维护变量.也可以上传

-

-

XComs:和Variable类似, 用于Task之间共享一些信息. XCom 包含task_id/dag_id属性, 适合于Task之间传递数据, XCom使用方法比Variables复杂些. 比如有一个dag, 两个task组成(T1->T2), 可以在T1中使用xcom_push()来推送一个key value, 在T2中使用xcom_pull()来获取这个key value.

五、Docs标签与Security标签

就是提供一些官方文档与用户清单与用户权限管理等功能,这里我就不仔细介绍。

4908

4908

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?