CART 决策树 [Breiman et al., 1984] 使用"基尼指数" (Gini index)来选择划分属性。CART 是Classification and Regression Tree的简称,这是一种著名的决策树学习算法,分类和回归任务都可用。

一、基尼值和基尼指数

基尼值Gini(D):从数据集D中随机抽取两个样本,其类别标记不一致的概率。故,Gini(D)值越小,数据集D的纯度越高。

数据集 D 的纯度可用基尼值来度量:

其中:![]()

基尼指数Gini_index(D):一般,选择使划分后基尼系数最小的属性作为最优化分属性。

二、案例

请根据下图列表,按照基尼指数的划分依据,做出决策树。

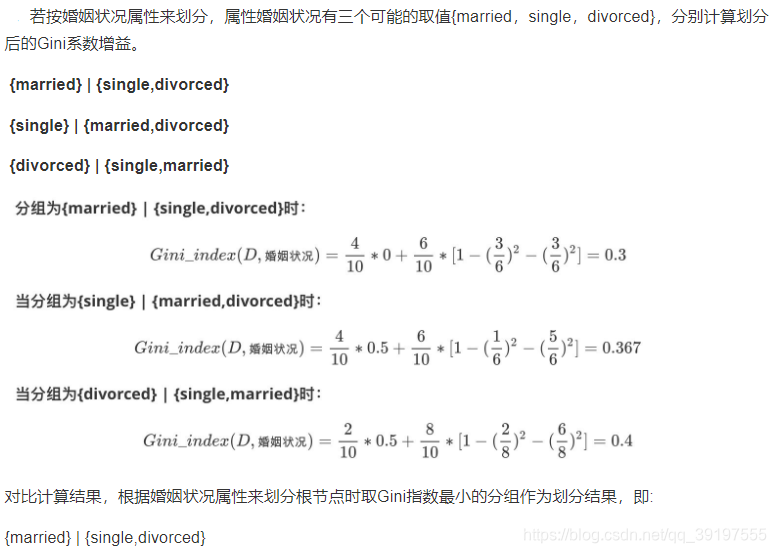

1,对数据集非序列标号属性{是否有房,婚姻状况,年收入}分别计算它们的Gini指数,取Gini指数最小的属性作为决策树的根节点属性。

2、第二次大循环

3、经过如上流程,构建的决策树,如下图:

现在总结一下CART的算法流程

while(当前节点"不纯"):

1.遍历每个变量的每一种分割方式,找到最好的分割点

2.分割成两个节点N1和N2

end while

每个节点足够“纯”为止

本文介绍了CART决策树算法,该算法使用基尼指数选择最优划分属性。基尼指数衡量数据集的纯度,数值越小表示纯度越高。在构建决策树的过程中,通过计算各属性的基尼指数,选取最小值作为划分依据。文章还提供了一个案例,展示了如何依据基尼指数构建决策树的过程,并总结了CART算法的基本流程。

本文介绍了CART决策树算法,该算法使用基尼指数选择最优划分属性。基尼指数衡量数据集的纯度,数值越小表示纯度越高。在构建决策树的过程中,通过计算各属性的基尼指数,选取最小值作为划分依据。文章还提供了一个案例,展示了如何依据基尼指数构建决策树的过程,并总结了CART算法的基本流程。

4545

4545

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?