一、研究背景

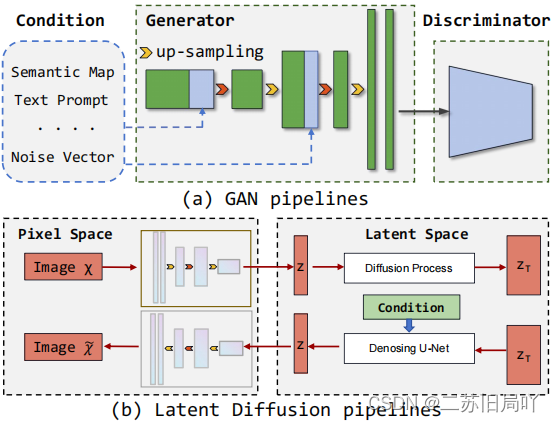

1.GANs和扩散模型的发展滋生了大量高度真实的合成图像,并增大了误用风险。

2.以往的深度伪造检测任务致力于设计新的检测算法,明显缺乏对生成架构的探究。

3.为了提升检测算法的泛化性,以往工作通常优化检测算法、扩充数据集、预训练模型,但是缺乏域不变表征使这些方法依旧难以应用于未知域。

4.当前一些工作主要研究上采样对整个图像在频域的影响,并用频谱表征上采样伪影,但是GAN不同的频域模式限制了频域伪影的泛化性能。

二、研究动机

1.上采样被广泛用于GAN模型和扩散模型,因此,在提升深度伪造检测泛化性上具有巨大潜力。

2.上采样使局部像素之间产生联系,同时,后续CNN的平移不变性使这种联系得以保存。

3.不管生成效果再怎么真实,上采样层的痕迹始终存在于局部的图片像素中。

三、研究目标

通过重新探究生成模型的上采样模块的像素级影响,实现域无关的伪造检测。

四、技术路线

重新思考基于CNN的深度伪造生成器,并构建了伪影的通用表征近邻像素关系Neighboring Pixel Relationships (NPR),提升深度伪造检测的泛化性。

- 引入Neighboring Pixel Relationships (NPR)的概念。

x^\hat x<

该研究关注深度伪造检测中上采样操作的重要性,指出上采样在GANs和扩散模型中的广泛应用导致了局部像素间的联系,这些联系即使在高度真实的图像中也能被检测到。通过提出Neighboring Pixel Relationships (NPR)的概念,该研究旨在建立一种域无关的伪造检测方法,提高检测算法的泛化性能。实验结果表明,上采样的伪影对于检测具有更好的泛化性。

该研究关注深度伪造检测中上采样操作的重要性,指出上采样在GANs和扩散模型中的广泛应用导致了局部像素间的联系,这些联系即使在高度真实的图像中也能被检测到。通过提出Neighboring Pixel Relationships (NPR)的概念,该研究旨在建立一种域无关的伪造检测方法,提高检测算法的泛化性能。实验结果表明,上采样的伪影对于检测具有更好的泛化性。

订阅专栏 解锁全文

订阅专栏 解锁全文

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?