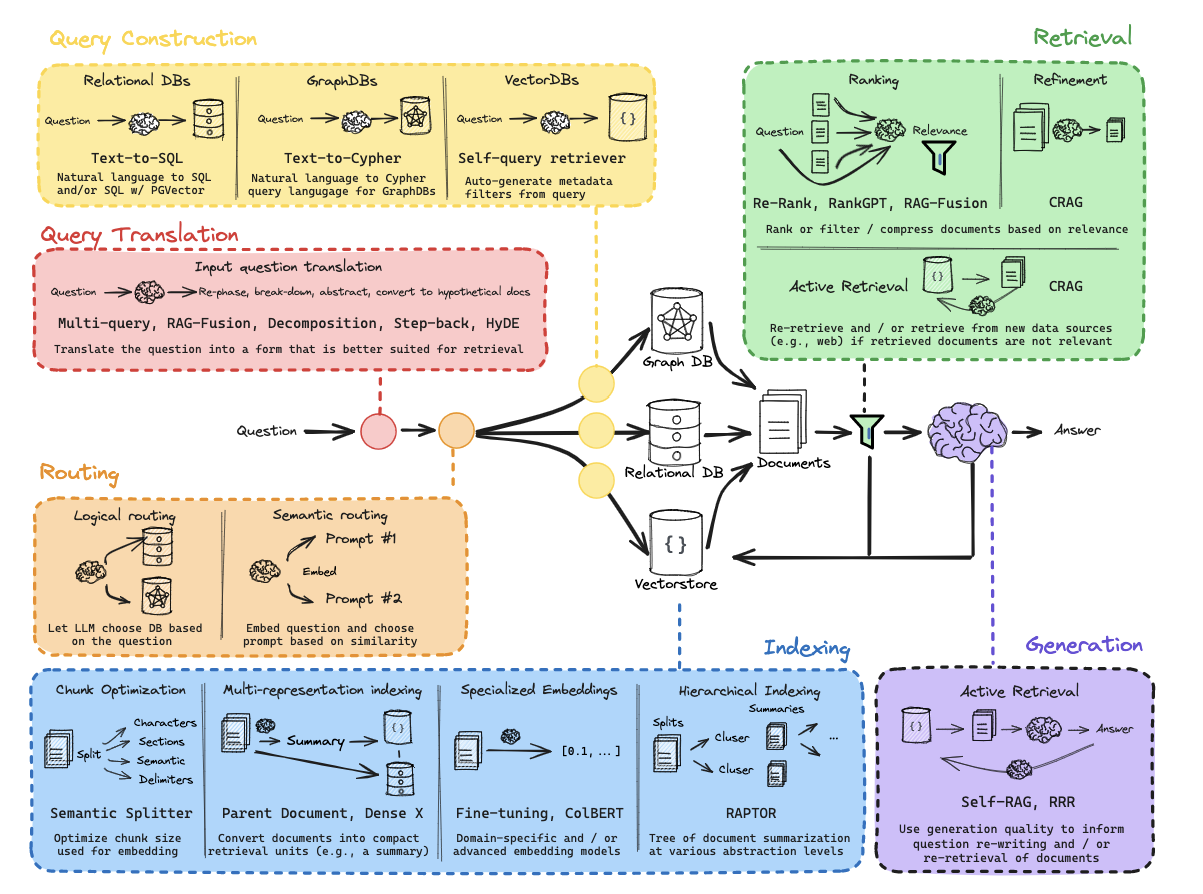

上一篇文章中,我们探讨了如何通过Query Translation(问题翻译)优化问题表达,使其更适合检索。探讨了Multi-Query、RAG-Fusion、Decomposition等让问题"更易被正确回答"的方法。然而检索前优化的工作不止于此。我们还需要解决两个关键问题:

- 如何为问题选择最合适的数据源(如向量数据库、关系型数据库或图数据库))?

- 如何弥合自然语言问题与结构化数据之间的差距?

为解决这些问题,我们需要引入两个关键环节:路由决策与查询构建。 - 路由决策:根据问题的语义和上下文,将问题路由到合适的数据源。

- 查询构建:专注于将自然语言问题转换为结构化查询语言(如SQL、Cypher等),或者生成适合特定数据源的查询指令。

接下来,我们将深入探讨路由决策和查询构建的核心原理,代码实现等等。

路由决策

路由,基本上就是将query导向正确的数据源,大部分情况下,这个数据源指的是不同的数据库, 比如有3个不同的库存储知识,包括关系数据库,图数据库,以及向量存储数据库。在回答一个问题的时候,要知道去哪个数据库里检索相关文档。数据源也可以指不同的prompt,比如针对数学问题,使用数学问题的prompt 模板。

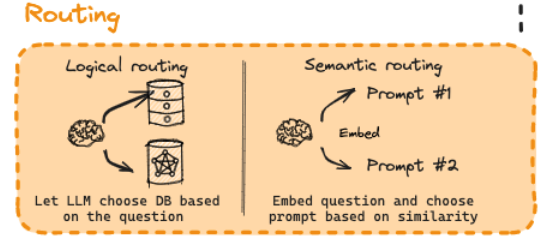

在RAG应用中,根据决策类型不同,路由主要分为:

- 逻辑路由:依赖LLM对问题进行推理,并根据推理结果来选择最合适的数据源。

- 语义路由:根据问题与数据源的语义相似性选择最合适的prompt或者数据源。

逻辑路由

原理解析

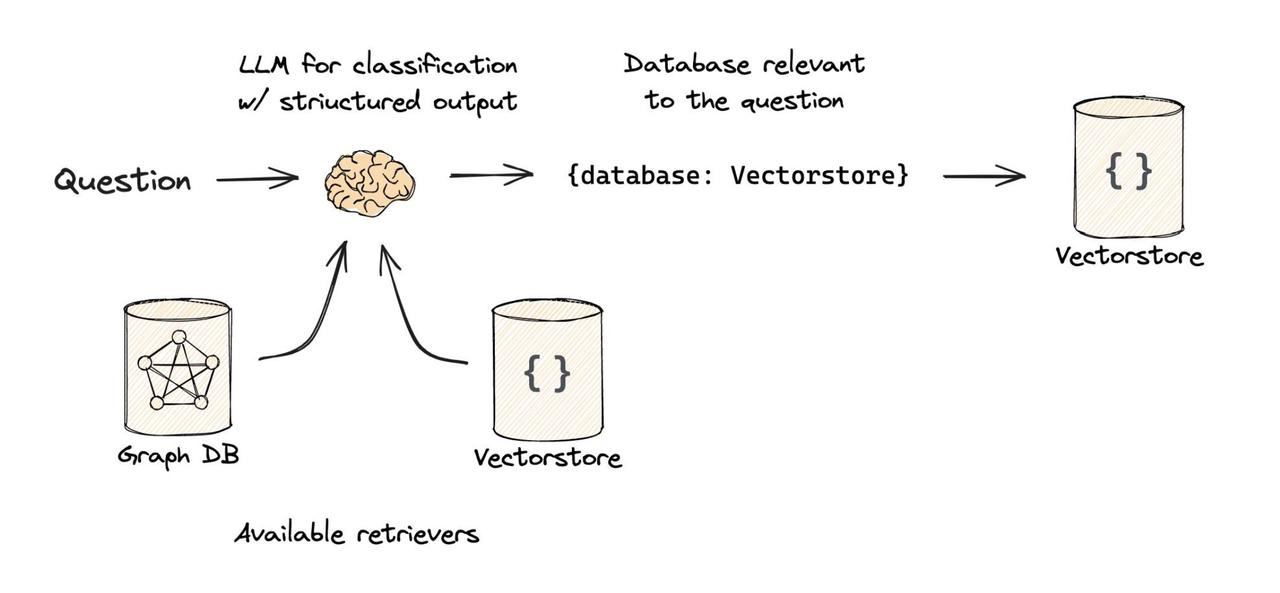

逻辑路由是基于规则和推理的路由策略,主要依赖于LLM对用户输入进行推理分析,并根据推理的结果来选择最合适的数据源或处理流程。这种方法通常采用分类的方式,将查询归类到特定的数据源或处理管道中。

逻辑路由的实现较为简单,给定LLM关于不同数据源的信息,让LLM 推理当前输入的问题应该使用哪一个数据源。但是逻辑路由对模型的要求较高,需要LLM具有强大的推理能力。

代码实现

对于具有函数调用功能的LLM来说,逻辑路由的核心就是使用模型来做分类。

举个例子,要根据用户问题中涉及到了哪种语言,将其路由到对应的数据源(python,js, 还是 Golang 文档)。核心步骤是通过强制LLM输出预定义格式,确保下游检索步骤能精准定位知识库。

首先,定义RouteQuery,这是限制LLM必须遵循的输出格式。这里通过定义data_source属性必须是3个预定义值之一。

from typing import Literal

from langchain_core.prompts import ChatPromptTemplate

from langchain_core.pydantic_v1 import BaseModel, Field

from langchain_openai import ChatOpenAI

# Data model

class RouteQuery(BaseModel):

"""Route a user query to the most relevant datasource."""

# 使用Pydantic模型约束LLM输出格式,限定 datasource 字段只能为三个预定义值之一。

datasource: Literal["python_docs", "js_docs", "golang_docs"] = Field(

...,

# 通过 description 字段隐式引导模型关注「编程语言」这一关键特征。

description="Given a user question choose which datasource would be most relevant for answering their question",

)

这里通过LLM的函数调用实现结构化输出

# LLM with function call

llm = ChatOpenAI(model="gpt-3.5-turbo-0125", temperature=0)

structured_llm = llm.with_structured_output(RouteQuery)

# 要求LLM根据question 中的编程语言特性进行决策

# Prompt

system = """You are an expert at routing a user question to the appropriate data source.

Based on the programming language the question is referring to, route it to the relevant data source."""

prompt = ChatPromptTemplate.from_messages(

[

("system", system),

("human", "{question}"),

]

)

# Define router

router = prompt | structured_llm

with_structured_output是什么?

在要求LLM返回结构化输出的时候,这里使用llm.with_strucured_output()方法。这是langchain为了让LLMs返回结构化输出所定义的一个公共接口。通过调用这个方法(并传递一个JSON模式或Pydantic模型),模型将自动添加任何必要的参数和输出解析器。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3446

3446

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?