import jieba as jb

import numpy as np

import pandas as pd

from gensim.models.doc2vec import Doc2Vec, TaggedDocument

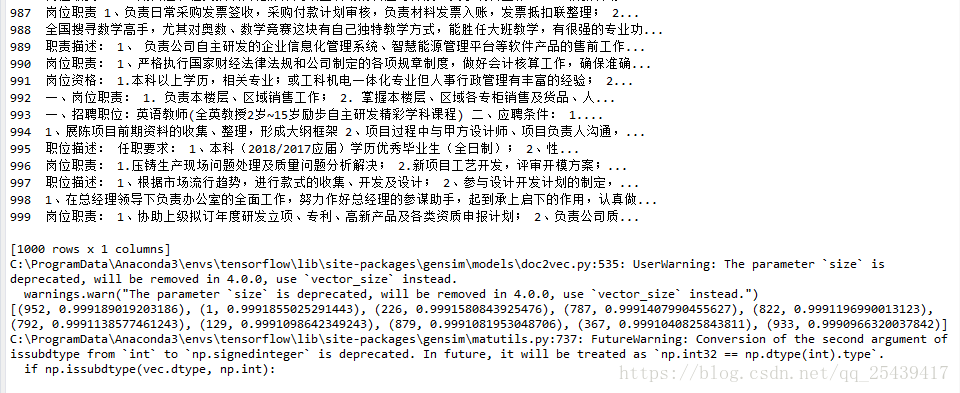

shixi = pd.read_table('shixi.txt')

print(shixi)

s = '哈哈哈哈大师赛的小康康'

w = jb.cut(s)

jdlist = list()

for i in range(1000):

w = jb.cut(shixi.content[i])

jdlist.append(TaggedDocument(' '.join(w).split(' '),[i]))

#print(jdlist)

model = Doc2Vec(jdlist,dm=1, dm_concat=1, size=100, window=2, hs=0, min_count=2, workers=8)

print(model.docvecs.most_similar(63)[0][0])

通过genism的库,使用doc2vec看看基于文档的初步分类效果怎么样。

事实证明结果不太行,会把 嵌入式的岗位,匹配到 销售等。

需要进一步对文档分词进行过滤和处理。

先看

本文探讨了使用Genism库的Doc2Vec进行文本分类的效果,发现对于文档分类存在不准确性,尤其是在区分程序员岗位和销售等职位时。通过引入jieba分词和停用词过滤,分类精度略有提升,但仍有不足。作者指出干扰信息过多可能是主要原因,并计划尝试TFIDF算法,聚焦于文本中的关键信息,以提高分类准确性。

本文探讨了使用Genism库的Doc2Vec进行文本分类的效果,发现对于文档分类存在不准确性,尤其是在区分程序员岗位和销售等职位时。通过引入jieba分词和停用词过滤,分类精度略有提升,但仍有不足。作者指出干扰信息过多可能是主要原因,并计划尝试TFIDF算法,聚焦于文本中的关键信息,以提高分类准确性。

订阅专栏 解锁全文

订阅专栏 解锁全文

1394

1394

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?