前言

在深度学习中,模型的初始化是训练过程中的一个重要步骤。适当的初始化可以加快模型的收敛速度,提高模型的性能。PyTorch作为流行的深度学习框架,提供了多种初始化方法,其中nn.init.constant_是其中之一。该函数用于将神经网络中的权重和偏置项初始化为一个常数值。本文将详细介绍nn.init.constant_函数的基本用法、原型、示例,并与其他初始化方法进行对比,最后进行总结。

函数与案例详解

基本用法

nn.init.constant_函数将输入的张量(tensor)中的所有元素初始化为指定的常数值。这个函数通常用于初始化神经网络的权重(weights)和偏置(biases)参数。

原型

torch.nn.init.constant_(tensor, val)

参数说明:

tensor:需要初始化的张量。

val:要设置的常数值

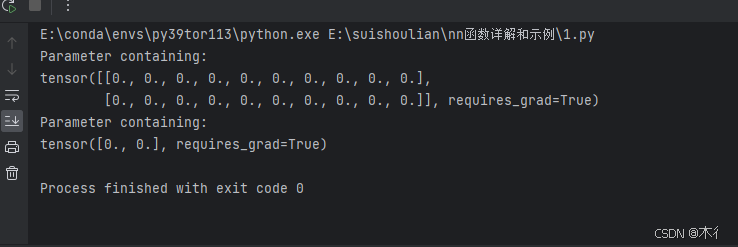

示例

假设我们有一个简单的全连接层(nn.Linear),我们想要将其权重和偏置都初始化为0。以下是如何使用nn.init.constant_来实现这一点的示例:

import torch

import torch.nn as nn

# 创建一个全连接层,输入特征数为10,输出特征数为2

fc = nn.Linear(10, 2)

# 使用nn.init.constant_将权重和偏置初始化为0

nn.init.constant_(fc.weight.data, 0)

nn.init.constant_(fc.bias.data, 0)

# 打印初始化后的权重和偏置

print(fc.weight)

print(fc.bias)

函数对比

与其他初始化方法的对比

PyTorch的torch.nn.init模块提供了多种初始化方法,如均匀分布初始化(uniform_)、正态分布初始化(normal_)、Xavier/Glorot初始化(xavier_uniform_, xavier_normal_)、He初始化(kaiming_uniform_, kaiming_normal_)等。

均匀分布初始化(uniform_):将张量的元素初始化为指定范围内的均匀分布的随机数。

正态分布初始化(normal_):将张量的元素初始化为指定均值和标准差的正态分布的随机数。

Xavier/Glorot初始化:根据输入和输出的神经元数量自适应地调整初始化范围,以保持激活值的方差和梯度的方差在传播过程中尽量一致。

He初始化:也称为ReLU初始化,特别适用于ReLU激活函数,它通过考虑非线性激活函数来修正Xavier初始化的方差缩放。

与这些方法相比,nn.init.constant_提供了一种简单的初始化方式,即将所有参数初始化为相同的常数值。这种方法虽然简单,但在某些情况下可能会导致训练过程中的梯度消失或爆炸问题,因为它没有考虑到网络结构的复杂性或激活函数的影响。

总结

nn.init.constant_是PyTorch中一个用于初始化神经网络参数的函数,它将张量中的所有元素初始化为指定的常数值。虽然这种方法简单直观,但在实际应用中,可能需要根据网络结构和激活函数的特点选择合适的初始化方法。通过与其他初始化方法的对比,我们可以更好地理解nn.init.constant_的适用场景和局限性。

本文介绍PyTorch中nn.init.constant_函数的用法,用于将神经网络参数初始化为常数值。文章对比了不同初始化方法,并提供了全连接层的示例。

本文介绍PyTorch中nn.init.constant_函数的用法,用于将神经网络参数初始化为常数值。文章对比了不同初始化方法,并提供了全连接层的示例。

1251

1251

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?