部署文档

一:安装jdk(必须1.8及以上版本)

1.检测系统是否有自带的jdk环境 java -version

2.如果有自带jdk则检测jdk的安装包 rpm -qa | grep java

3.根据检测的包名卸载jdk rpm -e --nodeps +包名

4.检测是否还存在jdk安装包 rpm -qa | grep java

5.自带jdk卸载完毕后 ,新建一个存放jdk的文件夹,然后下载1.8及以上版本的jdk

下载链接(1.8):https://www.oracle.com/java/technologies/javase/javase-jdk8-downloads.html

选择linux版本64位的jdk下载

解压安装jdk,并配置jdk环境

修改配置文件 vi /etc/profile

6.输入source /etc/profile 重新加载配置文件

7.输入java -version 查看jdk安装情况

二:安装zookeeper

1.下载zookeeper

- 新建一个存放zookeeper的文件夹 使用tar -zxvf+压缩文件名 进行解压安装

- 进入zookeeper的conf目录下 复制 zoo_sample.cfg 文件 命名为zoo.cfg

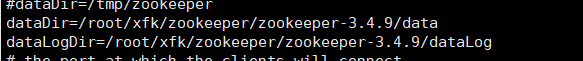

- 查看zoo.cfg文件的 dataDir 和dataLogDir 的路径配置,并在自己的目录下检查是否存在这两个文件夹,若不存在则创建

- 进入zookeeper的bin目录启动zookeeper

./zkServer.sh start (启动zookeeper)

./zkServer.sh stop (停止zookeeper)

./zkServer.sh restart(重启zookeeper)

./zkServer.sh status (查看zookeeper状态)

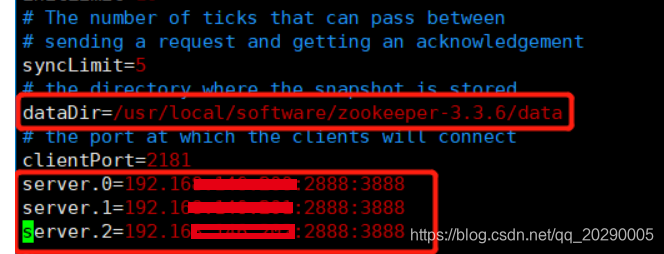

6.如果是集群模式 ,则需要在每台机器上都配置zoo.cfg文件,并增加配置 server.A=B:C:D 配置

A:其中 A 是一个数字,表示这个是服务器的编号;

B:是这个服务器的 ip 地址;

C:Leader选举的端口;

D:Zookeeper服务器之间的通信端口。

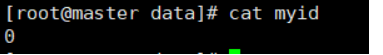

- 在dataDir指定的路径下创建myid文件,在文件中写上A的数字编号就可以(每台机器都配置)

例如:

- 配置环境变量(不是必须步骤,但是如果不配置,每次启动zk需要在bin目录下)

#set zookeeper environment

export ZK_HOME=/usr/local/software/zookeeper-3.3.6

export PATH=$PATH:$ZK_HOME/bin

然后 source /etc/profile 重启配置文件,启动服务

三:安装MySql

- 下载路径https://dev.mysql.com/downloads/mysql/

或者 wget http://dev.mysql.com/get/Downloads/MySQL-5.7/mysql-5.7.17-linux-glibc2.5-x86_64.tar.gz

或者

wget http://dev.mysql.com/get/Downloads/MySQL-5.6/MySQL-5.6.22-1.el6.i686.rpm-bundle.tar

我这里用的第三种

- 安装服务

rpm -ivh MySQL-server-5.6.22-1.el6.i686.rpm

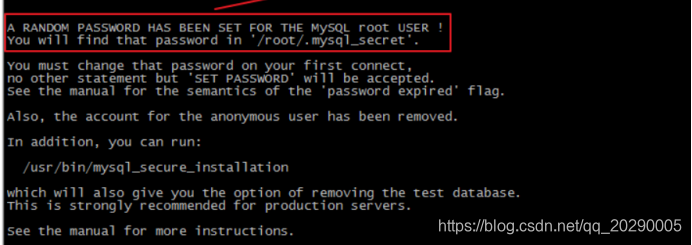

(如果出现报错,根据报错安装依赖,注意安装提示,随机生成的密码保存在如下文件中)

- 安装client

rpm -ivh MySQL-client-xxxxxxxxx - 执行 service mysql status 查看mysql进程,出现MySql is not running则服务未启动

- 启动mysql --service mysql start

- 使用root账号登录mysql # mysql -uroot -p

- 修改root用户密码SET PASSWORD = PASSWORD('123456');

8.系统启动时自动启动mysql服务

加入到系统服务:

chkconfig --add mysql

自动启动:

chkconfig mysql on

查询列表:

Chkconfig

- 开启远程访问并打开防火墙3306端口

四:安装kafka

- 下载路径 https://kafka.apache.org/downloads

- 创建kafka文件夹,并解压下载文件

- 进入kafka的config目录下,修改server.properties

# broker的全局唯一编号,不能重复

broker.id=0

# 监听

listeners=PLAINTEXT://:9092

# 日志目录log.dirs=/home/hadoop/kafka-logs

# 配置zookeeper的连接(如果不是本机,需要该为ip或主机名)

zookeeper.connect=localhost:2181

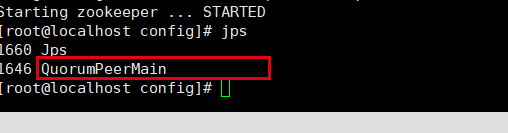

- jps查看zookeeper是否启动(没启动的话需要启动zookeeper)

5.启动kafka

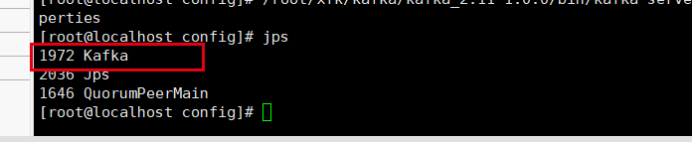

/root/xfk/kafka/kafka_2.11-1.0.0/bin/kafka-server-start.sh -daemon /root/xfk/kafka/kafka_2.11-1.0.0/config/server.properties![]()

不加 -daemon参数,界面会进入一个阻塞状态(建议加上)

输入jps查看进程,进程已启动

6.创建topic

kafka-topics.sh --create --zookeeper localhost:2181 --replication-factor 1 --partitions 1 --topic test

查看topic信息

kafka-topics.sh --list --zookeeper localhost:2181

启动生产者

kafka-console-producer.sh --broker-list localhost:9092 --topic test

启动消费者

kafka-console-consumer.sh --zookeeper localhost:2181 --topic test --from-beginning

在生产者控制台生产消息,看消费端是否可以正常消费到

7.配置环境变量

# Kafka Environment Variable

export KAFKA_HOME=/root/xfk/kafka/kafka_2.11-1.0.0

export PATH=$PATH:$KAFKA_HOME/bin

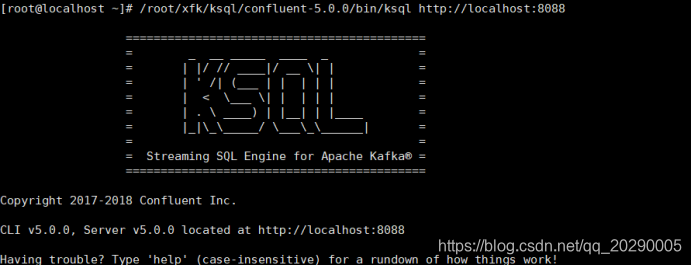

五:安装ksql

- 下载安装ksql

wget https://packages.confluent.io/archive/5.0/confluent-oss-5.0.0-2.11.tar.gz

tar zxvf confluent-oss-5.0.0-2.11.tar.gz -C /opt/programs/confluent_5.0.0 - 启动zk和kafka

- 启动ksql

bin/ksql-server-start -daemon etc/ksql/ksql-server.properties - 连接ksql

bin/ksql http://localhost:8088

本文详细介绍了如何在Linux环境下安装部署Kafka,以消费MySQL数据。首先,需要安装JDK 1.8及以上版本,接着部署Zookeeper,然后安装MySQL,最后安装Kafka和ksql,并配置相关环境及启动服务。通过这些步骤,确保Kafka能够从MySQL获取数据。

本文详细介绍了如何在Linux环境下安装部署Kafka,以消费MySQL数据。首先,需要安装JDK 1.8及以上版本,接着部署Zookeeper,然后安装MySQL,最后安装Kafka和ksql,并配置相关环境及启动服务。通过这些步骤,确保Kafka能够从MySQL获取数据。

3624

3624

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?