各位技术小伙伴们,今天咱们要聊的这位主角,可是深度学习江湖中大名鼎鼎的“记忆大师”——LSTM(Long Short-Term Memory,长短期记忆网络)!别被它的英文名唬住,其实它就是RNN(循环神经网络)家族里一位特别擅长“记住事儿”的成员。话不多说,赶紧上车,咱们一起揭开LSTM的神秘面纱!

👨👩👧👦 LSTM和RNN:本是同根生

要说LSTM,就不得不先提它的“好兄弟”——RNN。循环神经网络(RNN)本是处理序列数据(如文本、语音)的“扛把子”,但它有个致命伤:长期依赖处理能力极差!举个栗子🌰:

假设我们让 RNN 预测 “我今天吃了饭,所以很饱” 的下一个词,短句子还行。但要是处理像《哈利波特》这么长的文本,它就会犯 “老年痴呆”—— 要么记不住前面的关键信息(梯度消失),要么把不重要的信息记成 “重点”(梯度爆炸),就像你追剧追了 100 集,问你第一集女主穿啥衣服,你大概率得挠头吧😅。

💥RNN:我的记忆像金鱼,超过7步全清零

这时候,LSTM就闪亮登场了!它就像是给RNN装上了一个“记忆宫殿”,让RNN不仅能记住最近的事情,还能把重要的事情牢牢地锁在记忆宫殿里,想忘都忘不了!

🔍 LSTM的原理:记忆宫殿的秘密

LSTM之所以这么厉害,是因为它内部有一套精妙的“记忆管理机制”。简单来说,LSTM通过三大门腔+一个记忆细胞实现:

⚙️1、三大门腔:输入门、遗忘门、输出门

- 输入门(Input Gate):决定当前时刻的输入信息有多少可以进入记忆宫殿。

- 遗忘门(Forget Gate):决定之前存储在记忆宫殿里的信息有多少应该被遗忘。

- 输出门(Output Gate):决定当前时刻可以从记忆宫殿里提取多少信息出来使用。

📦 2. 记忆细胞(Cell State)

记忆细胞贯穿整个时间序列,只做线性变换(避免梯度消失)。它就像你的日记本,遗忘门划掉该删的内容,输入门写入新内容,这样 “日记本” 就既能保留重要记忆,又不会太臃肿

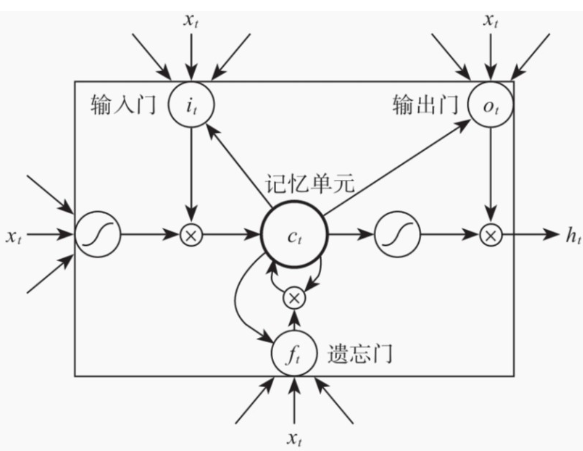

下图为LSTM的原理图:

由图中可以看出输入门 i 、输出门 o 、遗忘门 f 和一个记忆单元(细胞) c 。这些门和记忆单元组合起来大大提升了循环神经网络处理长序列数据的能力。通过这三个门的协同工作,LSTM就能像变魔术一样,把重要的信息牢牢记住,把不重要的信息统统忘掉!

🌟 LSTM的特点:记忆大师的独门绝技

- 长短期记忆:既能记住最近的信息,也能记住很久以前的重要信息,解决了RNN的“长期依赖”问题。

- 梯度消失/爆炸的克星:通过门控机制,有效地缓解了RNN在训练过程中容易出现的梯度消失或爆炸问题。

- 灵活性强:可以根据不同的任务需求,调整门的阈值,从而控制信息的流动。

🌈 LSTM的应用场景:记忆大师的舞台

LSTM这么厉害,当然要在各个领域大展身手啦!下面就给大家举几个例子:

📝 文本生成

想不想让机器也学会写诗、写小说?LSTM就能做到!通过学习大量的文本数据,LSTM可以捕捉到语言的规律和模式,然后生成出与训练数据风格相似的文本。比如,著名的GPT系列模型,就大量使用了LSTM及其变体。

🎧 语音识别

语音识别也是LSTM的强项之一。通过处理语音信号的时间序列数据,LSTM可以准确地识别出语音中的文字内容。现在很多智能音箱、语音助手都离不开LSTM的功劳。比如手机的语音助手,你说 “给我放首周杰伦的歌”,LSTM 能结合前后的语音信号,理解你说的是 “周杰伦” 而不是 “周杰”,避免放错歌的尴尬😜

📈 时间序列预测

在股票预测、天气预报等领域,时间序列预测可是个大难题。但是LSTM却能凭借其强大的记忆能力,捕捉到时间序列中的长期依赖关系,从而给出更准确的预测结果。不过要注意,它不是万能的,不能 100% 准确,毕竟股市还有很多突发因素,比如某大佬一句话就可能让股价暴跌😱。

🤖 机器人控制

在机器人控制领域,LSTM也能派上用场。通过处理机器人传感器采集到的序列数据,LSTM可以帮助机器人更好地理解环境、规划动作,实现更智能的控制。

💻 代码实战:用Python实现一个简单的LSTM

说了这么多,咱们也来动手实践一下吧!下面是一个使用Python和Keras库实现简单LSTM模型的例子,用于预测正弦波序列的下一个值。

import numpy as np

import matplotlib.pyplot as plt

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import LSTM, Dense

# 生成正弦波数据

def generate_sine_wave(seq_length, num_samples):

x = np.linspace(0, 4 * np.pi, seq_length * num_samples)

y = np.sin(x)

return y.reshape(num_samples, seq_length, 1)

# 参数设置

seq_length = 50 # 序列长度

num_samples = 1000 # 样本数量

# 生成数据

data = generate_sine_wave(seq_length, num_samples)

# 划分训练集和测试集

train_size = int(num_samples * 0.8)

X_train, y_train = data[:train_size, :-1], data[:train_size, -1]

X_test, y_test = data[train_size:, :-1], data[train_size:, -1]

# 构建LSTM模型

model = Sequential([

LSTM(50, activation='relu', input_shape=(seq_length - 1, 1)),

Dense(1)

])

# 编译模型

model.compile(optimizer='adam', loss='mse')

# 训练模型

model.fit(X_train, y_train, epochs=100, verbose=0)

# 预测并可视化结果

predictions = model.predict(X_test)

plt.figure(figsize=(12, 6))

plt.plot(y_test, label='True Values')

plt.plot(predictions, label='Predictions')

plt.legend()

plt.show()运行这段代码,你就能看到一个简单的LSTM模型如何学习并预测正弦波序列的下一个值啦!是不是很有趣呢?

🎉 结语

LSTM 作为 RNN 的 “进化版”,通过遗忘门、输入门等结构,解决了长序列记忆的难题,在 NLP、时间序列等领域大显身手。但它也不是完美的,计算复杂度比 RNN 高,训练起来更费时间和算力,就像学霸虽然成绩好,但也得花更多时间学习不是😉如果你也对序列数据处理感兴趣,不妨动手试试LSTM吧!说不定你也能用它创造出一些有趣的应用呢!

🎁: 下期预告:《GRU:我比LSTM少1个门,但得更快!》👉 关注不迷路~

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?