最近Meta AI发布了Segment Anything模型,可以直接分割任何图片。我趁热乎体验了一下。

进入官网 & 上传图片

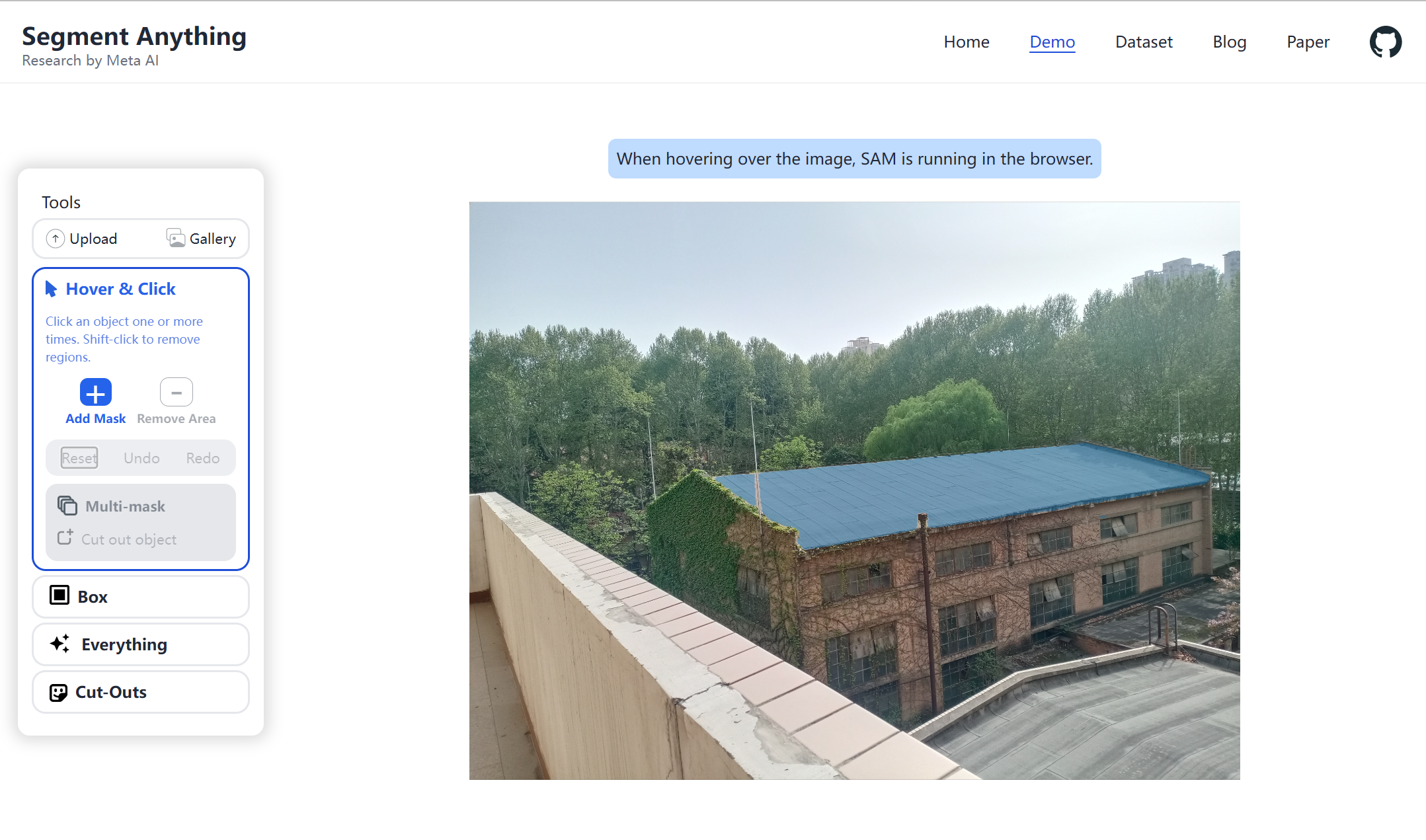

打开Segment Anything官网https://segment-anything.com/:

点击Try the demo,在弹出的对话框中勾选“I have read…”,进入上传界面:

点击“Upload an image”,上传自己的图片:

我上传的图片大小是5.14MB,提取物体用时3分06秒。

Hover & Click——截取物体

处理完毕后,当鼠标悬停在某个物体上时,该物体被标蓝。点击左侧的“Hover & Click”,然后左键点击图像的某一区域可以将该物体加入选区,右键移除选取。比如,我想抠出房子但

SegmentAnything是一款由MetaAI推出的图片分割工具,用户可以轻松地通过上传图片,然后通过Hover&Click或Box方式选择并提取所需物体。一切物体都能被识别并保存为透明背景的图片,尽管处理大图可能导致分辨率下降。

SegmentAnything是一款由MetaAI推出的图片分割工具,用户可以轻松地通过上传图片,然后通过Hover&Click或Box方式选择并提取所需物体。一切物体都能被识别并保存为透明背景的图片,尽管处理大图可能导致分辨率下降。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1686

1686

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?