本文为原创文章,转载请注明出处---https://blog.youkuaiyun.com/q_z_r_s

|

机器感知

一个专注于SLAM、三维重建、机器视觉等相关技术文章分享的公众号

|

假设机器人位姿为3维,每个landmark为2维,EKF中的状态向量为:

x=[xvy1y2⋯yn]T

x=\left[\begin{matrix}x_v&y_1&y_2&\cdots&y_n\end{matrix}\right]^T

x=[xvy1y2⋯yn]T

运动方程和观测方程为:

xt=f(xt−1,ut,vt)zt=h(xt,ωt)

x_t=f(x_{t-1},u_t,v_t)\\

z_t=h(x_t,\omega_t)

xt=f(xt−1,ut,vt)zt=h(xt,ωt)

故有:

Gt=I+[∂f∂x3×303×2n02n×302n×2n]=[F3×303×2n02n×3I2n×2n]

G_t=I+\left[\begin{matrix}\frac{\partial{f}}{\partial{x}}_{3\times3}&0_{3\times2n}\\

0_{2n\times3}&0_{2n\times2n}\end{matrix}\right]=\left[\begin{matrix}F_{3\times3}&0_{3\times2n}\\0_{2n\times3}&I_{2n\times2n}\end{matrix}\right]

Gt=I+[∂x∂f3×302n×303×2n02n×2n]=[F3×302n×303×2nI2n×2n]

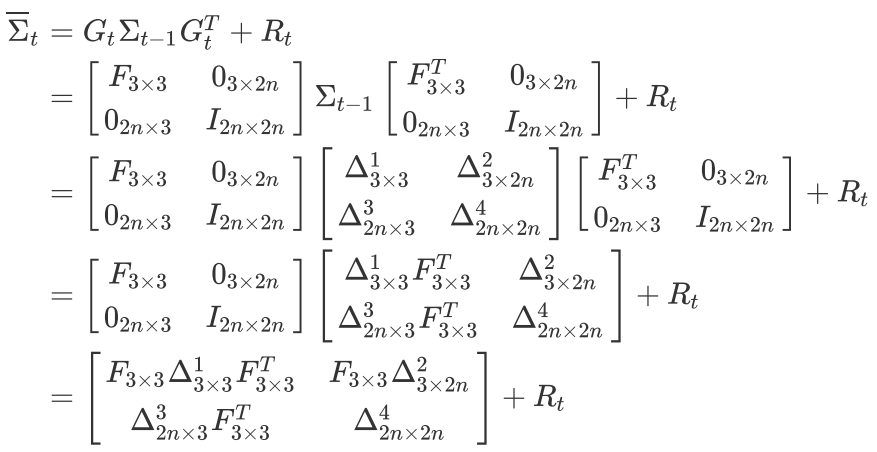

因此,协方差矩阵的预测值为:

Σ‾t=GtΣt−1GtT+Rt=[F3×303×2n02n×3I2n×2n]Σt−1[F3×3T03×2n02n×3I2n×2n]+Rt=[F3×303×2n02n×3I2n×2n][Δ3×31Δ3×2n2Δ2n×33Δ2n×2n4][F3×3T03×2n02n×3I2n×2n]+Rt=[F3×303×2n02n×3I2n×2n][Δ3×31F3×3TΔ3×2n2Δ2n×33F3×3TΔ2n×2n4]+Rt=[F3×3Δ3×31F3×3TF3×3Δ3×2n2Δ2n×33F3×3TΔ2n×2n4]+Rt

\begin{align}

\overline{\Sigma}_t&=G_t\Sigma_{t-1}G_t^T+R_t\\

&=

\left[\begin{matrix}F_{3\times3}&0_{3\times2n}\\0_{2n\times3}&I_{2n\times2n}\end{matrix}\right]\Sigma_{t-1}

\left[\begin{matrix}F_{3\times3}^T&0_{3\times2n}\\0_{2n\times3}&I_{2n\times2n}\end{matrix}\right]+R_t\\

&=\left[\begin{matrix}F_{3\times3}&0_{3\times2n}\\0_{2n\times3}&I_{2n\times2n}\end{matrix}\right]\left[\begin{matrix}

\Delta^1_{3\times3}&\Delta^2_{3\times2n}\\

\Delta^3_{2n\times3}&\Delta^4_{2n\times2n}

\end{matrix}\right]

\left[\begin{matrix}F_{3\times3}^T&0_{3\times2n}\\0_{2n\times3}&I_{2n\times2n}\end{matrix}\right]+R_t\\

&=\left[\begin{matrix}F_{3\times3}&0_{3\times2n}\\0_{2n\times3}&I_{2n\times2n}\end{matrix}\right]\left[\begin{matrix}

\Delta^1_{3\times3}F_{3\times3}^T&\Delta^2_{3\times2n}\\

\Delta^3_{2n\times3}F_{3\times3}^T&\Delta^4_{2n\times2n}

\end{matrix}\right]+R_t\\

&=\left[\begin{matrix}

F_{3\times3}\Delta^1_{3\times3}F_{3\times3}^T&F_{3\times3}\Delta^2_{3\times2n}\\

\Delta^3_{2n\times3}F_{3\times3}^T&\Delta^4_{2n\times2n}

\end{matrix}\right]+R_t

\end{align}

Σt=GtΣt−1GtT+Rt=[F3×302n×303×2nI2n×2n]Σt−1[F3×3T02n×303×2nI2n×2n]+Rt=[F3×302n×303×2nI2n×2n][Δ3×31Δ2n×33Δ3×2n2Δ2n×2n4][F3×3T02n×303×2nI2n×2n]+Rt=[F3×302n×303×2nI2n×2n][Δ3×31F3×3TΔ2n×33F3×3TΔ3×2n2Δ2n×2n4]+Rt=[F3×3Δ3×31F3×3TΔ2n×33F3×3TF3×3Δ3×2n2Δ2n×2n4]+Rt

综上,可以得出,预测协方差矩阵时,只要与机器人位姿相关的的协方差矩阵块都是有变化的,而仅与landmark相关的协方差矩阵块完全没有任何变化。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?