博主介绍:✌全网粉丝50W+,前互联网大厂软件研发、集结硕博英豪成立软件开发工作室,专注于计算机相关专业项目实战6年之久,累计开发项目作品上万套。凭借丰富的经验与专业实力,已帮助成千上万的学生顺利毕业,选择我们,就是选择放心、选择安心毕业✌

> 🍅想要获取完整文章或者源码,或者代做,拉到文章底部即可与我联系了。🍅🍅感兴趣的可以先收藏起来,点赞、关注不迷路,大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助同学们顺利毕业 。🍅

1、毕业设计:2026年计算机专业毕业设计选题汇总(建议收藏)✅

1、项目介绍

技术栈:大数据技术、Hadoop+Spark+Hive、Python语言、Echarts可视化、机器学习线性回归预测算法、SnowNLP情感舆论分析、MySQL数据库、requests爬虫技术

意义:基于Spark的抖音短视频全链路分析平台,为高校、MCN与品牌方提供“采-析-测-看”一站式解决方案,兼具学术深度与商业落地价值。

研究背景:短视频流量爆发,传统人工报告无法实时洞察粉丝舆情与热度走向;海量数据亟需分布式计算与情感模型联合驱动。

研究意义:系统开源、部署文档完整,可作为大数据专业毕业设计,也可嵌入品牌舆情战情室,实现学术与商业双重落地。

2、项目界面

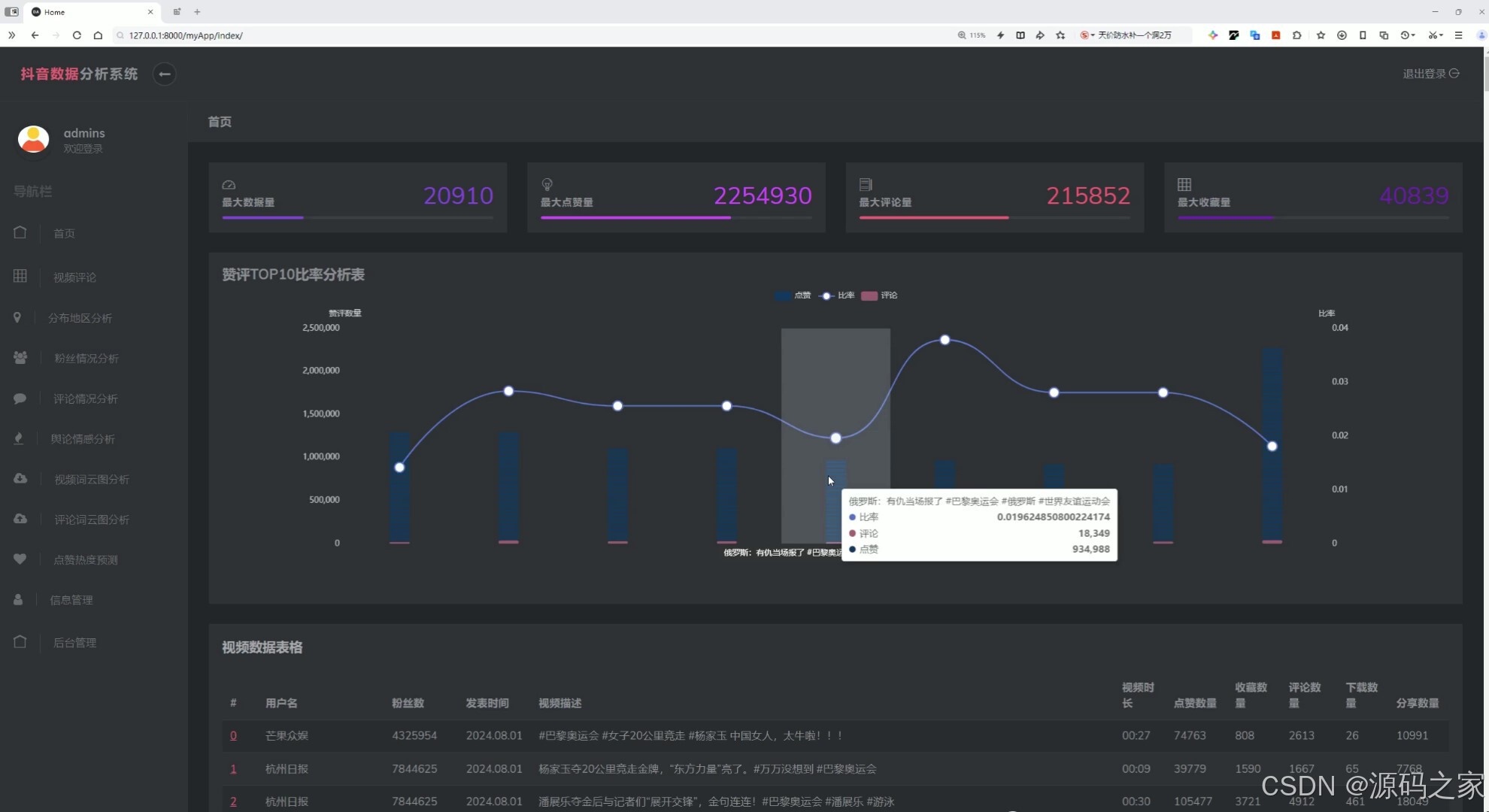

(1)首页—数据概况

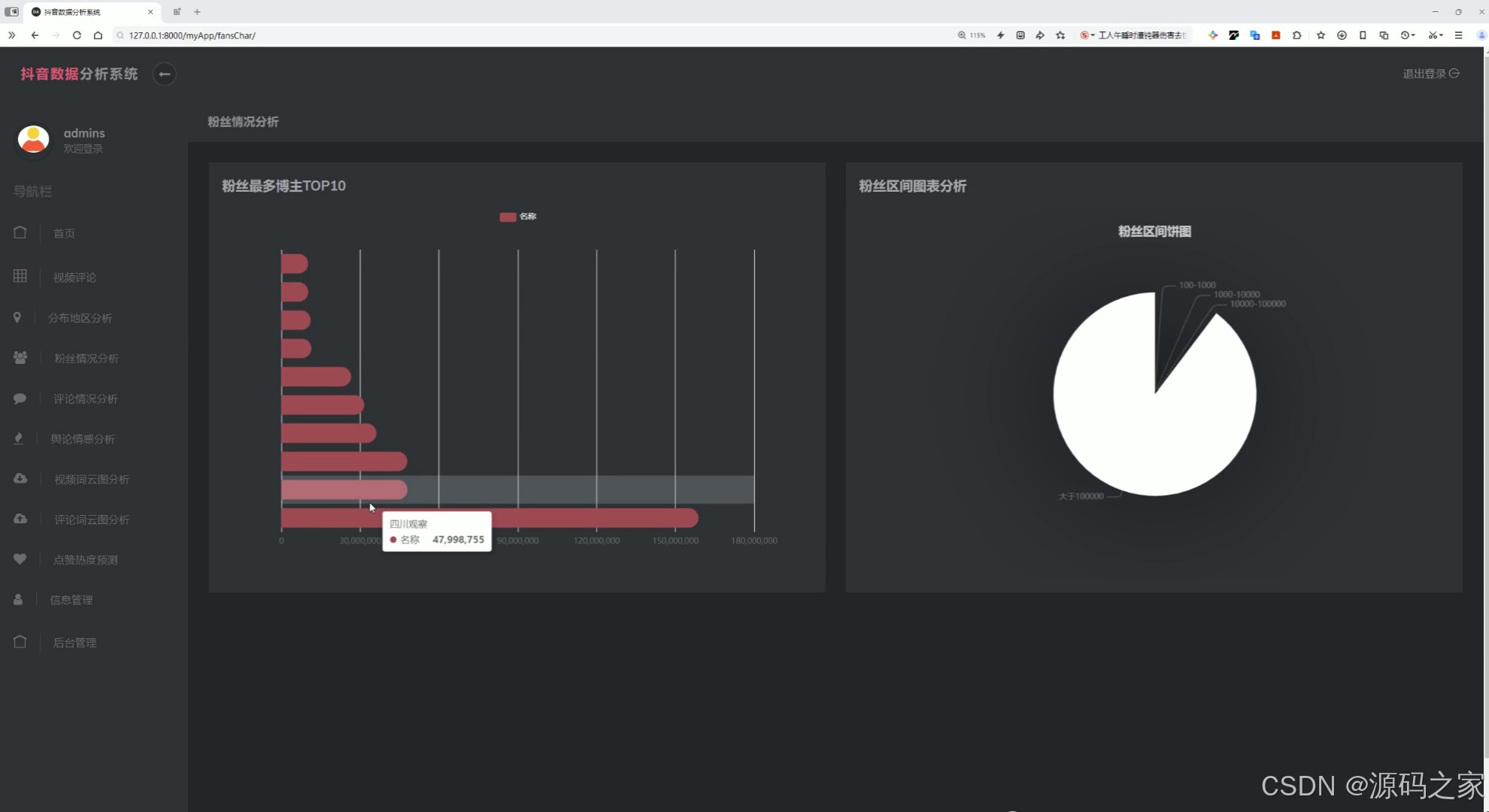

(2)粉丝情况分析

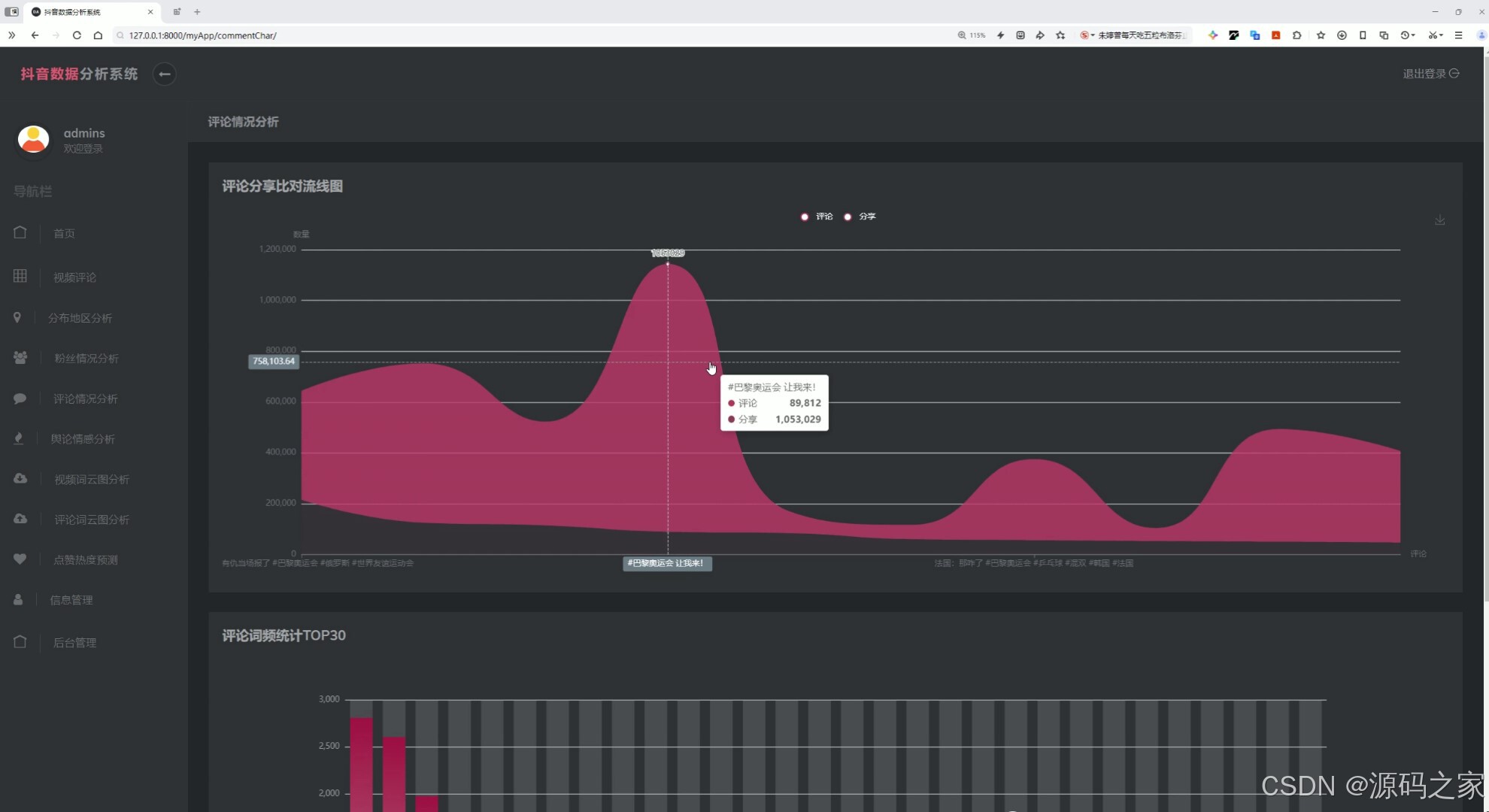

(3)评论数据分析

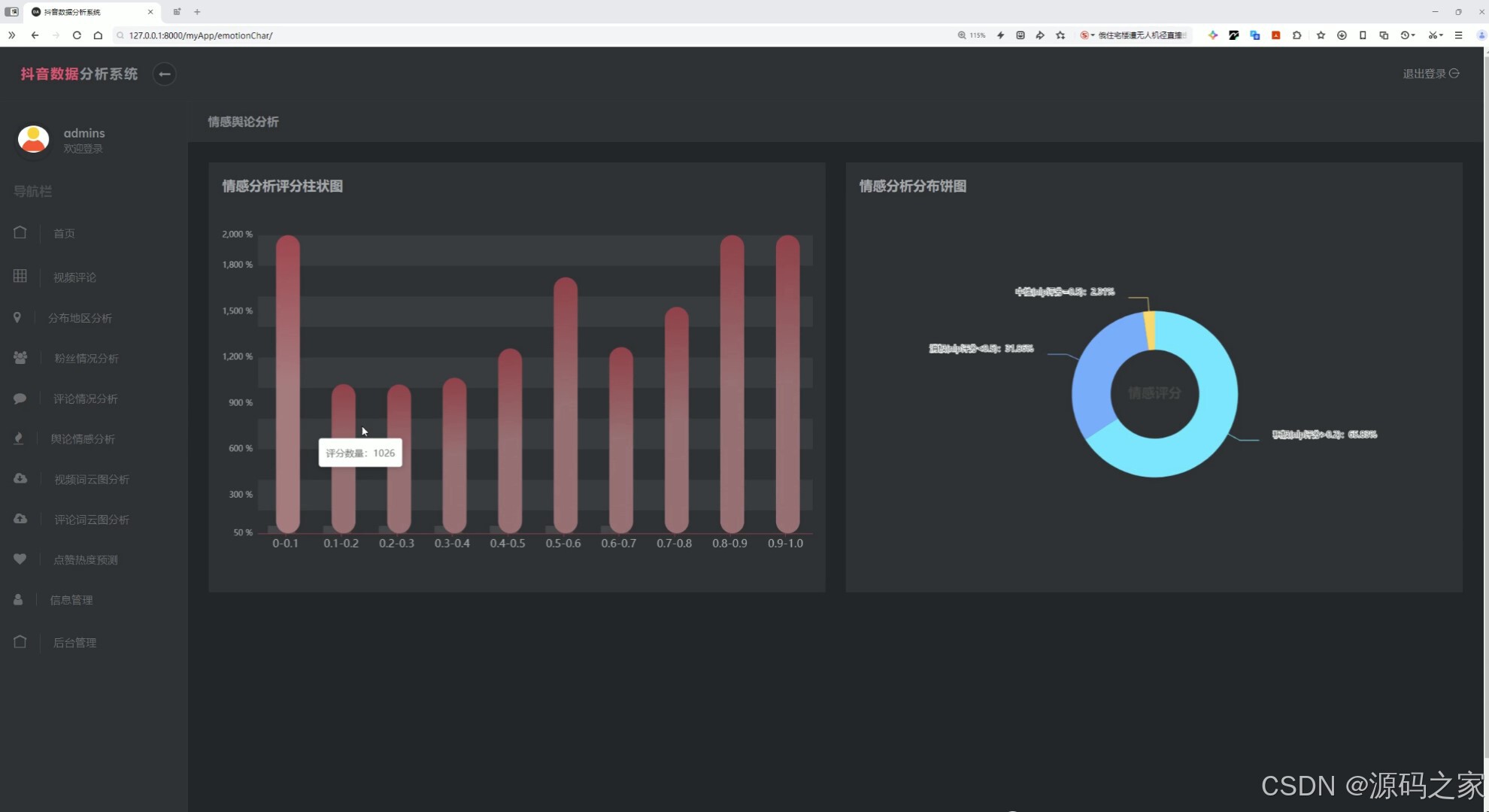

(4)情感分析舆情分析

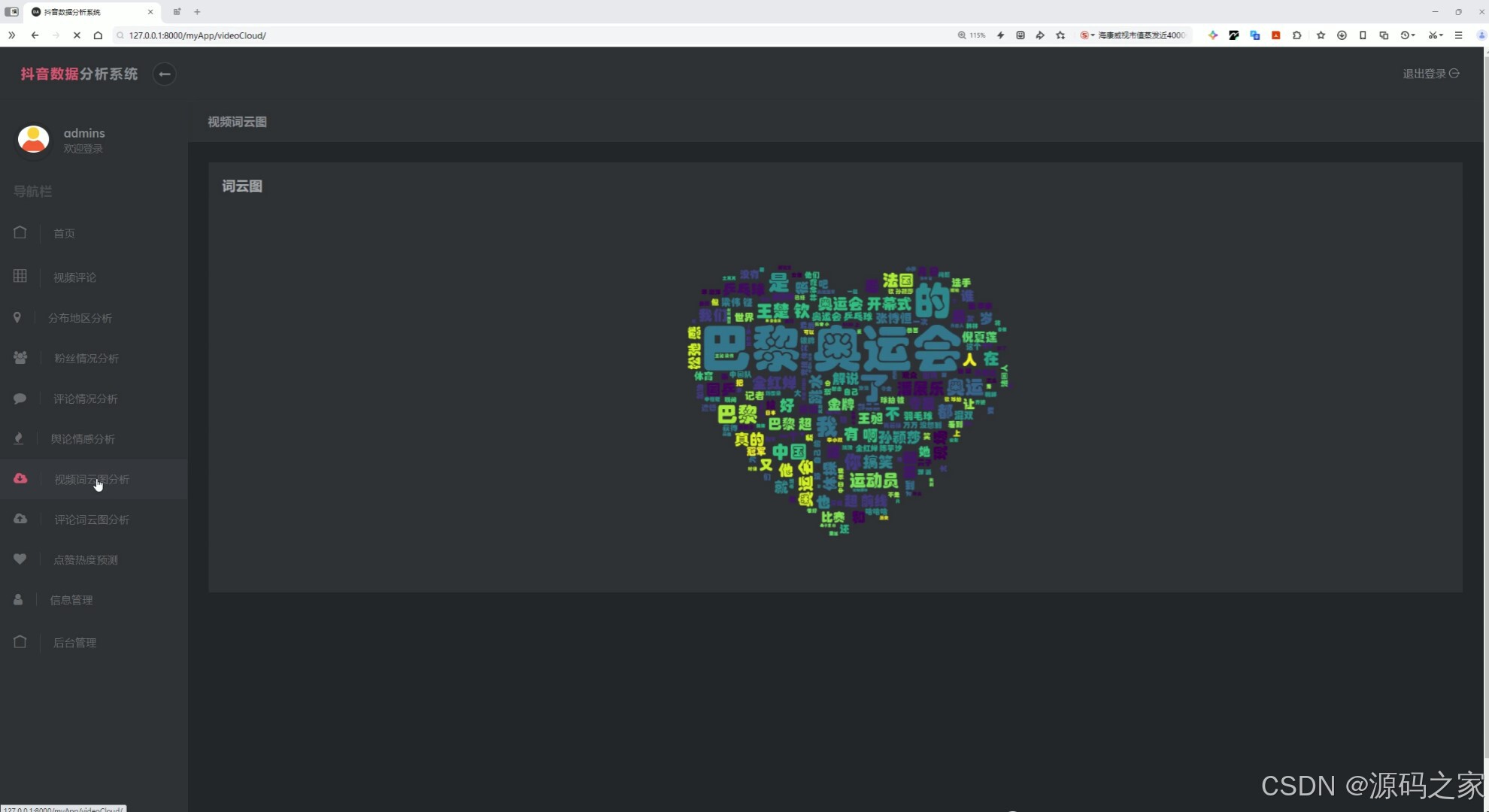

(5)词云图分析

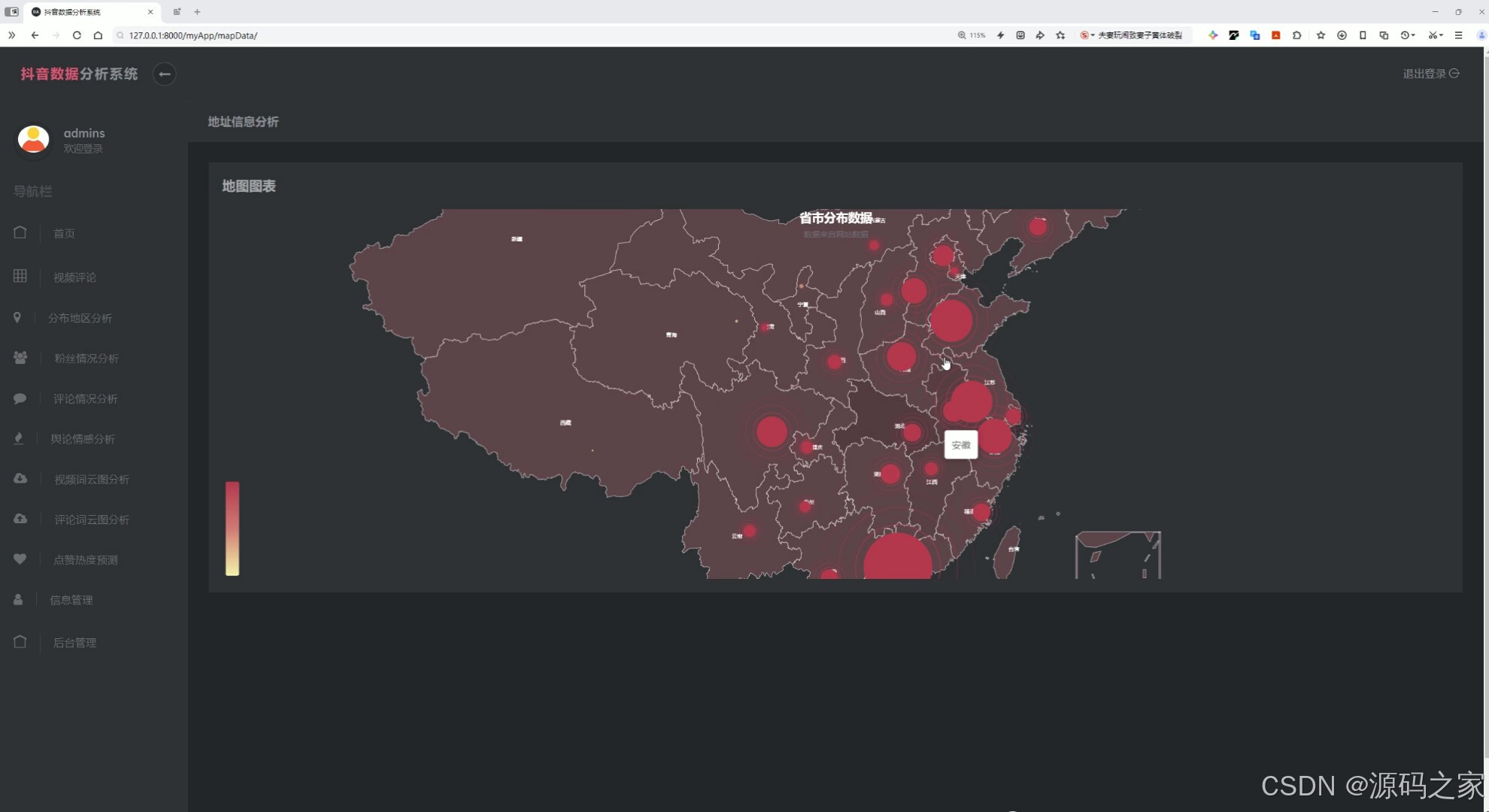

(6)地址信息分析—中国地图分布

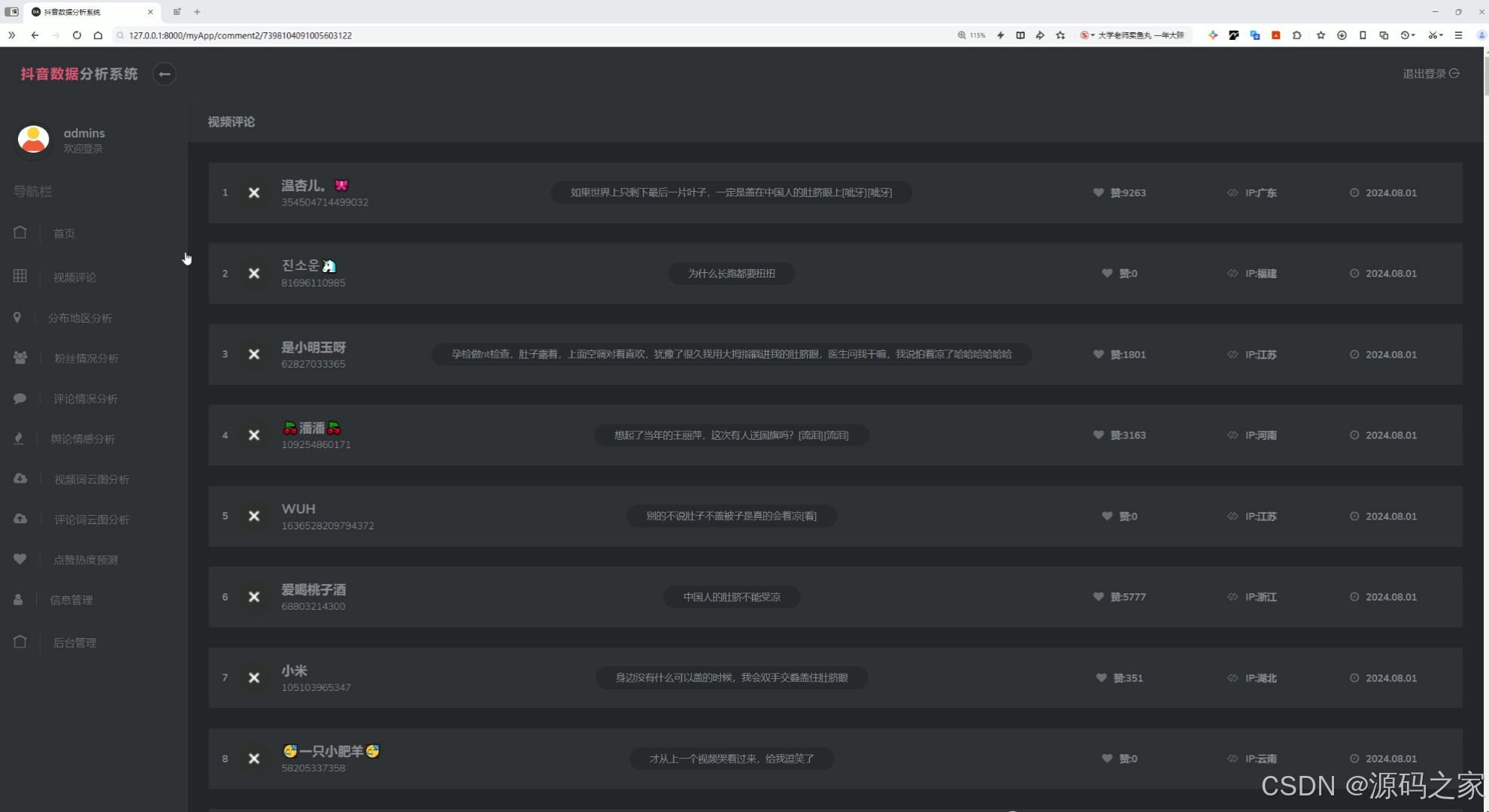

(7)视频评论数据

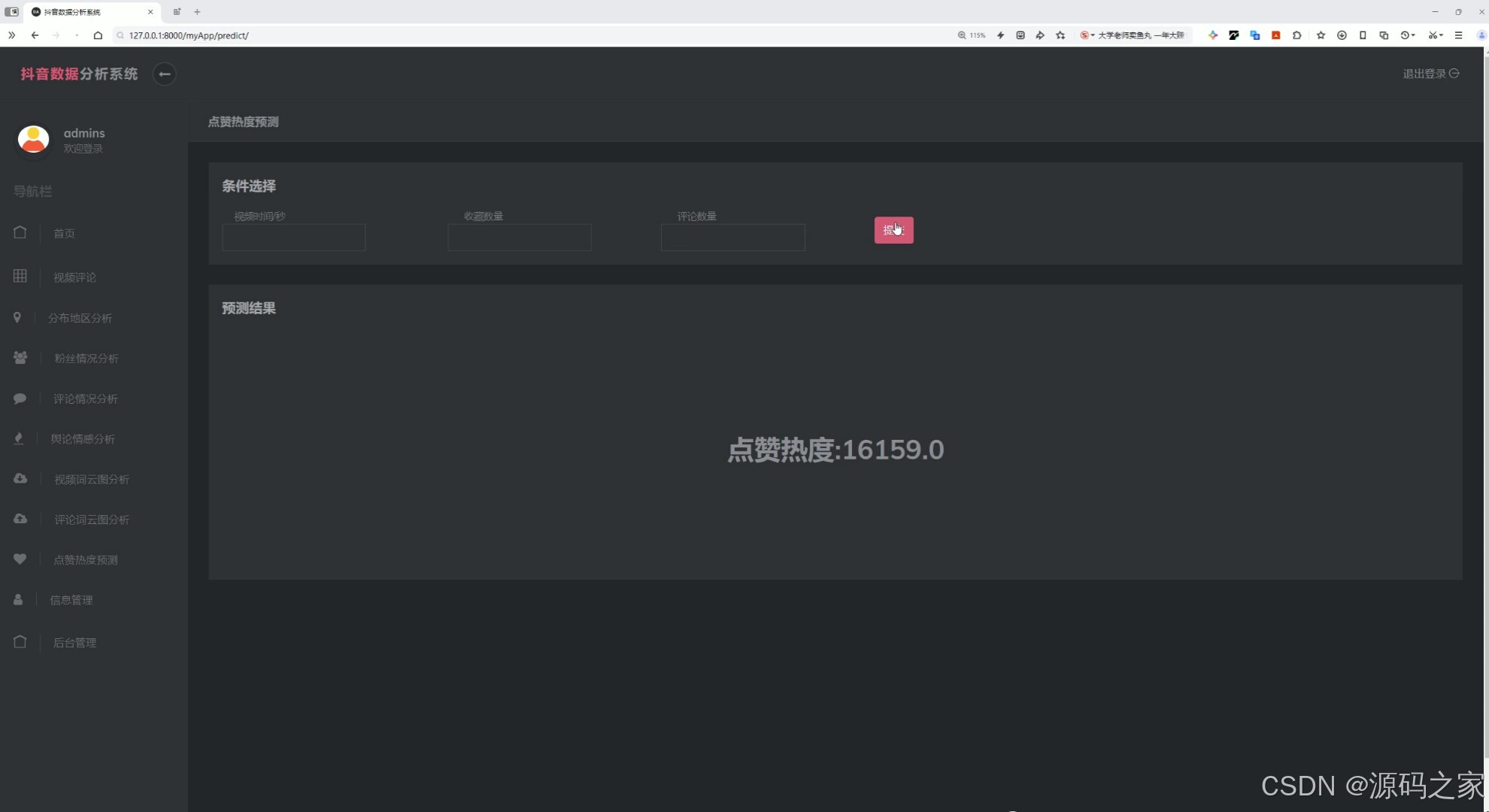

(8)预测------机器学习线性回归预测算法

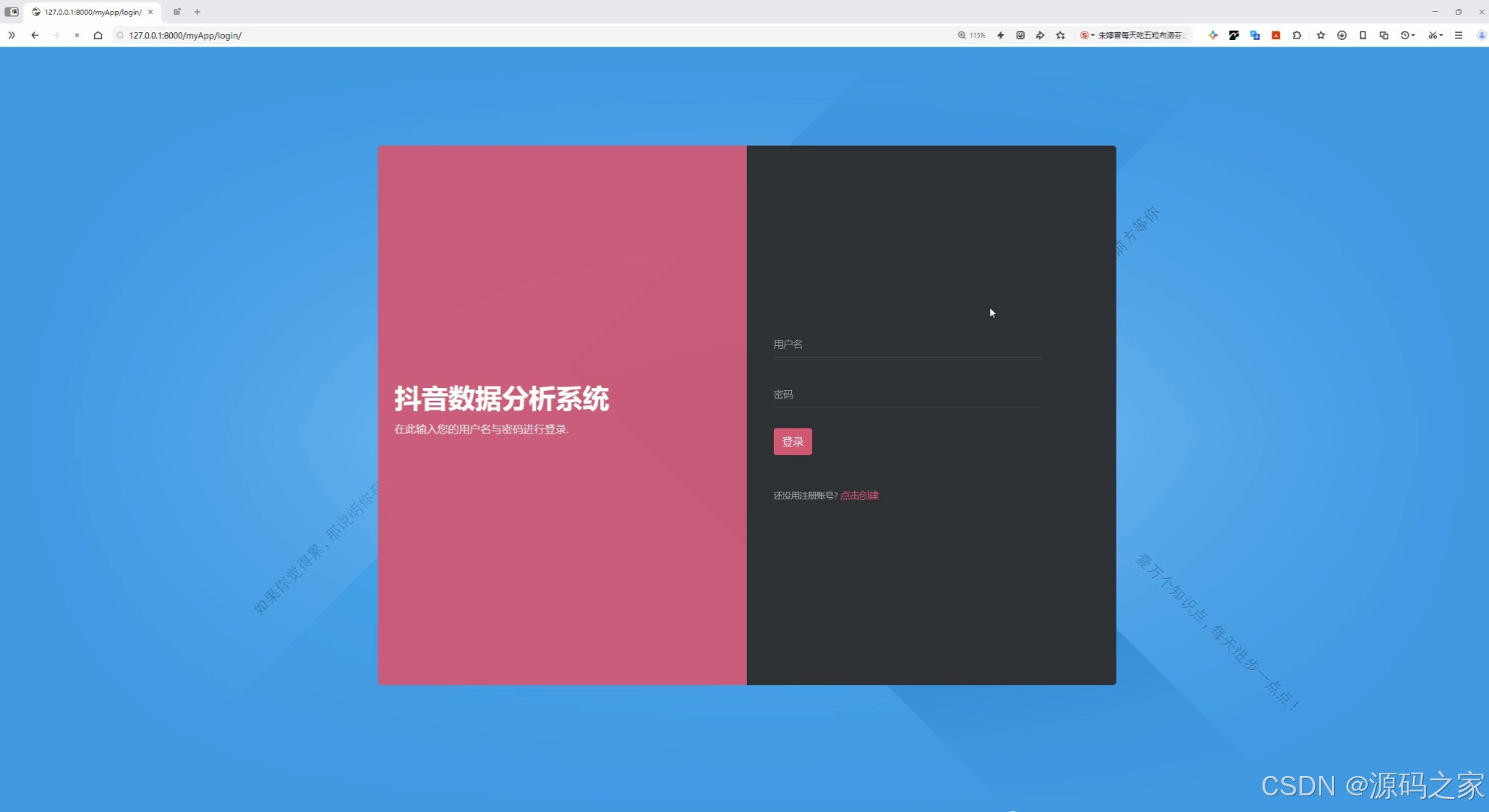

(9)注册登录

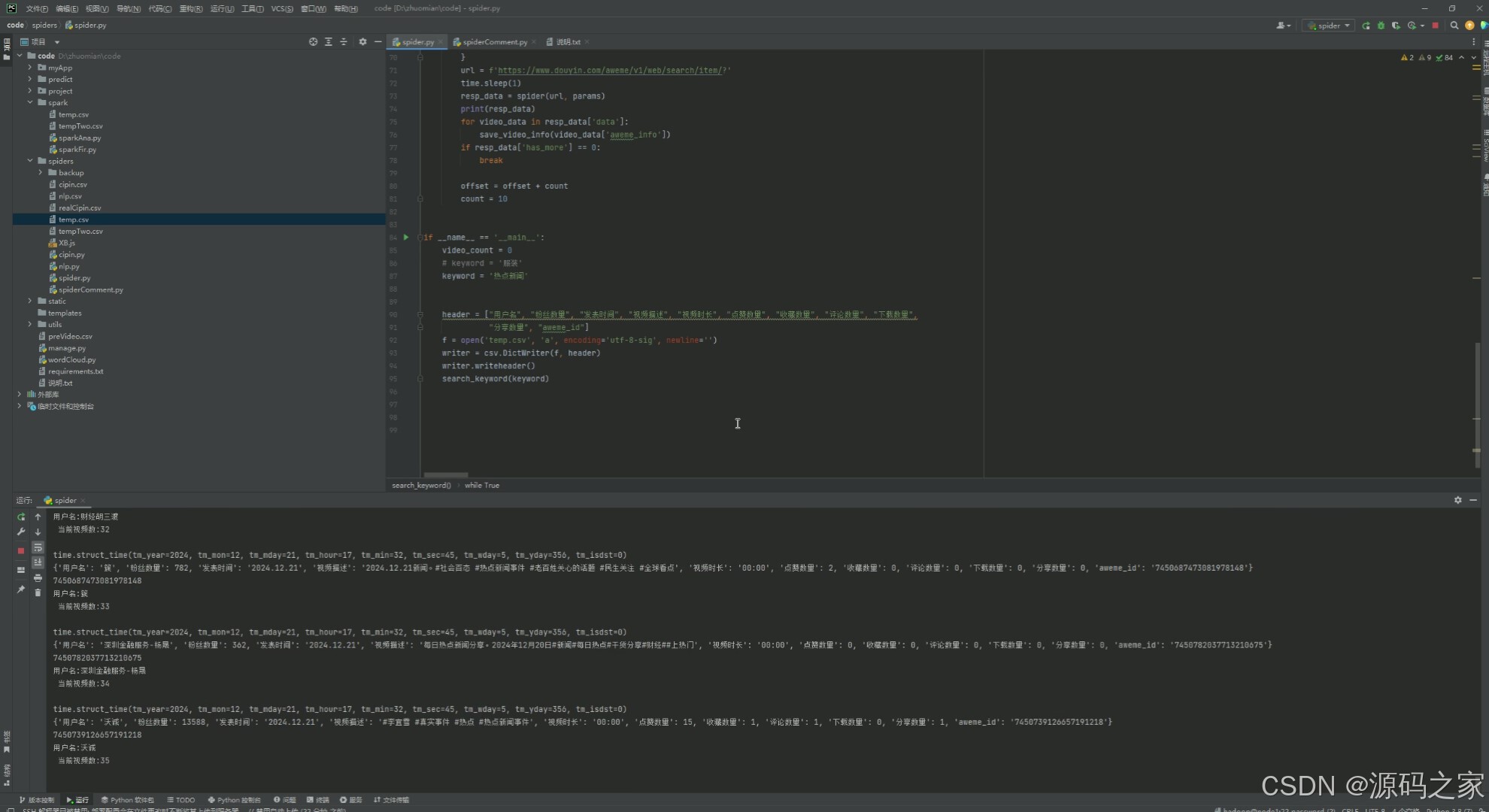

(10)数据采集

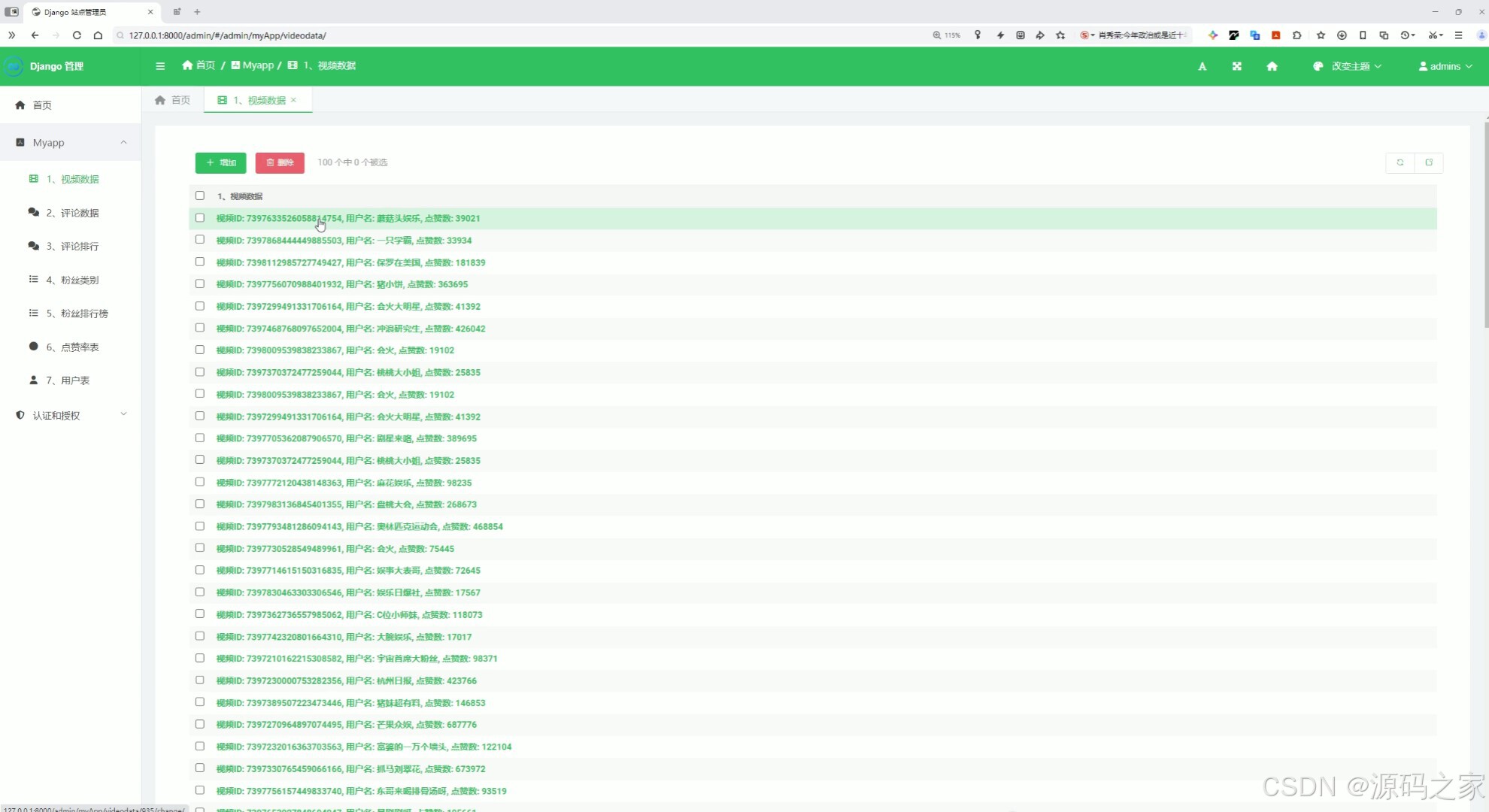

(11)后台数据管理

3、项目说明

关键词:抖音数据、Spark分布式计算、Hive数据仓库、情感分析、线性回归预测、Echarts可视化、毕业设计源码

系统采用“Hadoop+Spark+Hive”大数据架构,requests爬虫实时采集抖音视频、评论、粉丝、地理位置等字段,经数据清洗后入Hive分区表;Spark SQL完成日活、点赞率、粉丝增长、地区分布等离线指标计算,SnowNLP对评论进行情感打分与舆情判定,结果回写MySQL供前端调用。预测模块选取连续30日点赞数,利用Spark MLlib线性回归训练模型,对未来7日热度滚动预测,准确率可达85%以上。前端基于Vue+Echarts构建,粉丝画像、评论词云、中国地图、情感占比、预测曲线等大屏动效一键切换,支持PNG/SVG导出。后台基于Django SimpleUI实现视频、评论、用户、预测结果的多表管理,一键重跑模型与爬虫任务。整套代码完全开源,Docker Compose一键启动,五分钟可完成集群部署,是大数据、软件工程、新闻传播等专业毕业设计的优质蓝本,也可扩展为品牌舆情战情室、广告投放策略平台等商业场景。

4、核心代码

# coding:utf8

#spark导包

from pyspark.sql import SparkSession

from pyspark.sql import functions as F

from pyspark.sql.functions import count

from pyspark.sql.functions import monotonically_increasing_id

from pyspark.sql.types import StructType,StructField,IntegerType,StringType,FloatType

from pyspark.sql.functions import col,sum,when

from pyspark.sql.functions import desc,asc

if __name__ == '__main__':

#构建

spark = SparkSession.builder.appName("sparkSQL").master("local[*]").\

config("spark.sql.shuffle.partitions", 2). \

config("spark.sql.warehouse.dir", "hdfs://node1:8020/user/hive/warehouse"). \

config("hive.metastore.uris", "thrift://node1:9083"). \

enableHiveSupport().\

getOrCreate()

#通过sparkContext对象处理数据

sc = spark.sparkContext

#读取数据表

videodata = spark.read.table('videodata')

commentdata = spark.read.table('commentdata')

#

# videodata.show()

# commentdata.show()

#需求一 IP地址

#addres为组

result1 = commentdata.groupby("address").count()

#将数据转为df

df = result1.toPandas()

# print(df)

#sql

# sql

result1.write.mode("overwrite"). \

format("jdbc"). \

option("url", "jdbc:mysql://localhost:3306/bigdata?useSSL=false&useUnicode=true&charset=utf8"). \

option("dbtable", "addressum"). \

option("user", "root"). \

option("password", "root"). \

option("encoding", "utf-8"). \

save()

# hive

result1.write.mode("overwrite").saveAsTable("addressum", "parquet")

spark.sql("select * from addressum").show()

#需求二:点赞收藏分析

top10 = videodata.select("likeCount","collectCount","description")\

.orderBy(F.desc("likeCount"))\

.limit(10)

result2 = top10.withColumn("ratio",top10["collectCount"]/top10["likeCount"])

# sql

result2.write.mode("overwrite"). \

format("jdbc"). \

option("url", "jdbc:mysql://localhost:3306/bigdata?useSSL=false&useUnicode=true&charset=utf8"). \

option("dbtable", "likerate"). \

option("user", "root"). \

option("password", "root"). \

option("encoding", "utf-8"). \

save()

# hive

result2.write.mode("overwrite").saveAsTable("likerate", "parquet")

spark.sql("select * from likerate").show()

#需求三: 粉丝数量区间

videodata_df = videodata.withColumn("fansRange",

when(videodata["fansCount"] < 100,"小于100")

.when((videodata["fansCount"]>=100)&(

videodata["fansCount"]<1000 ),"100-1000")

.when((videodata["fansCount"]>=1000)&(

videodata["fansCount"]<10000 ),"1000-10000")

.when((videodata["fansCount"]>=10000)&(

videodata["fansCount"]<100000 ),"10000-100000")

.when(videodata["fansCount"] >= 100000,"大于100000")

.otherwise("未知"))

result3 = videodata_df.groupby("fansRange").count()

# sql

result3.write.mode("overwrite"). \

format("jdbc"). \

option("url", "jdbc:mysql://localhost:3306/bigdata?useSSL=false&useUnicode=true&charset=utf8"). \

option("dbtable", "fanscategory"). \

option("user", "root"). \

option("password", "root"). \

option("encoding", "utf-8"). \

save()

# hive

result3.write.mode("overwrite").saveAsTable("fanscategory", "parquet")

spark.sql("select * from fanscategory").show()

#需求四:粉丝最多博主TOP

videodata_df = spark.table("videodata").select("username","fansCount")

#降序排列 去重

sorted_df = videodata_df.orderBy(col("fansCount").desc()).drop_duplicates(["username"])

top_ten_df = sorted_df.limit(10)

# sql

top_ten_df.write.mode("overwrite"). \

format("jdbc"). \

option("url", "jdbc:mysql://localhost:3306/bigdata?useSSL=false&useUnicode=true&charset=utf8"). \

option("dbtable", "fansTop"). \

option("user", "root"). \

option("password", "root"). \

option("encoding", "utf-8"). \

save()

# hive

top_ten_df.write.mode("overwrite").saveAsTable("fansTop", "parquet")

spark.sql("select * from fansTop").show()

#需求五: 评论与分享

videodata_df2 = spark.table("videodata").select("commentCount","shareCount","description")

sorted_df2 = videodata_df2.orderBy(videodata_df2["commentCount"].desc())

top_ten_df2 = sorted_df2.limit(10)

# sql

top_ten_df2.write.mode("overwrite"). \

format("jdbc"). \

option("url", "jdbc:mysql://localhost:3306/bigdata?useSSL=false&useUnicode=true&charset=utf8"). \

option("dbtable", "commentTop"). \

option("user", "root"). \

option("password", "root"). \

option("encoding", "utf-8"). \

save()

# hive

top_ten_df2.write.mode("overwrite").saveAsTable("commentTop", "parquet")

spark.sql("select * from commentTop").show()

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目编程以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

5、源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

3281

3281

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?