Anthropic: building effective AI agents

https://www.anthropic.com/engineering/building-effective-agents?via=aitoolhunt

从Anthropic在行业内成功实施Agent的落地case来看,无一不是使用了简单+可组合的模式,而非复杂的框架和特殊的库。大道至简。

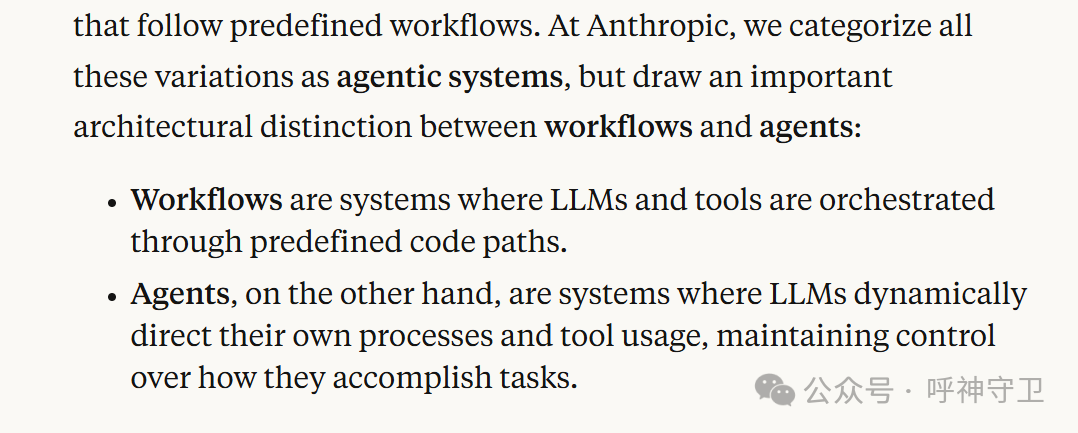

就像AI/AIGC/GenAI一样,大家对Agent的概念和理解也多种多样,很多业务人员甚至把KG支持的Chatbot叫做Agent。Anthropic把Agent多样的理解和变种,统一叫做智能体系统 - Agentic System。Agentic System从架构层面分为Workflow和Agent,并做了重要的区分。

- Workflow:LLM和Tool经过预先定义和精心编排

- Agent:LLM动态指导自己的流程和工具调用,并始终保持对完成任务方式的控制

在垂直领域中,需要尽量找到最简单的解决方案路径,在必要的时候才增加系统复杂性。很多场景根本不需要Agent,Agent会牺牲延迟和成本,来换取更好的性能,垂直领域场景需要考虑这种trade off值不值得。

在垂直领域场景中,对于能够被定义的很好的任务,同时需要保证可预测性和一致性时,选Workflow(Dify当前在做的事情)。当大规模需要动态灵活性且模型自主驱动决策时,选Agent(Manus想要做的事情 )。Workflow的瓶颈是对于垂直领域场景中的任务,是没法被提前定义好的;Agent的瓶颈是保证了灵活性和自主性,需要牺牲稳定性和可预测性。当前很多垂直领域落地的AI场景,优化的单个大模型(FT)配检索(RAG)再加一些prompt示例(ICL)就足够了。

)。Workflow的瓶颈是对于垂直领域场景中的任务,是没法被提前定义好的;Agent的瓶颈是保证了灵活性和自主性,需要牺牲稳定性和可预测性。当前很多垂直领域落地的AI场景,优化的单个大模型(FT)配检索(RAG)再加一些prompt示例(ICL)就足够了。

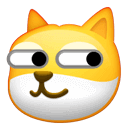

有很多框架,让Agent的构建变得简单。比如LangGraph,Dify。这些框架通过标准化通用组件和功能,形成了一些额外的抽象层。抽象层会掩盖掉过程的提示和反馈,增加debug的复杂度。所以这些框架看似简化了问题,实则也会复杂问题。当一个简单解决方案足矣满足垂直场景需求的时候,就不要使用这类框架。不了解这些框架抽象层背后的原理,形成了对底层不正确的假设,是在这些Agent框架被应用过程中最常见的一种错误。

Agentic System的进化是通过Block,Workflow和Agent逐步实现的。根据垂直领域Agent的应用场景,总结了Agent的7大应用架构,从易到难依次来介绍:

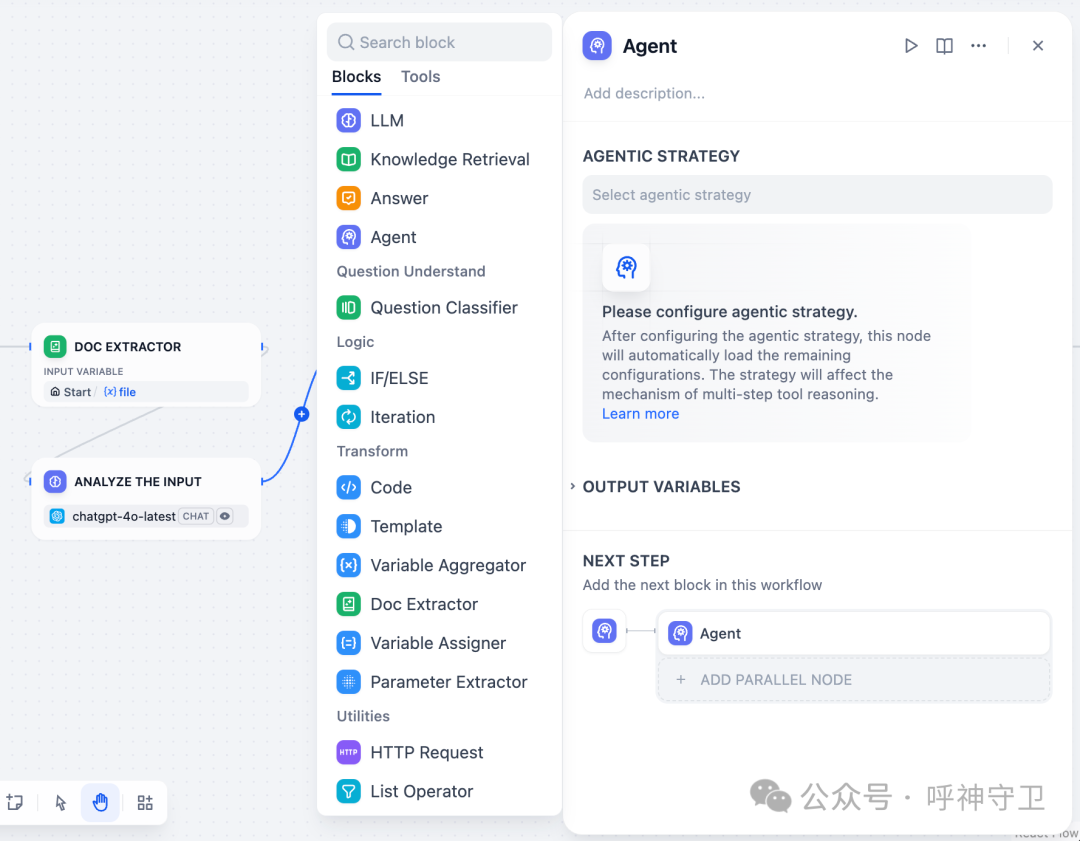

- Building Block: The Augmented LLM

增强型LLM。基于Agent系统的要求,增强基础LLM的功能。借助MCP框架,LLM可拓展工具链。检索 - 自动生成查询语句,工具 - 选择场景最适合的工具,记忆 - 决定什么信息要保留。根据需要为LLM定制这些能力,形成Agent最基础的组件(block)。

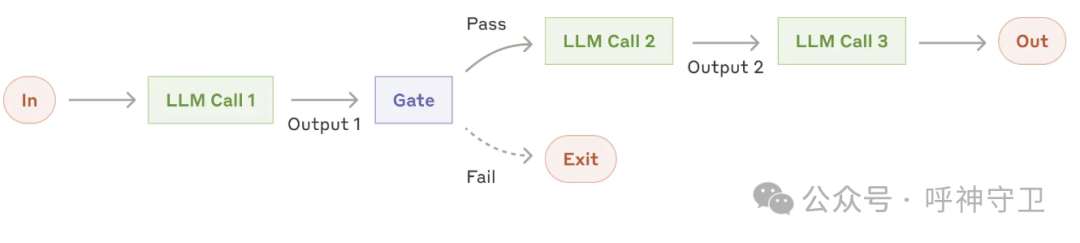

- Workflow: Prompt Chaining

提示串型Workflow。将任务分解为串行步骤,中间环节增加检查点,保证整体流程在按计划进行。

适用场景:任务可以被容易清晰地分解为固定简单的子任务,目标是通过牺牲延迟性来换取更高的准确性。

示例:市场营销文案,并翻译为不同语言。编写文件大纲,确认大纲是否符合某些标准,返工迭代,然后根据大纲编写文件。

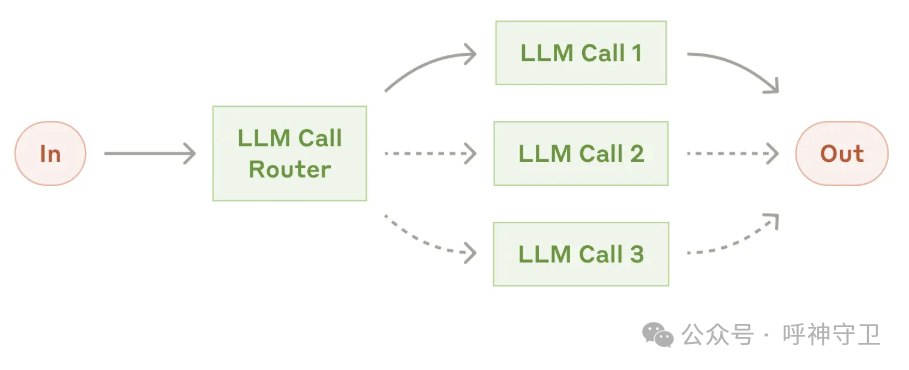

- Workflow: Routing

路由型Workflow。将大任务按照不同类别进行分解,并针对分解的任务,建立更专业的提示。否则诊断一种类型任务的优化,可能会对其他任务产生影响。

适用场景:任务相对复杂,类别相对明确。通过LLM或更传统的分类模型进行任务拆解。

示例:客户服务查询(一般问题、退款请求、技术支持)导向不同的下游流程、提示和工具。将简单/场景问题交给小模型,困难/异常问题交给大模型。

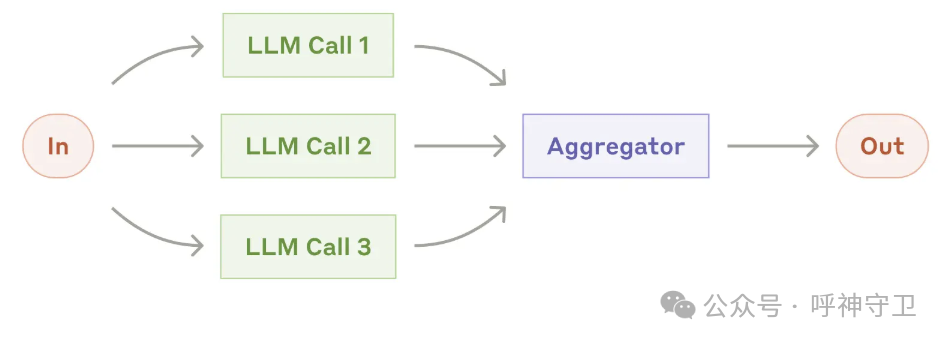

- Workflow: Paralleization

并行Workflow。并行同时执行一项任务,然后汇总结果。并行方式有两种:①分段:任务分解为独立子任务并行运算,提高执行速度;②投票:多次运行同一任务,以获得不同输出结果,提高置信度。

适用场景:当有多个因素时,每个因素由单独的LLM调用处理,性能通常会更好,从而可以集中关注每个特定的方面。

示例:①分段并行 - 当一个模型实例在处理用户查询时,另一个模型对用户查询进行安全审查,防止出现不恰当的内容或请求。②投票并行 - 评估一段代码是否有漏洞,通过多个不同的提示来评估不同方面或要求的投票阈值,来平衡漏报和误报。

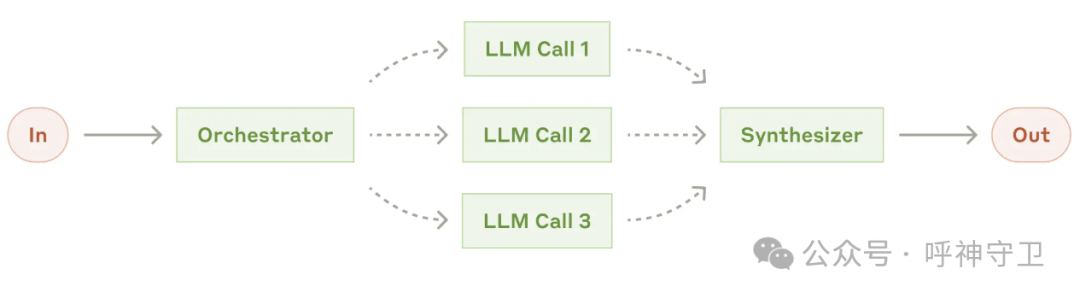

- Workflow: Orchestrator-Workers

协调者型Workflow。中央协调者LLM会动态分解任务,并将其分配给工作者LLM,并综合其结果。

适用场景:无法预测所需子任务的复杂程度。拓扑结构和并行化类似,但主要区别在于其灵活性,子任务不是预先定义的,而是由协调者根据具体输入确定的。

垂直场景示例:每次从不同的来源收集和分析信息,以查找可能相关的搜索任务。

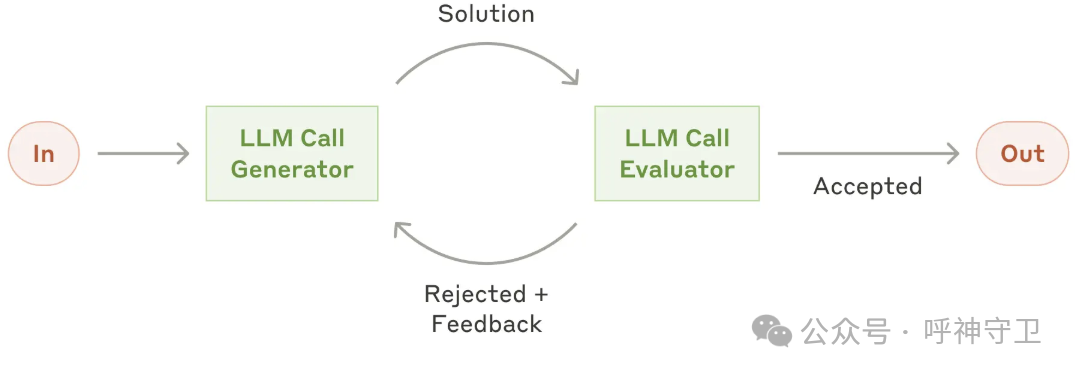

- Workflow: Evaluator-Optimizer

评价器-优化器Workflow。一个生成响应,另一个提供评价和反馈。类似强化学习。

适用场景:有明确的评估标准,且迭代改进提供了可衡量的价值,会很有效。两个关键的衡量点,1-人类明确提出反馈意见时,LLM的响应明显得到改善;2-LLM可以提出此类反馈

复杂的搜索或推理任务,需要多轮搜索和分析才能收集到全面的信息,由评估员决定是否需要进一步探索。

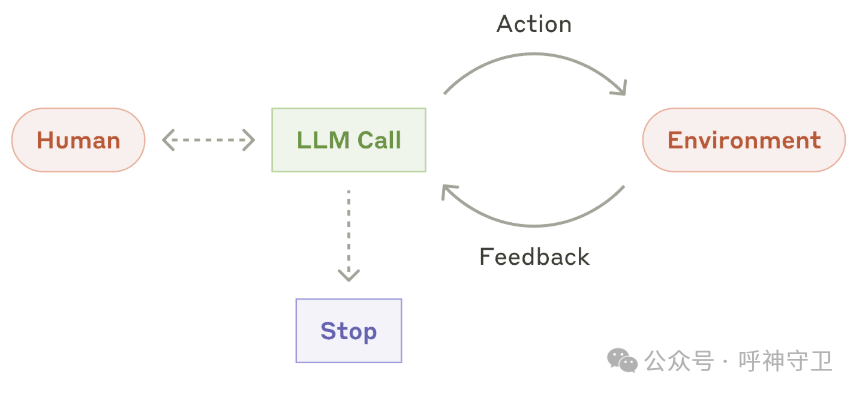

- Agents

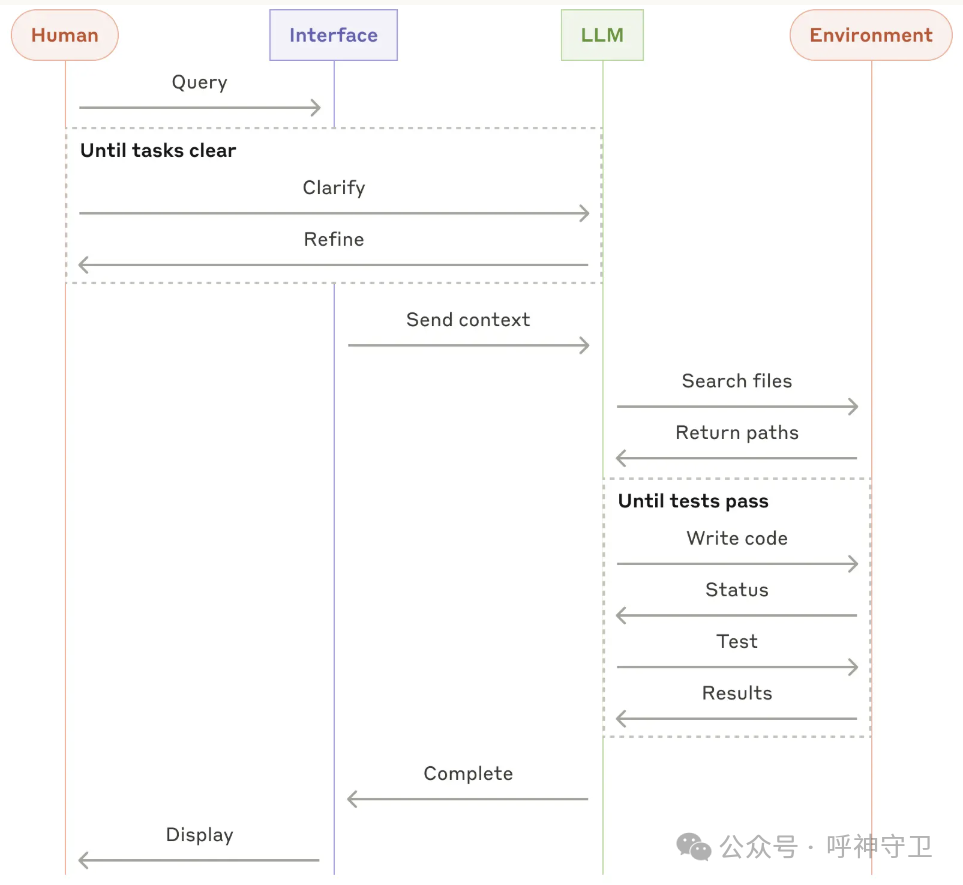

真正意义上的Agent。其工作模式是,一旦任务明确,智能体就会独立进行规划和操作,并有可能返回人类获取进一步的信息或判断。在执行过程中,智能体从环境中获取每一步的 “基本事实”(如工具调用结果或代码执行情况)以评估其进度至关重要。然后,智能体可以在检查点或遇到阻碍时暂停,以获得人工反馈。任务通常会在完成后终止,但通常也会包含停止条件(如迭代的最大次数)以保持控制。这种模式下,清晰完善的设计工具集及其文档至关重要。

Agent可用于开放式问题,在这种问题中,很难或不可能预测所需的步骤数,也无法硬编码出固定的路径。LLM可能会运行多个回合,你必须在一定程度上信任它的决策。智能体的自主性使其成为在可信环境中扩展任务的理想选择。

与任何LLM功能一样,成功的关键在于衡量性能和迭代实施。要记住只有当复杂性能够明显改善结果时,才应该考虑增加复杂性。

在实施Agentic System时,尽量遵循三个核心原则:

- 保持智能体设计的简洁性。

- 明确显示智能体的规划步骤,优先考虑透明度。

- 通过详尽的工具文档和测试,精心设计智能体-计算机接口(ACI)。

框架可以帮助快速入门,但当进入生产阶段时,要开始减少抽象层并使用基本组件构建。遵循这些原则,就能创建出不仅功能强大,而且可靠、可维护并深受用户信赖的Agentic System。

最近有意思的几个新闻:

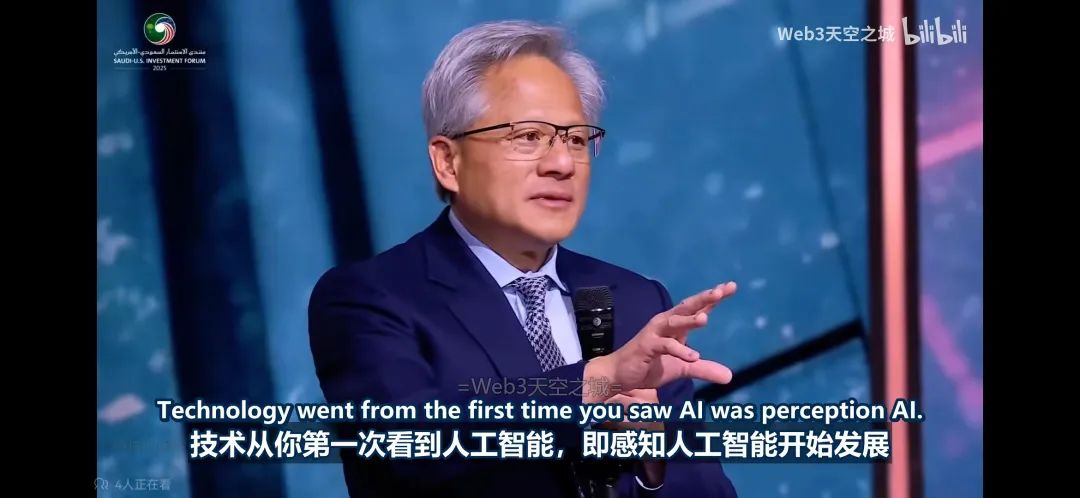

懂王带着一众商业大佬去沙特带货,让英伟达接了一大笔订单。(之前被禁售令卡的不行的老黄,现在可开心了,之前有多恨懂王,现在就有多爱懂王🙂)。老黄开心了,懂王又开始搞东大,这不年初说可以卖的H20,现在又黄了。年初风风火火找我们推销Azure和AWS H20 RI的朋友们,现在也都销声匿迹了。

本次大会上,老黄的一个观点很有意思。他对当前和未来AI形态定义了四个阶段,分别是感知AI-生成式AI-具身AI-物理AI。物理AI是终极难题,数学世界的多维很容易(多加个字段而已),物理世界的三维对AI都很难。

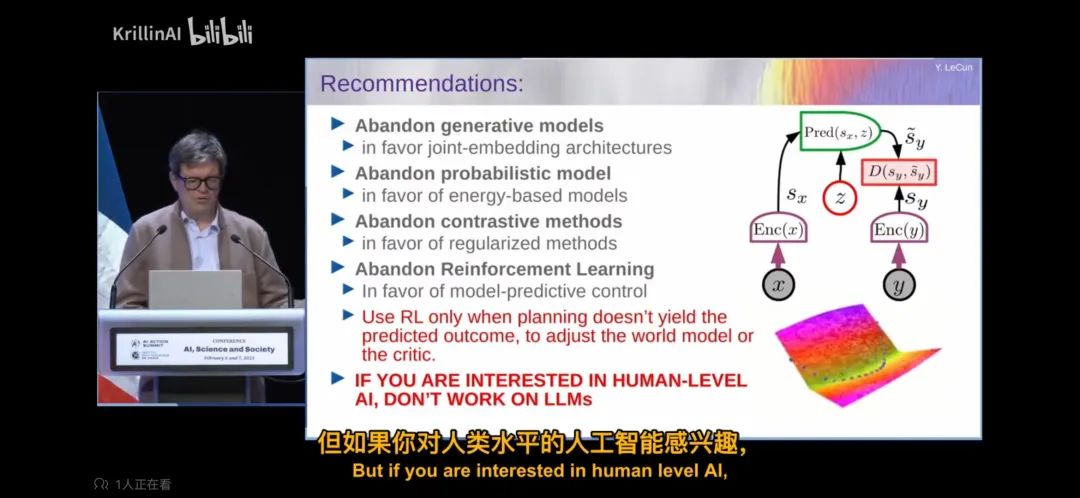

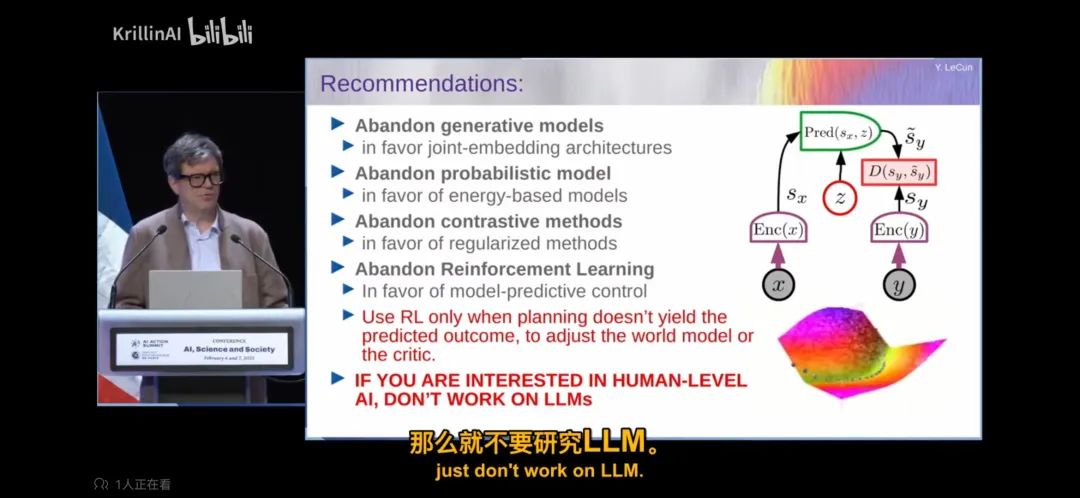

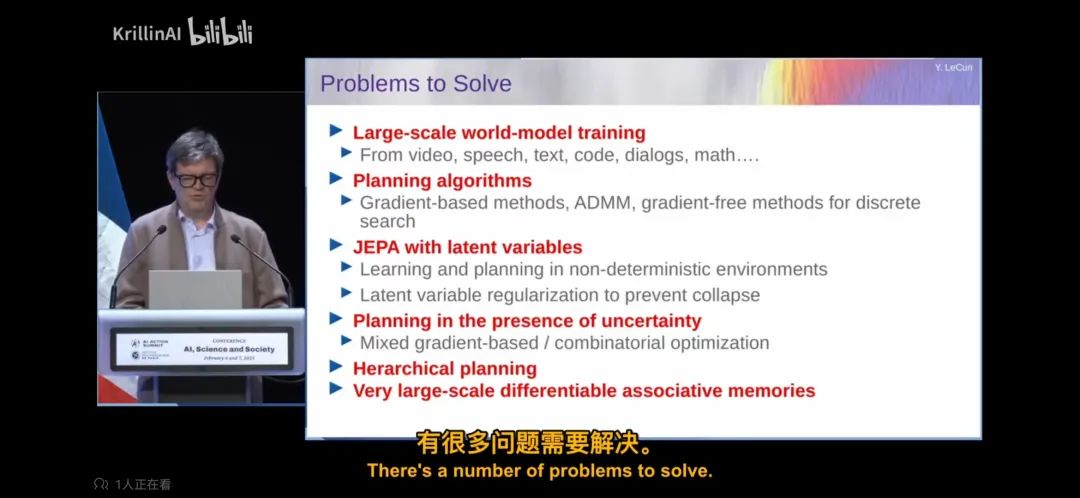

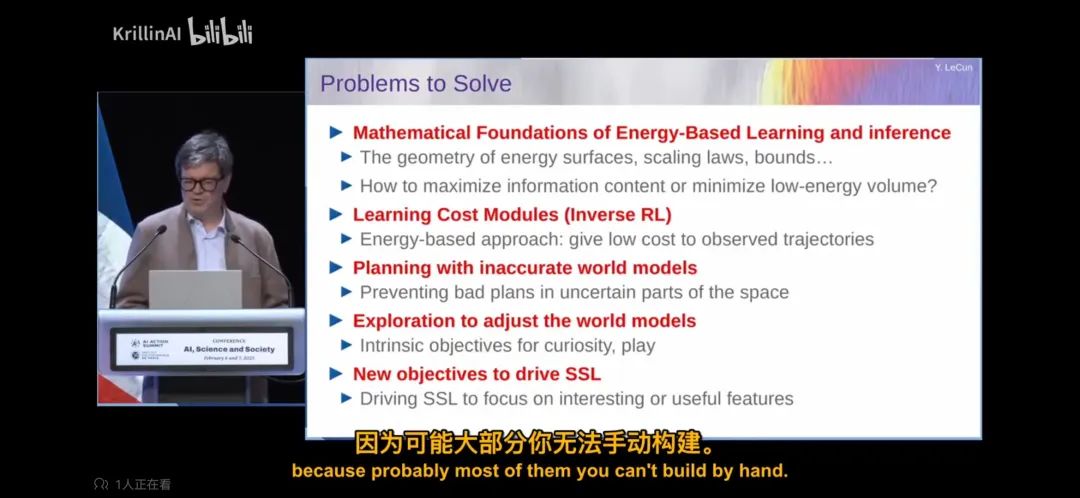

另外一个有意思的消息,深度学习三巨头,图灵奖获得者,现代AI教父之一杨乐坤Yann Lecun,最近在巴黎2025 AI行动峰会上,讲了一些自己对AI趋势的判断。当前以LLM为基础的路径无法实现对物理世界的理解;如果要研究人类世界的AI,放弃LLM;LLM无法带领我们走向AGI。

乐坤作为LLM的忠实"反对者",一直以来经常在各大场合去唱反调。世界模型、人类AI、物理AI,本质上都在讲一件事,而当AI真正开启物理世界的大门,理解物理定律,理解物理世界常识,理解重力、惯性、因果关系、物质守恒定律、遮挡等,人类进入AGI也将开始将进入倒计时。正如最早源自古希腊哲学家亚里士多德提出的一个第一性原理哲学术语:“每个系统中存在一个最基本的命题,它不能被违背或删除。”

乐坤在学术界的地位毋庸置疑,虽然经常"唱唱反调",但也不妨碍他带队持续推出LLaMA大模型的升级迭代。这种百家争鸣的方式其实挺好的,各家都能保持在自己的领域和方向健康持续的发展,时不时拿出来辩一辩也挺好的。

最后,最近最重磅的一个新闻,就是红杉资本的AI闭门会。从会议的讨论结果来看,当前已经具备了AI发展所需的所有要素,从历史的发展来看,这些浪潮是叠加的(半导体-操作系统-局域网-互联网-应用程序-移动互联网-AI),这些积累的技术浪潮,将我们带到了现在,AI是迫在眉睫且不可避免的,机会比之前的浪潮要大得多,AI的真正到来也将快的多。

未来AI的商业形态,不是Chatbot,不是Agent。AI未来会变成操作系统,而人类在这系统中,也许就是个接口。AI不是风口,而是工业革命,如果拒绝使用AI,就等于主动退出竞争。AI将彻底重新书写工作模式,未来的竞争力不在工具和代码上,甚至不在技术上,更有可能在意识上。

AI时代的人类,还需要掌握哪些权力,才能保持自己的不可替代性,总结三点:1.任务拆解权:变为意图设计者;2.系统调度权:让AI代理为你"排兵布阵";3.信任乘数权:在算法洪流中构建无法被复制的信誉护城河。

再展开说两点,任务定义+方向把控。

-

场景定义力:你能设定目标,AI才能执行路径。把模糊意图转化为结构化任务。AI擅长做,却不懂该做什么。需要具备:精准描述问题/拆解目标优先级/为系统设置边界条件。

-

信息生成力:你不是输出内容,而是在积累信誉资产。在大量AI生成内容泛滥的时代,可信度和判断力,将成为最大稀缺。需要具备:稳定、风格清晰的输出模式/可验证的结果交付记录/在特定系统中建立"不可替代接口"。

很多人开玩笑形容当前的AI为"脱裤子放屁"。以coding场景为例,你想要的是代码吗?你想要的是代码构建好的App。也就是说现在的AI,还处于中间过度状态,这个中间状态可能很快就结束,Agent的到来会进一步加速这个过程。

最后总结一下,SaaS时代的逻辑是为功能付费,而AI时代的逻辑是为结果付费!

我们该怎样系统的去转行学习大模型 ?

很多想入行大模型的人苦于现在网上的大模型老课程老教材,学也不是不学也不是,基于此我用做产品的心态来打磨这份大模型教程,深挖痛点并持续修改了近100余次后,终于把整个AI大模型的学习门槛,降到了最低!

在这个版本当中:

第一您不需要具备任何算法和数学的基础

第二不要求准备高配置的电脑

第三不必懂Python等任何编程语言

您只需要听我讲,跟着我做即可,为了让学习的道路变得更简单,这份大模型教程已经给大家整理并打包分享出来, 😝有需要的小伙伴,可以 扫描下方二维码领取🆓↓↓↓

一、大模型经典书籍(免费分享)

AI大模型已经成为了当今科技领域的一大热点,那以下这些大模型书籍就是非常不错的学习资源。

二、640套大模型报告(免费分享)

这套包含640份报告的合集,涵盖了大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(几乎涵盖所有行业)

三、大模型系列视频教程(免费分享)

四、2025最新大模型学习路线(免费分享)

我们把学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战。

L1阶段:启航篇丨极速破界AI新时代

L1阶段:我们会去了解大模型的基础知识,以及大模型在各个行业的应用和分析;学习理解大模型的

核心原理、关键技术以及大模型应用场景。

L2阶段:攻坚篇丨RAG开发实战工坊

L2阶段是我们的AI大模型RAG应用开发工程,我们会去学习RAG检索增强生成:包括Naive RAG、Advanced-RAG以及RAG性能评估,还有GraphRAG在内的多个RAG热门项目的分析。

L3阶段:跃迁篇丨Agent智能体架构设计

L3阶段:大模型Agent应用架构进阶实现,我们会去学习LangChain、 LIamaIndex框架,也会学习到AutoGPT、 MetaGPT等多Agent系统,打造我们自己的Agent智能体。

L4阶段:精进篇丨模型微调与私有化部署

L4阶段:大模型的微调和私有化部署,我们会更加深入的探讨Transformer架构,学习大模型的微调技术,利用DeepSpeed、Lamam Factory等工具快速进行模型微调;并通过Ollama、vLLM等推理部署框架,实现模型的快速部署。

L5阶段:专题集丨特训篇 【录播课】

全套的AI大模型学习资源已经整理打包,有需要的小伙伴可以微信扫描下方二维码,免费领取

433

433

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?