本文详细介绍了RAG(检索增强生成)技术的实战构建过程,通过六步流程(文档加载、文本分块、信息嵌入、向量存储、信息检索、答案生成)解决大语言模型的"幻觉"和"选择性失忆"问题。作者提供了完整的开源实现,让读者能够亲手构建属于自己的RAG系统,为AI添加外部记忆能力,使回答更加准确可靠,并能够基于特定知识库进行推理。这不仅是技术教程,更是通往更强大、更可信AI应用的关键一步。

蓝图:构建一个RAG系统的六脉神剑

在动手之前,我们先回顾一下RAG系统的核心流程,整个过程可以清晰地分为六个关键步骤:

- 文档加载 (Loading): 为AI“喂食”知识,这是所有智慧的源头。

- 文本分块 (Splitting): 庖丁解牛,将大块知识“切片”,方便AI消化。

- 信息嵌入 (Embedding): 将文字翻译成AI能懂的“密码”——向量。

- 向量存储 (Storage): 为这些“密码”建造一座高效的“记忆宫殿”。

- 信息检索 (Retrieval): 当问题传来,精准地在宫殿中找到相关线索。

- 答案生成 (Generation): 让AI拿着“参考资料”开口说话,给出最终答案。

接下来,让我们卷起袖子,逐一攻破这六大关卡。

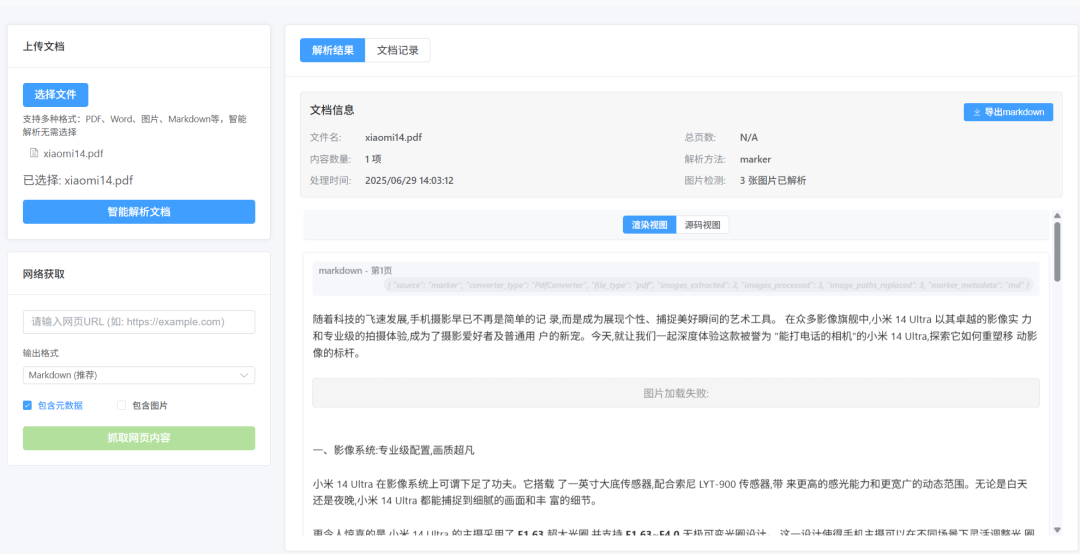

第一步:文档加载

万丈高楼平地起,RAG系统的地基,就是高质量的知识源。如果源头的数据都无法被正确解析,那么后续无论模型多强大、算法多精妙,都只是在“垃圾”上做文章,结果自然是“垃圾进,垃圾出”。

在我构建的这个RAG系统中,我设计了两种“喂食”路径:

- 本地投喂:直接从你的电脑目录中批量加载文件。

- 网络爬取:给定一个网址,系统会自动抓取网页内容。

一个关键的设计决策是:无论源文档是PDF、Word还是HTML,我选择将它们统一解析成Markdown格式。

为什么是Markdown?因为它不仅仅是纯文本,它保留了文档的结构化信息(如标题、列表、粗体等)。这就像给AI的食物不仅有营养,还分好了主食、配菜和汤,后续进行“文本分块”时,我们就能利用这些结构信息,切分得更合理、更符合语义。

实战小贴士:在真实项目中,你会遇到各种“千奇百怪”的文档格式。通用的解析方案是起点,但针对特定格式(如复杂的财务报表PDF)进行深度定制的解析,是提升最终效果的必经之路。

第二步:文本分块

文档成功加载后,我们得到了一篇篇完整的长文。但大模型就像一个“短期记忆”的学生,一次性塞给他太多东西,他会记不住、也无法聚焦。因此,我们需要对知识进行“切片”处理。

为什么必须分块?

- 聚焦主题:让每个文本块尽可能只讨论一个核心主题,避免信息交叉干扰。

- 突破限制:每个大模型都有其上下文窗口(Context Window)的长度限制,分块可以确保输入内容不“超载”。

分块不是简单地“一刀切”,不同的切法,效果迥异。以下是几种主流的“刀法”:

- 按页分块 (Page-based): 简单粗暴,适合保留原始版面(如PDF页码),但容易割裂上下文。

- 固定大小 (Fixed-size): 像用模具切饼干,保证每块大小均匀。缺点是可能在句子或段落中间无情地“腰斩”,破坏语义完整性。

- 按结构分块 (Recursive/Semantic): 这是更高级的“刀法”。它会尊重文本的自然结构,优先按段落、再按句子进行切分。这种方式能最大程度地保留语义的连贯性,是我在这个项目中主要采用的策略。

- 按语义分块 (Semantic-based): 终极“刀法”,借助AI的理解能力来识别文本的语义边界。它能更好地处理主题切换、逻辑关联,确保每一块都是一个“意义单元”。

选择合适的分块策略,是决定检索质量的第一个关键胜负手。

第三步:信息嵌入

文本块准备就绪,现在我们要把它们翻译成AI能理解的语言。这种语言不是英文也不是中文,而是一种数学语言——向量(Vectors)。

这个翻译过程,我们称之为信息嵌入(Embedding)。

你可以把嵌入模型想象成一个超级翻译官。它阅读每一个文本块,然后将其内涵的“意义”映射到高维空间中的一个具体坐标点。这个坐标点,就是向量。在这个空间里,意思相近的文本块,它们的坐标点也彼此靠近。

在这个RAG系统中,我集成了灵活的嵌入模型选项,给予你充分的选择权:

- 商业API模型:如OpenAI的text-embedding-3-large,效果出众,按量付费。

- 开源本地模型:如Hugging Face社区的sentence-transformers,或是国内顶尖的BGE、通义千问(Qwen)系列模型。这些模型可以免费部署在本地,保障数据私密性,但需要一定的硬件资源。

通过切换不同的嵌入模型,你可以直观地感受到它们在语义捕捉能力上的细微差别,这是一个非常有价值的对比实验。

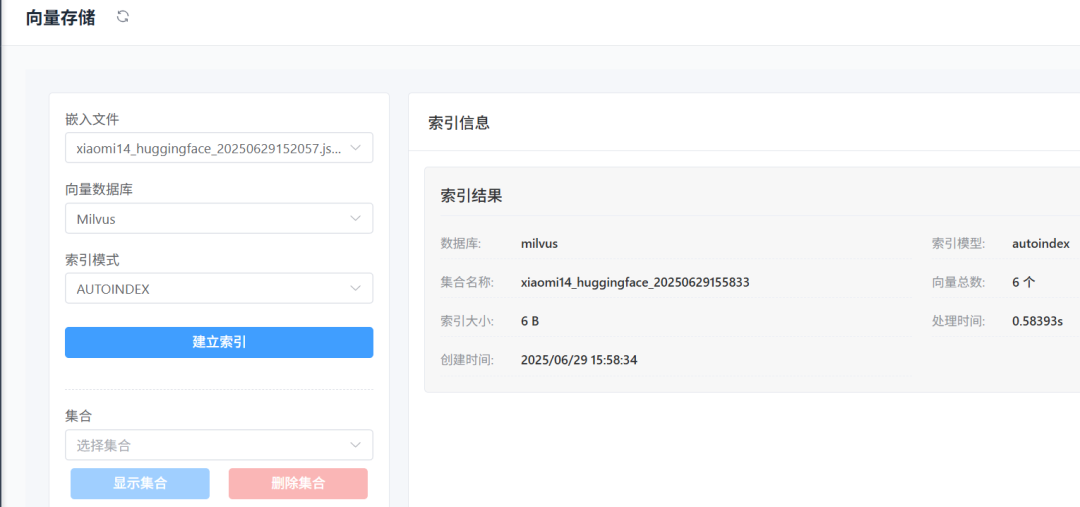

第四步:向量存储

现在,我们手握成千上万个代表知识的向量。下一步,就是为它们建造一座能够被快速检索的“记忆宫殿”——向量数据库(Vector Database)。

向量数据库的核心能力,就是在亿万个向量中,光速找出与目标向量最“相似”(即空间距离最近)的那些。

选择哪座“宫殿”,取决于你的需求和场景:

轻量级选手 (适合入门与原型):

- Faiss:Meta出品,快如闪电,是一个纯粹的相似性搜索库,非常适合在本地快速验证想法。

- Chroma:为开发者体验而生,主打“开箱即用”,让你能以最少代码启动一个向量存储服务。

生产级巨头 (适合大规模部署):

- Milvus:云原生、分布式设计,为海量数据和高并发场景而生,是构建企业级RAG的可靠选择。

我的建议是:在开发和调试阶段,使用Faiss或Chroma,它们能让你把精力聚焦在流程本身。当你的系统准备好走向生产环境时,再无缝切换到像Milvus这样更健壮、可扩展的数据库。

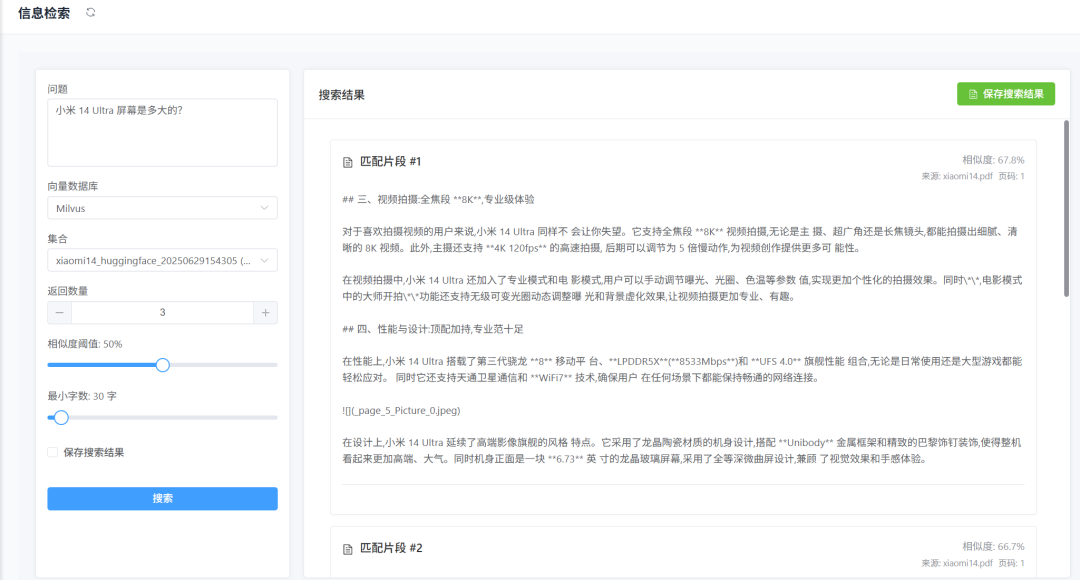

第五步:信息检索

万事俱备,只欠东风。当用户提出问题时,激动人心的“寻宝”时刻到来了。

我们的系统会做两件事:

- 将用户的问题也通过同一个嵌入模型,“翻译”成一个查询向量(Query Vector)。

- 拿着这个查询向量,冲进我们的“记忆宫殿”(向量数据库),寻找与之最相似的文本块向量。

这个过程就像在巨大的图书馆里,根据一本书的“风格”和“主题”,迅速找到书架上与它最匹配的其他几本书。

为了让“寻宝”过程更可控,我设置了几个关键的调节旋钮:

- 返回数量 (Top-K): 指定返回最相关的几个结果。我通常默认设置为3,这意味着为AI提供3条最关键的参考线索。

- 相似度阈值 (Similarity Threshold): 设定一个“相关度”门槛,比如50%。只有相似度得分高于这个值的文本块才会被召回,有效过滤掉不相干的噪音。

- 最小字数 (Minimum Characters): 避免返回一些过于零碎或无意义的短文本片段。

这些参数的微调,对最终生成答案的质量有着直接且显著的影响。

第六步:生成答案

我们手上已经有了与用户问题最相关的几段“参考资料”。最后一步,就是让大模型(LLM)这位“总指挥”登场。

系统会自动构建一个精巧的提示词(Prompt),它的结构通常是这样的:

# 指令

请根据下面提供的上下文信息,简洁、准确地回答用户的问题。

如果上下文中没有足够信息,请直接说“根据现有资料,我无法回答该问题”。

# 上下文信息

[这里会插入从向量数据库中检索到的文本块1]

---

[这里会插入从向量数据库中检索到的文本块2]

---

[这里会插入从向量数据库中检索到的文本块3]

# 用户问题

[这里会插入用户的原始问题]

这个过程,完美模拟了我们人类的**“开卷考试”**。LLM不再是凭空“记忆”来回答,而是基于我们提供的、高度相关的上下文信息来进行总结、推理和组织语言。

这不仅极大地降低了“胡说八道”的概率,更让它有能力回答那些它“从未学过”的、特定于我们知识库的问题。

同样,生成答案的LLM也可以自由配置,无论是调用外部API还是使用本地部署的模型,你都可以接入进来,比较不同模型在“阅读理解”和“语言组织”能力上的表现。

总结

恭喜你!跟着这六个步骤,我们一起走完了一个完整RAG系统的构建之旅。从最开始的数据“喂食”,到最后的“开卷考试”,我们亲手为AI打造了一个强大、可靠的外部记忆系统。

通过亲手构建,你得到的不仅是一个能跑通的系统,更是一种驾驭AI的思维方式。你现在拥有了让AI学习任何知识、并基于这些知识进行可靠回答的能力。

这,正是通往更强大、更可信、更具实用价值的AI应用的关键一步。

如何从零学会大模型?小白&程序员都能跟上的入门到进阶指南

当AI开始重构各行各业,你或许听过“岗位会被取代”的焦虑,但更关键的真相是:技术迭代中,“效率差”才是竞争力的核心——新岗位的生产效率远高于被替代岗位,整个社会的机会其实在增加。

但对个人而言,只有一句话算数:

“先掌握大模型的人,永远比后掌握的人,多一次职业跃迁的机会。”

回顾计算机、互联网、移动互联网的浪潮,每一次技术革命的初期,率先拥抱新技术的人,都提前拿到了“职场快车道”的门票。我在一线科技企业深耕12年,见过太多这样的案例:3年前主动学大模型的同事,如今要么成为团队技术负责人,要么薪资翻了2-3倍。

深知大模型学习中,“没人带、没方向、缺资源”是最大的拦路虎,我们联合行业专家整理出这套 《AI大模型突围资料包》,不管你是零基础小白,还是想转型的程序员,都能靠它少走90%的弯路:

- ✅ 小白友好的「从零到一学习路径图」(避开晦涩理论,先学能用的技能)

- ✅ 程序员必备的「大模型调优实战手册」(附医疗/金融大厂真实项目案例)

- ✅ 百度/阿里专家闭门录播课(拆解一线企业如何落地大模型)

- ✅ 2025最新大模型行业报告(看清各行业机会,避免盲目跟风)

- ✅ 大厂大模型面试真题(含答案解析,针对性准备offer)

- ✅ 2025大模型岗位需求图谱(明确不同岗位需要掌握的技能点)

所有资料已整理成包,想领《AI大模型入门+进阶学习资源包》的朋友,直接扫下方二维码获取~

① 全套AI大模型应用开发视频教程:从“听懂”到“会用”

不用啃复杂公式,直接学能落地的技术——不管你是想做AI应用,还是调优模型,这套视频都能覆盖:

- 小白入门:提示工程(让AI精准输出你要的结果)、RAG检索增强(解决AI“失忆”问题)

- 程序员进阶:LangChain框架实战(快速搭建AI应用)、Agent智能体开发(让AI自主完成复杂任务)

- 工程落地:模型微调与部署(把模型用到实际业务中)、DeepSeek模型实战(热门开源模型实操)

每个技术点都配“案例+代码演示”,跟着做就能上手!

课程精彩瞬间

② 大模型系统化学习路线:避免“学了就忘、越学越乱”

很多人学大模型走弯路,不是因为不努力,而是方向错了——比如小白一上来就啃深度学习理论,程序员跳过基础直接学微调,最后都卡在“用不起来”。

我们整理的这份「学习路线图」,按“基础→进阶→实战”分3个阶段,每个阶段都明确:

- 该学什么(比如基础阶段先学“AI基础概念+工具使用”)

- 不用学什么(比如小白初期不用深入研究Transformer底层数学原理)

- 学多久、用什么资料(精准匹配学习时间,避免拖延)

跟着路线走,零基础3个月能入门,有基础1个月能上手做项目!

③ 大模型学习书籍&文档:打好理论基础,走得更稳

想长期在大模型领域发展,理论基础不能少——但不用盲目买一堆书,我们精选了「小白能看懂、程序员能查漏」的核心资料:

- 入门书籍:《大模型实战指南》《AI提示工程入门》(用通俗语言讲清核心概念)

- 进阶文档:大模型调优技术白皮书、LangChain官方中文教程(附重点标注,节省阅读时间)

- 权威资料:斯坦福CS224N大模型课程笔记(整理成中文,避免语言障碍)

所有资料都是电子版,手机、电脑随时看,还能直接搜索重点!

④ AI大模型最新行业报告:看清机会,再动手

学技术的核心是“用对地方”——2025年哪些行业需要大模型人才?哪些应用场景最有前景?这份报告帮你理清:

- 行业趋势:医疗(AI辅助诊断)、金融(智能风控)、教育(个性化学习)等10大行业的大模型落地案例

- 岗位需求:大模型开发工程师、AI产品经理、提示工程师的职责差异与技能要求

- 风险提示:哪些领域目前落地难度大,避免浪费时间

不管你是想转行,还是想在现有岗位加技能,这份报告都能帮你精准定位!

⑤ 大模型大厂面试真题:针对性准备,拿offer更稳

学会技术后,如何把技能“变现”成offer?这份真题帮你避开面试坑:

- 基础题:“大模型的上下文窗口是什么?”“RAG的核心原理是什么?”(附标准答案框架)

- 实操题:“如何优化大模型的推理速度?”“用LangChain搭建一个多轮对话系统的步骤?”(含代码示例)

- 场景题:“如果大模型输出错误信息,该怎么解决?”(教你从技术+业务角度回答)

覆盖百度、阿里、腾讯、字节等大厂的最新面试题,帮你提前准备,面试时不慌!

以上资料如何领取?

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

为什么现在必须学大模型?不是焦虑,是事实

最近英特尔、微软等企业宣布裁员,但大模型相关岗位却在疯狂扩招:

- 大厂招聘:百度、阿里的大模型开发岗,3-5年经验薪资能到50K×20薪,比传统开发岗高40%;

- 中小公司:甚至很多传统企业(比如制造业、医疗公司)都在招“会用大模型的人”,要求不高但薪资可观;

- 门槛变化:不出1年,“有大模型项目经验”会成为很多技术岗、产品岗的简历门槛,现在学就是抢占先机。

风口不会等任何人——与其担心“被淘汰”,不如主动学技术,把“焦虑”变成“竞争力”!

最后:全套资料再领一次,别错过这次机会

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

2412

2412

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?