Ollama是建立在llama.cpp开源推理引擎基础上的大模型推理工具框架。得益于底层引擎提供的高效模型推理,以及多硬件适配,Ollama能够在包括CPU、GPU在内的,不同的硬件环境上,运行各种精度的GGUF格式大模型。通过一个命令行就能拉起LLM模型服务。

通过Ollama,开发者可以更好的使用GGUF模型。而当前ModelScope社区上已经托管了数千个优质的GGUF格式的大模型,为了让开发者更方便地把这些模型用起来,社区最近支持了Ollama框架和ModelScope平台的链接,通过简单的 ollama run命令,就能直接加载运行ModelScope模型库上的GGUF模型。

01

一键运行

入门非常简单:

- 设置ollama下启用

ollama serve

- ollama run ModelScope任意GGUF模型

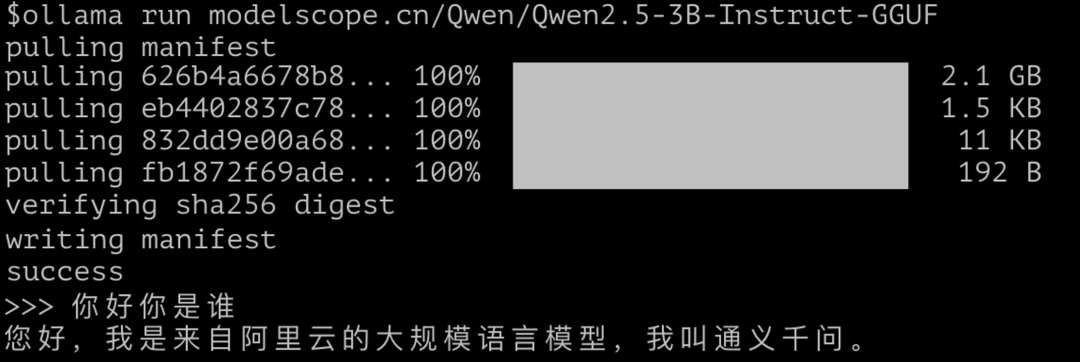

ollama run modelscope.cn/Qwen/Qwen2.5-3B-Instruct-GGUF

在安装了Ollama的环境上(建议使用>=0.3.12版本),直接通过上面的命令行,就可以直接在本地运行 Qwen2.5-3B-Instruct-GGUF模型。

命令行的具体格式为:

ollama run modelscope.cn/{model-id}

其中model-id的具体格式为{username}/{model},例如:

ollama run modelscope.cn/Qwen/Qwen2.5-3B-Instruct-GGUF

ollama run modelscope.cn/second-state/gemma-2-2b-it-GGUF

ollama run modelscope.cn/Shanghai_AI_Laboratory/internlm2_5-7b-chat-gguf

关于如何安装Ollama,可参考Ollama官方文档(https://ollama.com/download),建议使用>=0.3.12版本。

或者参见这个ModelScope Notebook来完成安装:https://modelscope.cn/notebook/share/ipynb/4a85790f/ollama-installation.ipynb 。

02

配置定制

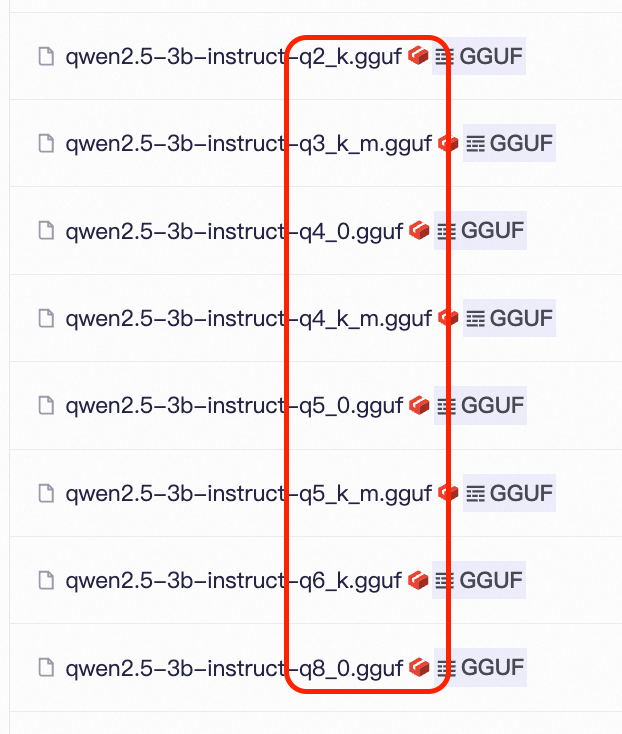

Ollama支持加载不同精度的GGUF模型,同时在一个GGUF模型库中,一般也会有不同精度的模型文件存在,例如Q3_K_M, Q4_K_M, Q5_K等等,入下图所示:

一个模型repo下的不同GGUF文件,对应的是不同量化精度与量化方法。默认情况下,如果模型repo里有Q4_K_M版本的话,我们会自动拉取并使用该版本,在推理精度以及推理速度,资源消耗之间做一个较好的均衡。如果没有该版本,我们会选择合适的其他版本。

此外,您也可以显式配置来指定想要使用的版本。例如:

ollama run modelscope.cn/Qwen/Qwen2.5-3B-Instruct-GGUF:Q3_K_M

这里命令行最后的:Q3_K_M选项,就指定了使用Q3_K_M精度的GGUF模型版本,这个选项大小写不敏感,也就是说,无论是:Q3_K_M,还是:q3_k_m,都是使用模型repo里的"qwen2.5-3b-instruct-q3_k_m.gguf" 这个模型文件。当然,您也可以直接指定模型文件的全称,这同样是支持的:

ollama run modelscope.cn/Qwen/Qwen2.5-3B-Instruct-GGUF:qwen2.5-3b-instruct-q3_k_m.gguf

03

更多配置选项

Ollama支持通过Modelfile配置文件,来实现大模型推理的参数自定义。ModelScope与Ollama的对接,会根据平台上GGUF模型的信息,自动生成每个模型需要的配置与参数,包括推理模版(Template),模型参数(Parameters)等等,后续我们也将支持模型贡献者在模型repo里,通过特定文件来指定专属的配置,敬请期待 :)。

如何学习AI大模型?

作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。 至于能学习到多少就看你的学习毅力和能力了 。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

这份完整版的大模型 AI 学习资料已经上传优快云,朋友们如果需要可以微信扫描下方优快云官方认证二维码免费领取【保证100%免费】

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

四、AI大模型商业化落地方案

作为普通人,入局大模型时代需要持续学习和实践,不断提高自己的技能和认知水平,同时也需要有责任感和伦理意识,为人工智能的健康发展贡献力量。

3488

3488

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?