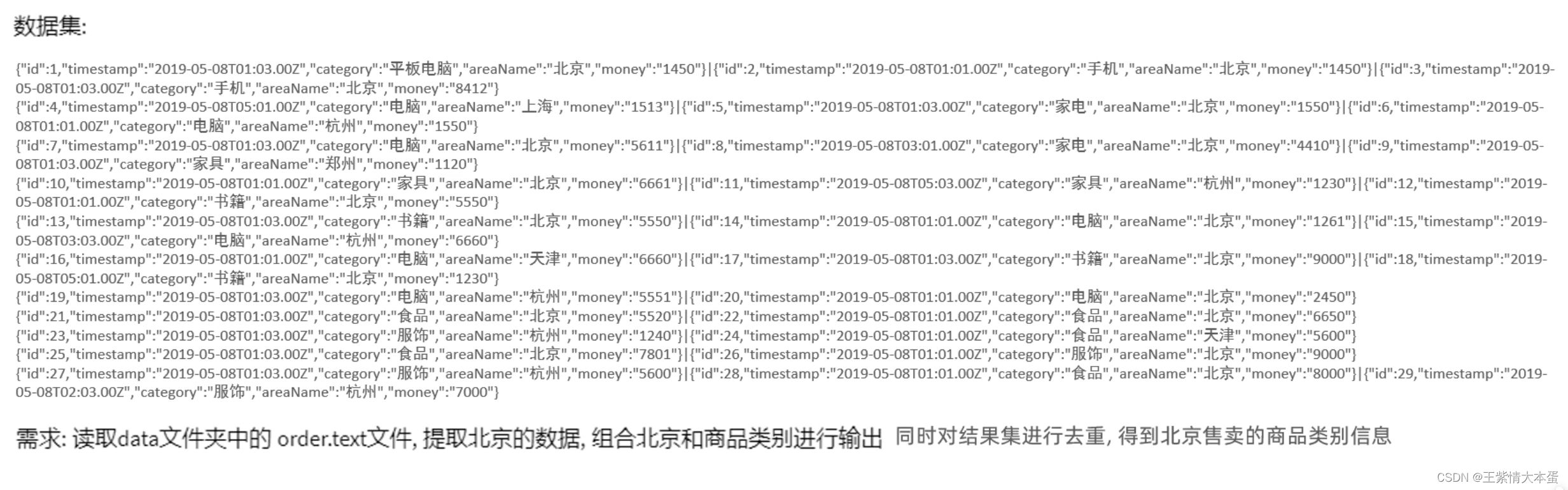

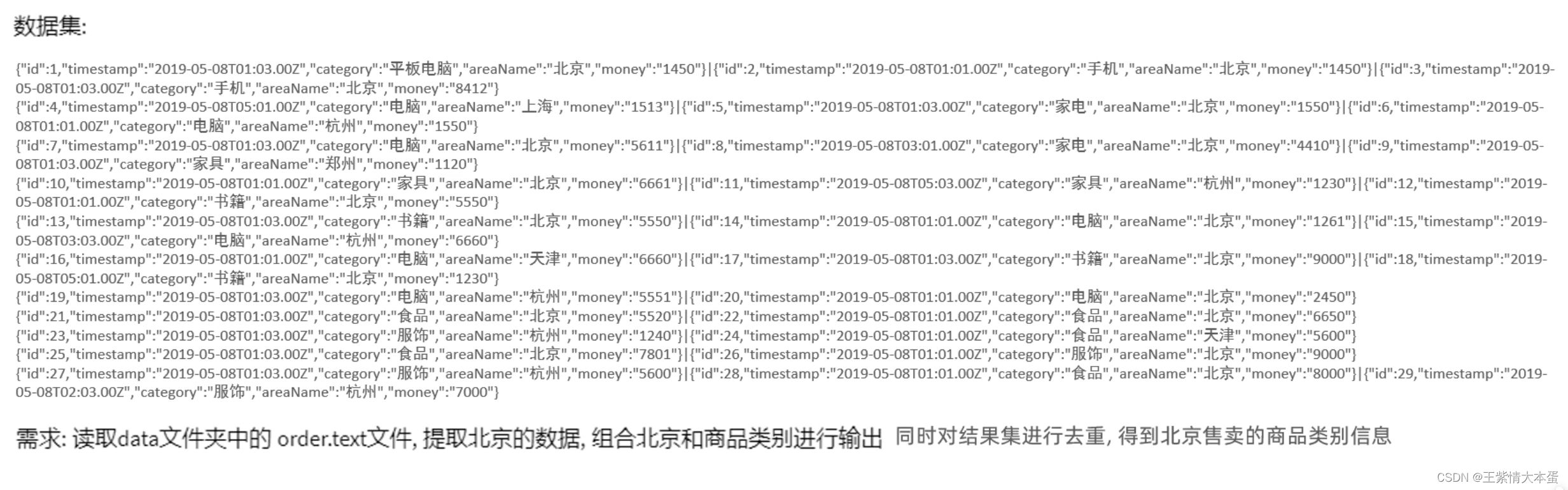

1.数据集和问题

2.代码部分

from pyspark import SparkConf, SparkContext

import json

if __name__ == '__main__':

conf = SparkConf().setAppName("test").setMaster("local[*]")

sc = SparkContext(conf=conf)

file_rdd = sc.textFile("../data/input/order.text")

jsons_rdd = file_rdd.flatMap(lambda line: line.split("|"))

dict_rdd = jsons_rdd.map(lambda json_str: json.loads(json_str))

beijing_rdd = dict_rdd.filter(lambda d: d['areaName'] == "北京")

category_rdd = beijing_rdd.map(lambda x: x['areaName'] + "_" + x['category'])

result_rdd = category_rdd.distinct()

print(result_rdd.collect())

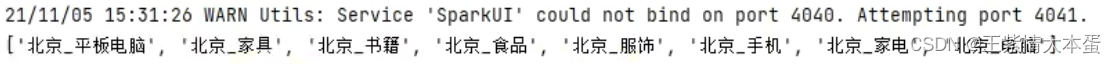

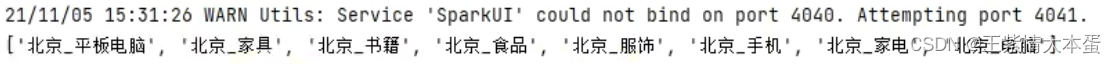

3.运行结果

4.将案例提交到yarn环境中运行

2862

2862

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?