介绍

近年来,基于卷积神经网络的语义分割模型在众多应用中表现出了显著的性能。然而当应用于新的领域时,这些模型通常不能很好地泛化,特别是从合成数据到真实数据时。本文讨论了无监督域适应(UDA)的问题,即对来自一个源域的标记数据进行训练,同时从目标域的无标记数据进行学习。现有的方法通过对这些无标签图像进行伪标签训练取得了成功。人们提出了多种技术来降低由域转移引起的低质量伪标签的情况,并取得了不同程度的成功。我们提出了DACS:通过跨域混合采样的域适应,它将来自两个域的图像与相应的标签和伪标签混合在一起。除了标签数据本身外,这些混合样本还会被训练。

我们注意到,在现有的纠正错误伪标签的方法中,目标域中的某些图像会过度采样,图像中的低置信度像素会被过滤掉。许多低置信度像素与语义边界上的预测对齐,从而导致那里的训练信号减弱。传统的直接使用混合的方法会导致一些类进行合并。

总结来说:DACS提出了三个创新点。

①引入了一种新的算法,将目标域的图片和源域中的图片进行混合,创造出来一个新的、高扰动的样本

②通过实验证明跨域的图像混合可以很大程度上解决类合并的问题

③在GTA5—>City 取得了sota 的水准

方法

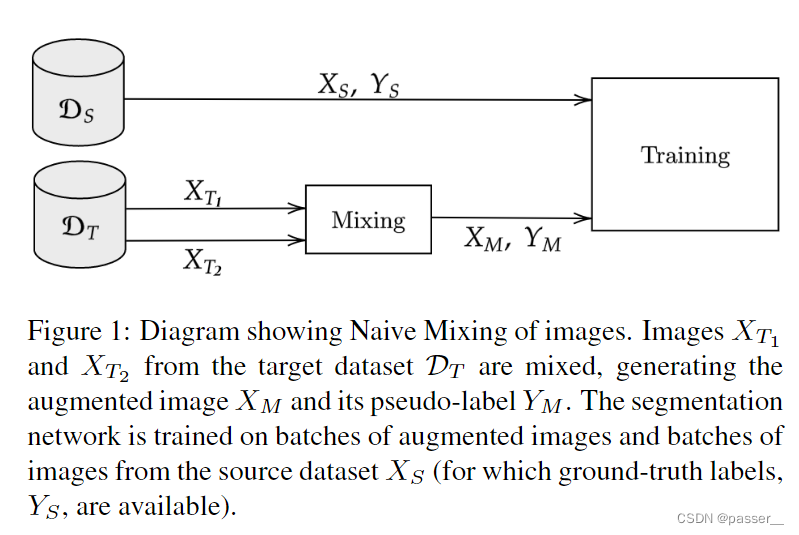

Naive Mixing

对于朴素的混合方法就是拿目标域的两张图进行混合,然后生成Xm,然后获得其对应的伪标签Ym,然后将源域中的Xs,Ys,和在目标域混合生成的图片再放到一块训练。

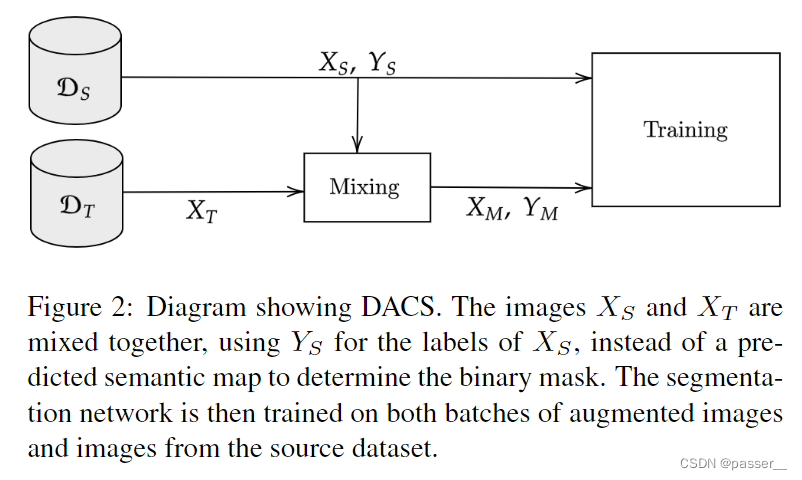

DACS

DACS是一种针对无监督域适应语义分割的新型方法,通过混合源域和目标域的图像以创建高扰动样本,缓解类合并问题。它使用ClassMix策略,将源域的一半类粘贴到目标域图像上,减少低置信度像素的影响。实验显示DACS在GTA5到Cityscapes的迁移中取得SOTA性能。

DACS是一种针对无监督域适应语义分割的新型方法,通过混合源域和目标域的图像以创建高扰动样本,缓解类合并问题。它使用ClassMix策略,将源域的一半类粘贴到目标域图像上,减少低置信度像素的影响。实验显示DACS在GTA5到Cityscapes的迁移中取得SOTA性能。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3644

3644

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?