论文标题

4D Gaussian Splatting for Real-Time Dynamic Scene Rendering

用于实时动态场景渲染的四维高斯散射

论文链接:

https://arxiv.org/abs/2310.08528

论文作者

Guanjun Wu, Taoran Yi, Jiemin Fang, Lingxi Xie, Xiaopeng Zhang, Wei Wei, Wenyu Liu, Qi Tian, Xinggang Wang

内容简介

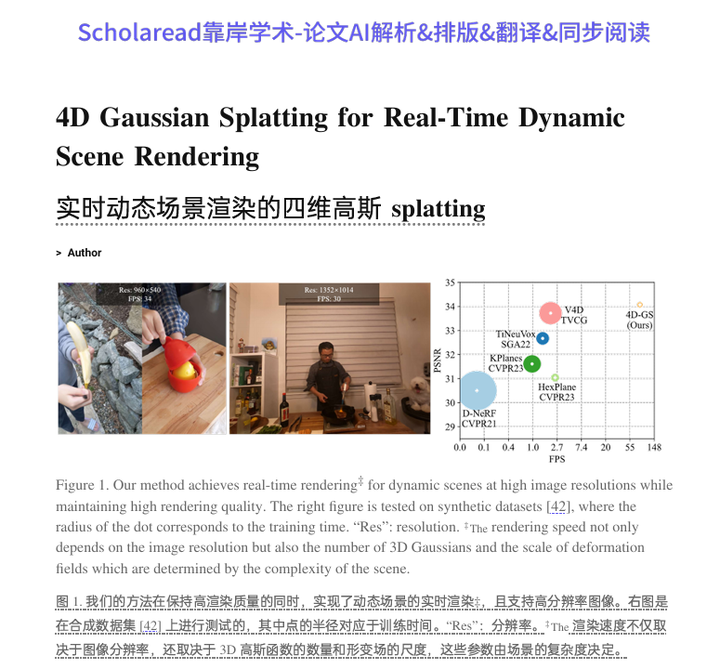

这篇论文提出了一种名为4D Gaussian Splatting (4D-GS) 的方法,用于实时渲染动态场景。该方法通过结合3D高斯和4D神经体素(neural voxels)的显式表示,以及一个高效的高斯变形场网络,来实现对动态场景的快速渲染。4D-GS能够在保持高渲染质量的同时,实现高训练和存储效率。

方法

1.4D Gaussian Splatting (4D-GS):

4D-GS是一种全新的显式表示方法,用于动态场景的渲染。它通过3D高斯和4D神经体素来表示场景,并使

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2352

2352

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?